优化器

首先定义:待优化参数: ,目标函数:

,初始学习率

。

而后,开始进行迭代优化。在每个epoch :

- 计算目标函数关于当前参数的梯度:

- 根据历史梯度计算一阶动量和二阶动量:

,

- 计算当前时刻的下降梯度:

- 根据下降梯度进行更新:

SGD ![m_t = g_t; V_t = I^2]()

SGD with Momentum ![m_t = \beta_1 \cdot m_{t-1} + (1-\beta_1)\cdot g_t]()

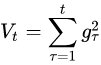

AdaGrad![]()

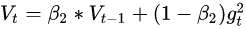

AdaDelta / RMSProp ![]()

Adam ![m_t = \beta_1 \cdot m_{t-1} + (1-\beta_1)\cdot g_t]()

![V_t = \beta_2 * V_{t-1} + (1-\beta_2) g_t^2]()

posted on 2019-09-26 13:57 happygril3 阅读(189) 评论(0) 收藏 举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号