一篇文章搞懂logit与logits

logit 的历史由来

在 20 世纪 30 年代和 40 年代,许多人试图将线性回归应用于预测概率的问题。然而,线性回归产生的输出范围是从负无穷到正无穷,而我们期望的概率输出范围是 0 到 1。实现这一目标的一个方法是将 0 到 1 的概率映射到负无穷到正无穷的范围,然后像往常一样使用线性回归。

其中一个映射方法是累积正态分布,由 Chester Ittner Bliss 在 1934 年提出,他将其称为“概率单位”(probit)模型,是“probability unit”的缩写。然而,这个函数计算成本较高,且对多分类支持不好。

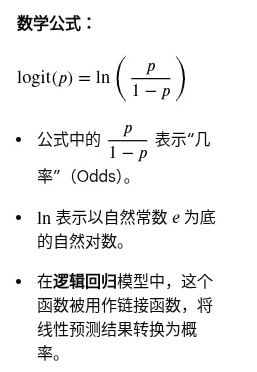

1944 年,Joseph Berkson 使用函数 ln(p/(1−p))ln(p/(1−p)) (同上面的数学定义)进行这种映射,并称之为logit,是“logistic unit”的缩写。术语“逻辑回归”(logistic regression)也是由此而来的。

1. Logit 函数

Logit 函数是对数几率函数(Log-Odds Function),是 Sigmoid 函数(逻辑函数)的反函数。

作用: 它将一个概率值 𝑝(范围在 0 到 1 之间)映射到整个实数范围(从负无穷大到正无穷大)。

在逻辑回归(Logistic Regression)中,Logit 函数被用作链接函数(Link Function),它允许我们将线性模型的输出与概率联系起来,使得我们可以使用线性回归技术来预测二元分类结果。

2. Logits(神经网络术语:原始输出分数)

在深度学习的实践中,Logits(通常使用复数形式)指的是神经网络最后一层未经激活函数处理的原始输出向量或预测分数。

这些原始分数代表了模型对每个类别的证据强弱,它们的取值可以是任意实数。

与激活函数的关系:

- Logits 是输入: 它们是 Sigmoid 或 Softmax 激活函数的输入。

- 激活函数是转换器:

- 对于二元分类,Logits 输入到 Sigmoid 得到 0到1 之间的概率。

- 对于多类别分类,Logits 输入到 Softmax 得到总和为 1 的概率分布。

总结:

在神经网络语境下,Logits 是模型内部的原始得分;在数学语境下,Logit 函数是将外部概率转换为对数几率的数学变换。

参考资料:

1. logit

浙公网安备 33010602011771号

浙公网安备 33010602011771号