文件之rsync 和 HDFS

rsync

参考 http://www.ruanyifeng.com/blog/2020/08/rsync.html

rsync是一个常用的Linux程序,用于文件同步

它可以在本地计算机与远程计算机之间,或者两个本地目录之间同步文件(但不支持两台远程计算机之间的同步)。它也可以当作文件复制工具,替代cp和mv命令。

一、新建虚拟机尝试两个本地目录之间同步文件。

安装虚拟机略

1.安装rsync

yum install rsync -y

2.本地创建文件夹并新建几个文件

mkdir zs

cd zs

touch a.txt

touch b.txt

touch c.txt

3.新建另一个文件夹 mkdir ls

4.输入命令 rsync -r zs ls , rsync -r 源文件夹 目的文件夹

5.进入查看已同步到ls文件夹

经测试每点一次才会同步文件,不会一直监控

rsync -a source destination 除了可以递归同步以外,还可以同步元信息.由于 rsync 默认使用文件大小和修改时间决定文件是否需要更新,所以-a比-r更有用。

如果目标文件夹不存在会自动创建,如果只想同步源目录source里面的内容到目标目录destination 就在源文件夹后面加/ rsync -a source/ destination

二、新建另一虚拟机尝试同步文件

新建虚拟机并安装rsync

配置了一下虚拟机的IP,并输入命令

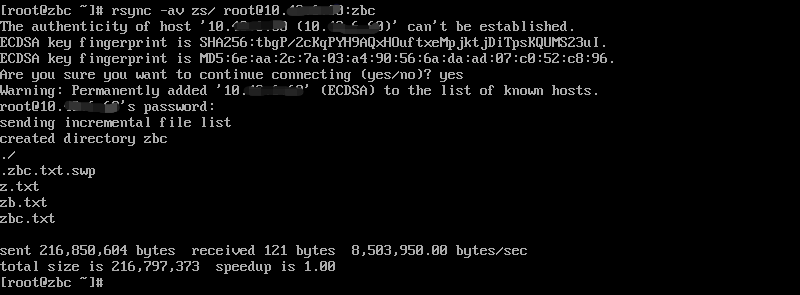

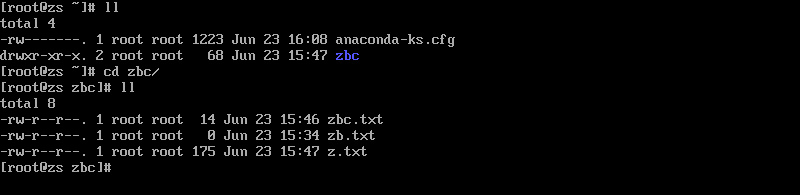

rsync -av zs/ root@10.43.*.*:zbc

rsync -av 源文件夹/ 用户名@IP:目的文件夹

连接成功后并输入密码,同步成功

hdfs

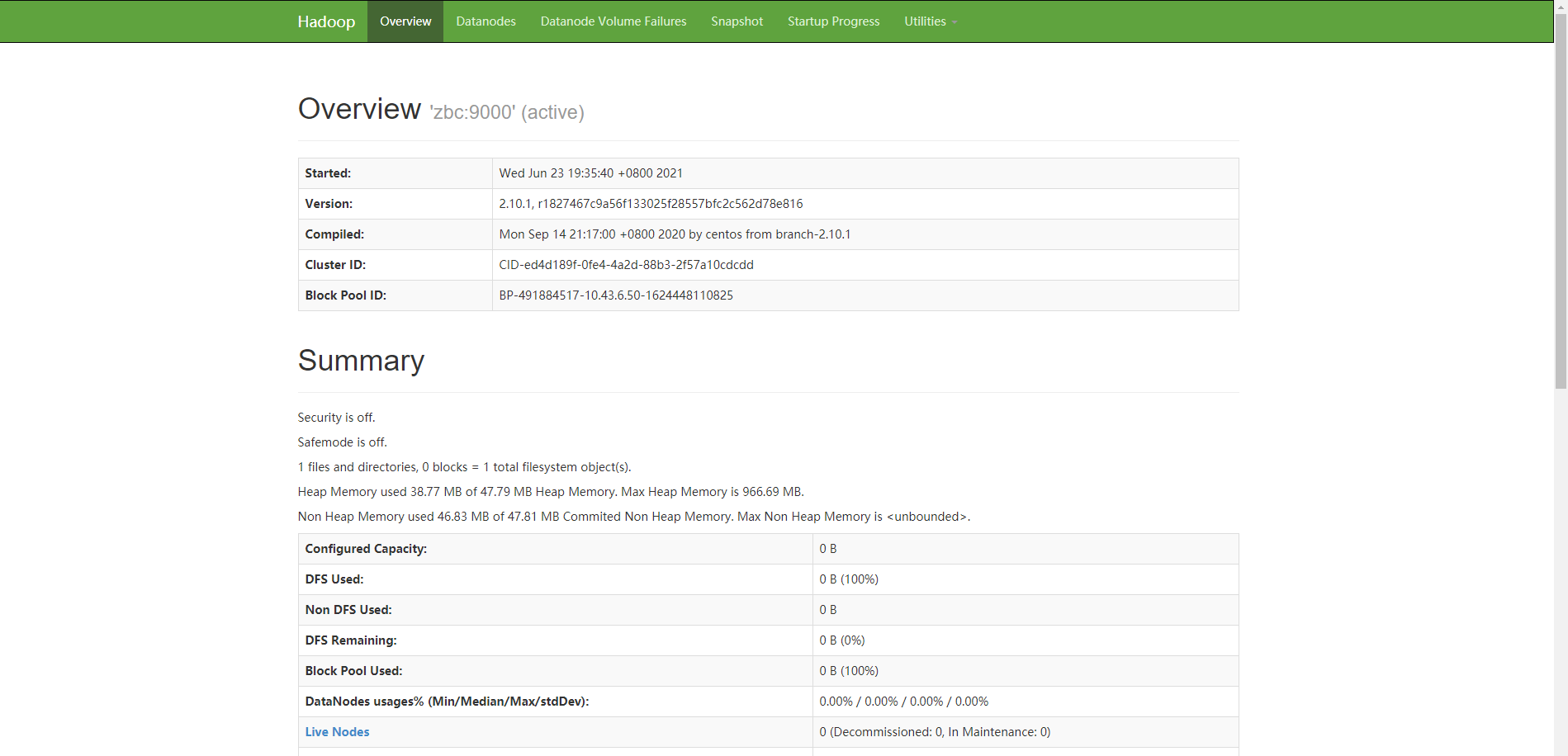

Hadoop分布式文件系统(HDFS)

文档:http://hadoop.apache.org/docs/r1.0.4/cn/hdfs_user_guide.html

文档:https://blog.csdn.net/sjmz30071360/article/details/79877846

Hadoop方式需要搭建Hadoop环境

下载并安装Java以及Hadoop

根据博客大都能做到,我说下要注意的地方

首先是/etc/profile 注意不要填错

设置 SSH 免密码登录,将生成的公钥id发送给从机的命令是

ssh-copy-id 从机的ip

ssh 从机的IP,可以免密登录

配置 HDFS

在所有机器上的/hadoop-2.7.3/etc/hadoop目录中,修改core-site.xml和hdfs-site.xml文件,以完成 HDFS 的配置。

- 修改

core-site.xml,在configuration标签内加入以下配置: -

<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://192.168.1.123:9000</value>//自己配置的主机IP </property> <property> <name>hadoop.tmp.dir</name> <value>/home/hadoopData</value> <description>namenode 上传到 hadoop 的临时文件夹</description> </property> <property> <name>fs.trash.interval</name> <value>4320</value> </property> </configuration>

修改hdfs-site.xml,在configuration标签内加入以下配置

-

<configuration> <property> <name>dfs.namenode.name.dir</name> <value>/home/hadoopData/dfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>/home/hadoopData/dfs/data</value> </property> <property> <name>dfs.replication</name>//副本个数,默认配置是 3,应小于 datanode 机器数量,我只配置了一个从机,所以改成了1 <value>1</value> </property> <property> <name>dfs.webhdfs.enabled</name> <value>true</value> </property> <property> <name>dfs.permissions.superusergroup</name> <value>staff</value> </property> <property> <name>dfs.permissions.enabled</name> <value>false</value> </property> </configuration>

在主机/hadoop-2.7.3/etc/hadoop目录下修改slaves文件,从机不用管

- 修改成从机的IP 即可

搭建成功了,怎么用。。。

浙公网安备 33010602011771号

浙公网安备 33010602011771号