集成学习——GBDT--企业神器

最近在网上点击了不好啊岗位查看岗位需求,不少的岗位都提到了GBDT,既然如此,分三步整理出GBDT的主线思路。

1.复习一下课程

2.网上查阅一下资料

3.手写一下笔记

Grandint Boosting Decision Tree(梯度提升决策树)

残差学习,运用到的数学技巧很多,传统模型也就是这个特点。数学性强,到了深度学习最主要就是堆机器了。

集成学习——GBDT--企业神器

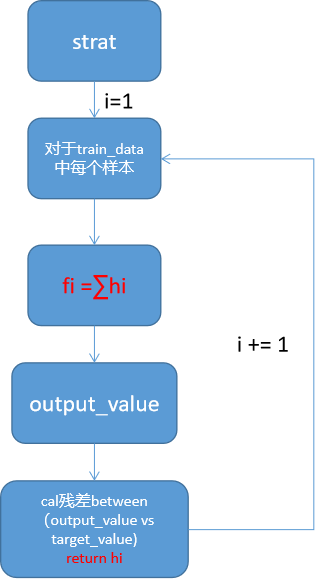

思想:串行进行m轮学习,每一轮学习,该轮和目标直指的残差。最终求和m个学习器,得到分类(回归)模型。

对于分类问题:

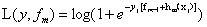

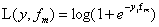

![]() ,对于0-1分类,由于输出值具有概率意义,至于在0~1,所以必须通过hi转换到至于为r的空间,方便残差学习。

,对于0-1分类,由于输出值具有概率意义,至于在0~1,所以必须通过hi转换到至于为r的空间,方便残差学习。- 构造损失函数:损失函数必须满足分类正确是L值小,分类错误时值大。更具此性质,构造了

回到,GBDT流程,研究一下GBDT究竟学的是什么?

我们知道,最终的分类器 fm = fm-1 +hm.

展开损失函数:

在第m轮,fm-1 是已知的,所以,hm是需要学习的对象。

这部分数学比较复杂,记住结论:

第m轮,hm(x)学习的目标是

,根据此公式,训练数据通过它之后就可以得到一个一一对应的数据集合W(这个数据集的意义是:每个的对应的值代表了xi和目标值的残差,是下一轮学习的目标)。

,根据此公式,训练数据通过它之后就可以得到一个一一对应的数据集合W(这个数据集的意义是:每个的对应的值代表了xi和目标值的残差,是下一轮学习的目标)。

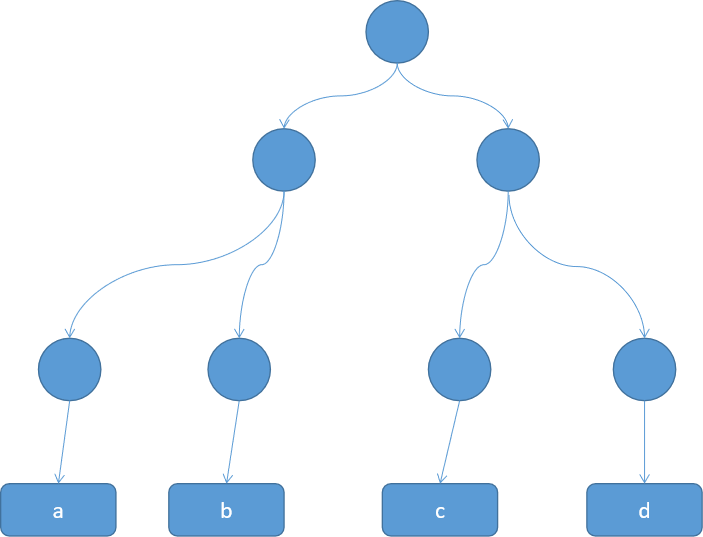

对数据集合W,建树。

最终的学习目标hi是该数据在树上最后落到的字节的点数据集经过C运算,得到的值:

最终的学习目标hi是该数据在树上最后落到的字节的点数据集经过C运算,得到的值: 。软化,增强泛化性。

。软化,增强泛化性。

最终的到 。

。

总结集成学习三大模型

| 模型 | RFT | Adaboost | GBDT |

| 学习方式 | 并行学习 | 串行学习 | 串行学习 |

| 学习目的 | 强分类器提升泛化能力 | 弱分类提高分类能力 | 残差学习 |

| 所用基础分类器 | 强决策树 | 若决策树 | 决策树软化残差 |

posted on 2021-06-07 10:31 life‘s_a_struggle 阅读(97) 评论(0) 收藏 举报

,对于0-1分类,由于输出值具有概率意义,至于在0~1,所以必须通过hi转换到至于为r的空间,方便残差学习。

,对于0-1分类,由于输出值具有概率意义,至于在0~1,所以必须通过hi转换到至于为r的空间,方便残差学习。

浙公网安备 33010602011771号

浙公网安备 33010602011771号