人工智能学习——第五课:Tensorflow学习——多层感知器(神经网络)与激活函数

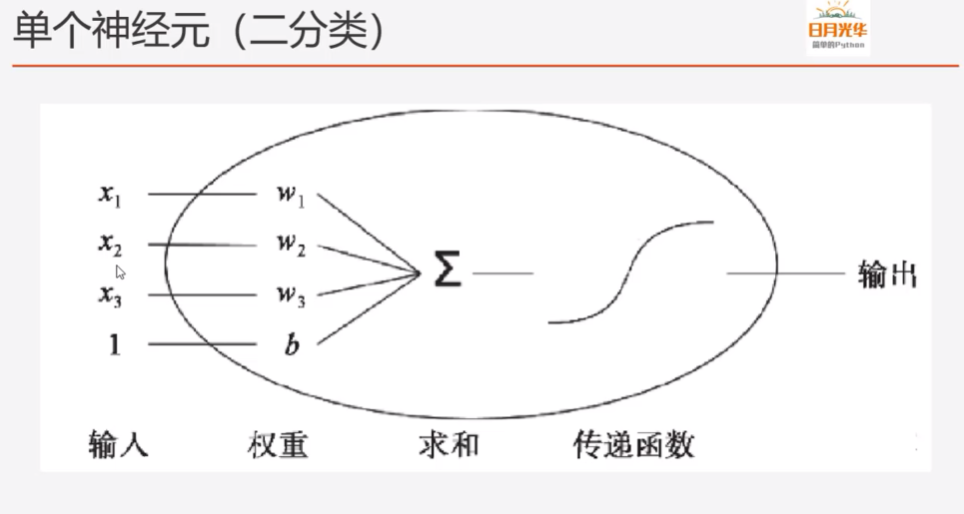

一、单个神经元

单个神经元 x1 w1 x2 w2 x3 w3 输入 权重 输入+权重,通过偏移量b求和,作为输出值; 通过激活函数对输出值作处理 ;

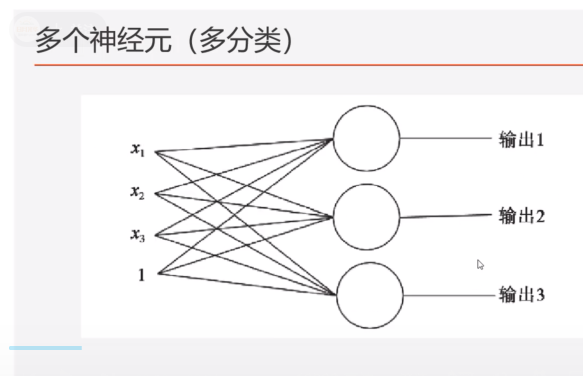

二、多个神经元(浅层学习)

多个神经元 x1 w1 x2 w2 x3 w3 1 权重 输入*权重,加上偏移量,分别建议输出; 输入数据集(x1、x2、x3、1)通过单个神经元进行单层输出的效果,没有实现深度学习的效果; 什么是深度学习? 可以实现多层级的学习模型; 单层神经元缺陷: 神经元要求数据必需是线性可分的; 单层神经元没法解决异或的拟合; 异或问题无法找到一条直线分割两个类;

导致神经网路停止不前很多年。

信号——激活神经元(信号强度)——向下一个神经元,传输信息号,实现深度三、多层感知器

生物的神经元一层一层连接起来,当神经信号达到某一个条件,这个神经元就会激活,然后继续传递信息下去。

为了继续使用神经网络解决这种不具备线性可分性的问题,采取在神经网络的输入端和输出端之间插入更多的神经元。

线性输出

线性关系无法拟合高阶输出,不属于深度学习;

原因:(多层感知器——隐含层,层数越多,非线性传输)

输入信号——隐含层(只有一层)——仍然属于线性输出;

非线性输出

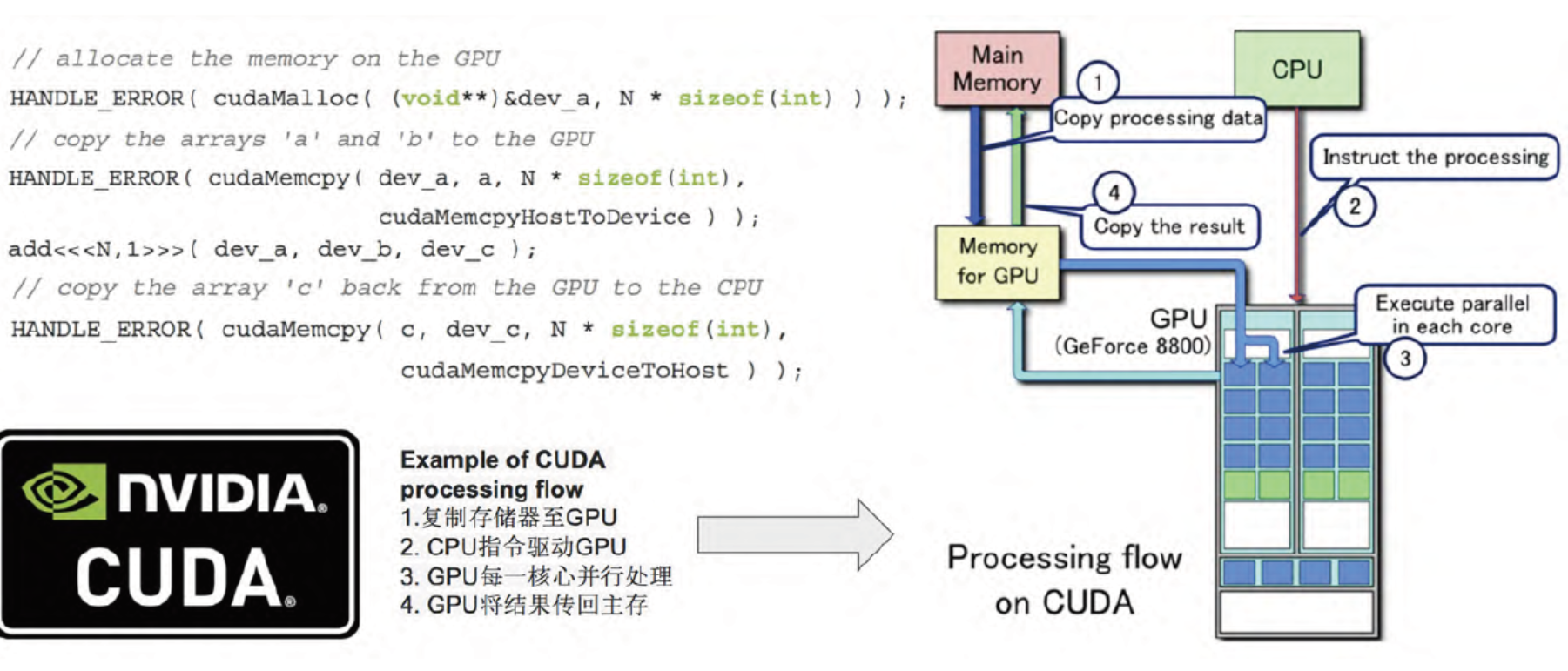

非线性输出关键点:隐含层可以不断叠加,模拟脑神经元——接收电信号,满足触发条件——不断叠加神经元处理输入电信号(类似于树状,向下不断伸展),提供满足要求的处理能力,猜想:神经元类似于主机的1个物理核,物理核足够强大虚拟96个或者更多逻辑核,对一个问题同时在多个逻辑上并行处理;

nvidia 的GPU和显存

四、激活函数

relu函数

x>0:传输型号 x<0:屏蔽信号

sigmoid函数

x接近0:梯度大; x远离0:梯度平缓;

tanh函数

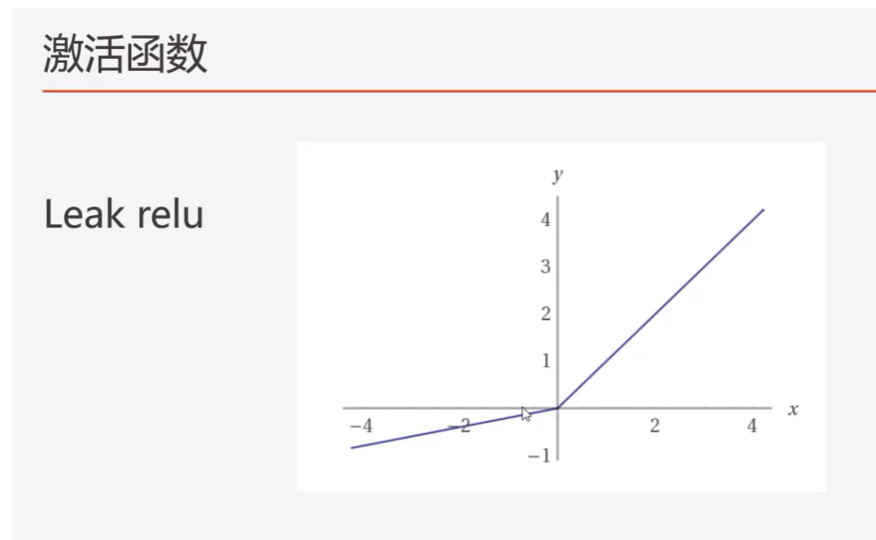

leak relu函数

常用于生成网络;

五、

六、

稳步前行,只争朝夕。

浙公网安备 33010602011771号

浙公网安备 33010602011771号