一、词频统计:

- 读文本文件生成RDD lines

- 将一行一行的文本分割成单词 words flatmap()

- 全部转换为小写 lower()

- 去掉长度小于3的单词 filter()

- 去掉停用词

- 转换成键值对 map()

- 统计词频 reduceByKey()

- 按字母顺序排序sortByKey()

- 按词频排序 sortBy()

- 结果文件保存 saveAsTextFile(out_url)

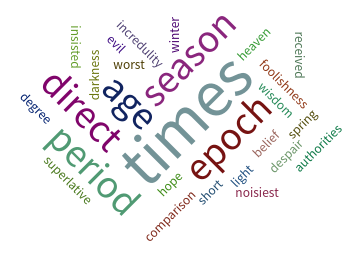

- 词频结果可视化 pyecharts.charts.WordCloud()

- 比较不同框架下(Python、MapReduce、Hive和Spark),实现词频统计思想与技术上的不同,各有什么优缺点.

答:

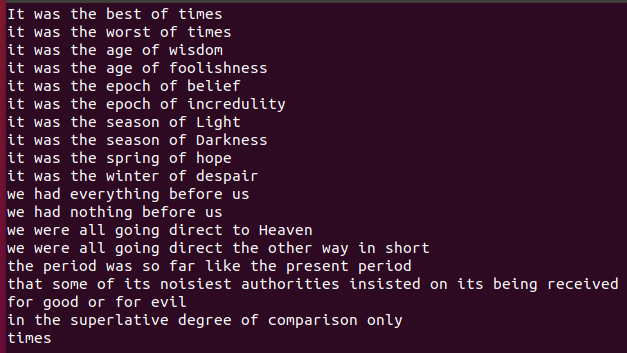

(1)文本文件

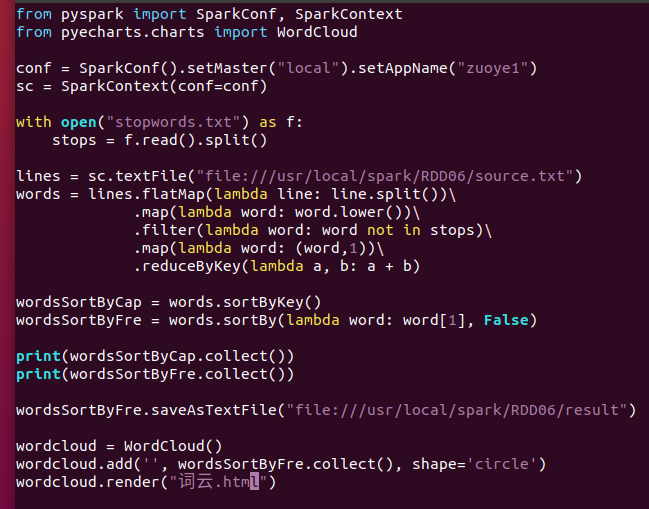

(2)代码

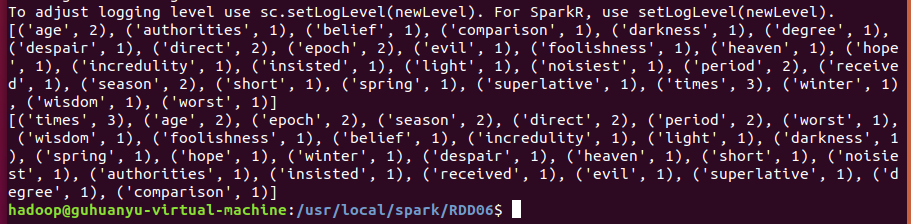

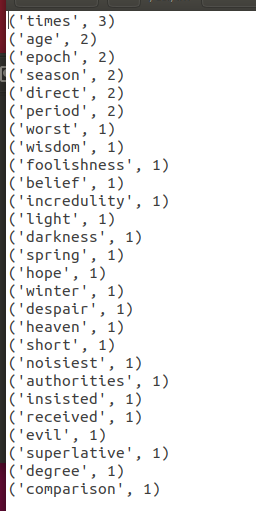

(3)运行结果

(1)Python:文件操作读取文件,循环遍历所有单词,并统计词频;操作简单,不需要导库,几行代码便可以实现。

(2)Spark:先导入pyspark并使用内置对象SparkContext,使用内置对象的方法和RDD对象的方法来实现词频统计;代码可以运行在分布式集群上,但是需要一个学习的过程。

(3)MapReduce:Java实现,代码行比Python多,需要导入很多库,写很多类;比pyspark实现的代码要复杂。

二、学生课程分数案例

- 总共有多少学生?map(), distinct(), count()

- 开设了多少门课程?

- 每个学生选修了多少门课?map(), countByKey()

- 每门课程有多少个学生选?map(), countByValue()

- Tom选修了几门课?每门课多少分?filter(), map() RDD

- Tom选修了几门课?每门课多少分?map(),lookup() list

答:

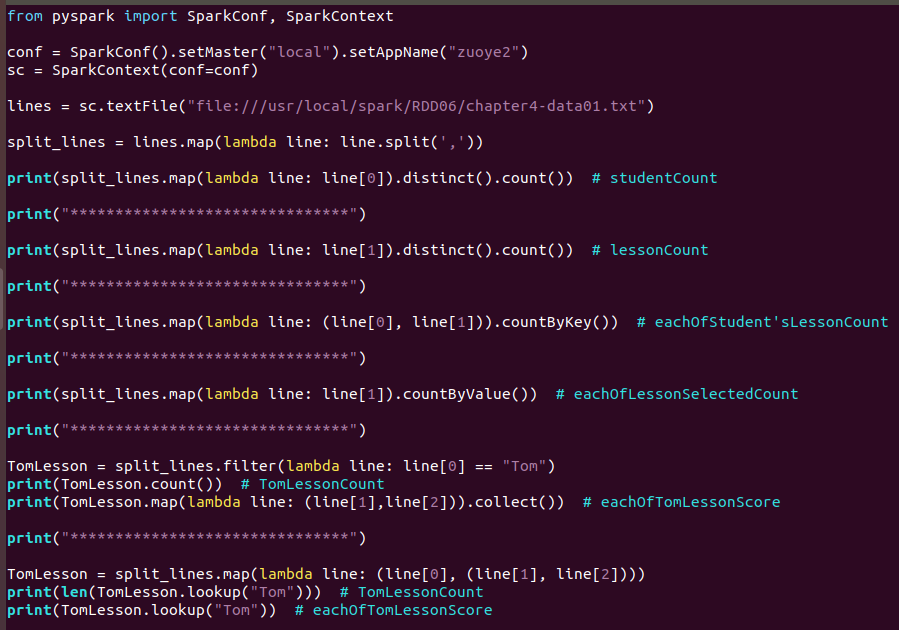

(1)代码

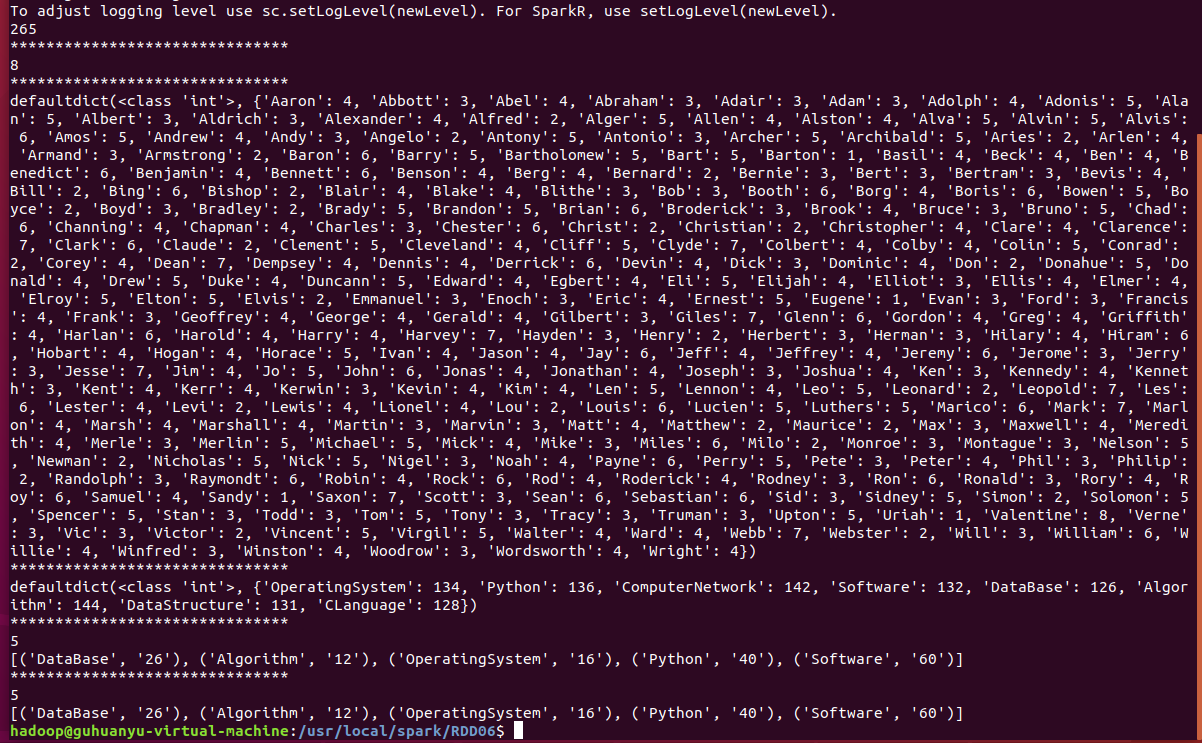

(2)运行结果

- Tom的成绩按分数大小排序。filter(), map(), sortBy()

- Tom的平均分。map(),lookup(),mean()

- 求每门课的选修人数及平均分。combineByKey()

答:

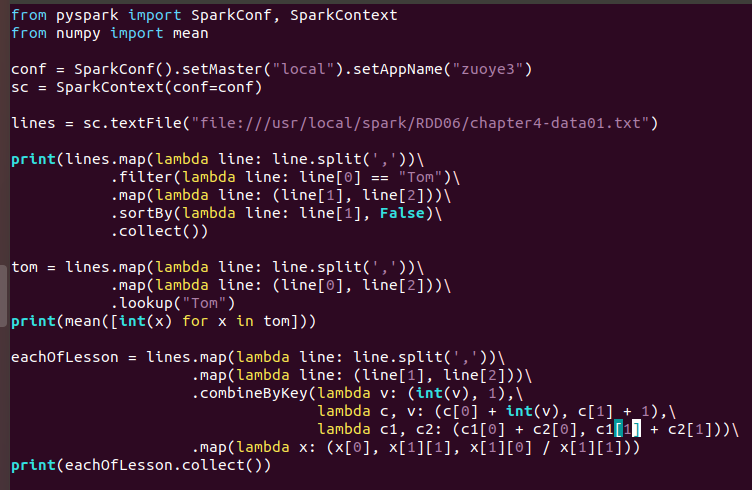

(1)代码

(2)运行结果

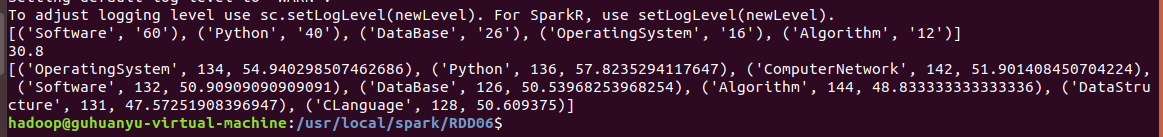

- 生成(课程,分数)RDD,观察keys(),values()

- 每个分数+5分。mapValues(func)

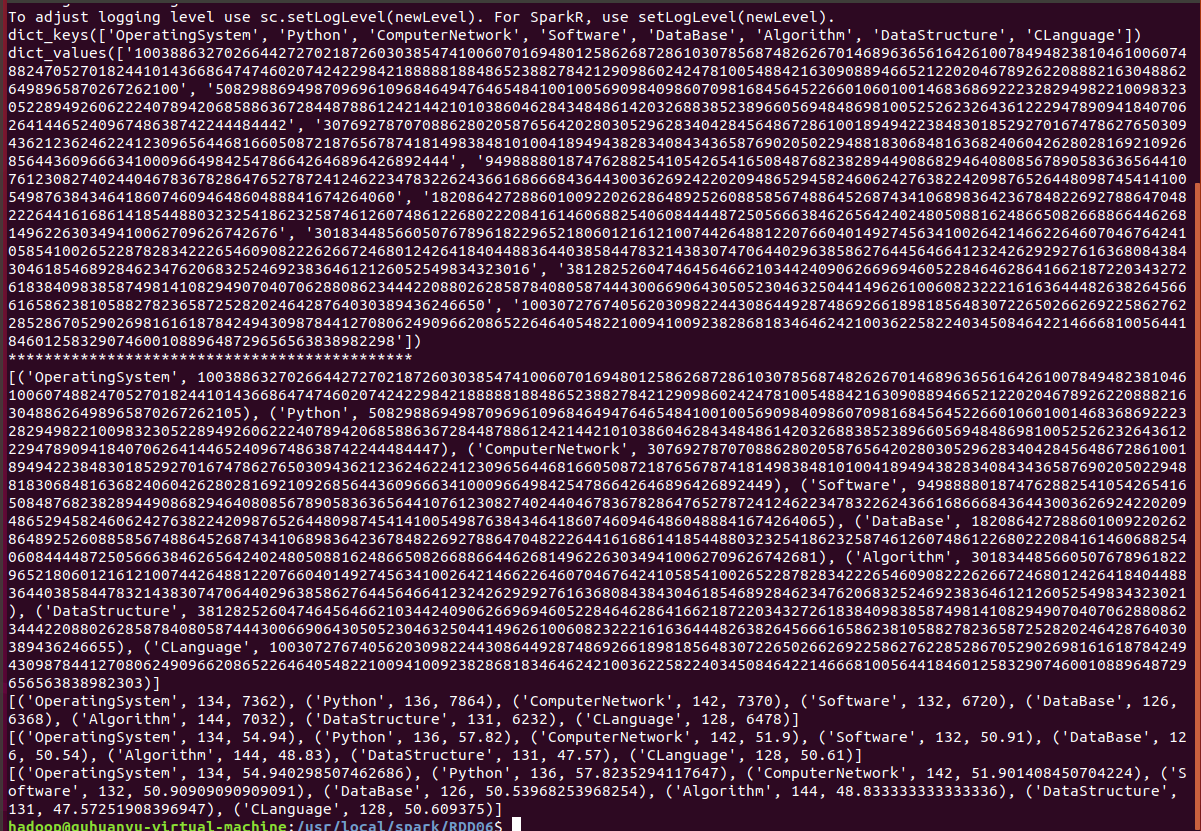

- 求每门课的选修人数及所有人的总分。combineByKey()

- 求每门课的选修人数及平均分,精确到2位小数。map(),round()

- 求每门课的选修人数及平均分。用reduceByKey()实现,并比较与combineByKey()的异同。

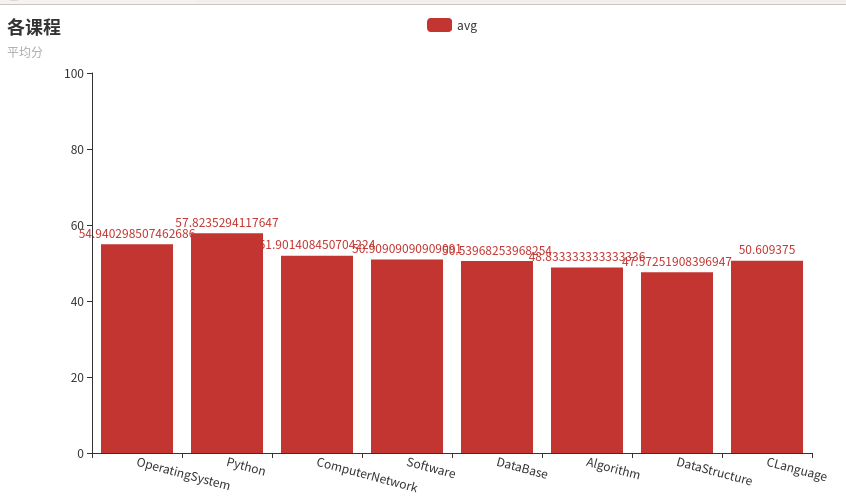

- 结果可视化。 pyecharts.charts,Bar()

答:

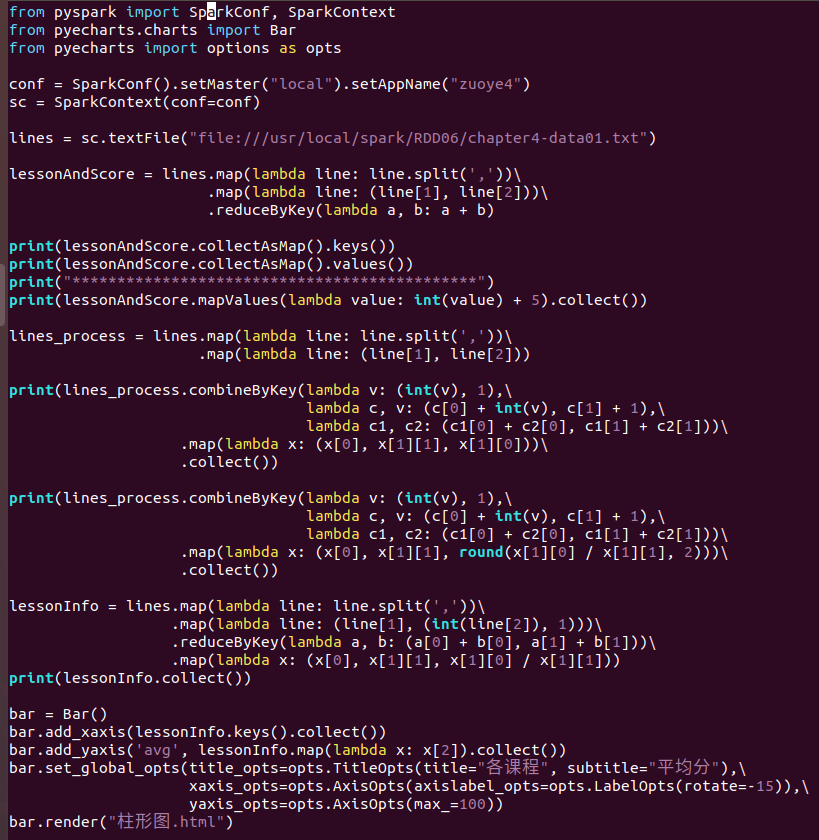

(1)代码

(2)运行结果

我觉得combineByKey()可以实现的操作,reduceByKey()都可以实现,但是combineByKey()最重要的一点是,可以跨分区操作。

浙公网安备 33010602011771号

浙公网安备 33010602011771号