自我介绍

大家好,我是2023级数据科学与大数据技术0103班的一名学生,很高兴进入这个大家庭并在此记录我接下来的学习内容,如今进入大学已经3年了,我们上了很多专业的科目虽然说成绩不错,但是真实掌握的和课程相关的技术确实不怎么会运用。我比较喜欢音乐,喜欢听歌(写作业的时候喜欢听,休息的时候也喜欢听);我认为我的数学还是OK的,对于这该门科目,我除了上课听老师讲的知识,自己还会额外去学习有关这两门课的网课。

对于目前我的状况来说,我们已经学了很多很多专业知识,我对数据分析方向比较感兴趣,想深入学习有关数据分析的内容,但是我现有的能力不足以支撑,有许多欠缺的能力。如下:

现有能力:

基础编程能力:了解JAVA和python基础语法,基本上能够使用。

大数据入门:熟悉linux基本命令,能在center OS系统中完成JAVA环境配置;了解Hadoop的核心组件,例如mapreduce,HDFS,了解各组件的功能和交互流程;了解HDFS分布式文件系统的基本概念,能在虚拟机上完成hadoop的单机、集群部署,了解分布式的核心是分而治之。

数据处理工具:熟练使用excel(V lookup函数,条件格式),能完成500行左右数据的统计;了解python的pandas,numpy库。

统计学基础:掌握描述性统计(均值,方差,)概率分布(正态分布二项分布,t分布等等),能运用假设检验(卡方检验,t检验)解决简单的数据分析问题。

所欠缺的能力:

①不会用可视化工具将分析结果转化为直观的可视化报告。

②缺乏实际的业务场景经验

③SQl仅掌握基础查询,对进阶内容不熟悉,对nosql数据库了解较少

④面对海量数据时容易陷入误区,不能够系统的分析逻辑并解决问题

希望能在课程中掌握有关数据分析师的核心工作(SQL+python+可视化数据),能够理解不同行业的业务逻辑,希望能通过学习以及通过一些真实案例来提升分析思维和业务敏感度

对于我现在目标来说,主要是考研,每天都有花时间来复习考研数学以及考研英语;但是我也想成为一名数据分析师,我会认真学习课程上所安排的专业课,尽量掌握该掌握的知识。

优势:耐心细致吧,能够处理数据中的异常;喜欢沟通,能够将分析结果用自己的语言表达给他人;自制力较强,能够按照自己规划去实施

劣势:知识储备不足,分析时容易脱离实际情况;思维逻辑不够系统,对于复杂问题的拆解不能够用专业的思维逻辑来思考;对SQL进阶语法掌握不牢,处理大量数据查询时效率低;

目前的代码量:java150行左右,Python150行左右,sql100行左右,总共400行左右(均为布置的课堂作业以及代码练习)

行业要求:通过上网查询了解到,入职中大型企业的数据分析师岗位累积代码量需达8千到1万行,其中sql代码占比约40%,需包含复杂业务查询,Python代码以数据处理和简单建模为主,同时需要具备可视化工具的实操经验

对于该门课程来说;大数据分析这门课程是大数据时代的核心课程之一。在接下来的十周里,每周将学习一个重要的数据科学技术领域,通过逐步积累,构建起完整的数据科学知识体系。

每周学习重点

(一)第一周-课程自我介绍

本周作为课程的开篇,主要目的是让大家对整个课程有一个全面的了解,包括课程目标、涵盖的技术范围以及学习方法等。

(二)第二周-数据采集

数据采集是大数据分析的第一步。我们将学习如何从各种数据源(如数据库、网络API、文件系统等)收集数据。这包括了解不同的数据格式(如CSV、JSON、XML等),掌握数据采集工具(如网络爬虫、ETL工具等)的使用方法,以及处理数据采集过程中的常见问题,如数据的完整性、准确性和合法性。

(三)第三周-numpy和pandas

numpy和pandas是Python中用于数据处理和分析的重要库。

①numpy提供了高效的多维数组操作功能,包括数组的创建、索引、切片、数学运算等。它是许多其他数据科学库的基础,能够大大提高数据处理的效率。

②pandas则侧重于数据结构和数据分析工具。它提供了两种主要的数据结构:Series(一维数据结构)和DataFrame(二维数据结构)。通过pandas,我们可以方便地进行数据清洗、转换、合并、分组等操作。

(四)第四周-线性回归、逻辑回归、决策树

①线性回归是一种用于预测数值型目标变量的方法。它基于线性模型,通过最小二乘法来拟合数据,找到最佳的直线(或超平面)来描述自变量和因变量之间的关系。

②逻辑回归用于处理分类问题,特别是二分类问题。它通过将线性模型的输出经过逻辑函数(如sigmoid函数)转换为概率值,来判断样本属于某个类别的可能性。

③决策树是一种基于树结构的分类和回归方法。它通过对特征进行逐步划分,构建出一棵决策树,每个内部节点表示一个特征测试,每个分支代表一个测试输出,每个叶节点代表一个类别或数值。

(五)第五周-随机森林、XGBoost

①随机森林是一种集成学习方法,它由多个决策树组成。在训练过程中,随机森林通过对训练数据进行有放回的抽样和特征的随机选择,构建多个不同的决策树,然后通过投票(分类问题)或平均(回归问题)的方式得到最终的预测结果。随机森林具有很好的鲁棒性和泛化能力。

②XGBoost是一种基于梯度提升算法的高效机器学习库。它通过迭代地训练弱学习器(通常是决策树),并根据损失函数的梯度来调整模型的权重,逐步提升模型的预测性能。XGBoost在许多数据挖掘竞赛中取得了优异的成绩,广泛应用于各种分类和回归问题。

(六)第六周-聚类、神经网络

①聚类是一种无监督学习方法,用于将数据集中的样本划分为若干个不同的簇。常见的聚类算法包括K - Means聚类、层次聚类等。聚类的目的是使同一簇内的样本尽可能相似,而不同簇的样本尽可能不同,从而发现数据中的潜在结构。

②神经网络是一种模拟人类大脑神经元结构的机器学习模型。它由多个神经元组成,通过调整神经元之间的连接权重来学习数据中的模式。神经网络具有很强的非线性拟合能力,能够处理复杂的数据关系,在图像识别、语音识别、自然语言处理等领域取得了巨大的成功。

(七)第七周-TensorFlow、Keras

①TensorFlow是谷歌开发的一款开源的深度学习框架。它提供了高效的张量运算和自动求导功能,支持构建各种复杂的深度学习模型。TensorFlow具有高度的灵活性和可扩展性,可以在不同的硬件平台(如CPU、GPU、TPU)上运行。

②Keras是一个高层神经网络API,它构建在TensorFlow等后端之上,提供了简单易用的接口来快速搭建和训练深度学习模型。Keras适合初学者快速上手,能够在短时间内构建出有效的神经网络模型。

(八)第八周-LSTM、自编码器

①LSTM(长短期记忆网络)是一种特殊的循环神经网络(RNN),它通过引入门控机制,解决了RNN在处理长序列数据时的梯度消失和梯度爆炸问题。LSTM在时间序列预测、自然语言处理等领域有广泛的应用。

②自编码器是一种无监督学习模型,它的目标是通过将输入数据进行编码和解码,尽可能地重构输入数据。自编码器可以用于数据降维、特征提取、数据去噪等任务。

(九)第九周-情感计算、RFM模型

①情感计算是研究如何使计算机能够识别、理解、生成和模拟人类情感的技术。在数据分析中,情感计算可以用于分析文本、语音等数据中的情感倾向,为市场营销、用户体验分析等提供支持。

②RFM模型是一种客户细分模型,它通过客户的最近一次消费(Recency)、消费频率(Frequency)和消费金额(Monetary)三个维度来对客户进行分类,帮助企业识别高价值客户,制定精准的营销策略。

(十)第十周-遗传算法、蚁群优化算法

①遗传算法是一种基于生物进化理论的优化算法。它通过模拟自然选择、交叉和变异等过程,在解空间中搜索最优解。遗传算法常用于解决复杂的优化问题,如函数优化、组合优化等。

②蚁群优化算法是模拟蚂蚁觅食行为的一种群体智能算法。蚂蚁在觅食过程中会通过释放信息素来引导同伴找到食物源,蚁群优化算法利用这种信息素机制来寻找最优路径或解决优化问题。

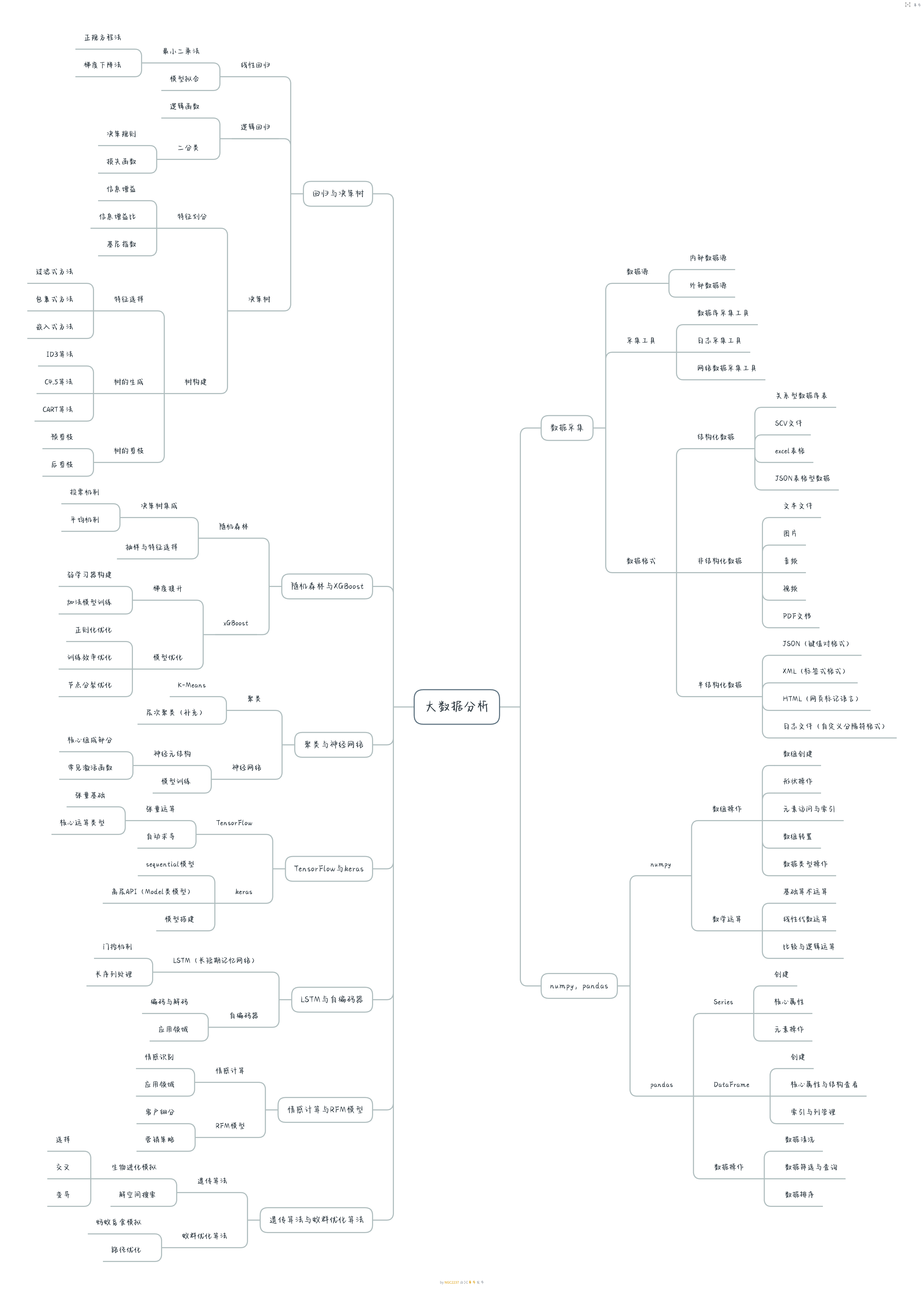

3.思维导图

希望通过这十周的学习,我可以比较系统地掌握数据科学与大数据分析的核心技术,对我来说,这门课不仅是专业知识的积累,更是作为一名数据分析师所必备的技能,在接下来的学期里,我会认真学习该门课程,为未来在相关领域的工作和研究打下坚实的基础。(以后再补充)|

浙公网安备 33010602011771号

浙公网安备 33010602011771号