[PaperReading] Qwen3 Technical Report

Qwen3 Technical Report

link

时间:25.05

单位:Qwen Team

相关领域:LLM

被引次数:2378

项目主页:https://github.com/QwenLM/Qwen3

TL;DR

Qween3.0既有Dense也有MoE架构,参数量分布从0.6B到235B。Qween3的创新点是将思考与非思考模型整合到统一框架,这样用户不需要手动在两种模式间切换,取而代之的是"思考预算"机制,允许用户在推理过程中自适应地分配计算资源,根据任务复杂度平衡延迟和性能。

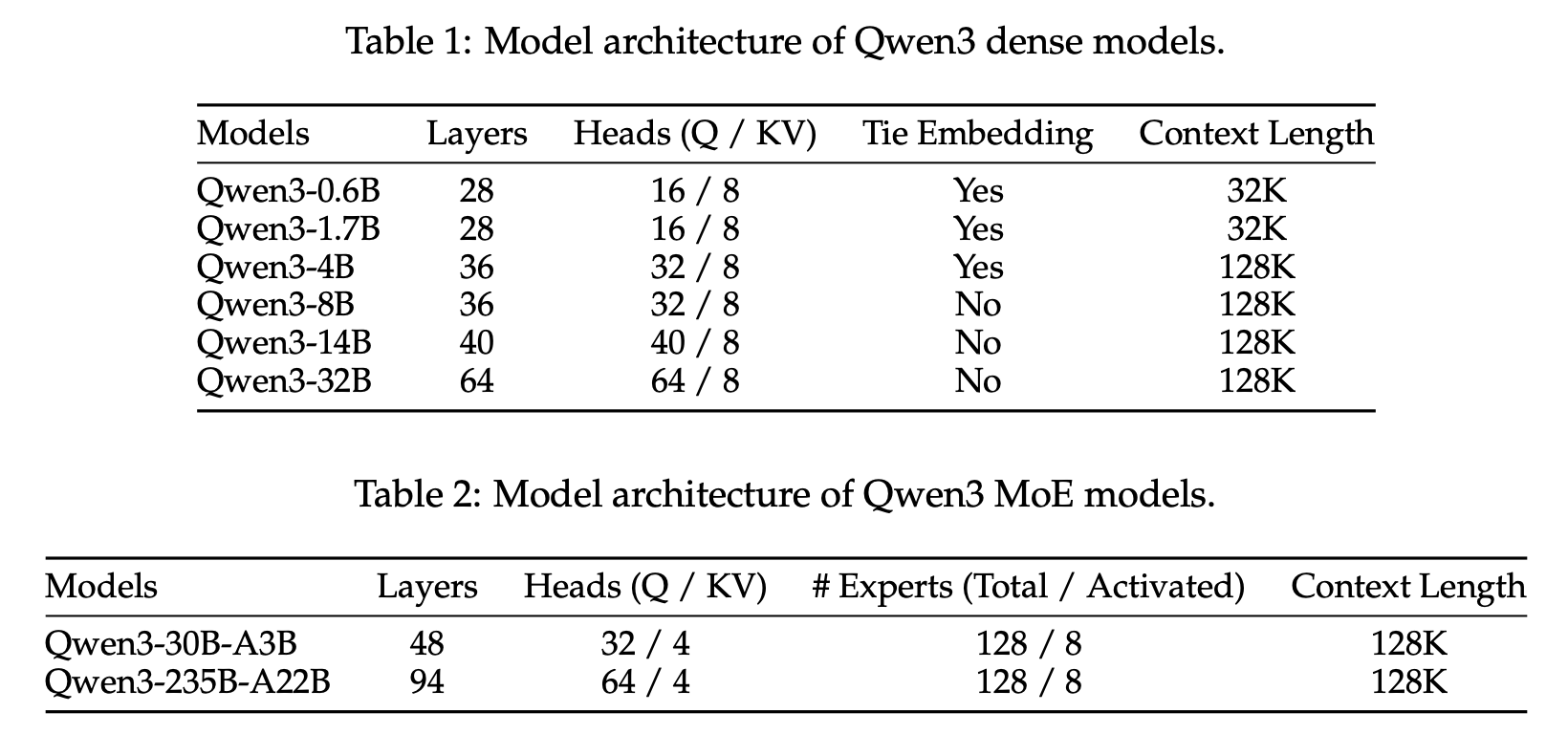

Architecture

Method

Pre-training

**Data: ** 36T tokens,来源:领域知识STEM(science, technology, engineering, mathematics) + coding + 合成数据 + 多模态提取(Qween2.5VL从pdf中提取与清洗)。预训练数据中包含119种语言(Qween2.5仅支持29种)。

Pre-training Stage

- General Stage (S1): Qwen3模型在4,096 token的序列长度上训练超过30万亿token,建立了语言能力和通用世界知识的坚实基础。

- Reasoning Stage (S2): 增加STEM、编码、推理和合成数据的比例优化预训练语料库。模型在4,096 token的序列长度上进一步预训练约5T更高质量的token。

- Long Context Stage: 收集高质量长上下文语料库以扩展Qwen3模型的上下文长度。所有模型在32,768 token的序列长度上预训练数千亿token。

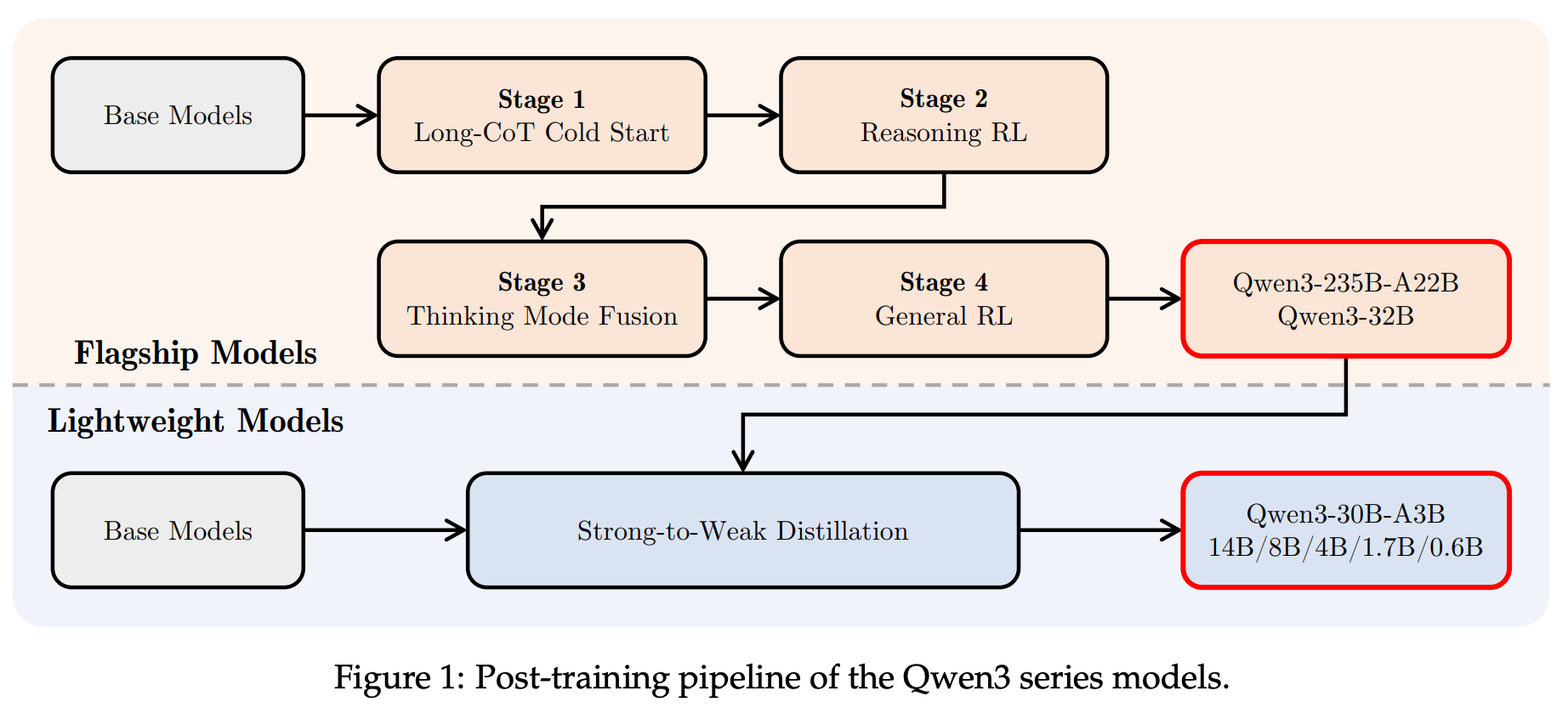

Post-training

Long-CoT Cold Start

两阶段构建LongCoT数据集,SFT冷启动,训练Loss上:

- 损失计算范围:覆盖整个序列(思考过程+最终答案)

- 权重分配:对思考步骤token给予更高权重

- 正则化项:添加了连续性约束和格式一致性惩罚

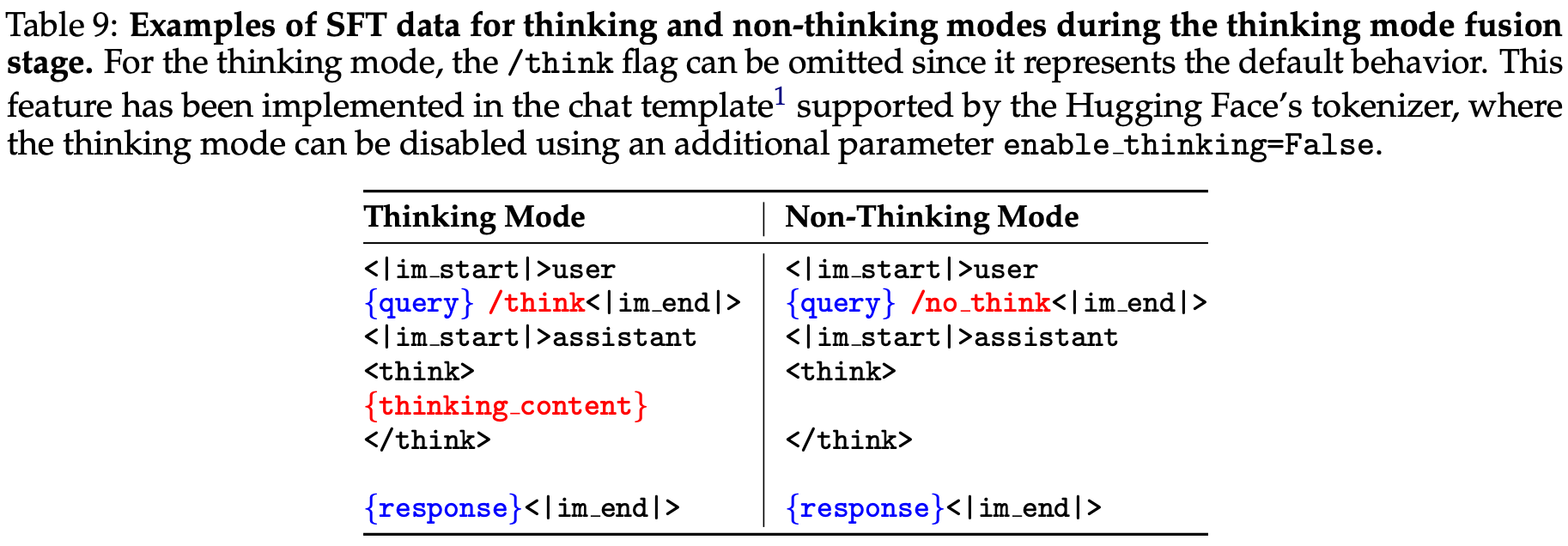

Thinking Mode Fusion

什么是Thinking Mode Fusion?

出发点:之前对于开发者而言,既需要部署think模型,也需要部署no-think模型,希望开发think与nothink统一模型。

该阶段本质上是基于SFT的增强型训练。首先构建think与no-thinking混合SFT数据集,使得两种模型是可联合训练起来。模板也按照下面方式统一,区别在于/think与/nothink标识。

为了允许用户在推理过程中自适应地分配计算资源,训练时如果回答长度过长,会插入以下提示,模型根据已有推理信息尽快输出结果。

“Considering the limited time by the user, I have to give the solution based on the thinking directly now.\n.\n\n”

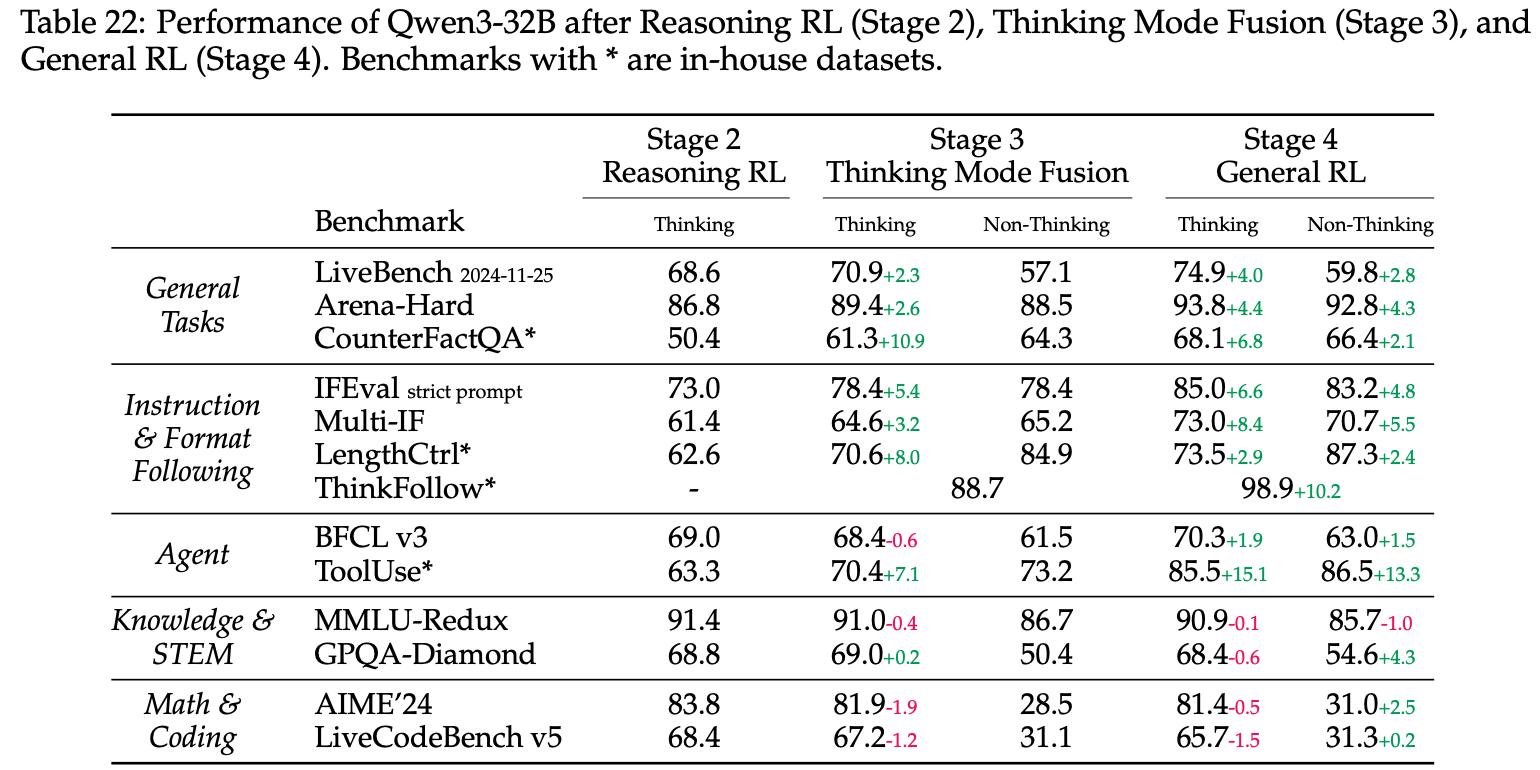

Stage2的Reasoning RL 与 Stage4的General RL 有什么区别?

Reasoning RL(第二阶段):数学推理与代码生成等高阶认知任务

- 核心目标:培养深度推理能力

- 关键指标:AIME得分(85.1)、Codeforces评级(2056)

- 训练方式:GRPO

General RL(第四阶段):覆盖20+通用能力维度

- 核心目标:实现综合能力对齐

- 关键指标:AlignBench v1.1(8.94)、Arena-Hard(95.6)

- 训练方式:

- Rule-based Reward

- Model-based Reward with Reference Answer (使用Qwen2.5-72B-Instruct作为Reference模型)

- Model-based Reward without Reference Answer (根据人类偏好训练Reward模型)

Strong-to-Weak Distillation

使用Qwen3-32B or Qwen3-235B-A22B等Teacher模型来蒸馏 dense models (Qwen3-0.6B, 1.7B, 4B, 8B, and 14B) and one MoE model (Qwen3-30B-A3B)等Student模型。

Experiment

Performance of Different Stage

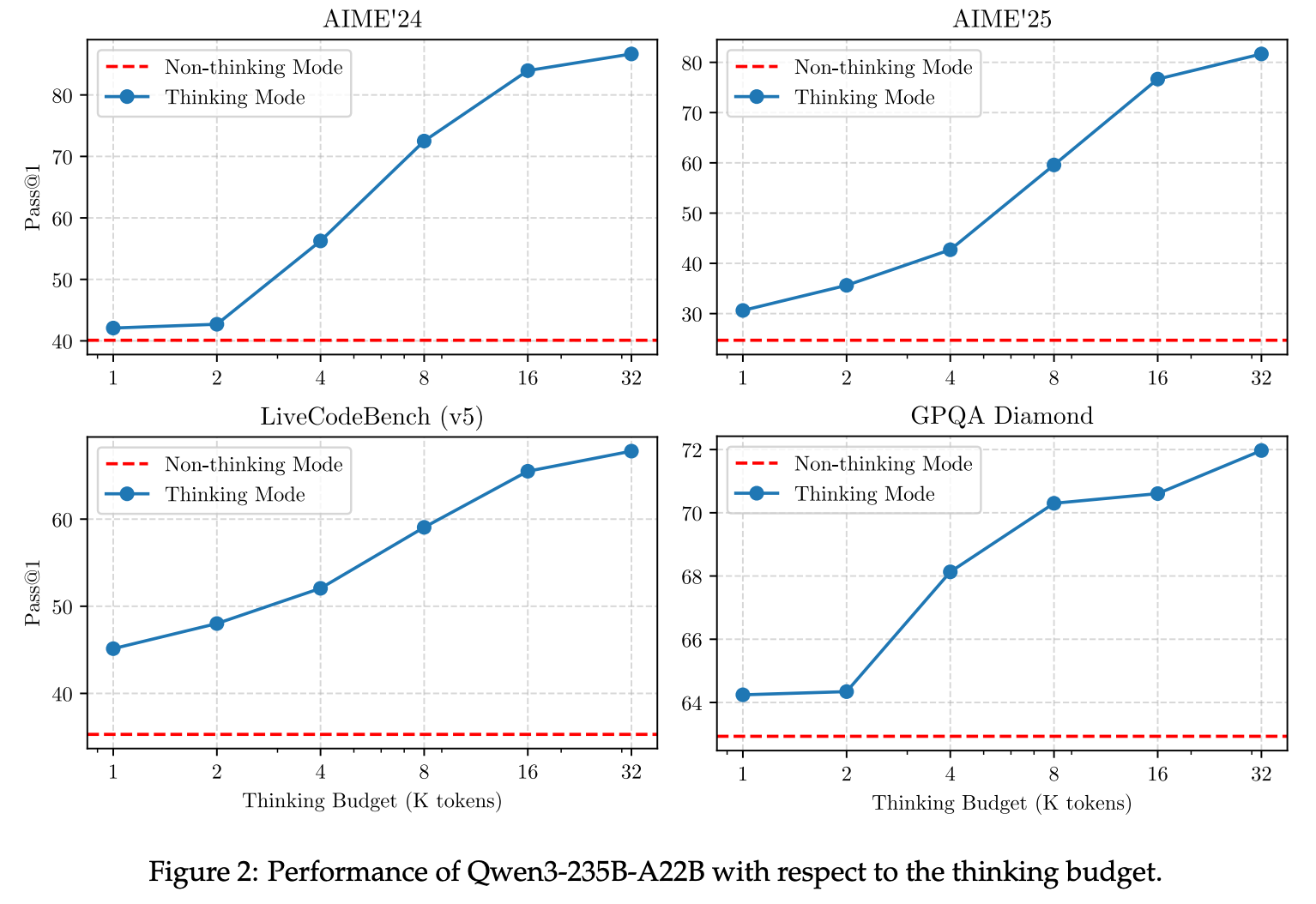

Think Budget

总结与思考

无

相关链接

https://www.zhihu.com/question/1930932168365925991/answer/1931651556656263928

https://www.zhihu.com/question/1914286810902827620/answer/1924558141305099927

本文来自博客园,作者:fariver,转载请注明原文链接:https://www.cnblogs.com/fariver/p/19018749

浙公网安备 33010602011771号

浙公网安备 33010602011771号