Dify 预建集成指南:无缝连接 MaaS、API 与 MCP 平台

作为⼀款开源的⼤模型应⽤开发平台,Dify 始终围绕两个核⼼⽬标构建:大幅降低开发门槛与全面提升开发效率。借助其预建的集成能⼒,开发者能够轻松连接各类主流模型即服务(MaaS)、常⽤ API 服务以及新兴的 MCP 平台,⽽⽆需从零构建适配层。

Dify 与模型即服务(MaaS)的预建集成

在模型集成⽅⾯,Dify 原⽣⽀持多种主流⼤语⾔模型,提供真正开箱即⽤的体验。

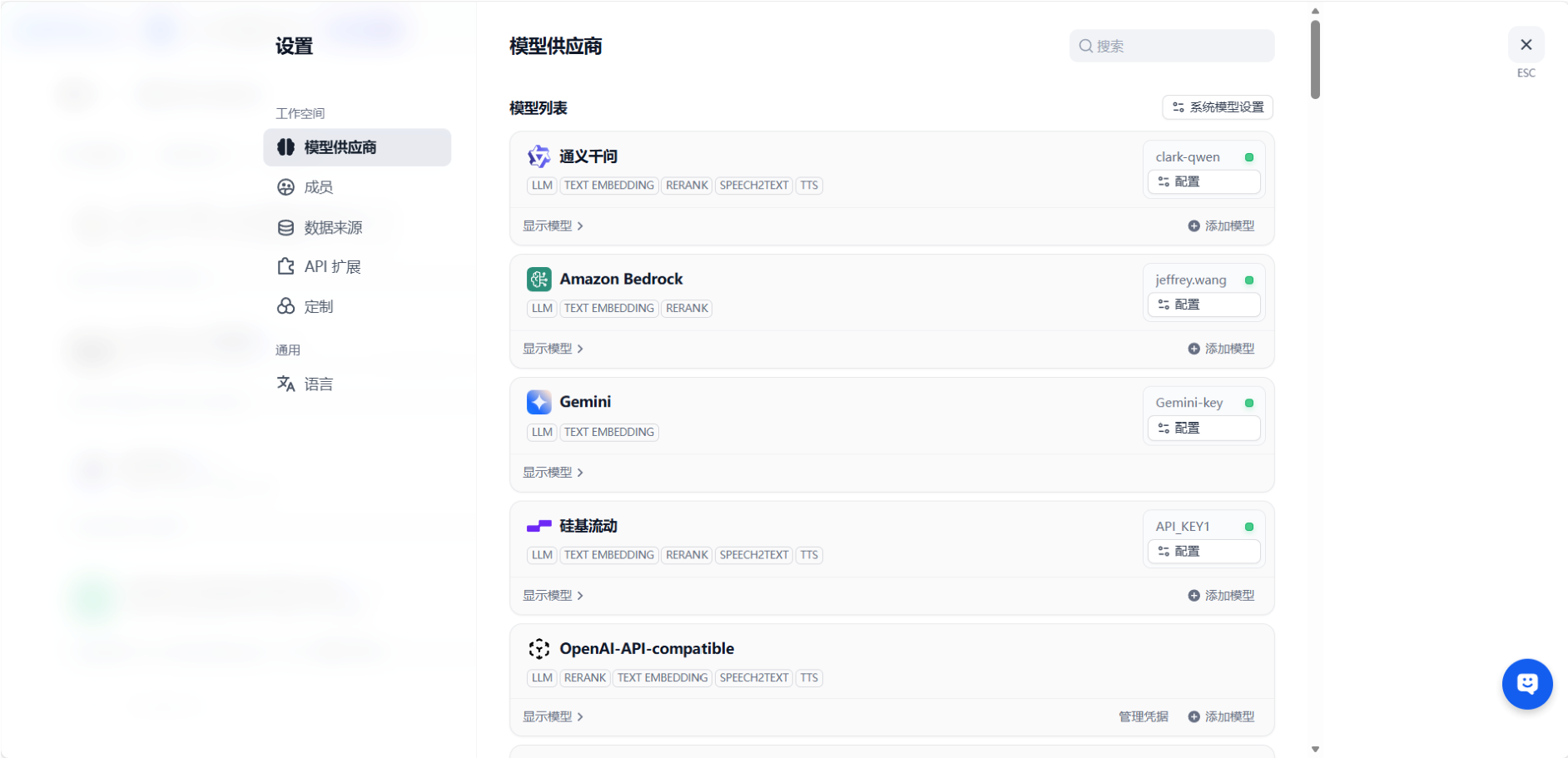

01 模型供应商插件

Dify 通过插件机制实现其模型⽆关性的设计理念。⽆论您使⽤ OpenAI 的 GPT 系列、Anthropic 的 Claude,还是 Llama、ChatGLM 等开源模型,只需下载对应的模型供应商插件,即可统⼀通过LLM节点调⽤⼀系列模型服务。这种设计让开发者摆脱了为每个模型学习不同 API 规范的负担,极⼤简化了开发流程。

02 私有化模型的集成

除了公有云模型服务,Dify 还⽀持与企业内部部署的私有化模型⽆缝集成。通过简单的配置,您可以通过VLLM、Ollma、OpenAI API compatible等插件连接企业内部的私有化部署模型。这种灵活性使 Dify 既能满⾜初创团队快速验证需求,也能适应⼤型企业对数据隐私和定制化的严格要求。

03 极简配置流程

在 Dify 中添加新的模型服务通常只需⼏个简单步骤:进⼊模型设置界⾯,选择提供商类型,输⼊ API 密钥和端点 URL。直观的操作界⾯让原本需要数⼩时的集成⼯作,缩短到⼏分钟即可完成,真正消除了复杂的编码需求。

Dify 与 API 服务的预建集成

Dify 内置了丰富的 API ⼯具集,让 AI 应⽤能够轻松与外部服务和数据进⾏交互。

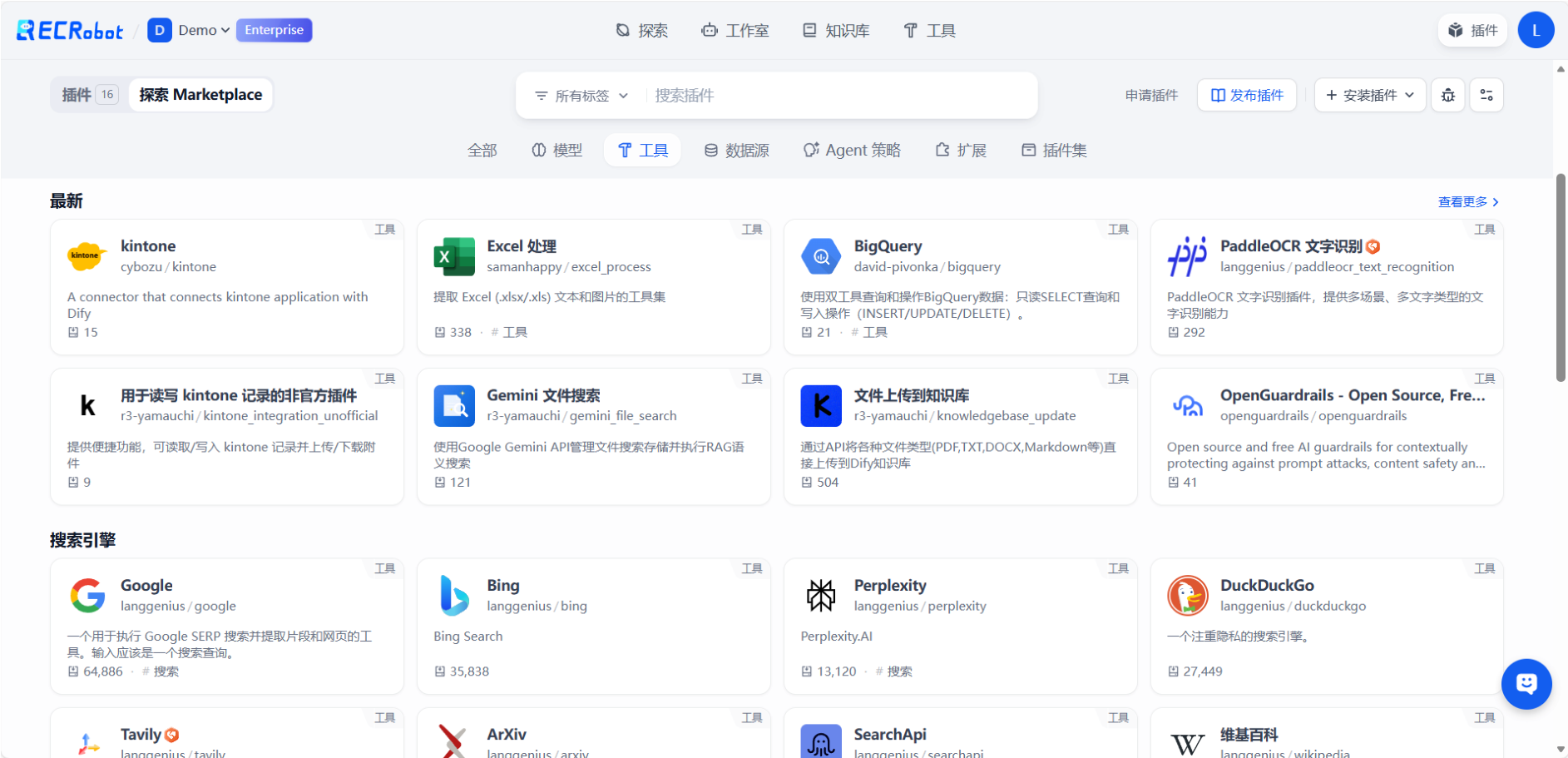

开箱即用的 API 连接器

Dify 提供了多种预建⼯具,覆盖了 Google Search、DALL·E 图像⽣成、计算器、⽹⻚抓取等常⻅ API 服务。这些⼯具可以直接拖拽到⼯作流中,⽆需编写任何适配代码,极⼤提升了开发效率。

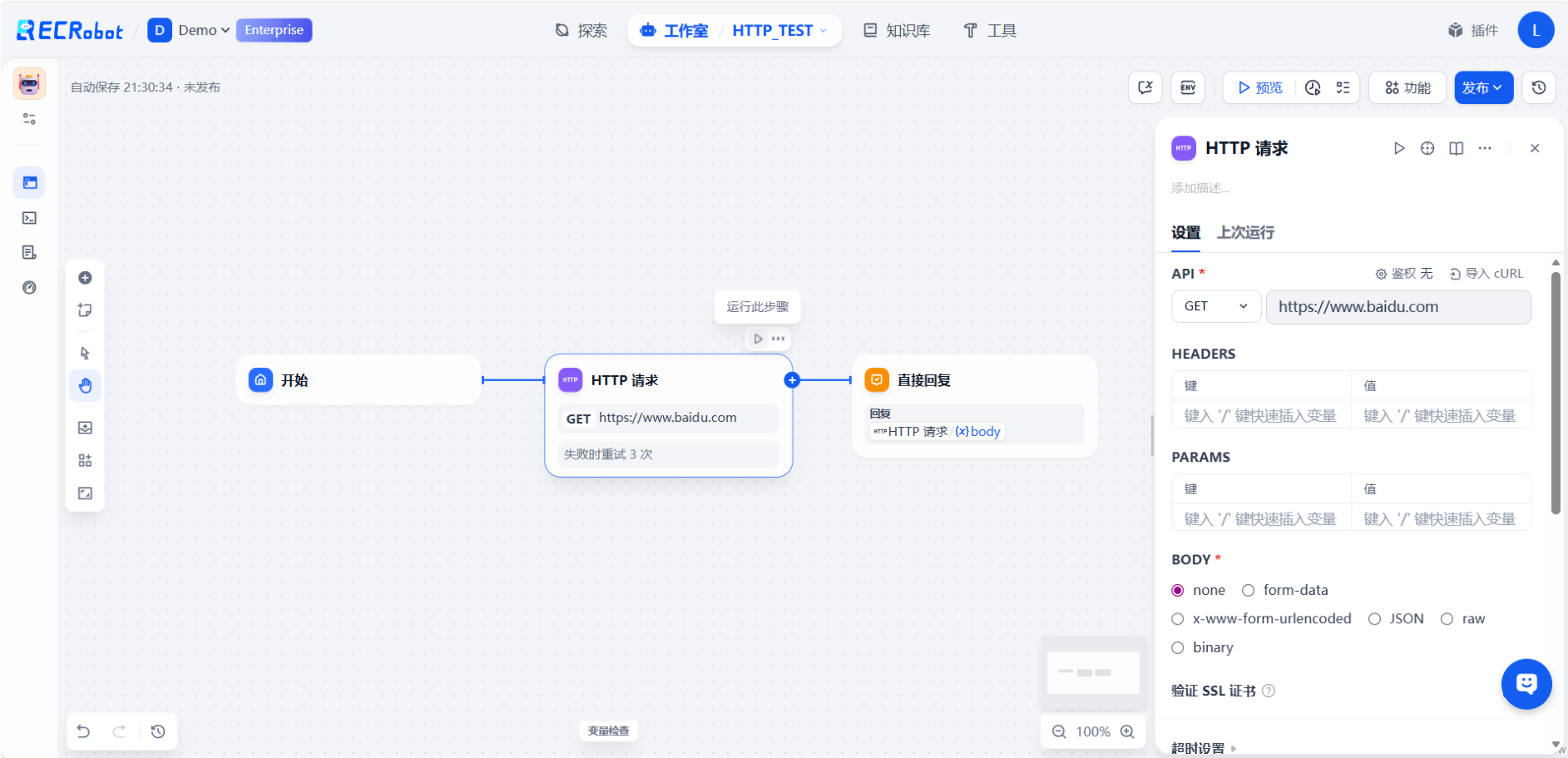

灵活的 RESTful API 集成

对于私有 API 或⾏业特定接⼝,Dify 的 HTTP 节点让集成变得异常简单。只需配置 API 的端点、调⽤参数和认证信息,Dify 便能调⽤各种系统的 API。这意味着开发⼈员能快速将有暴露 API 的CRM、ERP 等系统快速集成到 AI 应⽤中。

Dify ⽀持完整的 RESTful API 集成模式,包括:

· 多种认证⽅式(API Key、OAuth、Bearer Token)

· 灵活的请求/响应数据映射完善的错误处理和重试机制

这些功能确保了与各类 Web 服务集成的可靠性和可维护性。

Dify 与 MCP 平台的预建集成

Model Context Protocol(MCP)是由 Anthropic 提出的开放协议,旨在标准化 LLM 与外部⼯具、数据源的交互⽅式。Dify 在这⽅⾯提供了深度集成⽀持。

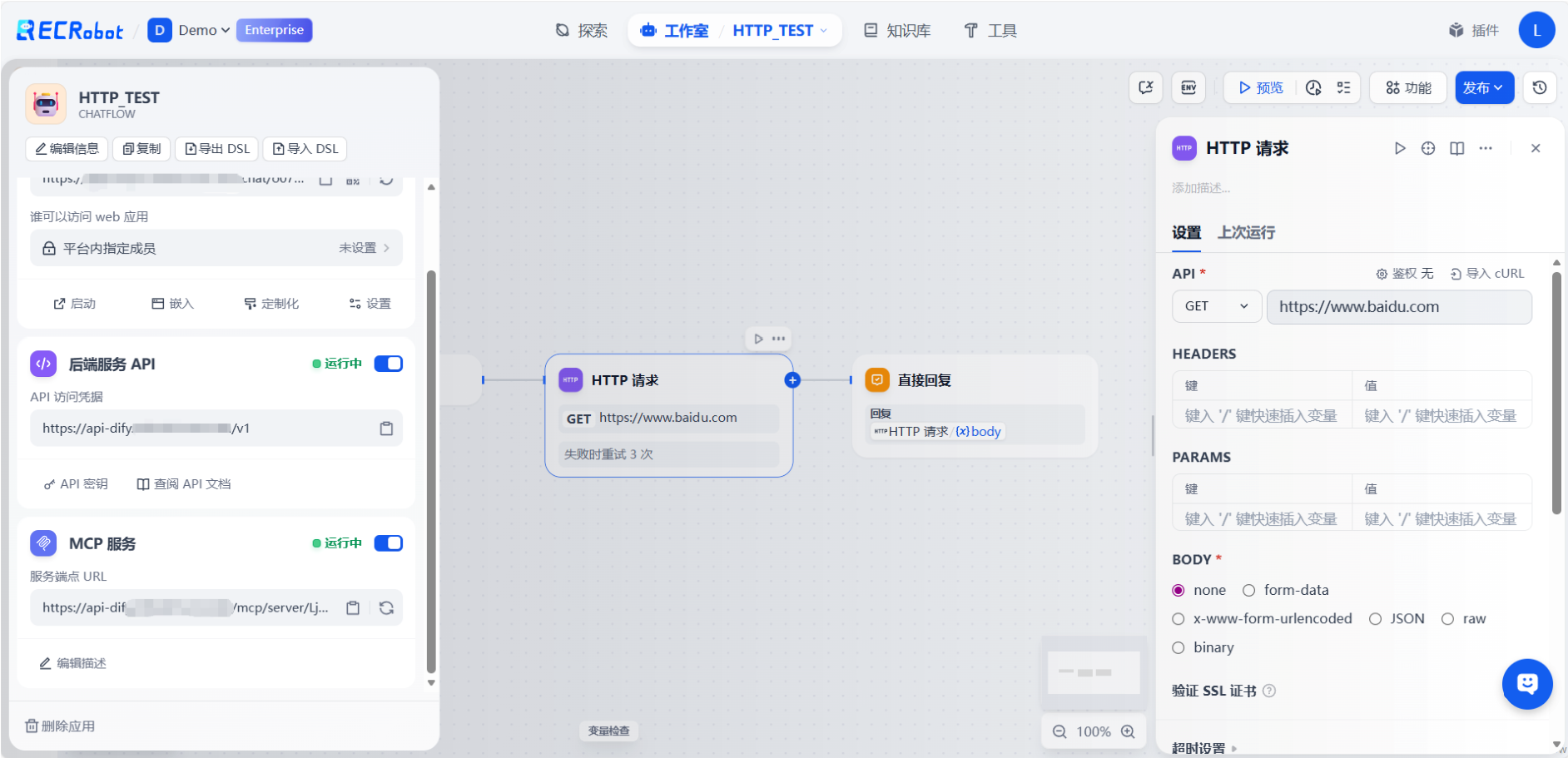

1. MCP 服务器集成

Dify 通过开启 MCP 功能,可以将任何⼯作流暴露为符合 MCP 标准的⼯具。这⼀集成带来⼏个显著优势:

·工具自动发现:AI 客⼾端能够动态获取 Dify ⼯作流作为可⽤⼯具,⽆需硬编码集成

·双向通信能力:⽀持复杂的多轮交互,超越简单的请求-响应模式

·标准化接口:基于 JSON-RPC 2.0 规范,确保与各种 MCP 客⼾端的兼容性

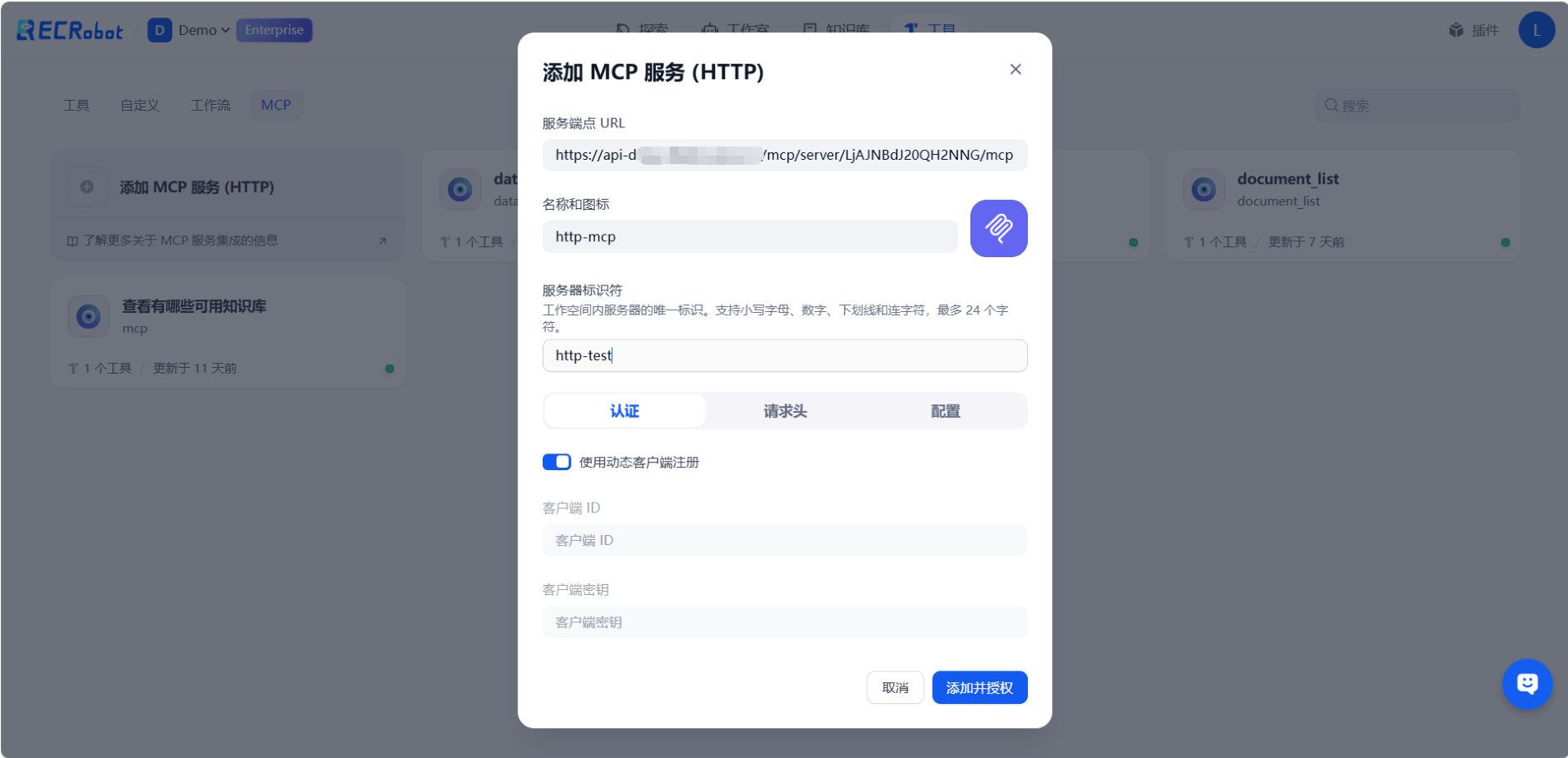

2. 作为MCP客户端

Dify 不仅可以作为 MCP 服务器,也能作为 MCP 客⼾端连接外部 MCP 服务器。这意味着您可以在 Dify ⼯作流中直接调⽤各种 MCP ⼯具,例如:

·本地⽂件系统操作数据库查询⼯具

·专有业务系统接⼝

这种双向集成的能⼒让 Dify 成为连接 AI 模型与现实世界数据和⼯具的关键桥梁。

结语

通过丰富的预建集成,Dify 极⼤地简化了与 MaaS、API 和 MCP 平台的连接过程。其低代码特性使业务⼈员也能构建复杂的 AI 应⽤,⽽灵活可扩展的架构则完全满⾜专业开发者的定制需求。

随着 MCP 协议的⽇益普及,Dify 的 MCP 集成能⼒将在 AI 应⽤开发⽣态中扮演更加重要的⻆⾊。⽆论是快速原型验证还是⽣产环境部署,Dify 都能提供⾼效、可靠的集成⽅案,让团队专注于创造核⼼价值,⽽⾮解决兼容性问题。

展望未来,Dify 势必会持续扩展其集成⽣态,⽀持更多服务和协议,不断降低 AI 应⽤开发的技术⻔槛,推动整个⾏业向前发展。

浙公网安备 33010602011771号

浙公网安备 33010602011771号