【大数据系列】hive安装及启动

一、安装好jdk和hadoop

二、下载apache-hive

https://mirrors.tuna.tsinghua.edu.cn/apache/hive/hive-2.3.0/

三、解压到安装目录并配置环境变量

tar -zxvf apache-hive-2.3.0 #解压

vi /etc/profile #打开配置环境变量的文件

export HIVE_HOME=/home/hadoop/apache-hive-2.3.0 #配置hive_home

export PATH=$PATH:/home/hadoop/apache-hive-2.3.0/bin #修改path

source /etc/profile #使环境变量生效

cd /home/hadoop/apache-hive-2.3.0/conf #切换到配置文件目录下

cp hive-default.xml.template hive-site.xml #生成hive-site.xml

vi hive-site.xml

替换${system:java.io.tempDir}为/home/hadoop/hive #替换环境变量

替换${system:user.name}为hadoop #替换环境变量

cd /home/hadoop/hive

mkdir hadoop

四、初始化schema库

cd /home/hadoop/apache-hive-2.3.0/bin

./schematool -initSchema -dbType derby #hive默认的数据库是derby

初始化完成之后,会在bin目录下创建一个metastore_db文件夹

hive #进入hive shell

五、hive常见命令

$hive>show databases; #显示库

$hive>show tables; #显示表

$hive>create database myhive; #创建库

$hive>use myhive; #启用myhive库

$hive>describe database myhive ;#查看数据库信息

$hive>describe table employee ;#查看表信息

$hive>create table test1 like test;//只是复制表结构,不复制数据

$hive>create table test3 as select id,name from test1;#复制表结构的同时内容也复制了

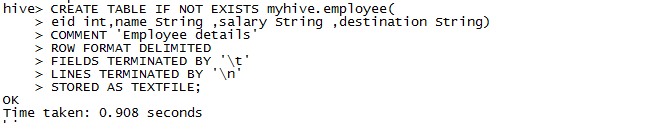

六、创建表

准备测试数据的文件

1201 Gopal 45000 Techinal manager

1202 Manisha 45000 Proof reader

1203 Masthanvali 40000 Techinal writer

1204 Krian 40000 Hr Admin

1205 Kranthi 30000 Op Admin

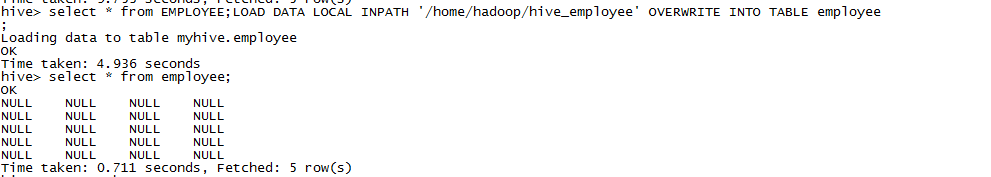

查询的数据为空,感觉看能是新建的文件中分隔符没识别出来吧,又新建了表做了测试。

FIELDS TERMINATED BY 表示字段以什么分割

LINES TERMINATED BY 表示行用什么分割

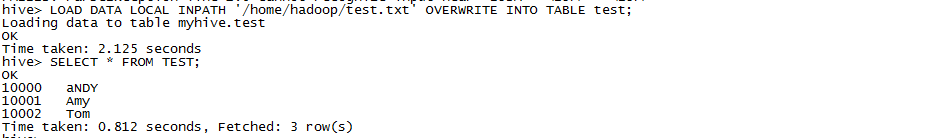

准备测试数据

10000,aNDY

10001,Amy

10002,Tom

LOAD DATA插入数据等价于hdfs上传数据

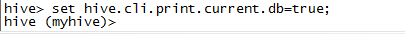

七、设置显示当前数据库

浙公网安备 33010602011771号

浙公网安备 33010602011771号