spark源码系列03-任务提交01

用spark版本1.3+

val conf=new SparkConf().setAppName("WordCount")

val sc=new SparkContext(conf)

//构建RDD并调用Transformation

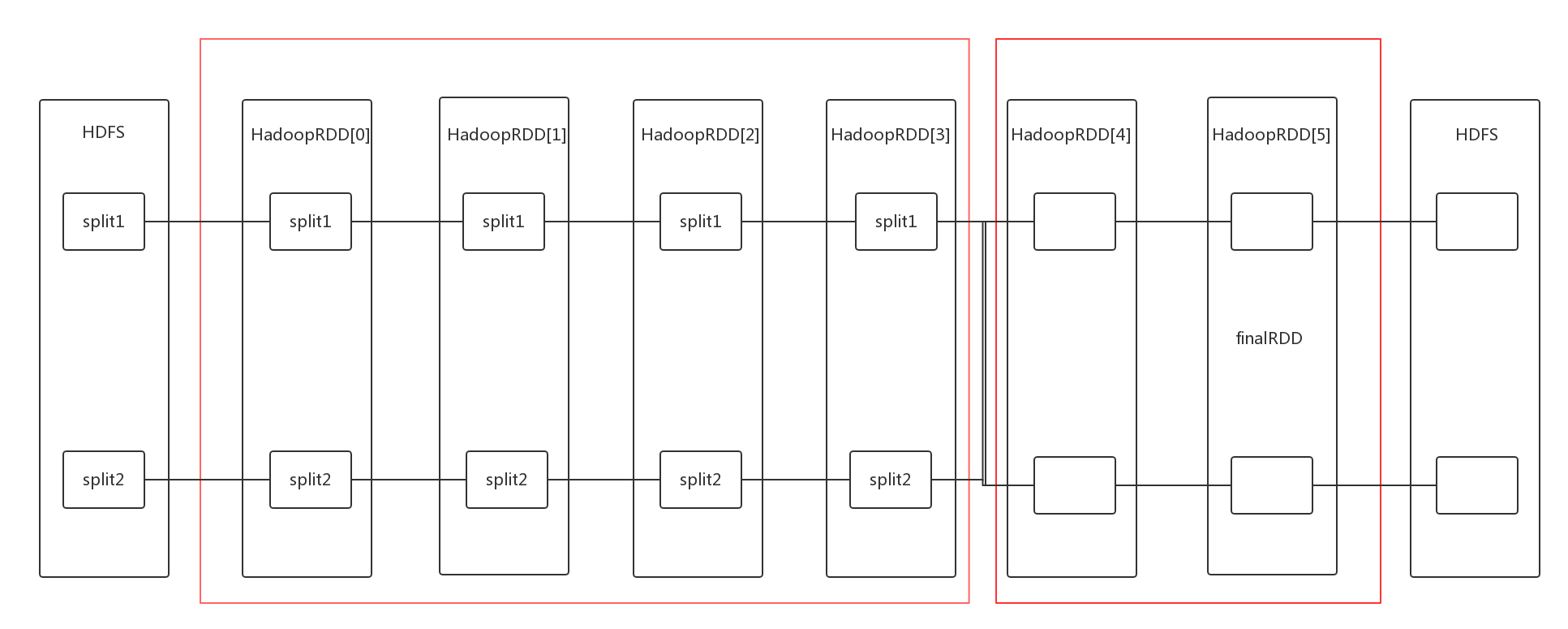

//textFile创建一个hadoopRdd,产生一个MapPartitionsRDD

//flatMap 产生一个MapPartitionsRDD

// map 产生一个MapPartitionsRDD

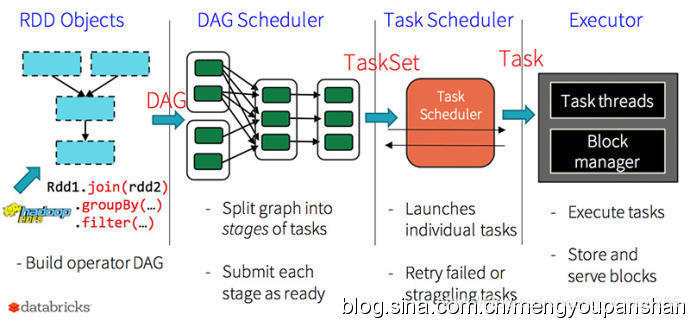

// reduceByKey 产生一个ShuffledRDD 宽依赖

// saveAsTextFile 产生一个MapPartitionsRDD

// 切分stage 记住最后个rdd 从后往前推

val wordAndCount=sc.textFile(args(0))

.flatMap(_.split(" &

浙公网安备 33010602011771号

浙公网安备 33010602011771号