scrapy爬虫框架

1,pip/pip3 install scrapy

命令框输入scrapy

报错的话/不是内部命令,先pip unstall scrapy卸载,然后再安装,找到报错信息warning,那边有一个·地址,添加到环境变量path中。再运行scrapy,如果还不是内部命令的话,跟着刚刚保存的路径,找到/scripts,复制这个的路径,去path中粘贴。重新输入scrapy。

2.scrapy startproject <项目名称>

会给你一个地址,通过pycharm打开这个文件。

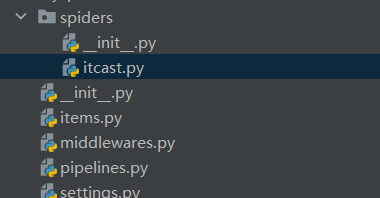

文件的作用:item.py 自己预计要爬取的内容

middlewares.py 自定义中间件的文件

pipelines.py 管道保存数据

settings.py 设置文件,ua,启动管理

spiders 自己定义的spiders文件夹

scrapy.cfg 项目的配置文件

3.创建爬虫

在项目路径下输入 scrapy genspider <爬虫名字> <允许爬虫的域名>

![]()

三个参数:name,allow_domains,start——urls

一个方法:parse 解析方法

完成爬虫:

修改起始的url

检查允许修改的域名

在parse方法中实现修改逻辑

# 获取所有教师节点,遍历所有教师节点

node_list = response.xpath('//div[@class="li_txt"]')

# print(len(node_list))

# xpath方法之后返回的是选择器对象

for node in node_list:

temp = {}

temp['name'] = node.xpath('./h3/text()').extract_first()

temp['title'] = node.xpath('./h4/text()')[0].extract()

temp['desc'] = node.xpath('./p/text()')[0].extract()

print(temp)

如果xpath只有一个节点,就使用extract——first(),否则extract()

浙公网安备 33010602011771号

浙公网安备 33010602011771号