hadoop学习笔记(一)hadoop环境搭建

目的

本文用于记录了如何安装、配置一台namenode、多台datanode的伪分布式集群。用于记录学习过程,中间一些步骤未做详细的描述,见谅。

所需系统

LINUX CENTOS7

(因为公司的生产环境不大可能会用windows装hadoop,本文仅探讨linux场景)

所需软件

Linux和Windows所需软件包括:

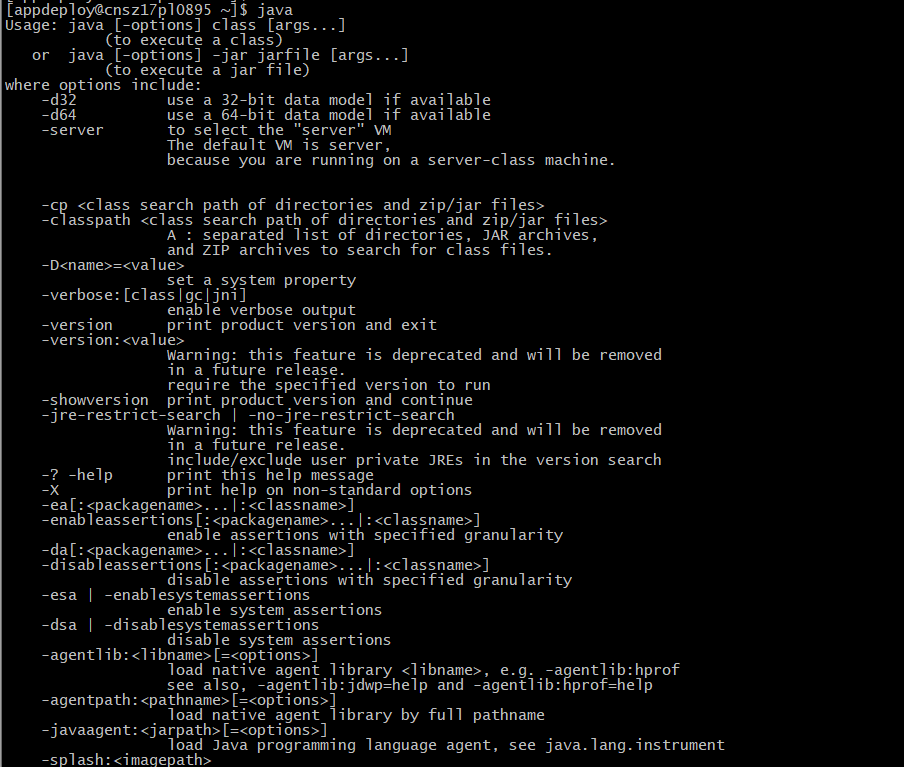

- JavaTM1.5.x,必须安装,建议选择Sun公司发行的Java版本。

- ssh 必须安装并且保证 sshd一直运行,以便用Hadoop 脚本管理远端Hadoop守护进程。

安装包

可以去官网hadoop.apache.org/下载,但是经常打不开或者速度很慢,可以用https://mirrors.aliyun.com/apache/hadoop/ 阿里的源,速度还是很稳的。

可以用wget下载下来。

集群规划

hadoop集群支持三种模式:

- 单机模式

- 伪分布式模式

- 完全分布式模式

如果是三台虚拟机,可以这么规划:

192.168.1.1 namenode,resourcemanager

192.168.1.2 datanode,nodemanager

192.168.1.3 datanode,nodemanager

准备工作

每台机器都要确认的步骤:

1、确认java安装好了

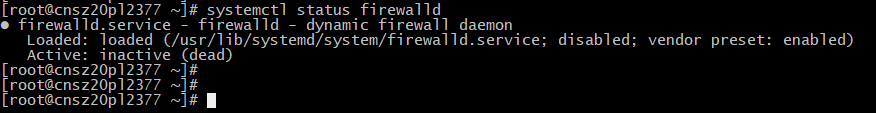

2、关闭防火墙

如centos7版本,

输入如下命令: systemctl stop firewalld

再检查一下防火墙状态: systemctl status firewalld

3、解压包

tar -zxvf xxx

4、配置--2.7.3版本为例

1)配置core-site.xml

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://192.168.1.1:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/app2/hadoop-2.7.3/tmp</value>

</property>

</configuration>

指定一台namenode和tmp目录

2)配置hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>//节点数

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/app2/hadoop-2.7.3/data/datanode</value>

</property>

</configuration>

配置副本数和hdfs文件的存储路径

对namenode+datanode的操作:

192.168.1.1

hadoop-daemon.sh start namenode

hadoop-daemon.sh start datanode

对datanode操作:

hadoop-daemon.sh start datanode

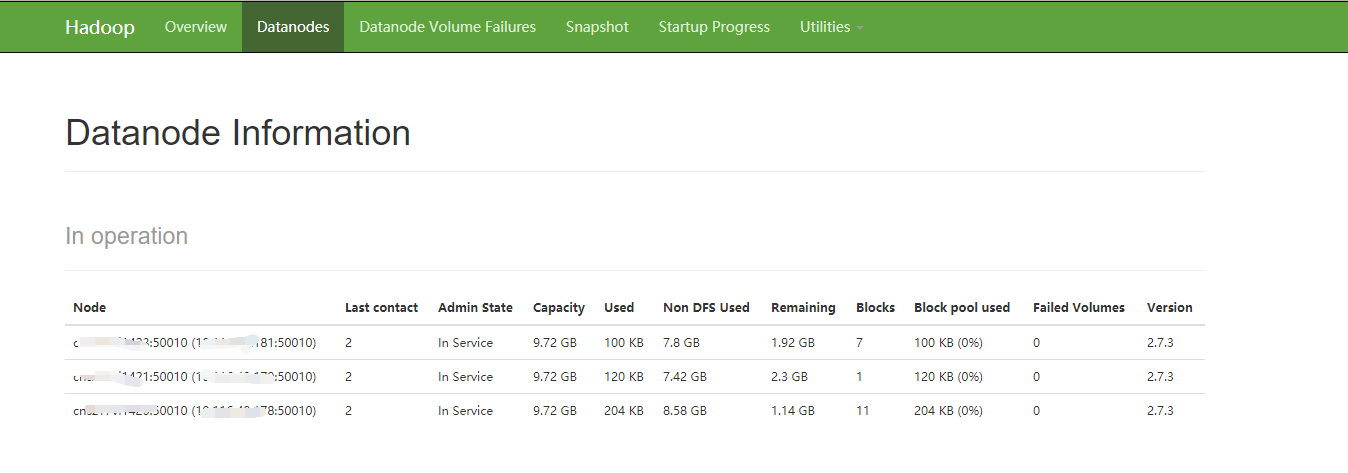

搞定,去地址看 namenodeip:50070 查看:

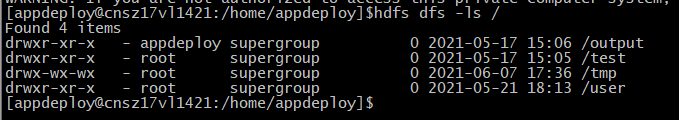

hdfs命令查看文件:

没问题,hdfs集群搭建成功。yarn的搭建过程下一篇再记录。

浙公网安备 33010602011771号

浙公网安备 33010602011771号