从零构建能自我优化的AI Agent:Reflection和Reflexion机制对比详解与实现

AI能否像人类一样从错误中学习?反思型Agent系统不仅能生成回答,还会主动审视自己的输出,找出问题并持续改进。

反思策略本质上就是让LLM对自己的行为进行自我批评。有时反思器还会调用外部工具或检索系统来提升批评的准确性。这样一来系统输出的就不再是一次性的回答,而是经过多轮生成-审阅循环优化后的结果。

目前主流的反思系统主要分为三类:

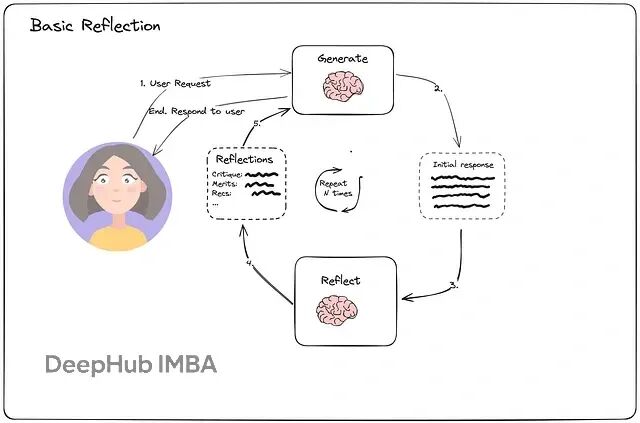

基础Reflection Agent比较轻量,就是简单的生成器加反思器循环。生成器负责起草、反思器负责批评,然后生成器根据反馈进行修订。这种方式在很多编辑类任务中效果不错。

Reflexion Agent更加结构化,会在可追踪的日志中记录历史行为、假设和反思内容。特别适合那些需要从多次失败中汲取经验的问题求解场景。

语言Agent树搜索(LATS)采用搜索策略探索多条行动路径,对结果进行反思,然后裁剪或保留有前景的分支。在规划和多步推理任务中表现最佳。

本文重点讨论前两种:Reflection和Reflexion,并用LangChain与LangGraph来实现完整的工作流程。

基础Reflection Agent的工作原理

Reflection Agent的核心在于两个角色之间的互动:

生成器负责起草初始回答,反思器则审查这个草稿,指出缺陷并提出改进建议。

这种循环会进行几轮,每一轮都让输出变得更加精炼和可靠。AI实际上在实时学习自己的错误,就像作家根据编辑意见反复修改稿件一样。

接下来用LangGraph构建一个LinkedIn帖子生成的Reflection Agent。LangGraph专门用于创建自我改进的AI系统,能够模拟人类的反思思维过程——Agent不会止步于第一稿,而是持续打磨直到内容足够优秀。

这个演示会展示如何设置生成器和反思器角色,使用LangChain进行结构化提示,并通过LangGraph将所有组件编织成一个迭代反馈循环。

https://avoid.overfit.cn/post/5f95082922614ac48cbfd84c0646199e

浙公网安备 33010602011771号

浙公网安备 33010602011771号