提升长序列建模效率:Mamba+交叉注意力架构完整指南

本文将深入分析Mamba架构中交叉注意力机制的集成方法与技术实现。Mamba作为一种基于选择性状态空间模型的新型序列建模架构,在长序列处理方面展现出显著的计算效率优势。通过引入交叉注意力机制,Mamba能够有效处理多模态信息融合和条件生成任务。本文从理论基础、技术实现、性能分析和应用场景等维度,全面阐述了这一混合架构的技术特点和发展前景。

序列建模领域的发展历程中,注意力机制的出现标志着对长距离依赖关系处理能力的重大突破。Transformer架构凭借其自注意力机制在自然语言处理领域取得了革命性进展,但其二次方时间复杂度在处理超长序列时面临显著的计算和内存瓶颈。近年来,研究者们开始探索替代方案,其中Mamba架构作为一种基于选择性状态空间模型的新型序列建模方法,在保持线性时间复杂度的同时实现了对长序列的高效处理。

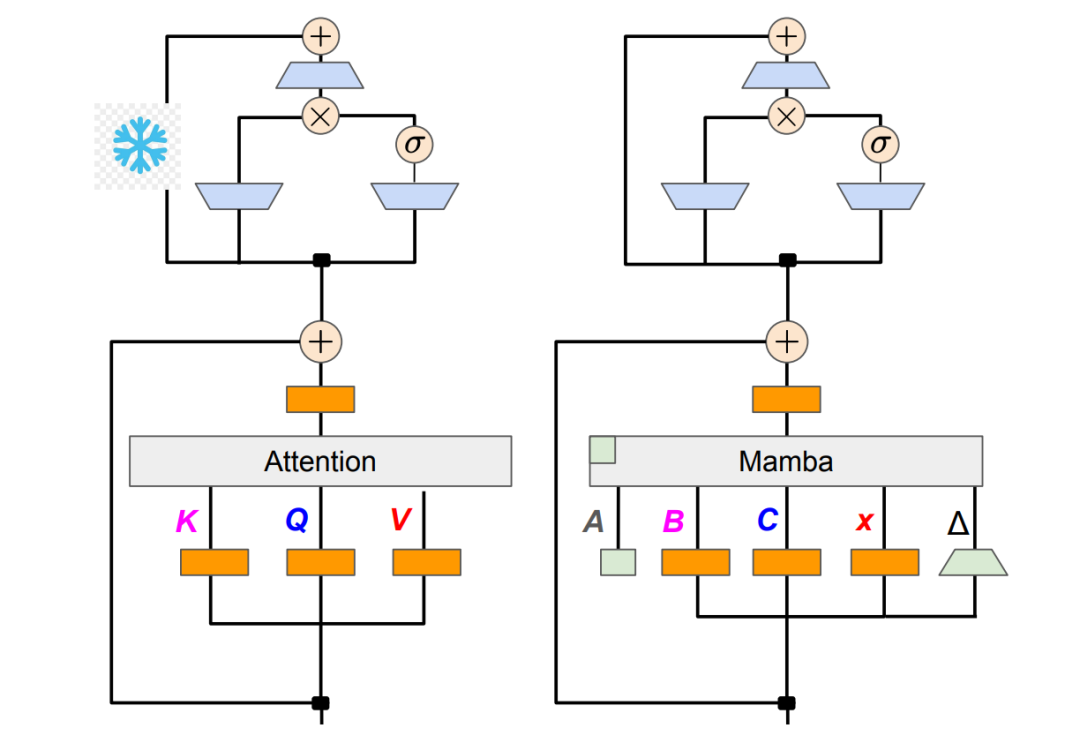

然而原始的Mamba架构在多模态信息融合和条件生成任务中存在局限性,缺乏直接建模不同序列间交互关系的能力。为了克服这一限制,研究者们提出了在Mamba架构中集成交叉注意力机制的方法。这种混合架构结合了Mamba在长序列建模方面的效率优势和交叉注意力在跨序列信息整合方面的能力,为多模态应用和复杂条件生成任务提供了新的技术路径。

https://avoid.overfit.cn/post/b6f815f33eca4425ad0adb5ad047fb77

浙公网安备 33010602011771号

浙公网安备 33010602011771号