为什么混合专家模型(MoE)如此高效:从架构原理到技术实现全解析

在人工智能技术快速演进的背景下,大型语言模型的架构设计始终围绕仅解码器(decoder-only)的Transformer结构展开。自第一个GPT模型发布以来,该架构已成为主流设计范式。尽管研究人员在效率优化方面进行了诸多改进,但核心架构结构保持相对稳定。

近期大型语言模型的发展呈现出一个重要的架构演进趋势:混合专家(Mixture-of-Experts, MoE)架构在基础模型中的广泛应用。这一变化的根本驱动力在于MoE架构能够在模型质量与推理效率之间实现优于传统密集模型的性能平衡。

基于MoE架构的大型语言模型具有稀疏性特征,即模型的各个组件并非同时处于激活状态。这种设计允许模型扩展至数千亿参数规模,而在推理过程中仅激活部分参数子集。Grok和DeepSeek-v3等最新模型均采用了这一技术路径。

本文将深入分析MoE架构的技术原理,探讨其在大型语言模型中被视为未来发展方向的原因,并详细介绍该架构在当前主要模型中的具体应用实现。

MoE架构技术原理:与Transformer的差异化设计

在标准的仅解码器Transformer架构中,每个token均通过单一的前馈神经网络(FFN)进行处理。该网络通常包含两个线性层,中间插入非线性激活函数。所有token都经由同一网络进行顺序处理。

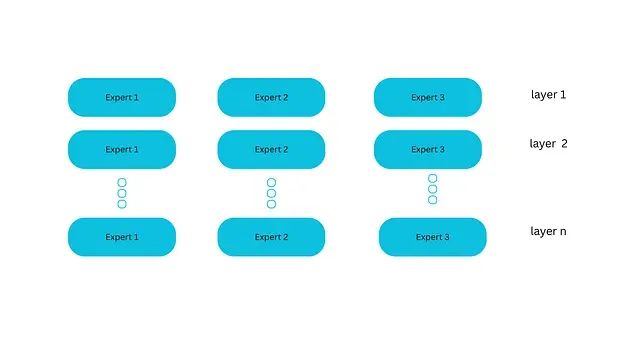

MoE系统对这一处理流程进行了关键性修改。在前馈模块内部,系统部署多个独立的网络单元而非单一网络。每个网络单元维护独立的权重参数,被称为"专家"。例如一个MoE层可能包含八个前馈网络,即八个专家单元。

这种设计类似于专业顾问团队,每个顾问具备特定的专业技能。MoE架构的两个核心组件包括专家网络(Experts)和路由机制(Router)。专家网络是指每个FFN层现在包含一组可选择的专家单元,这些专家通常本身就是FFN结构。路由器或门控网络(gate network)负责决策哪些token分配给哪些专家处理。

https://avoid.overfit.cn/post/0ff0fcf6d65c42cfb0fa430a845553be

浙公网安备 33010602011771号

浙公网安备 33010602011771号