NoProp:无需反向传播,基于去噪原理的非全局梯度传播神经网络训练,可大幅降低内存消耗

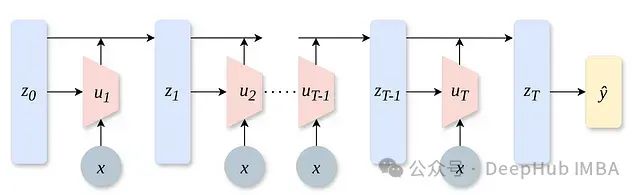

反向传播算法自四十年前问世以来一直作为深度学习的基石,然而仍然面临两项关键技术挑战:首先由于必须存储中间激活值用于梯度计算,导致内存消耗显著;其次其本质上的顺序计算特性严重限制了模型在分布式多GPU环境下的并行扩展能力。近期牛津大学、Mila研究所与Google DeepMind的研究团队联合提出了一种名为NoProp的创新方法。该研究成果表明,图像分类模型的训练可以完全不依赖任何形式的全局前向或反向传播过程。NoProp的核心技术基于扩散模型的概念,通过训练网络的每一层对注入噪声的目标标签实施去噪操作,从而彻底重新构想了深度学习的基础训练范式。

https://avoid.overfit.cn/post/f9e17c1e163b461f84946c1e8ca88fa4

浙公网安备 33010602011771号

浙公网安备 33010602011771号