PHATGOOSE:使用LoRA Experts创建低成本混合专家模型实现零样本泛化

这篇2月的新论文介绍了Post-Hoc Adaptive Tokenwise Gating Over an Ocean of Specialized Experts (PHATGOOSE),这是一种通过利用一组专门的PEFT模块(如LoRA)实现零样本泛化的新方法

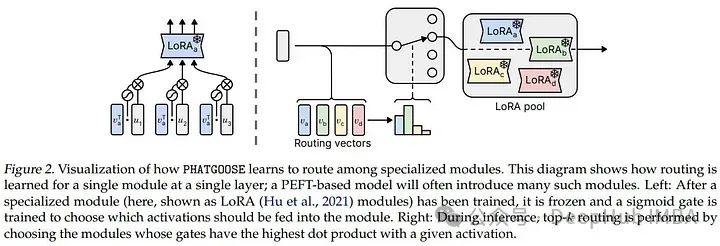

这个方法冻结整个模型,包括PEFT模块,并为每个模块训练一个类似于混合专家(MoE)模型中使用的路由(门控)网络。我们可以将此方法视为创建MoE模型的一种廉价方法,因为每个专家都只是一个LoRA的adapter。

这种门控网络训练的计算量非常小,并且通过在推理期间使用top-k路由策略进行令牌分发,提高了模型处理未显式训练的任务的能力。

PHATGOOSE的有效性在t5系列模型上进行了测试,与之前专家或依赖单个PEFT模块的方法相比,在标准基准上的零样本泛化方面表现优异。有时它的表现也优于明确目标的多任务训练。

https://avoid.overfit.cn/post/e099b8f39fb44497b010d8b929169ac8

浙公网安备 33010602011771号

浙公网安备 33010602011771号