本地部署大语言模型

什么是大语言模型

LLM是 AI 的一个具体应用,专注于自然语言处理。

AI:是一门综合性的学科和技术领域,旨在让机器能够模拟人类的智能行为,包括学习、推理、解决问题、理解语言、识别图像、规划决策等多个方面。AI 涵盖了众多的技术和研究方向,如机器学习、深度学习、计算机视觉、自然语言处理、机器人技术等。它的目标是使计算机系统具备类似人类的智能,能够自主地感知环境、处理信息并做出合理的决策和行动。

LLM:属于 AI 中自然语言处理领域的一个分支,是一种基于深度学习的语言模型,主要专注于处理和生成自然语言文本。LLM 通过学习大量的文本数据,能够理解语言的语义、语法和上下文信息,从而生成连贯、有逻辑的文本内容,如回答问题、生成文章、对话等。

Ollama

Ollama是一个工具,旨在让大语言模型的部署变得简单直接。它支持在本地运行多种开源的大语言模型,并通过命令行或 API 方便地调用它们。一般来说,本地部署大语言模型的效果是没有官方的API好的,但是可以保证敏感数据在本地处理,不泄露至第三方。

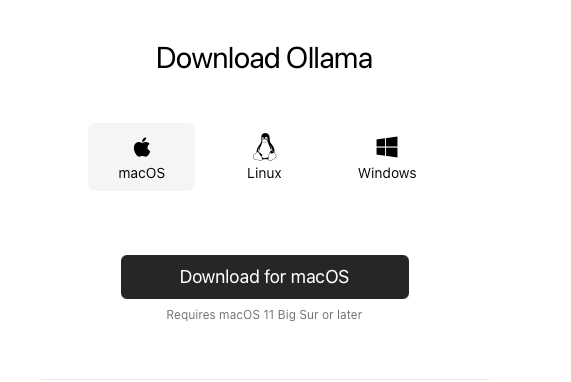

下载Ollama

在官网可以直接下载对应的 Ollama,这里我选mac因为我的是mac

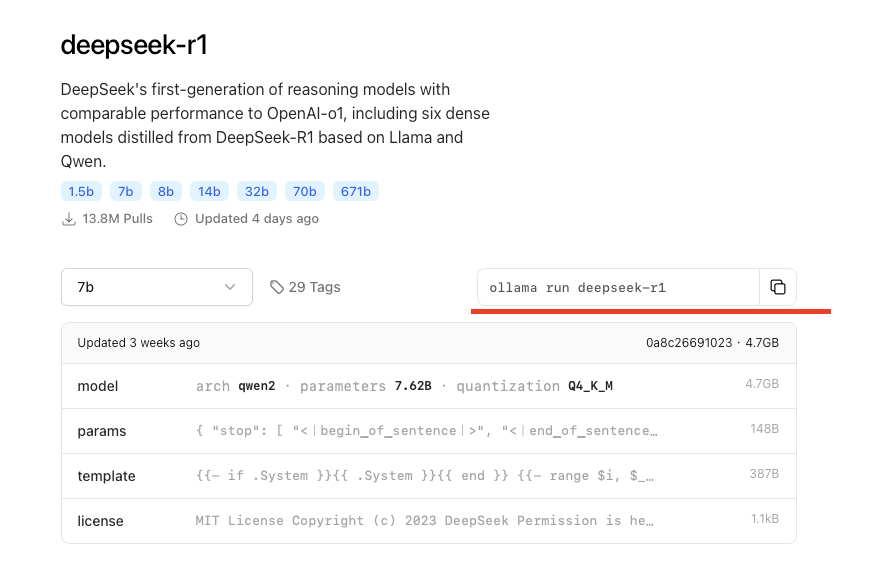

运行LLM(ollama命令行下载LLM)

ollama有方便的命令行可以让我们直接下载LLM然后加载,复制对应的命令行,执行就会运行对应的大语言模型,如果没有的话就会自己下载。(如果下载太慢可以中断中断control+c,然后再执行命令行下载LLM)

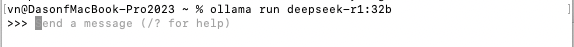

如:ollama run deepseek-r1:32b

加载LLM(ollama加载现有LLM)

ollama下载LLM步骤很简单,但问题是下载太慢😭,所以我们有第二种加载方法。

-

下载LLM(GGUF格式)

魔搭社区是一个提供模型库下载的社区,在这里下载模型可以有比较快的速度。

![image]()

-

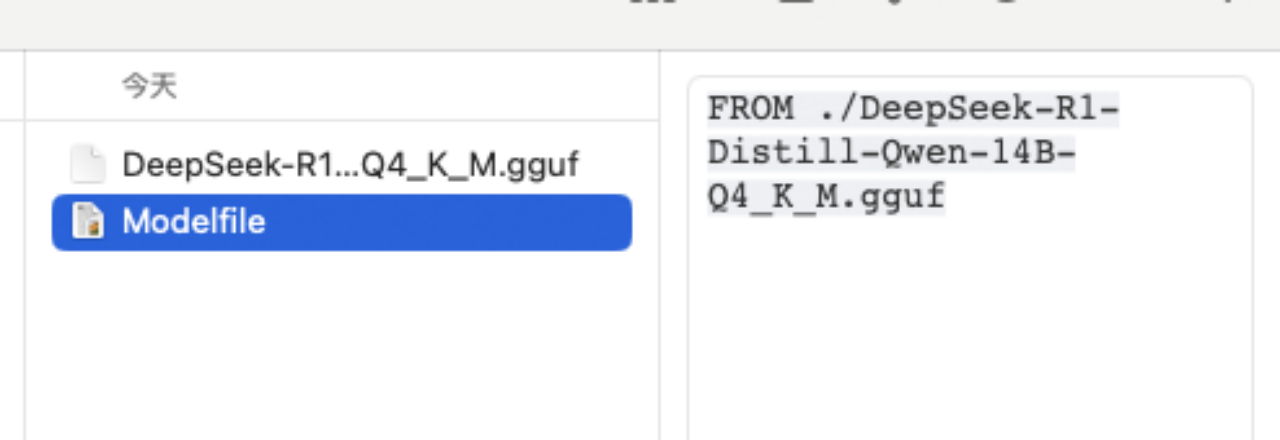

Ollama导入LLM

在下载好的模型文件夹内创建一个“Modelfile”文件,文件内容是“From ./文件名.后缀”。然后终端在目录内执行命令行ollama create 自定义模型名称 -f Modelfile

![image]()

-

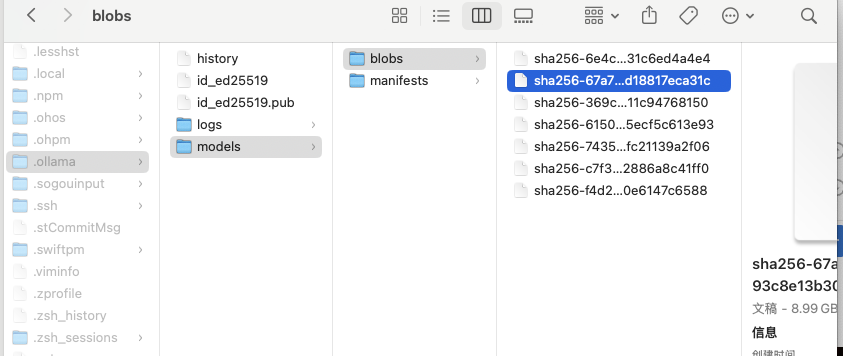

运行LLM

如果已经装载好了本地LLM,就会在~/.ollama/models 目录下,这个时候本地的LLM也可以删除了。(毕竟占位置😂)![image]()

然后就是在终端跑模型了,可以直接开始聊天了

ollama run 自定义模型名称![image]()

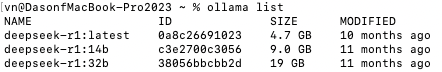

查找所有LLM可以使用命令

ollama list

![截屏2026-01-07 下午3.48.10]()

退出的话可以使用

/bye

![截屏2026-01-07 下午3.47.43]()

浙公网安备 33010602011771号

浙公网安备 33010602011771号