2.安装Spark与Python练习

一、安装Spark

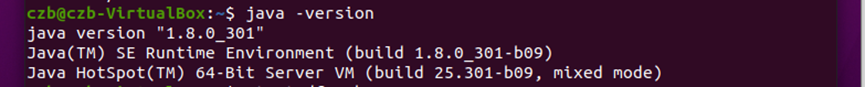

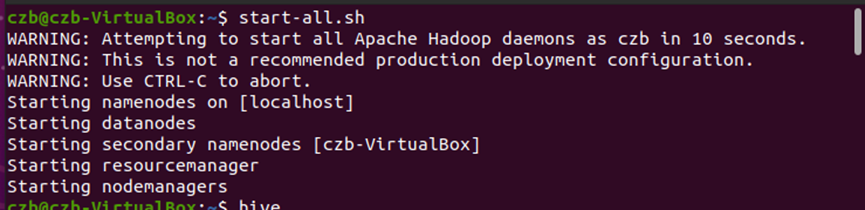

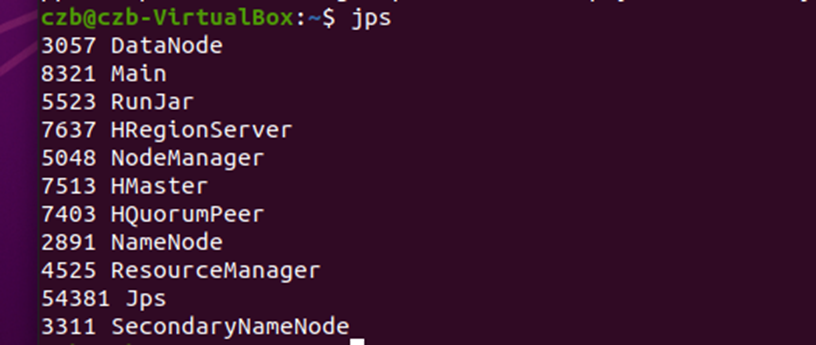

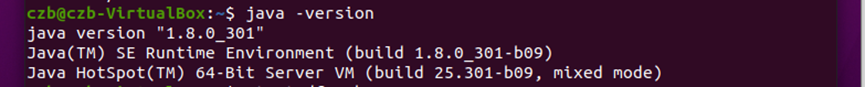

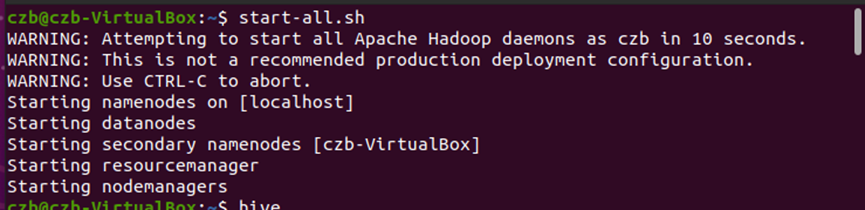

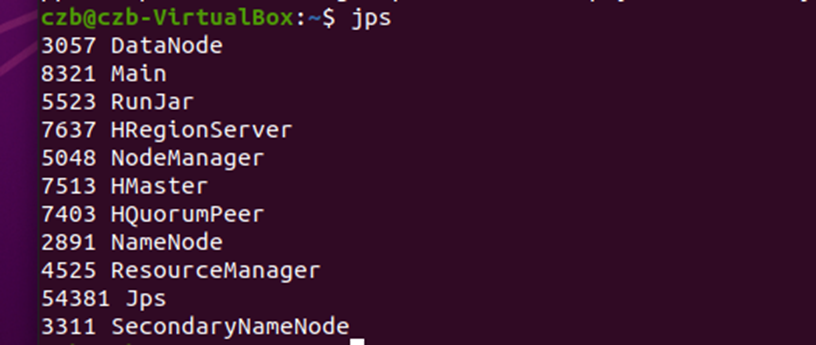

1.检查基础环境hadoop和jdk。

2.以前下载过spark,所以第二、三步直接跳过。

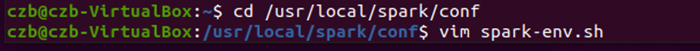

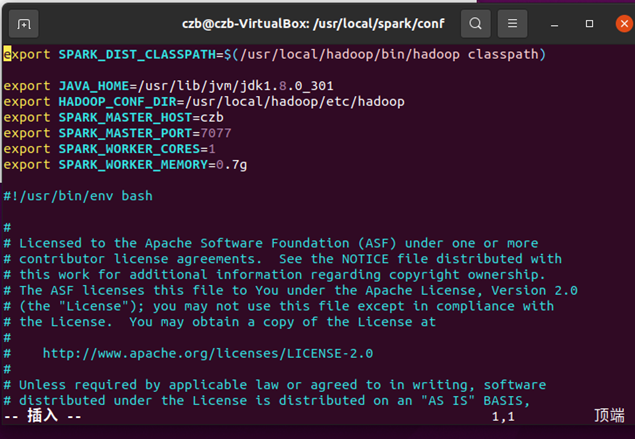

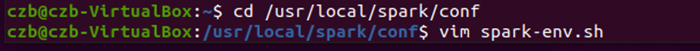

3.接下来配置文件。

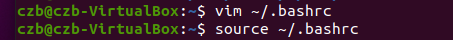

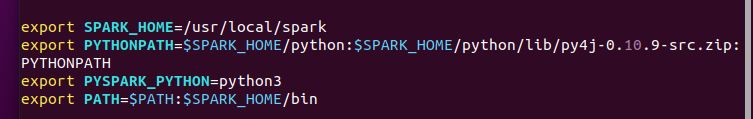

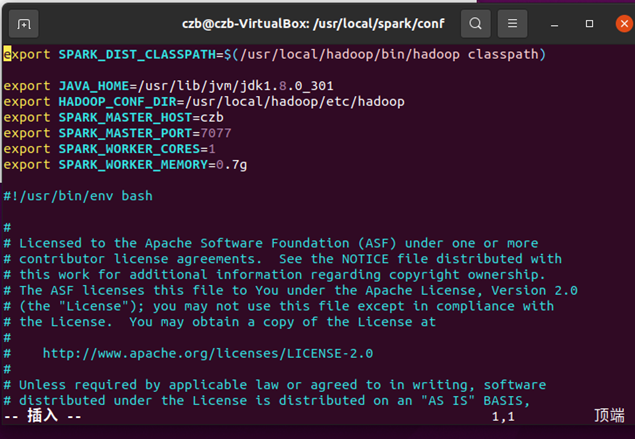

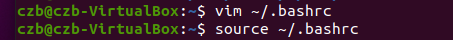

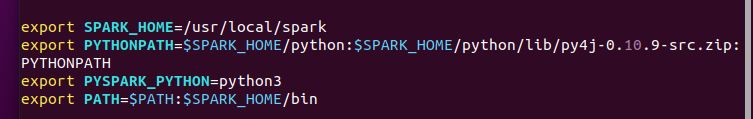

4.环境变量

使用vim ~/.bashrc进行配置,然后使用source ~/.bashrc生效。

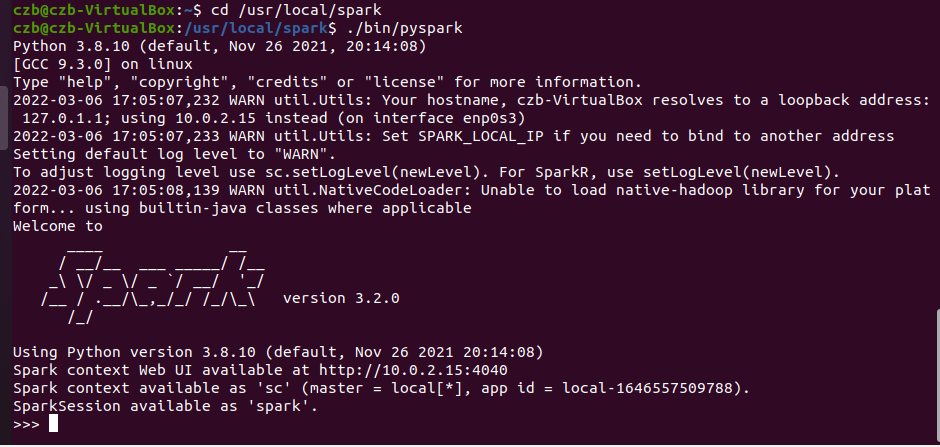

5.试运行Python代码。

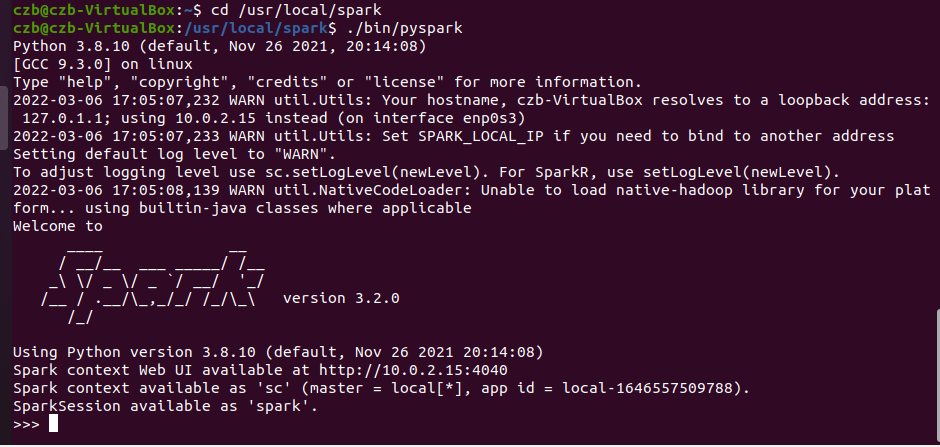

(1)执行以下命令启动pyspark.

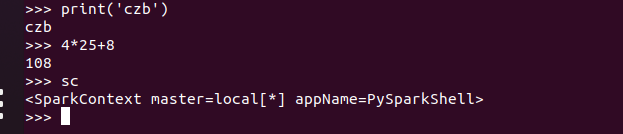

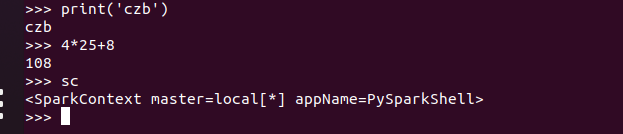

(2)运行python代码

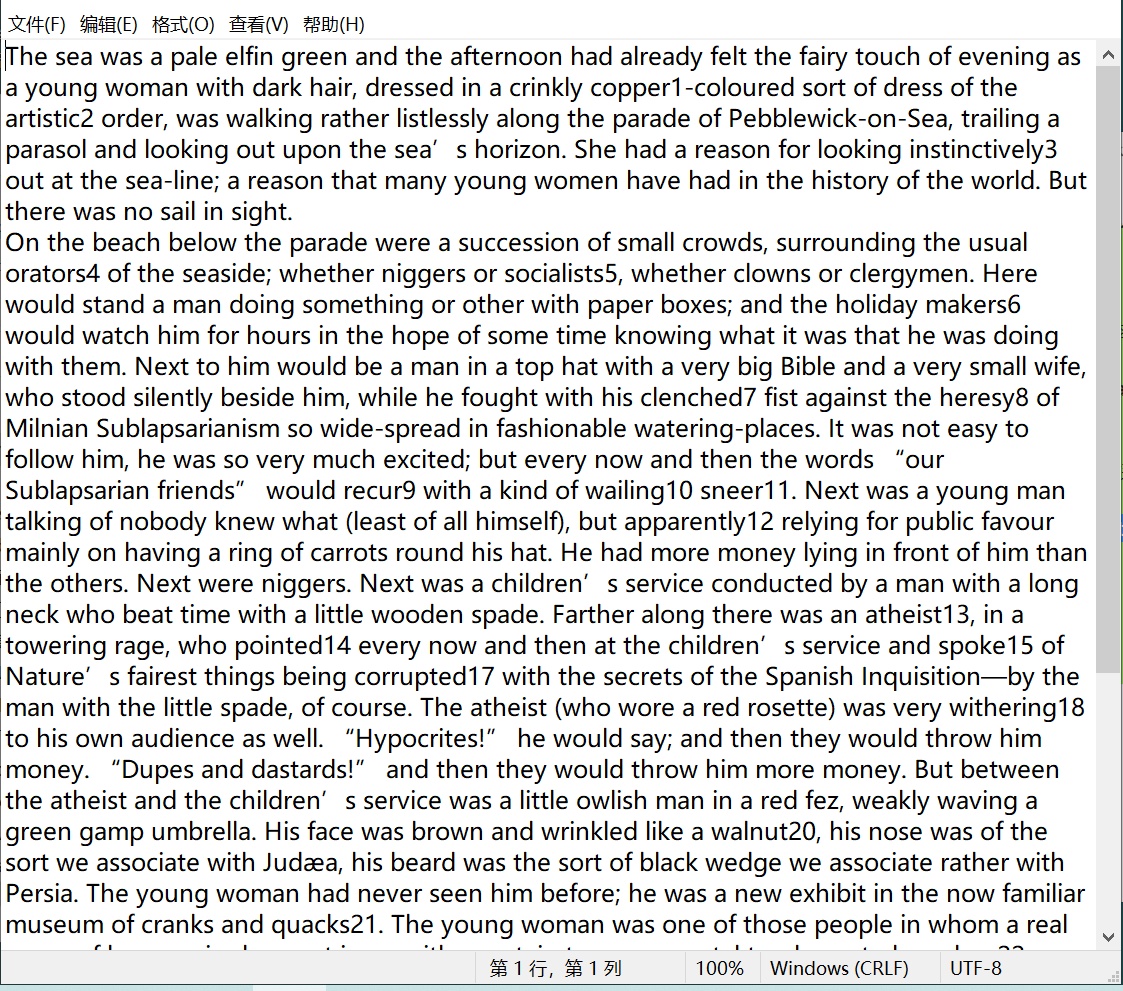

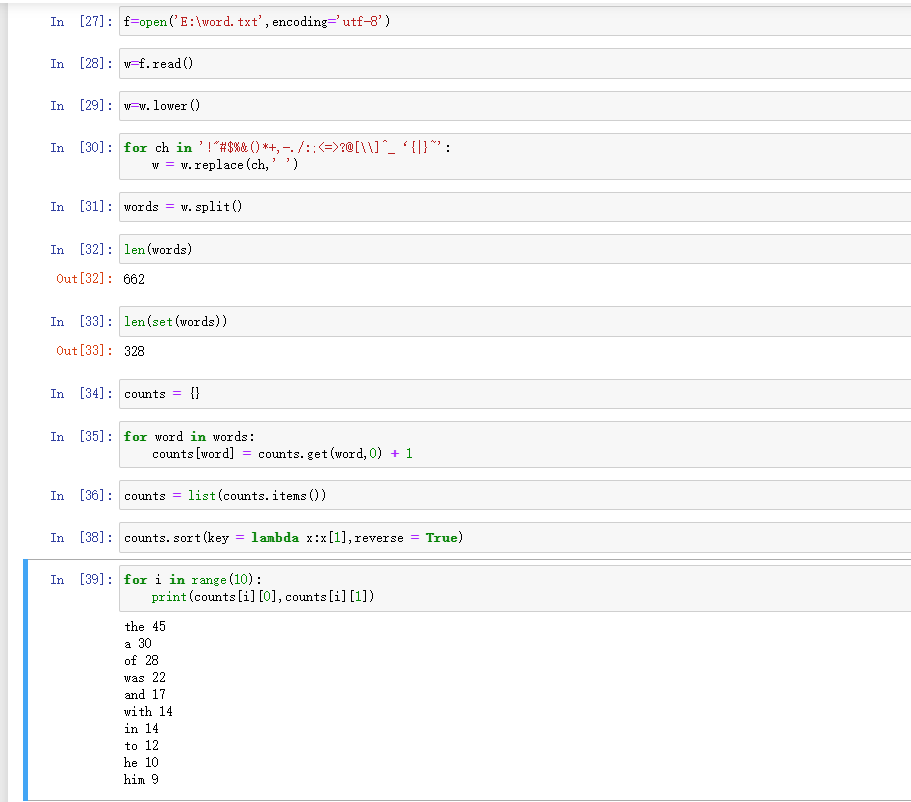

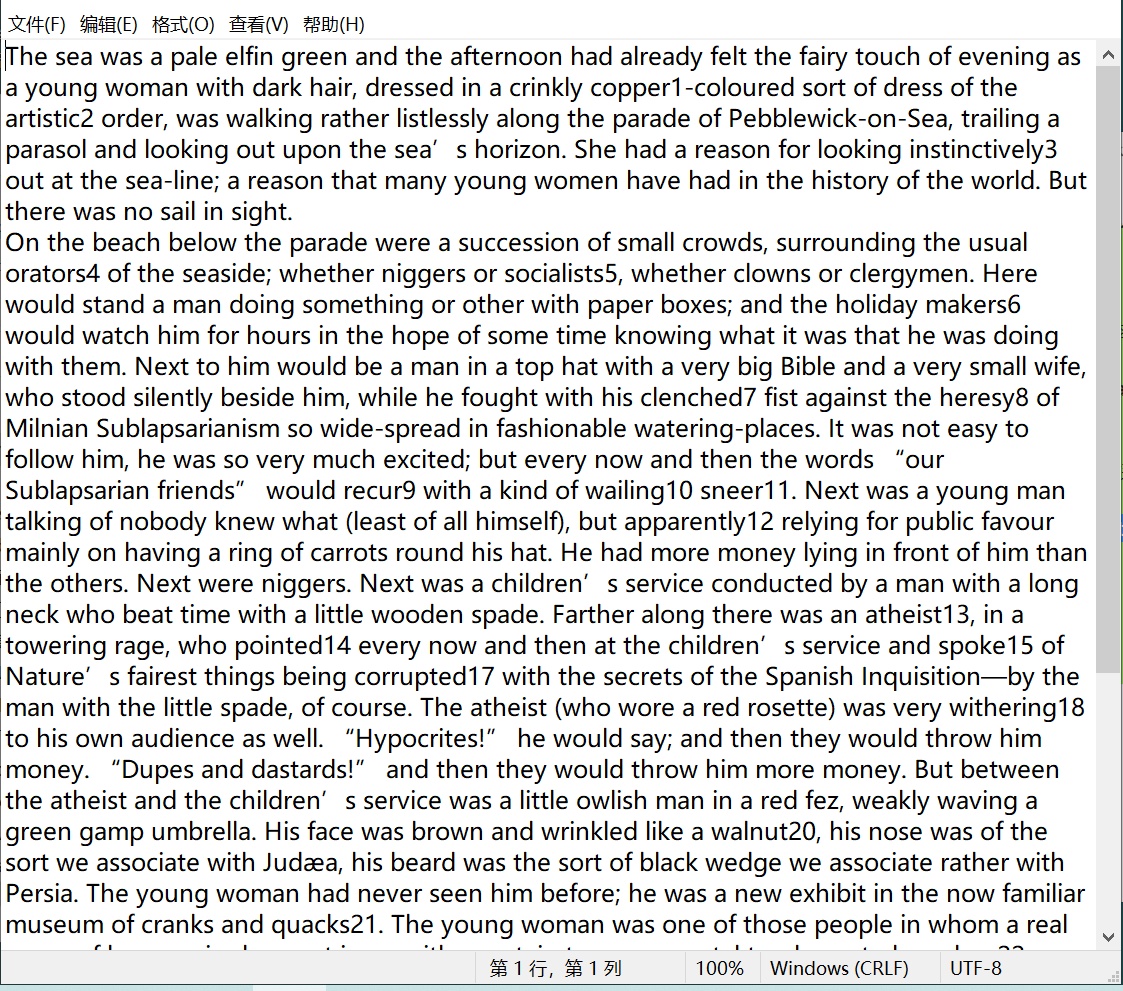

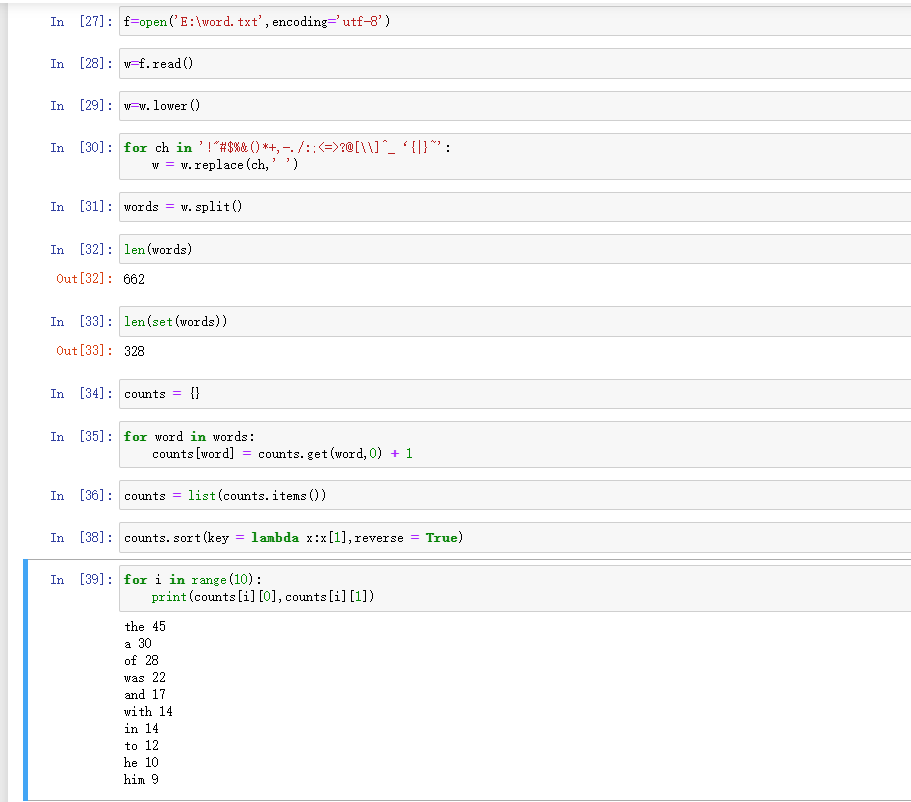

二、Python编程练习:英文文本的词频统计。

一、安装Spark

1.检查基础环境hadoop和jdk。

2.以前下载过spark,所以第二、三步直接跳过。

3.接下来配置文件。

4.环境变量

使用vim ~/.bashrc进行配置,然后使用source ~/.bashrc生效。

5.试运行Python代码。

(1)执行以下命令启动pyspark.

(2)运行python代码

二、Python编程练习:英文文本的词频统计。