希音面试:频繁 fullgc,如何排查?(图解+秒懂+史上最全)

本文 的 原文 地址

原始的内容,请参考 本文 的 原文 地址

尼恩说在前面

在40岁老架构师 尼恩的读者交流群(50+)中,最近有小伙伴拿到了一线互联网企业如得物、阿里、滴滴、极兔、有赞、希音、百度、网易、美团的面试资格,遇到很多很重要的面试题:

- 频繁 fullgc,如何排查?

最近有小伙伴在面试 希音,又遇到了相关的面试题。

小伙伴 没系统梳理, 支支吾吾的说了几句,面试官不满意, 挂了。

其中第一道题目的答案是:

希音面试:ClickHouse Group By 执行流程 ?CK 能支持 十亿级数据 实时分析的原理 是什么?

其中第2道题目的答案是:

希音面试:es延时如何解决?在mysql+ canal同步 es建索引场景,这个延时如何解决?

这篇文章,帮助小伙伴回答 第3题。

所以,尼恩给大家做一下系统化、体系化的梳理,使得大家内力猛增,可以充分展示一下大家雄厚的 “技术肌肉”,让面试官爱到 “不能自已、口水直流”,然后实现”offer直提”。

当然,这道面试题,以及参考答案, 会收入咱们的 《尼恩Java面试宝典PDF》V175版本,供后面的小伙伴参考 ,帮助大家进大厂/做架构。

架构师视角的 FullGC 治理思维

频繁 FullGC 不仅仅是 “JVM 问题”,而是 “架构不合理” 的外在表现。

作为技术高手,需要高维度看问题,具备以下高维度思考 能力:

(1) 系统化思维:

不孤立看待 FullGC,而是关联 “代码→JVM→架构→业务”,从 “现象→瓶颈→根因” 分层排查;

(2) 预防大于治疗:

通过架构设计(如缓存分片、流处理)避免内存资源过载,而非依赖事后调优;

(3) 数据驱动决策

所有优化方案需基于监控数据(如 Heap Dump、接口延迟)验证效果,避免 “凭经验调参”。

频繁 FullGC 的治理目标: “建立一套可扩展的内存资源管理体系”,确保业务增长时,系统能通过架构升级(而非临时调优)应对内存压力,从根本上保障服务稳定性。

作为技术高手, 需跳出 “仅调优 JVM 参数” 的局限,从底层原理→外部观测→ 四步定位→ e2e 解决方案 形成闭环。

根因分析包括: 底层原理→外部观测→ 四步定位

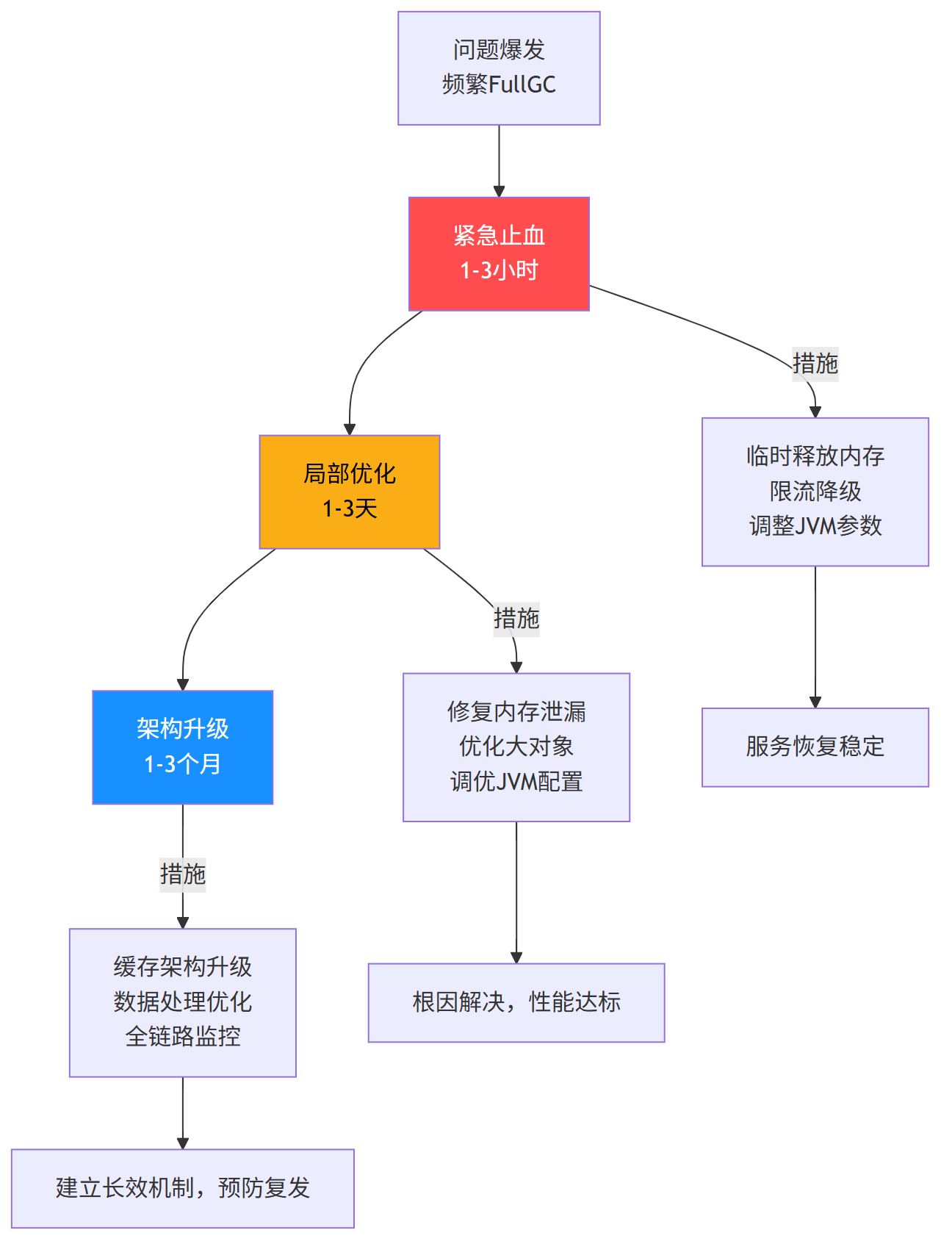

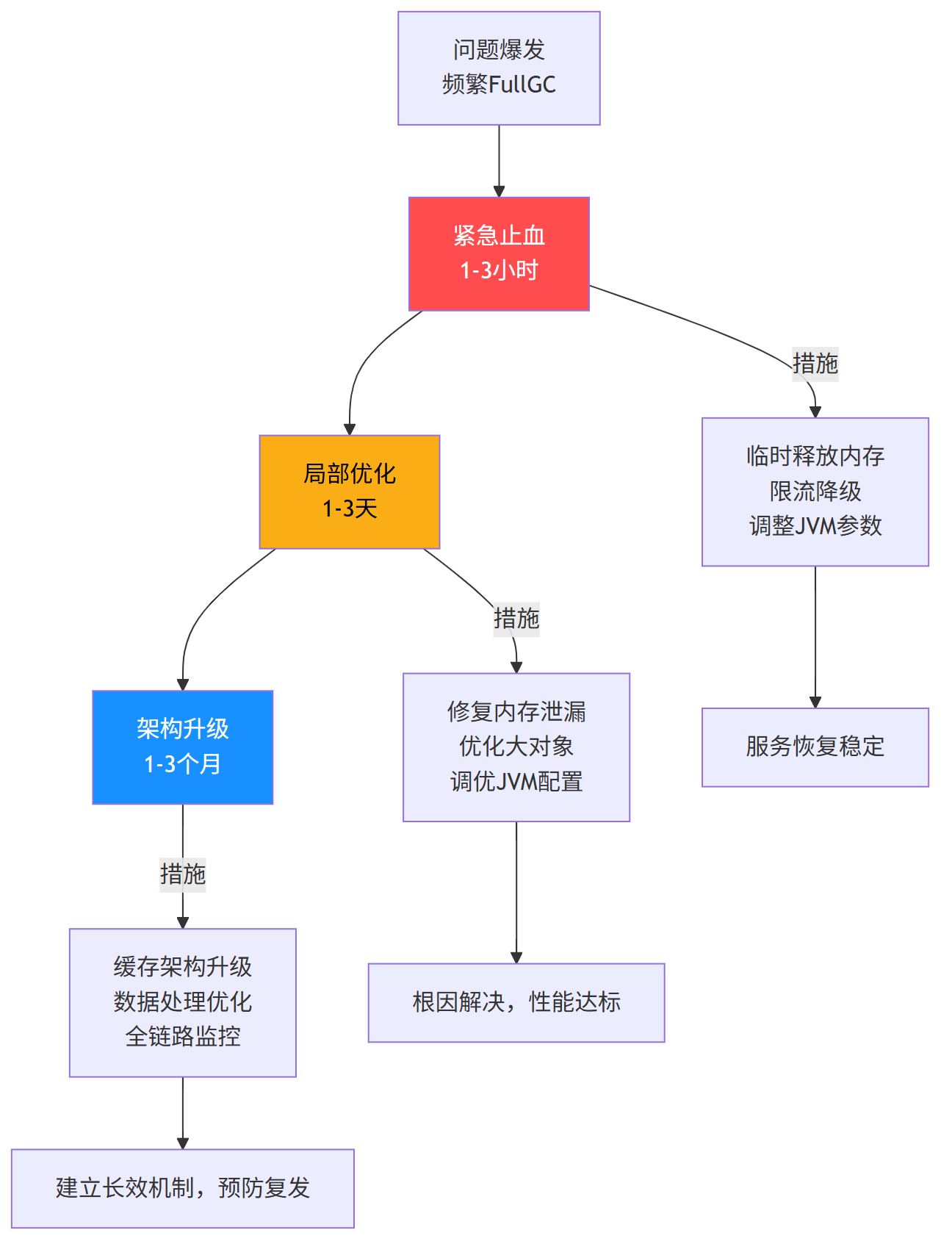

e2e 解决方案:从 “紧急止血” 到 “架构优化” , 核心路径 包括 “紧急止血(1-3小时) →局部代码优化 与 JVM 优化(1-3天) → 架构升级 (1-3个月)” 三个大步骤,确保问题彻底解决。

温馨提示: 尼恩的方案, 帮助很多小伙伴 进 大厂,逆天改命。

这个方案也是一个能逆天改命的方案,大家 收藏起来 看他10遍20遍,毒打面试官。

一、底层原理:理解 FullGC 的触发机制与危害

在解决问题前,必须先明确 FullGC 的核心逻辑 :

FullGC 是 JVM 老年代(Old Gen)或元空间(Metaspace)内存不足时,由垃圾收集器(如 G1、CMS、Serial Old)执行的 “全量垃圾回收”。

FullGC 特点是STW(Stop-The-World)时间长、资源消耗高,频繁触发会直接导致系统吞吐量下降、响应延迟飙升,甚至引发服务雪崩。

1.1 核心触发条件(底层逻辑)

FullGC 并非 “随机发生”,而是 JVM 内存管理机制的必然结果,关键触发条件可归纳为以下 4 类:

| 触发场景 | 底层原因 | 典型案例 |

|---|---|---|

| 老年代内存不足 | 新生代对象晋升老年代(如大对象直接进入老年代、Survivor 区对象年龄达标),老年代剩余空间无法容纳 | 批量处理 100MB 以上的大文件、缓存未及时清理 |

| 元空间(Metaspace)溢出 | 类加载过多(如动态生成类、依赖包冲突导致类重复加载),元空间默认无上限(需手动配置) | Spring 动态代理生成大量代理类、Groovy 脚本频繁编译 |

| 显式调用 System.gc () | 代码中手动触发 FullGC(JVM 可能忽略,但部分场景会强制执行) | 错误的 “内存优化” 代码、第三方框架隐式调用 |

| GC 算法特殊逻辑 | 如 CMS 收集器的 “Concurrent Mode Failure”(并发回收时老年代满)、G1 的 “Humongous Allocation Failure”(大对象无法分配) | 高并发下大对象突发写入、G1 Region 划分不合理 |

1.2 频繁 FullGC 的危害(技术高手 视角)

频繁 FullGC 是 “系统 可能雪崩” 的核心信号,其危害远超 “性能慢”:

危害1:服务可用性骤降:

每次 FullGC 会导致 STW(即使 G1 可控制在百毫秒级,频繁触发仍会累积延迟),秒杀、支付等核心场景会出现 “请求超时”;

所有GC算法在Full GC阶段都会发生Stop-The-World (STW),即所有业务线程被挂起,全力进行垃圾回收。

对于高并发、低延迟的核心场景(如秒杀、支付、交易),即使G1/ZGC已将STW控制在百毫秒级,频繁触发(如每分钟数次)也会导致请求响应时间尖刺,大量用户请求超时,直接触发熔断,服务可用性骤降。

危害2:资源恶性循环:

FullGC 消耗 CPU / 内存资源,导致业务线程执行时间变长,对象创建速度加快,进一步加剧内存压力,形成 “FullGC 越频繁→系统越慢→内存越紧张” 的死循环;

“FullGC 越频繁→系统越慢→内存越紧张” 的死循环 如下:

-

Full GC消耗CPU:GC线程是CPU密集型任务,频繁Full GC会抢占业务线程的CPU时间片。

-

业务线程效率降低:业务线程获得CPU时间减少,执行变慢,请求堆积。

-

对象堆积加速:未能及时处理的请求会导致新对象无法释放,在堆中加速堆积。

-

内存压力剧增:对象堆积使得下一次Full GC更快到来且耗时更长。

危害3:死亡螺旋(Death Spiral)导致雪崩:

单节点频繁 FullGC 可能扩散为集群问题(如分布式缓存穿透导致各节点频繁创建对象),若不及时止血,系统 可能雪崩 。

系统陷入 “FullGC 越频繁 → 系统越慢 → 内存越紧张 → FullGC更频繁” 的死亡螺旋(Death Spiral),最终资源耗尽,进程僵死或崩溃。

二、FullGC 常见根因 分析

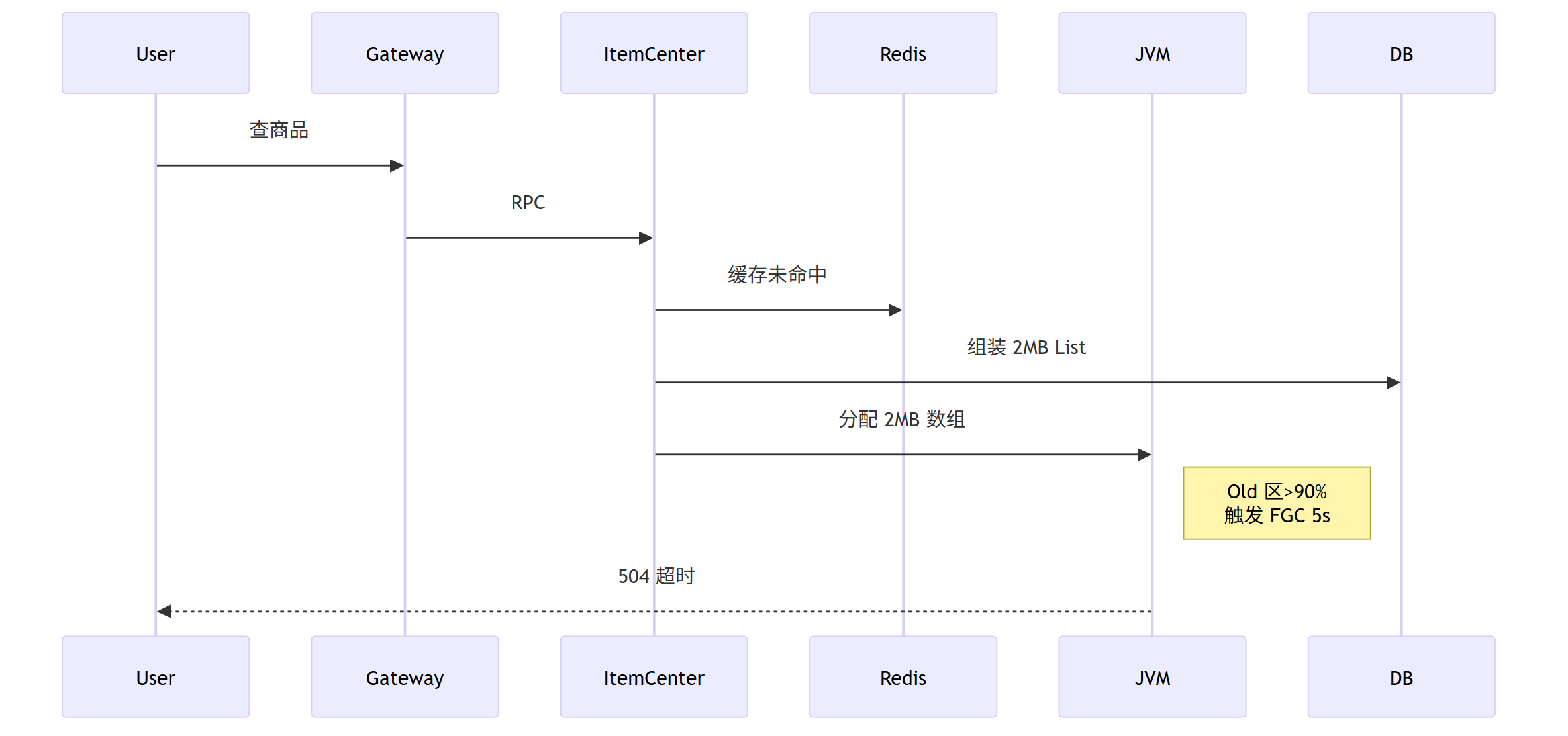

先看 一个真实的FullGC 生产案例 :

商品中心 QPS 3w → 每 30min 一次 FGC → 连续 5s 停顿

根因:

缓存未命中时DB查询 返回全字段,平均对象 2MB,每秒 3000 次 → 6GB/min 进入 Old 区

核心方案是 字段裁剪:

DB查询可以 返回 DTO 仅含前端所需 7 个字段,体积降到 80k(-96%)

FullGC 常见根因

| 根因 | 现象特征 | 架构级解法 |

|---|---|---|

| 1. 本地缓存超配 | Old 区 80% 被 CHM 本地缓存占满 | 本地缓存改用具备自动淘汰能力的 Caffeine + 外部化 Redis;bigkey分片 |

| 2. 消息膨胀 | Kafka 大消息 >512k,Old 区瞬涨 | 消息瘦身(传 ID 不传体);压缩 snappy;分块传输 |

| 3. 查询放大 | 1 次 DB查询 返回 10MB List | 分页 + 游标 + 字段裁剪 |

| 4. 滥用本地变量导致内存泄漏 | ThreadLocal 未 remove,Old 区缓慢上涨 | 可观测线程池;TransmittableThreadLocal |

| 5. 反射滥用/ASM 滥用 | LambdaMetafactory 产生大量类加载,MetaSpace 触发 FGC | 缓存 MethodHandle; |

| 6、其他 |

FullGC 常见根因 分类

| 根因分类 | 典型特征 | 排查方法 | 解决方案 |

|---|---|---|---|

| 内存泄漏 | 老年代使用率 只增不减, 直至OOM | jstat、MAT分析 查看支配树与GC Roots |

1. 修复代码bug(如无效引用) 2. 优化缓存策略(TTL、弱引用) 3. 检查框架资源未关闭(连接池等) |

| 代码BUG | 短命大对象 直接进入老年代 | jstat、GC日志 关注晋升年龄 |

1. 避免在循环中创建大对象 2. 优化集合的使用(如clear()) 3. 调整-XX:MaxTenuringThreshold |

| 缓存类应用 | 老年代被 缓存数据填满 | jstat、MAT分析 |

1. 使用堆外缓存(如Ehcache off-heap) 2. 使用分布式缓存(Redis) 3. 限制本地缓存大小(Guava Cache) |

| GC参数不当 | 堆空间配置 不合理 | 分析GC日志 | 1. 调整新生代与老年代比例(-XX:NewRatio) 2. 调整Eden与Survivor比例(-XX:SurvivorRatio) 3. G1调优:-XX:MaxGCPauseMillis、-XX:InitiatingHeapOccupancyPercent |

下面是一些 常见根因 的展开介绍

常根1:本地缓存超配

现象特征:

老年代使用率持续居高不下,通过堆转储(Heap Dump)分析,发现 ConcurrentHashMap或其包装类(如 Spring @Cacheable的默认实现)占据了近 80% 甚至更高的堆内存。

缓存中的对象多为业务实体,且无过期时间或内存淘汰策略(LRU/LFU),属于“静态”缓存,只增不减。

根因分析:

这并非经典的“内存泄漏”,而是容量规划失误。

在架构设计时,忽略了本地缓存的生命周期与 JVM 堆空间的制约关系。随着时间推移或流量增长,缓存条目无限增长,最终填满老年代。

由于缓存对象几乎总是可达的(被缓存框架的静态引用链持有),Full GC 无法回收它们,每次回收效果甚微,陷入“消耗 CPU 做无用功”的恶性循环。

架构级解法:

1、引入自动淘汰机制:立即将 ConcurrentHashMap替换为 Caffeine 或 Guava Cache,并设定合理的 maximumSize和 expireAfterAccess/expireAfterWrite策略。这是最直接的止血方案。

2、外部化缓存:这是治本之道。评估缓存数据的特性(如大小、一致性要求、访问频率)。对于大数据集或集群环境,必须将缓存外部化到 Redis 或 Memcached 等分布式缓存中间件中,从根本上解除对 JVM 堆的依赖。

3、分片与优化:如果必须使用本地缓存(追求极致性能),需对“大 key”进行分片,或仅存储对象的标识符(ID)而非完整序列化后的对象体,最大限度减少单条缓存项的体积。

常根2:消息膨胀

现象特征:

老年代使用率呈现瞬时尖峰,随后可能因 Full GC 而下降,GC 日志显示分配失败(Allocation Failure)或直接晋升(Promotion Failure)。

监控平台可发现该时间点与大量消息消费的时机吻合。消息队列(如 Kafka)监控显示消息体积巨大(远超默认的 1MB)。

根因分析:

Kafka 等消息队列的消费者客户端在反序列化消息时,会在堆上创建对象。

当单条消息体积过大(如 512KB 甚至数 MB),且消费速率较快时,极易产生短命大对象。

这些对象可能因新生代没有足够空间(-XX:PretenureSizeThreshold 参数对此类现代垃圾收集器无效)而直接分配在老年代,或者快速撑满新生代后通过担保机制提前晋升到老年代,瞬间触发 Full GC。

架构级解法:

1、消息瘦身:遵循“传引用而非传值”的原则,消息体只传递业务实体的 ID 或必要的查询条件,由消费者自行按需去查询数据库或服务,从而极大压缩消息体积。

2、启用压缩:在消息中间件(Kafka)的生产者和消费者端启用 Snappy 或 LZ4 等高效压缩算法,用 CPU 资源换取网络带宽和内存空间的节省,这是一种经典的权衡(Trade-Off)。

3、分块传输:对于必须传输的大内容(如文件、图片),应采用分块上传/下载的机制,而非通过消息队列一次传递。

常根3: DB查询放大

现象特征:

在触发数据库查询操作后(如导出报表、全量查询),老年代内存使用率呈现陡峭上升曲线,随后触发 Full GC。数据库监控显示当时有慢查询,网络流量激增。

堆转储中可能发现巨大的 ArrayList或 HashMap,其中填充了完整的数据库查询结果集。

根因分析:

这是典型的应用层与数据层契约缺失问题。

DAO 层(如 MyBatis、JPA)的某个查询方法,在没有分页限制的情况下,一次性从数据库拉取数万甚至数十万条记录。

整个结果集被完整映射为 Java 对象列表(如 List<User>),并在一个事务生命周期内被保留在内存中。这个庞大的中间结果集会迅速撑爆堆内存。

架构级解法:

1、强制分页:从架构上规定,所有列表查询接口必须强制接受分页参数(pageNum, pageSize)。这应作为一项编码规范和技术评审的准入门槛。

2、游标查询:对于必须处理大量数据的批处理或导出任务,应使用数据库游标(如 MyBatis 的 Cursor)进行流式处理,每次只从数据库获取并映射少量数据,逐步处理,避免一次性加载全部数据到内存。

3、字段裁剪:遵循“按需所取”原则,查询语句使用明确的字段列表(SELECT id, name FROM ...),避免 SELECT *,减少单条记录的内存占用,从而降低整个结果集的内存总量。

常根4. 滥用本地变量导致内存泄漏

现象特征:

老年代内存使用率呈现缓慢但稳定上升的趋势,即使在没有流量的情况下,内存也“只增不减”。

通过堆转储分析,发现大量 ThreadLocal对象或由线程池工作线程引用的对象无法被回收。

根因分析:

根本原因在于线程池与 ThreadLocal的生命周期错配。

Web 应用通常使用线程池处理请求。当在一个请求中将数据存入 ThreadLocal后未能及时 remove(),该对象就会一直被工作线程(Thread)实例强引用。

由于线程池中的线程是会复用的,几乎不会销毁,导致这个 ThreadLocal条目及其关联的值对象(如用户会话信息、数据库连接)会在整个线程的生命周期内无法被回收,造成实质上的内存泄漏。

架构级解法:

1、规范使用:建立编码规范,要求使用 ThreadLocal必须配套 try-finally块进行清理,确保 remove()操作一定会执行。

try {

userContextHolder.set(userInfo);

// ... 业务逻辑

} finally {

userContextHolder.remove(); // 必须清理

}

2、使用 TransmittableThreadLocal:对于需要在线程池异步场景中传递上下文的复杂情况,采用阿里开源的 TransmittableThreadLocal (TTL),它提供了更好的生命周期管理能力。

3、可观测性与防御性编程:通过 APM 工具监控线程池的各项指标,并考虑为关键的 ThreadLocal上下文包装一层软引用(SoftReference)或弱引用(WeakReference)作为最后的防御措施,但这不能替代规范的 remove()操作。

常根5. 反射滥用/ASM 滥用

现象特征:

Full GC 的触发原因并非“Java Heap Space”,而是 Metaspace(元空间)溢出。

监控曲线显示 Metaspace 使用量持续增长直至触顶。GC 日志会明确显示 Metadata GC Threshold相关的收集。堆转储对此类问题帮助不大,需关注方法区(Metaspace)的类加载信息。

根因分析:

JVM 的 Metaspace 用于存储类的元数据(Class metadata)。

动态代码生成技术(如反射、CGLib、ASM、Lambda 表达式)会在运行时动态生成大量新的类。

例如,Spring 的 AOP 代理(CGLib)、MyBatis 的动态 Mapper 实现、Groovy 脚本引擎、以及不当使用的 LambdaMetafactory,都会导致 Metaspace 中不断被注入新的类。

如果这些生成的类没有被正确缓存或及时卸载(需要对应的 ClassLoader 被回收),Metaspace 的使用量就会持续增长,最终触发频繁的 Full GC。

架构级解法:

1、缓存机制:对于通过反射获得的 Method、Constructor、Field等对象,应将其缓存起来,避免在高速路径上反复执行反射调用,从而减少动态类的生成。

2、增大 Metaspace 并监控:这不是解法,而是缓冲策略。通过 -XX:MaxMetaspaceSize设置一个较大的上限,并配合 -XX:MetaspaceSize设置触发 GC 的阈值。同时,必须通过监控工具(如 Prometheus)持续关注 Metaspace 的使用趋势,提前发现潜在问题。

3、审视技术选型:评估项目中是否过度使用了动态代理、字节码增强等技术。在非必要场景,考虑更简单、更静态的实现方式。对于 Lambda 表达式,避免在循环体内创建,尤其是那些会捕获外部变量的 Lambda,因为它们可能会生成新的类。

常根6. 其他原因,比如不合理的内存分配与 GC 参数

现象特征:

应用本身逻辑看似无问题,但一旦上量,Full GC 就异常频繁。

GC 日志显示新生代 GC 频繁且对象晋升率高,或者发生 Promotion Failed(担保失败)。

根因分析:

这是典型的 JVM 参数与应用特征不匹配。

1、新生代过小:如果新生代(-Xmn)设置得太小,会导致短期存活的对象频繁引发 Minor GC,并且一些“中年”对象会过早被晋升到老年代,快速填满老年代触发 Full GC。

2、Survivor 区比例失调:-XX:SurvivorRatio设置不合理,导致 Survivor 空间不足,对象无法在年轻代充分被回收,直接进入老年代。

3、G1 GC 配置不当:G1 的 -XX:MaxGCPauseMillis(最大停顿时间目标)设置得过于激进(如 10ms),会迫使 G1 更早地启动混合收集(Mixed GC),但实际上可能因为来不及回收而适得其反,导致收集效率低下,Full GC 频繁。

架构级解法:

1、容量规划与压测调优:在上线前,基于预期的流量和数据进行压力测试,观察 GC 日志,根据对象分配和晋升情况来调整堆和各分区的大小。

2、遵循“先理解后调优”原则:避免盲目套用“网上最佳参数”。使用 jstat -gcutil和 GC 日志分析工具(如 GCeasy)来指导调优:

- 如果晋升率高,适当增大新生代(

-Xmn)。 - 如果 Survivor 区溢出,调整

-XX:SurvivorRatio。 - 对于 G1,谨慎设置

MaxGCPauseMillis,初始阶段可以保持默认或设置为一个合理的值(如 100-200ms)。

三、分层定位:从 “外部观测” 到 “根因的四步定位”

排查频繁 FullGC 需遵循以下流程:

先监控现象→ 后溯源根因。

尼恩将其总结为“内外兼修: 外部观测、四步定位”的排查心法。

尼恩提示:jvm调优,一定避免盲目调参,不能 盲目调参。

3.1 外部观测—— 明确 FullGC 频率与影响(快速定位方向)

首先需通过监控工具获取 “第一手数据”,判断 FullGC 的频率、持续时间、内存变化趋势,避免 “主观判断”(如 “感觉系统卡” 可能并非 FullGC 导致)。

首先必须用数据说话,通过可观测性工具获取客观指标,精准定义问题,避免“凭感觉”诊断。

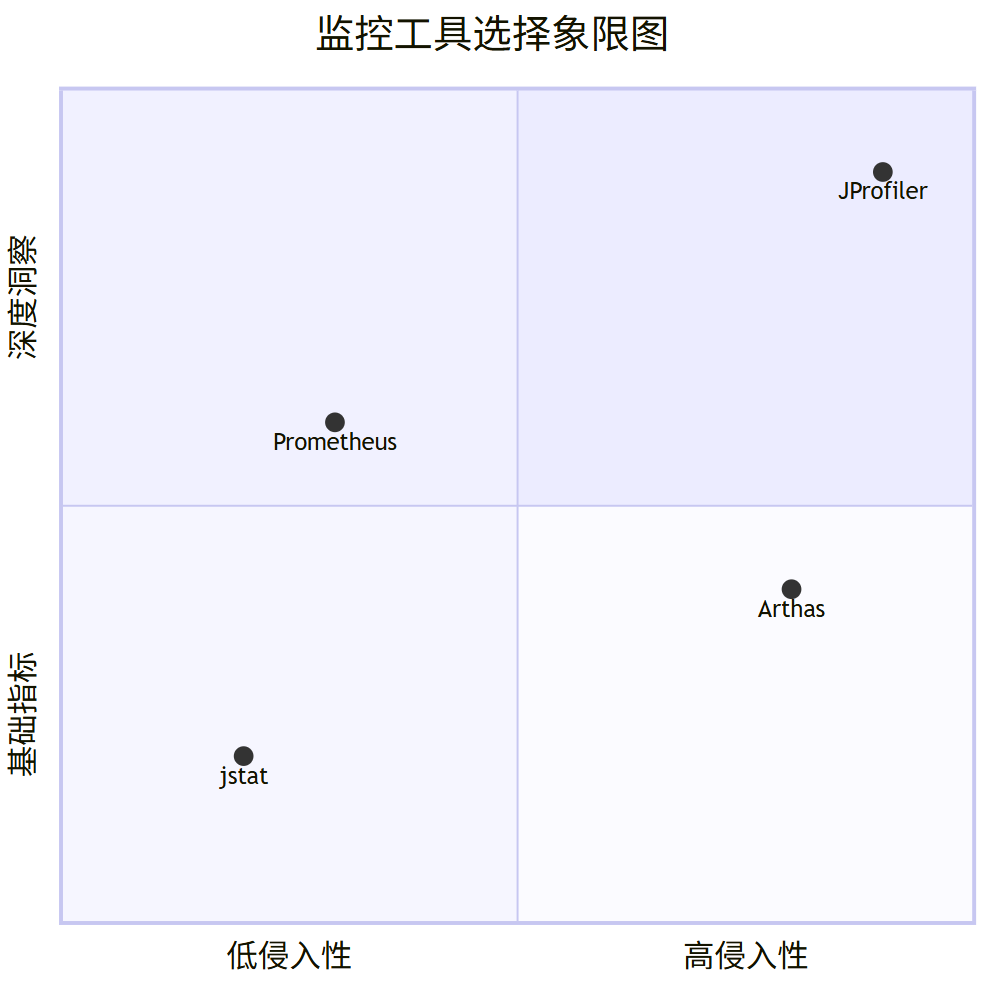

| 监控维度 | 关键指标 | 推荐工具 | 技术高手解读与目的 |

|---|---|---|---|

| FullGC基础信息 | 频率(次/分钟)、STW时间(毫秒/次)、回收效果(回收后老年代释放的内存大小) | jstat -gc <pid>, Prometheus + Grafana, SkyWalking |

目的:确诊是否真的是Full GC问题,并量化其严重程度。 解读:jstat看实时趋势,FGC/FGCT持续增长即为异常。Prometheus用于建立历史趋势大盘和告警,这是现代化运维的基石。 |

| 内存分区动态变化 | 老年代/元空间使用量-时间曲线、新生代晋升速率、大对象分配频率 | Arthas (dashboard/vmtool), JProfiler, JVisualVM |

目的:判断内存增长模式,区分是“内存泄漏”还是“大对象冲击”。 解读:曲线只升不降是泄漏的典型特征。Arthas可在生产环境无侵入在线诊断,是救火神器。JProfiler用于深度离线分析。 |

| 系统级影响 | 接口P99/P95延迟、CPU使用率(尤其GC线程占比)、请求超时率 | SkyWalking/Zipkin, top -Hp, 监控大盘 |

目的:将JVM内部事件与外部业务影响关联,证明Full GC是导致业务受损的根因。 解读:通过分布式链路追踪发现某个实例的延迟尖刺,并确认其时间点与GC日志中的STW时间点吻合,完成归因。 |

核心工具详解:

1、jstat -gc FGC(Full GC次数)和FGCT(Full GC总时间)列的数值是否在持续快速增加,OU(老年代使用量)是否在每次Full GC后没有明显下降。

2、Prometheus + Grafana:量化监控与告警的核心平台。通过JMX Exporter或Micrometer将JVM指标暴露给Prometheus,在Grafana中绘制:

- Full GC Frequency:

increase(jvm_gc_pause_seconds_count{gc="G1 Old Generation", action="end of major GC"}[5m]) - Full GC Duration:

increase(jvm_gc_pause_seconds_sum{gc="G1 Old Generation", action="end of major GC"}[5m]) - Old Gen Usage:

jvm_memory_used_bytes{area="heap"}

3、Arthas:生产环境在线诊断瑞士军刀。无需重启,动态跟踪问题。

dashboard:实时查看整体线程、内存、GC状态。vmtool:动态拦截对象,查看大小。heapdump:在线生成堆转储(替代jmap,部分场景更安全)。

4、SkyWalking:关联业务与基础设施的桥梁。其核心价值在于打通了业务链路Trace和JVM Metric,可以清晰地看到一个慢请求发生时,该实例的GC情况如何,真正做到端到端的根因定位。

通过以上监控组合拳, 不仅能发现问题,更能分析根因(是缓慢泄漏还是瞬间暴涨)、量化问题(频率和影响如何),并为下一步的深度剖析(获取堆转储、线程dump)提供最准确的时机和方向。

关键 监控平台(Granfana/Prometheus):观察时序趋势图,这是最高效的手段。

- Heap Memory Usage:观察老年代(Old Generation)内存使用率是否呈“锯齿状”(快速上升后被GC回收,如此反复),这是频繁Full GC的典型特征。

- GC Times / Duration:观察Full GC的频率和每次暂停的时间。

关键 监控 指标:

- Full GC Frequency:> 1次/分钟通常就不健康。

- STW Duration:每次暂停时间 > 1秒,或总暂停时间占比 > 1%。

实操步骤(以 Prometheus+Grafana 为例)

(1) 部署 JVM 监控 exporter(如 jmx_exporter),采集 jvm_gc_full_count(FullGC 次数)、jvm_gc_full_seconds(FullGC 总耗时)等指标;

(2) 在 Grafana 配置仪表盘,设置 “FullGC 频率> 1 次 / 5 分钟”“单次 STW>500ms” 的告警阈值;

(3) 观察内存曲线:若老年代使用量 “快速上升→FullGC 后骤降→再次快速上升”,说明存在 “对象频繁创建且无法回收” 的问题;若元空间使用量持续上升,需排查类加载泄漏。

3.2、根因排查层:四步定位闭环(采集→日志解析→堆 dump 分析→根因验证)

从顶尖高手思维出发,Full GC 分析过程需避免 “直接看堆 dump 找大对象” 的盲目操作,应先通过 GC 日志锁定方向,再用堆 dump 验证,最终形成闭环。

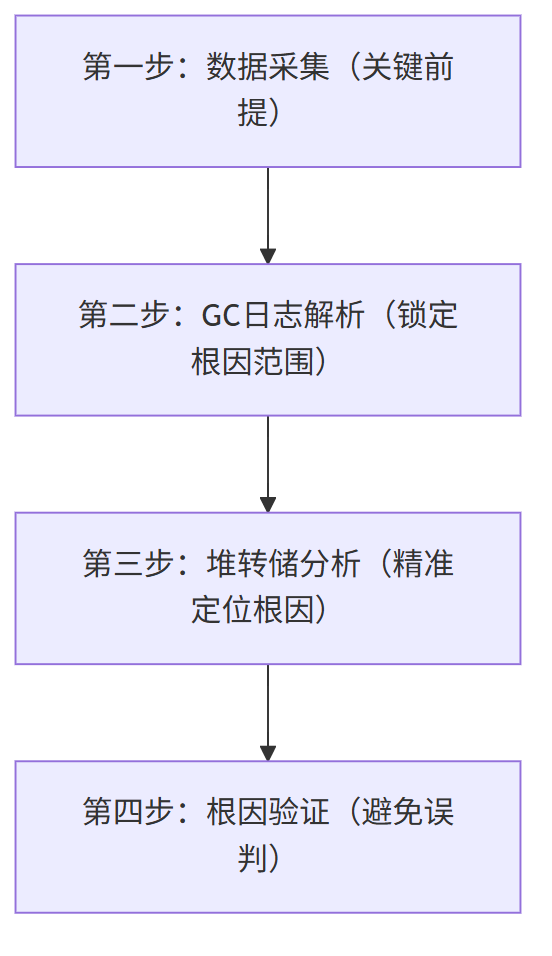

以下是标准化四步流程 闭环:

采集→GC 日志解析→堆转储( dump )分析→根因验证

四步流程 最终形成闭环。

GC 日志与堆转储的核心价值差异

在分析 FullGC 前,需先明确二者的本质定位 —— 它们分别解决 “FullGC 如何发生” 和 “FullGC 为何发生” 的问题,底层逻辑互补:

| 分析维度 | GC 日志(动态行为日志) | 堆转储(Heap Dump,静态内存快照) |

|---|---|---|

| 核心内容 | 1. FullGC 触发时机(如 “老年代占满”“元空间溢出”); 2. 各内存区域变化(如老年代回收前 / 后使用率); 3. GC 耗时(STW 时间、各阶段耗时); 4. GC 算法行为(如 G1 的 Mixed GC 失败触发 FullGC) | 1. 所有存活对象的类型、数量、大小; 2. 对象引用链(如 “哪个静态集合持有大对象”); 3. 内存泄漏疑点(如 “支配树中占比超 50% 的对象”); 4. 类加载情况(如 “元空间中动态生成的类数量”) |

| 底层逻辑 | 记录 JVM 内存管理的 “动态事件流”,反映 FullGC 的 “过程特征” | 抓拍 JVM 内存的 “静态快照”,反映 FullGC 的 “结构根源”(哪些对象在消耗内存) |

| 局限性 | 无法定位 “具体哪些对象导致内存不足”,仅能判断 “内存不足的类型” | 无法反映 “内存增长趋势”(如 “对象是突然暴增还是缓慢累积”),需结合多份快照对比 |

核心结论:

-

GC 日志是 “线索探测器”,用于缩小 FullGC 根因范围(如 “是老年代大对象还是元空间类泄漏”);

-

堆转储是 “根因定位器”,用于精准找到 “罪魁祸首”(如 “某个 HashMap 缓存了 100 万条未清理的日志对象”)。

二者结合才能形成 “从现象到根因” 的完整证据链

四: 四步定位闭环(采集→日志解析→堆 dump 分析→根因验证)

下面尼恩带大家对 四步定位闭环 ,进行详细介绍。

4.1 第一步:数据采集 —— 确保 “数据质量” 是分析的前提

采集不完整的 GC 日志或堆 dump 会直接导致分析失败,需提前配置 JVM 参数并掌握正确采集时机:

4.1.1 GC 日志采集(关键 JVM 参数)

需配置 “时间戳、内存区域、GC 阶段、耗时” 等关键信息,推荐参数如下(以 G1 GC 为例):

# JVM参数(Linux环境)

-XX:+PrintGCDetails # 打印详细GC信息(内存区域变化、耗时)

-XX:+PrintGCDateStamps # 打印GC发生的时间戳(格式:yyyy-MM-dd HH:mm:ss)

-XX:+PrintHeapAtGC # GC前后打印堆内存分布(老年代/新生代/元空间使用率)

-XX:+PrintReferenceGC # 打印引用处理情况(如软引用、弱引用回收)

-Xlog:gc*:file=/var/log/jvm/gc-%t.log:time,level,tags:filecount=10,filesize=100m # JDK9+统一日志格式,按时间滚动,保留10个文件(共1GB)

采集时机:

GC 日志需 “长期持续采集”,不能仅在 FullGC 后才开启 —— 需通过历史日志观察 “FullGC 前的内存增长趋势”(如 “老年代每天上涨 5%” vs “突然 1 小时涨满”)。

4.1.2 堆转储采集(关键工具与时机)

堆转储需在 “FullGC 后立即采集”,此时内存中仅保留 “存活对象”(避免死对象干扰分析),核心工具与命令如下:

| 工具 | 命令示例 | 适用场景 |

|---|---|---|

| jmap(JDK 自带) | jmap -dump:format=b,file=heap-after-fullgc.hprof <pid> (-dump:live 可选,仅保留存活对象,减少文件大小) |

生产环境离线采集(无性能开销) |

| Arthas(在线) | heapdump /tmp/heap-after-fullgc.hprof |

生产环境在线采集(无需重启服务) |

| JVisualVM | 图形化界面→右键进程→“Heap Dump” | 开发 / 测试环境(需 GUI 支持) |

注意:

堆 dump 文件可能达 GB 级,需提前预留磁盘空间;

生产环境建议用-dump:live仅保留存活对象,避免文件过大。

4.2 第二步:GC 日志解析 —— 从 “动态行为” 锁定根因范围

GC 日志解析的核心目标是 “排除干扰项,缩小根因范围”,需重点关注以下 4 个维度:

维度 1:判断 FullGC 触发类型(核心线索)

不同触发类型对应完全不同的根因,需从日志中提取关键关键字:

| FullGC 触发类型 | 日志关键字 | 对应根因方向 |

|---|---|---|

| 老年代内存不足 | [Full GC (Ergonomics)](G1)、[Full GC (Allocation Failure)](CMS) 且日志中Old Gen回收前使用率 > 90% |

1. 大对象直接进入老年代; 2. 新生代晋升速率过快; 3. 老年代对象无法回收(内存泄漏) |

| 元空间溢出 | [Full GC (Metadata GC Threshold)] 且日志中Metaspace使用率 > 95% |

1. 动态类生成过多(如 Groovy 脚本、ASM); 2. 类加载器泄漏(如未关闭的 GroovyClassLoader) |

| GC 算法执行失败 | [Full GC (Concurrent Mode Failure)](CMS) [Full GC (G1 Evacuation Pause)](G1) |

1. CMS 并发回收时老年代突然满; 2. G1 混合回收无法清理足够内存 |

| 显式调用 System.gc () | [Full GC (System.gc())] |

1. 代码中手动调用System.gc(); 2. 第三方框架隐式调用(如 RMI) |

示例日志片段(老年代不足触发 FullGC):

2024-05-20T14:30:00.123+0800: [Full GC (Ergonomics) [G1 Old Gen: 1887436K->1802436K(2097152K)] 2097152K->1802436K(2097152K), [Metaspace: 100000K->100000K(102400K)], 0.8900000 secs] [Times: user=2.10 sys=0.02, real=0.89 secs]

解析:

- 触发类型:

Full GC (Ergonomics)(G1 自动触发); - 老年代变化:回收前 1887MB(90% 使用率)→回收后 1802MB(86% 使用率),仅释放 85MB,属于 “无效 FullGC”(说明老年代对象多为存活状态,怀疑内存泄漏);

- 元空间无变化:排除元空间问题。

维度 2:分析内存区域变化(判断回收有效性)

通过 “GC 前后各区域使用率” 判断 FullGC 是否 “有效”—— 有效 FullGC 应能释放大量内存,无效 FullGC 则释放极少(提示内存泄漏):

| 内存区域变化特征 | 对应根因方向 |

|---|---|

| 老年代回收前 > 90%,回收后 < 60% | FullGC 有效,根因可能是 “临时大对象突发”(如批量任务) |

| 老年代回收前 > 90%,回收后 > 85% | FullGC 无效,根因是 “内存泄漏”(对象长期存活无法回收) |

| 元空间持续上涨(每次 GC 后不下降) | 类泄漏(动态类未回收) |

维度 3:提取关键指标(量化问题严重程度)

- STW 时间:如日志中

real=0.89 secs(实际耗时 890ms),若 STW>500ms,说明 FullGC 已影响业务响应(需优先解决); - 大对象分配频率:日志中

Allocated a new humongous object of size 10485760 bytes(分配 10MB 大对象)频繁出现,说明大对象是老年代压力来源; - 新生代晋升速率:通过多次 GC 日志计算 “新生代晋升到老年代的速率”(如每小时晋升 1GB),若速率远超老年代释放速率,说明晋升过快(需调整 JVM 参数如

-XX:MaxTenuringThreshold)。

维度 4:初步定位方向(形成分析假设)

基于以上 3 个维度,形成初步假设,例如:

假设 1:GC 日志显示 “老年代无效 FullGC + 无大对象分配”, 可以 怀疑是 “内存泄漏(如静态集合未清理)”;

假设 2:GC 日志显示 “老年代 FullGC 有效 + 大对象分配频繁”, 可以 怀疑是 “业务批量处理未分片(如一次性加载 10 万条数据)”;

假设 3:GC 日志显示 “元空间溢出 + 动态类生成日志”, 可以 怀疑是 “类加载器泄漏(如 Groovy 脚本未复用 ClassLoader)”。

4.3 第三步:堆转储分析 —— 从 “静态结构” 验证假设并定位根因

堆转储分析需 “围绕 GC 日志的初步假设展开”,避免无目的浏览。

推荐用MAT(Memory Analyzer Tool) 或Arthas,核心关注 3 个模块:

4.3.1 dump分析 1:支配树(Dominator Tree)—— 快速找到 “内存大户”

支配树的核心作用是 “按对象对内存的‘支配权’排序”—— 某对象若被删除后能释放大量内存,则在支配树中排名靠前,是 “内存大户”。

操作步骤(MAT):

(1) 导入堆 dump 文件→选择 “Leak Suspects Report”(泄漏疑点报告);

(2) 查看 “Dominator Tree” 标签,按 “Retained Size”(保留大小,即对象被删除后可释放的内存)排序;

(3) 重点关注 “Retained Size 占比超 10%” 的对象(如某HashMap保留大小占老年代 60%)。

示例场景:

GC 日志初步假设 “内存泄漏”,MAT 支配树显示java.util.HashMap(全类名com.xxx.service.UserCache中的静态userMap)保留大小 1.5GB(占老年代 75%)→锁定该 HashMap 为 “内存大户”。

4.3.2 dump分析 2:引用链分析(找到 “谁在持有对象”)

支配树找到内存大户后,需追溯 “引用链”—— 即 “哪个对象 / 变量持有该内存大户,导致其无法被 GC 回收”。

操作步骤(MAT):

(1) 右键内存大户对象(如HashMap)→“Path to GC Roots”→“Exclude Weak References”(排除弱引用,仅看强引用);

(2) 查看引用链,若显示 “static userMap → UserCache类 → ClassLoader”→说明该 HashMap 被静态变量持有,长期存活无法回收。

示例引用链:

java.util.HashMap @ 0x78000001 (size=1000000, retained size=1.5GB)

↓ (value)

com.xxx.model.User @ 0x78000002 (retained size=1.5KB)

↓ (this$0)

com.xxx.service.UserCache @ 0x78000003 (static class)

↓ (class)

sun.misc.Launcher$AppClassLoader @ 0x78000004 (system class loader)

解析:UserCache类的静态HashMap持有 100 万个User对象,且被系统类加载器持有→对象无法被 GC 回收,导致老年代内存泄漏。

4.3.3 dump分析 3:类加载分析(验证元空间问题)

若 GC 日志指向 “元空间溢出”,需在堆 dump 中查看 “类加载器与动态类数量”:

操作步骤(MAT):

(1) 选择 “Class Loader Explorer” 标签→查看各 ClassLoader 加载的类数量;

(2) 若GroovyClassLoader加载了 10 万 + 类,且引用链显示 “ClassLoader 被线程持有未释放”→说明类加载器泄漏。

4.4 第四步:根因验证 —— 避免 “误判”,确保结论可靠

堆转储分析得出结论后,需通过 “多维度验证” 避免误判,核心验证手段:

(1) 多份堆 dump 对比:

若 1 小时内两次堆 dump 中,UserCache的HashMap大小从 100 万增长到 120 万→确认对象持续累积,验证内存泄漏;

(2) 业务代码核对:

查看UserCache类,若发现 “仅 put 对象未 remove,且无过期机制”→与堆 dump 结论一致;

(3) 修改后验证:

临时清理UserCache的HashMap,观察 GC 日志→若 FullGC 频率从 10 次 / 小时降至 1 次 / 天→验证根因正确。

4.5、日志解析 + 堆 dump 分析 典型场景实战

通过两个典型场景,完整演示分析过程:

场景 1:静态缓存未清理, 导致内存泄漏

step1:GC 日志解析(初步假设)

- 触发类型:

Full GC (Ergonomics),老年代回收前 92%→回收后 88%(无效 FullGC); - 元空间无变化,无大对象分配日志→初步假设:内存泄漏(静态集合未清理)。

step 2:堆 dump 分析(验证假设)

支配树:UserCache的静态HashMap占老年代 70%,保留大小 1.4GB;

引用链:static userMap → UserCache → 系统类加载器→→ 确认静态变量持有大对象,无法回收;

- 类实例统计:

User对象数量达 120 万,与HashMap存储数量一致→ 根因锁定 “UserCache静态缓存未清理,User对象持续累积”。

step 3:根因验证

-

业务代码核对:

UserCache类仅提供addUser方法(put 对象),无remove或过期清理逻辑,且被@Component注解为单例→ 代码缺陷验证; -

临时修复:调用

UserCache.clear()清理缓存后,GC 日志显示老年代使用率从 88% 降至 45%,FullGC 频率从 10 次 / 小时降至 0 次 / 天→ 结论可靠。

场景 2:动态类生成太多,导致元空间溢出

step 1:GC 日志解析(初步假设)

- 触发类型:

Full GC (Metadata GC Threshold),元空间使用率 98%(102MB/104MB),GC 后无释放; - 日志中频繁出现 “

Loaded com.xxx.groovy.Script123”→ 初步假设:动态类生成过多,类加载器泄漏。

step 2:堆 dump 分析(验证假设)

- 类加载器统计:

GroovyClassLoader实例达 500 个,每个加载 200 + 动态脚本类,共 10 万 + 类; - 引用链:

GroovyClassLoader被ThreadPoolTaskExecutor的线程持有(线程复用未释放)→ 类加载器无法回收,导致类元信息累积。

step 3:根因验证

- 业务代码核对:Groovy 脚本执行逻辑为 “每次执行新建

GroovyClassLoader,执行后未关闭”,且用线程池复用线程→ 代码缺陷验证; - 优化后:复用

GroovyClassLoader,执行后调用close()释放→ 元空间使用率降至 60%,FullGC 不再触发→ 结论可靠。

4.6.日志解析 + 堆 dump 分析 工具 选型

从 “效率” 和 “生产环境适配” 出发,需选择合适的工具链,并遵循最佳实践:

| 工具类型 | 工具名称 | 优势 | 适用场景 |

|---|---|---|---|

| GC 日志分析工具 | GCeasy(在线 / 本地) | 自动解析日志,生成可视化报告(如 FullGC 频率趋势、内存泄漏风险),支持导出 PDF | 生产环境快速分析,无需复杂配置 |

| 堆转储分析工具 | MAT(Memory Analyzer Tool) | 功能强大,支持支配树、引用链、泄漏疑点分析,可处理 GB 级堆 dump | 深度根因定位(如内存泄漏、大对象分析) |

| 在线排查工具 | Arthas | 无需重启服务,支持在线生成堆 dump、查看 GC 状态、类加载情况 | 生产环境无法停机时的在线排查 |

| 监控与告警工具 | Prometheus + Grafana | 长期监控 GC 指标(FullGC 次数、老年代使用率),设置告警阈值 | 提前发现 FullGC 趋势,避免故障扩散 |

4.7 四步定位闭环(采集→日志解析→堆 dump 分析→根因验证)最佳实践

4.7.1 提前配置 GC 日志与堆 dump 采集:

在服务部署时,统一配置 GC 日志 JVM 参数(如通过 K8s ConfigMap 或 Dockerfile 固化),避免故障时无日志可查;

生产环境部署 “堆 dump 自动采集脚本”:当 FullGC 频率 > 1 次 / 5 分钟时,自动调用jmap生成堆 dump,避免人工操作延误。

4.7.2 建立 “GC 日志 + 堆 dump” 关联分析机制:

将堆 dump 文件名与 GC 日志时间戳关联(如heap-202405201430.hprof对应 14:30 的 FullGC),便于后续追溯;

用 Prometheus 存储 GC 指标,当触发告警时,自动关联对应时间段的 GC 日志和堆 dump,加速分析。

4.7.3 避免生产环境盲目分析堆 dump:

堆 dump 分析(尤其是 MAT)需消耗大量 CPU / 内存,生产环境建议将堆 dump 下载到本地分析,避免影响线上服务;

若堆 dump 文件 > 10GB,可先用jhat或jmap -histo:live <pid>生成简化统计(如对象类型与数量),缩小分析范围后再用 MAT 深入。

4.8 在k8s容器环境如何 Heap Dump

面试官 一般会追问:在k8s容器环境如何 Heap Dump。

在Kubernetes容器化环境中排查频繁Full GC问题,不仅考验JVM调优功底,更考验云原生体系下的综合运维与架构能力。

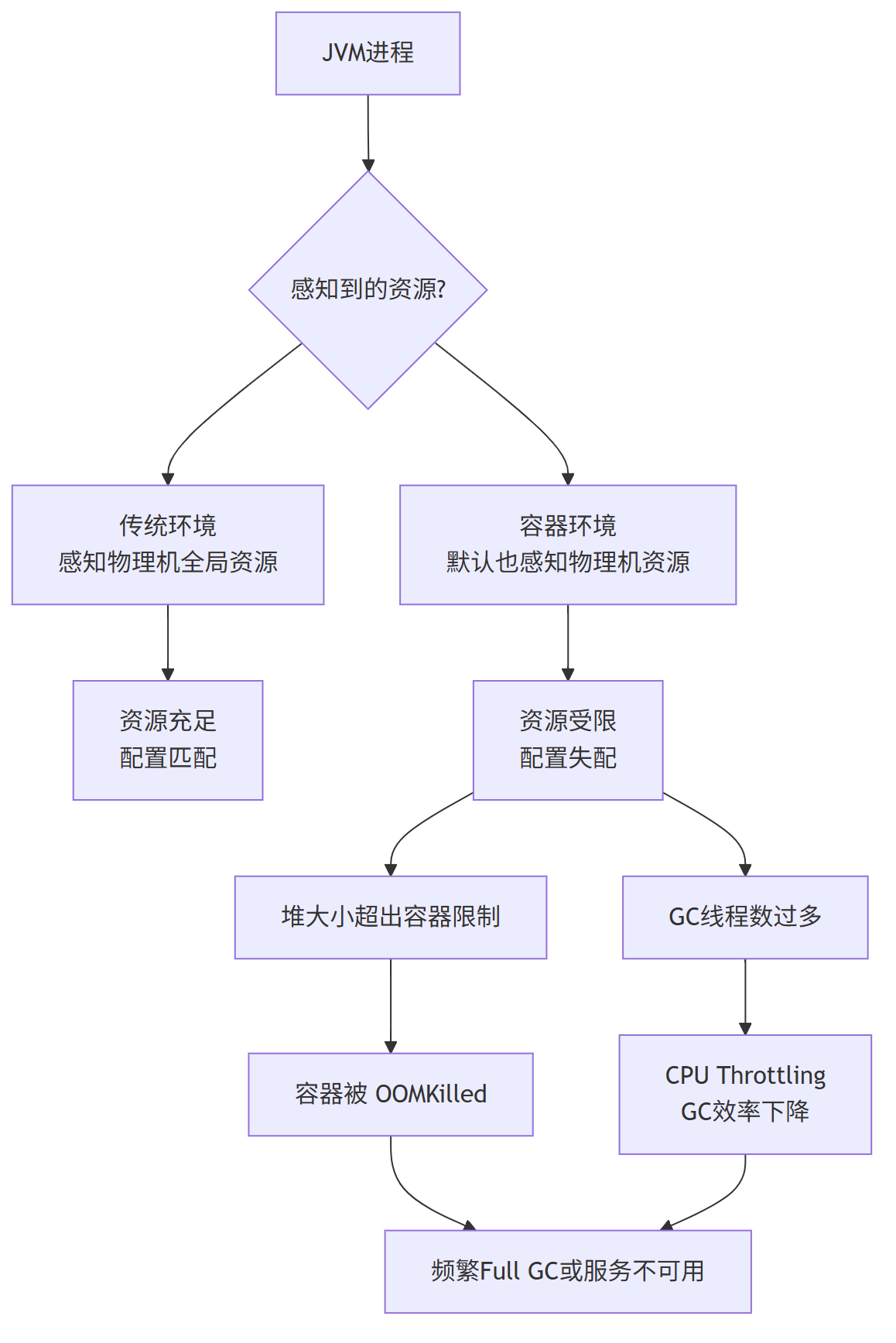

4.8.1 核心挑战:容器化环境带来的新维度

与传统物理机/虚拟机相比,K8s环境带来了三大核心挑战,这些问题环环相扣,必须首先理解:

1、资源限制与感知:JVM默认感知的是物理机的资源上限,而非容器的CPU/Memory Limit。这会导致:

-

堆大小设置不当,超出容器内存限制,引发容器被OOMKilled。

-

GC线程数(

-XX:ParallelGCThreads)基于物理CPU核心数,在受限的容器环境内造成过度线程上下文切换。

2、可观测性复杂度:排查链路变长。你需要先定位Pod,再进入容器,才能执行传统命令。日志、指标、快照的获取和存储都需要新的工具链和方法。

3、动态与弹性:Pod可能随时被调度或重启,传统的jmap、jstat命令的目标可能瞬间消失,需要更自动化、平台化的排查手段。

4.8.2 容器场景下的 体系化排查框架

第一层:在k8s容器环境 全局监控告警(发现与定位)

目标:快速发现哪个服务、哪个Pod实例出现了异常。

工具:Prometheus+ Grafana+ Alertmanager

核心指标:

1、容器内存指标:container_memory_usage_bytes/ container_memory_working_set_bytes。对比其与容器Limit值,判断是否逼近上限。

2、JVM GC指标:通过micrometer或jmx_exporter暴露的JVM指标,如:

jvm_gc_pause_seconds_count{action="end of major GC"}(Full GC次数)jvm_gc_pause_seconds_sum{action="end of major GC"}(Full GC总耗时)jvm_memory_used_bytes{area="heap"}(各堆区域使用量)

方法:在Grafana中绘制图表,并设置告警规则。

例如:“Full GC频率 > 2次/分钟” 持续5分钟则触发告警,并直接定位到异常Pod。

第二层:深入Pod内部诊断(采集与分析)

当告警触发后,我们需要登录到特定Pod进行深入排查。

1、获取Pod Shell:

kubectl exec -it <pod-name> -- /bin/bash

2、简化版TOP命令:

查看进程资源:

# 进入容器后,快速查看进程资源占用

kubectl top pod <pod-name> --containers

3. 容器内的JVM诊断命令:

查看GC状态(jstat):

# 先找到Java进程的PID,比如 1

jstat -gc 1 1s

# 观察FGC(Full GC次数)和FGCT(Full GC时间)的增长趋势

获取GC日志:这是最关键的证据。

必须在启动参数中预先开启。

# Java启动参数中必须添加,建议通过环境变量注入

-Xloggc:/opt/logs/gc.log

-XX:+PrintGCDetails

-XX:+PrintGCDateStamps

-XX:+UseGCLogFileRotation

-XX:NumberOfGCLogFiles=5

-XX:GCLogFileSize=10M

查看日志:tail -f /opt/logs/gc.log

4、紧急获取堆转储(Heap Dump):

# 进入容器后执行

jmap -dump:live,format=b,file=/tmp/heap.hprof 1

# 将dump文件从容器内复制到本地

kubectl cp <namespace>/<pod-name>:/tmp/heap.hprof ./heap.hprof

注意:jmap可能会触发STW,对生产环境有影响,务必谨慎。

第三层: k8s容器环境 高级与自动化诊断

对于临时排查,上述命令足够。

但对于生产环境,我们需要更优雅、自动化、平台化的方案。

1、Sidecar模式收集GC日志:

在Pod中部署一个Sidecar容器,专门负责收集和输出主容器的GC日志。

apiVersion: v1

kind: Pod

metadata:

name: my-java-app

spec:

containers:

- name: java-app

image: my-java-app:latest

volumeMounts:

- name: gc-logs

mountPath: /opt/logs

args:

- -Xloggc:/opt/logs/gc.log

- ...

- name: log-sidecar # 日志收集Sidecar

image: busybox

args: [/bin/sh, -c, 'tail -n+1 -f /opt/logs/gc.log']

volumeMounts:

- name: gc-logs

mountPath: /opt/logs

volumes:

- name: gc-logs

emptyDir: {}

2、APM工具集成:

集成APM (Application Performance Monitoring) 工具,如 SkyWalking, Pinpoint, Arthas集成。

它们提供无侵入式的JVM监控,可以实时查看内存、线程、方法调用链,甚至可以在线执行诊断命令,避免了频繁登录容器。

这是云原生最佳实践。

五 彻底解决问题: 从 “应急处理” 到 “架构优化” 的 e2e 解决方案

解决频繁 FullGC 问题, 端到端e2e的解决方案:

需分 “紧急止血→局部代码优化 与 JVM 优化→ 架构升级” 三个大步骤,确保问题彻底解决。

由于平台篇幅限制, 剩下的内容(5000字+),请参参见原文地址

浙公网安备 33010602011771号

浙公网安备 33010602011771号