Redis集群 - 图解 - 秒懂(史上最全)

文章很长,而且持续更新,建议收藏起来,慢慢读!疯狂创客圈总目录 博客园版 为您奉上珍贵的学习资源 :

免费赠送 :《尼恩Java面试宝典》 持续更新+ 史上最全 + 面试必备 2000页+ 面试必备 + 大厂必备 +涨薪必备

免费赠送 经典图书:《Java高并发核心编程(卷1)加强版》 面试必备 + 大厂必备 +涨薪必备 加尼恩免费领

免费赠送 经典图书:《Java高并发核心编程(卷2)加强版》 面试必备 + 大厂必备 +涨薪必备 加尼恩免费领

免费赠送 经典图书:《Java高并发核心编程(卷3)加强版》 面试必备 + 大厂必备 +涨薪必备 加尼恩免费领

免费赠送 经典图书:《尼恩Java面试宝典 最新版》 面试必备 + 大厂必备 +涨薪必备 加尼恩免费领

免费赠送 资源宝库: Java 必备 百度网盘资源大合集 价值>10000元 加尼恩领取

Redis集群 - 图解 - 秒懂(史上最全)

说明:

本文,以史上最为清晰的笔法,介绍清楚了Redis集群。

看完本文,涉及到Redis集群的架构类面试题目,按照本文的思路去回答,一定是120分。

Redis的架构模式分类

-

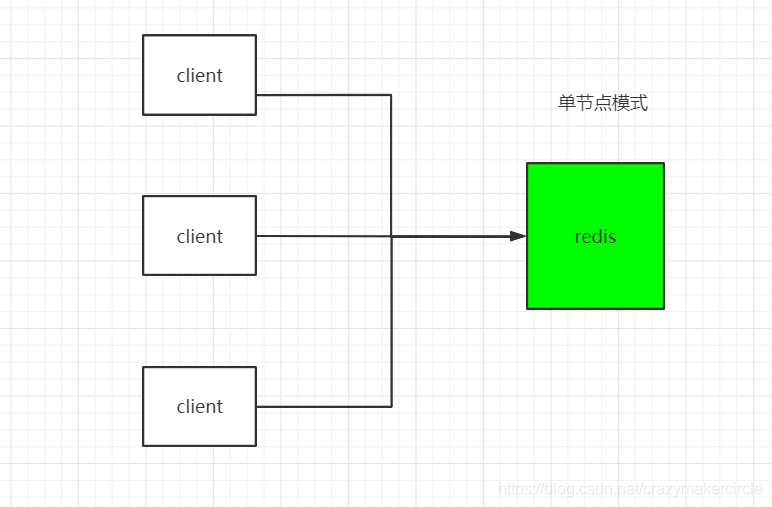

单节点模式

-

主从模式

-

哨兵模式

-

集群模式

单节点模式

特点:简单

问题:

1、内存容量有限 2、处理能力有限 3、无法高可用。

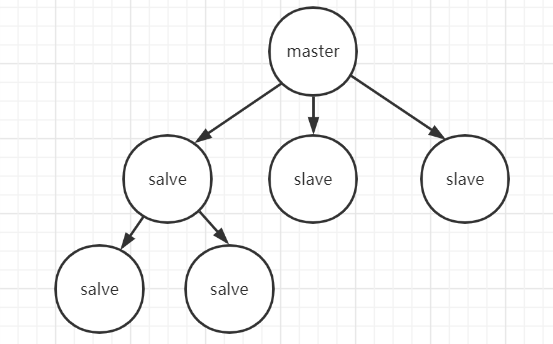

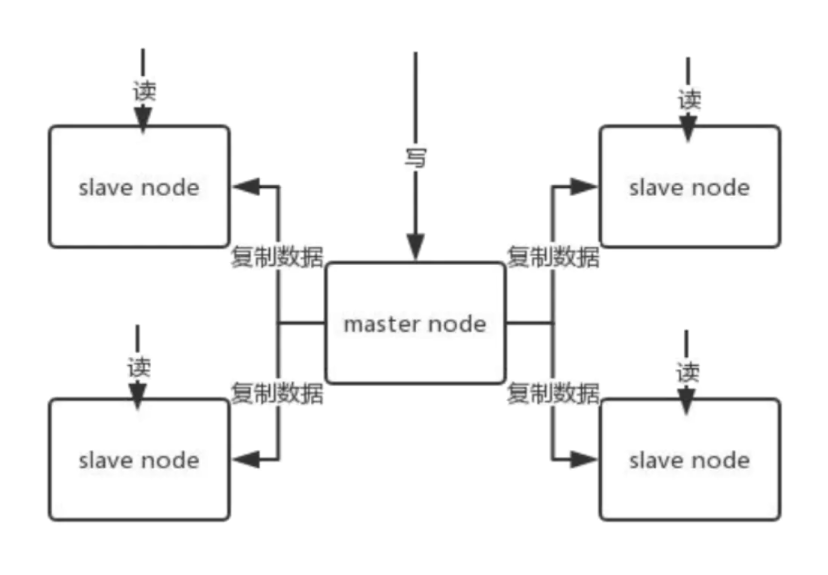

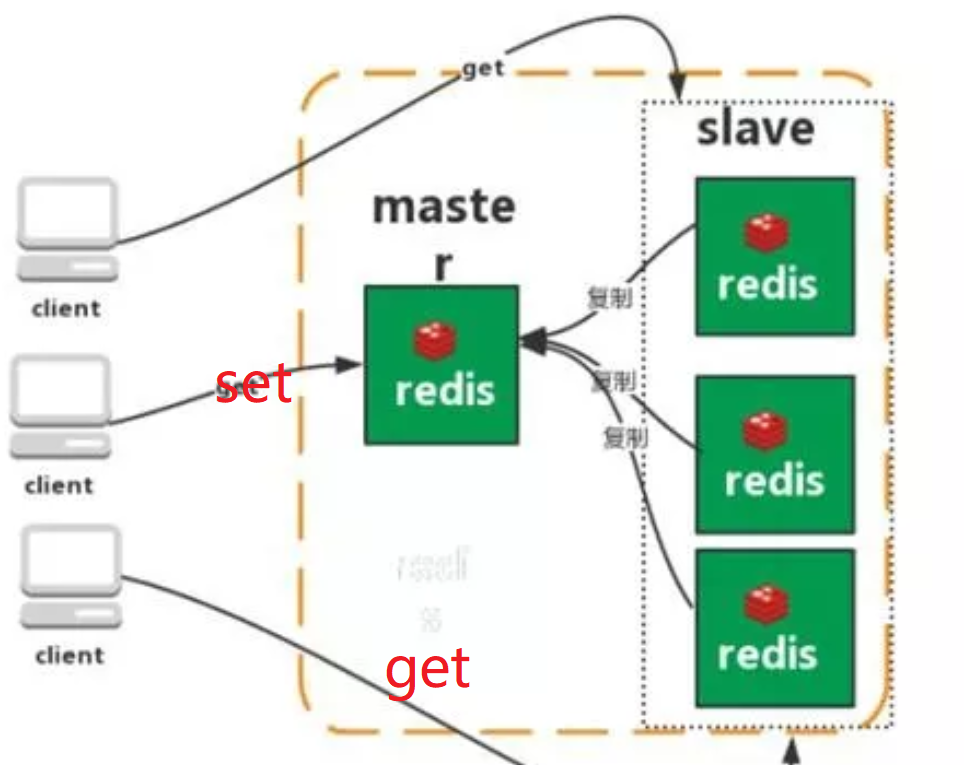

主从模式

Redis 的复制(replication)功能允许用户根据一个 Redis 服务器来创建任意多个该服务器的复制品,其中被复制的服务器为主服务器(master),而通过复制创建出来的服务器复制品则为从服务器(slave)。 只要主从服务器之间的网络连接正常,主从服务器两者会具有相同的数据,主服务器就会一直将发生在自己身上的数据更新同步 给从服务器,从而一直保证主从服务器的数据相同。

特点:

1、master/slave 角色

2、master/slave 数据相同

3、降低 master 读压力, 读取工作转交从库

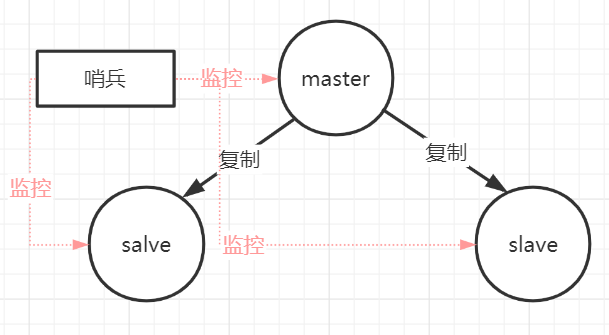

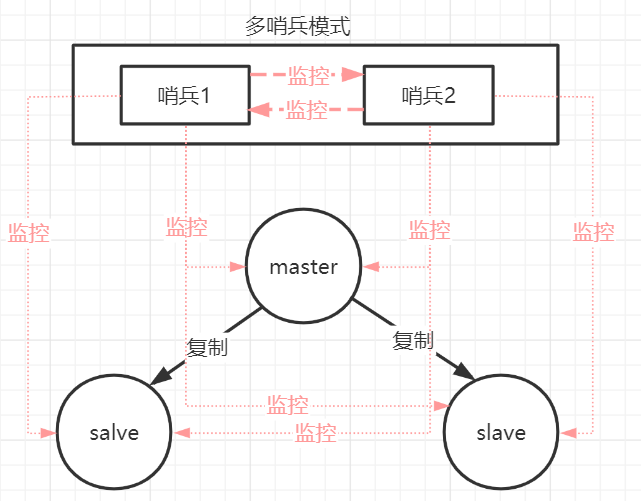

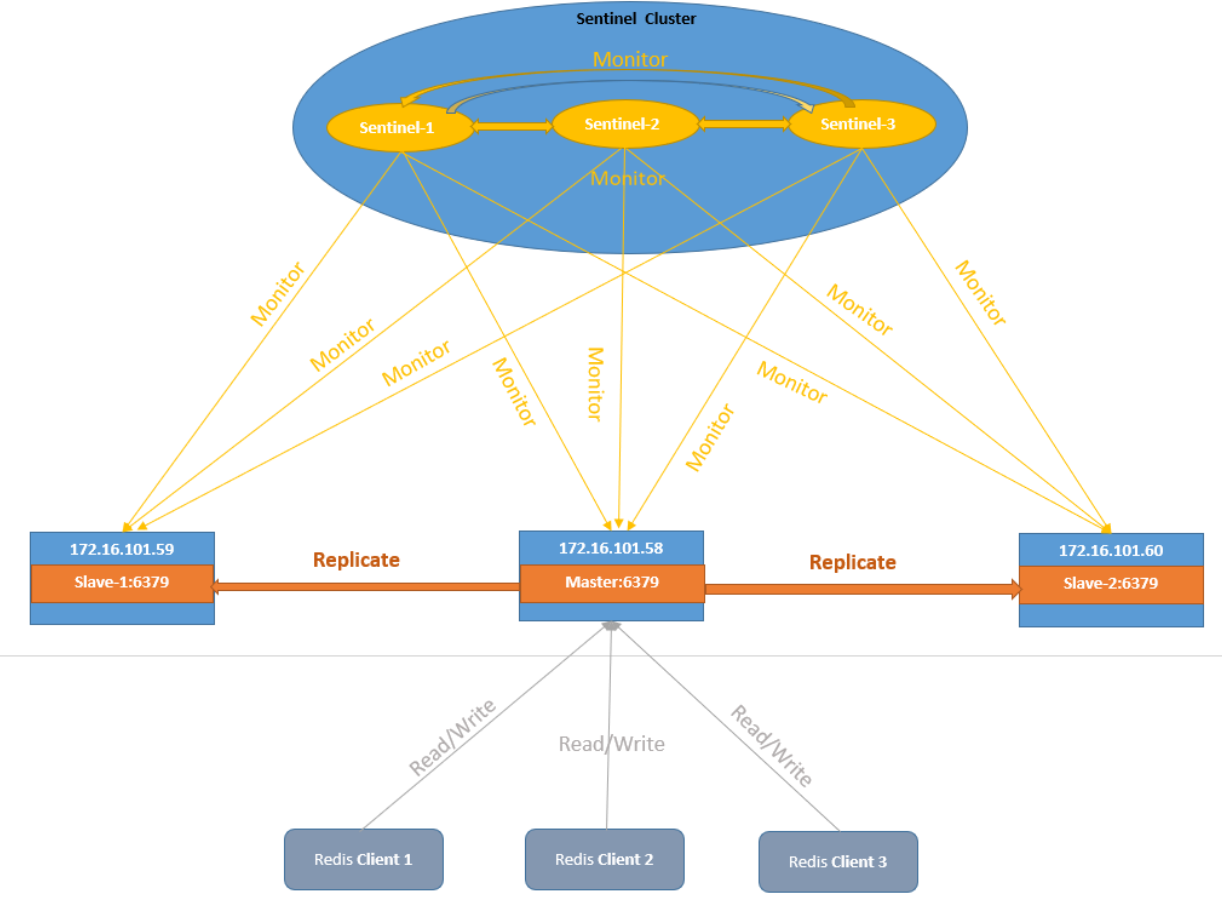

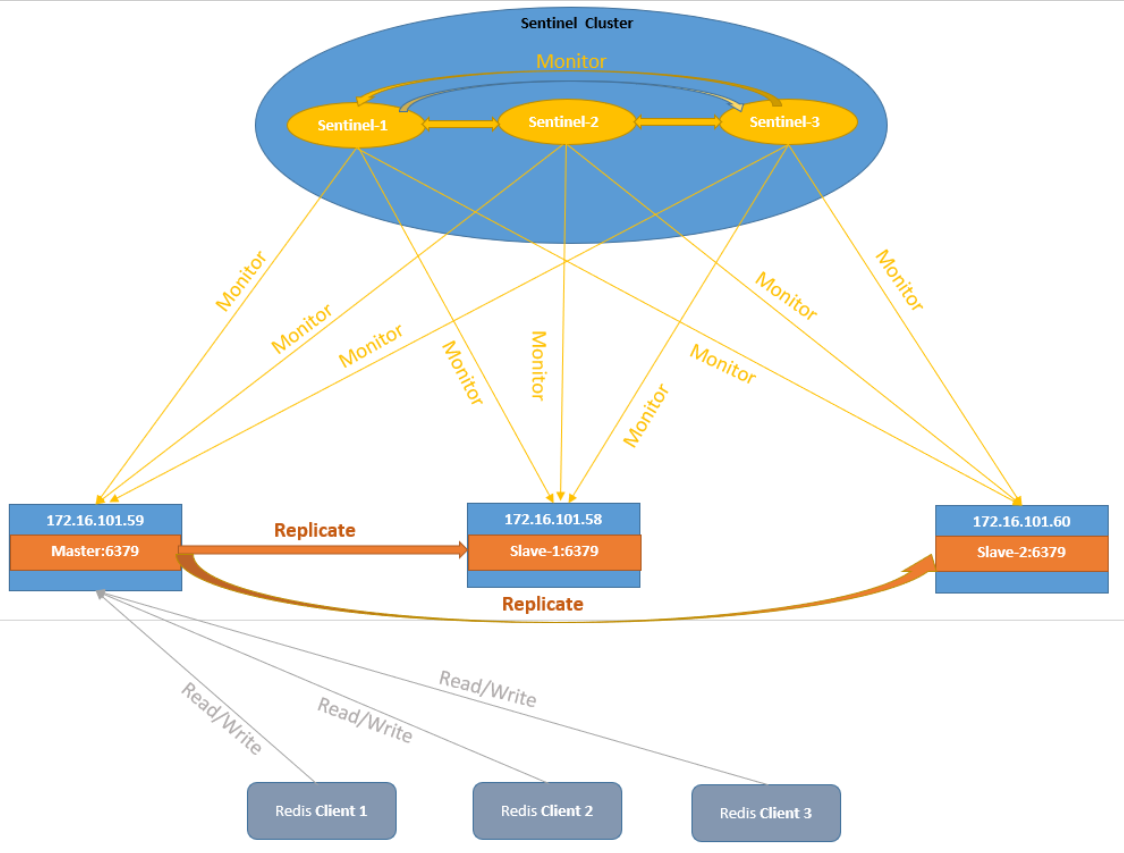

哨兵模式

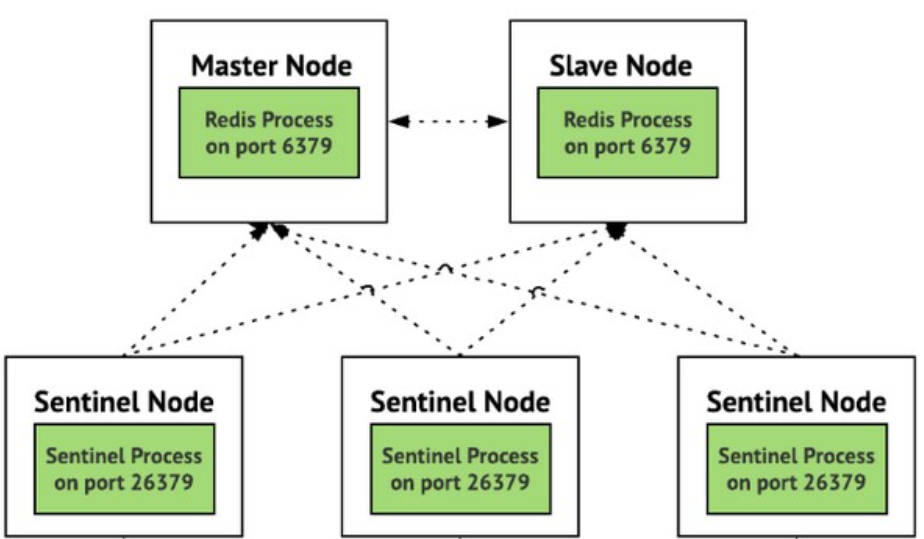

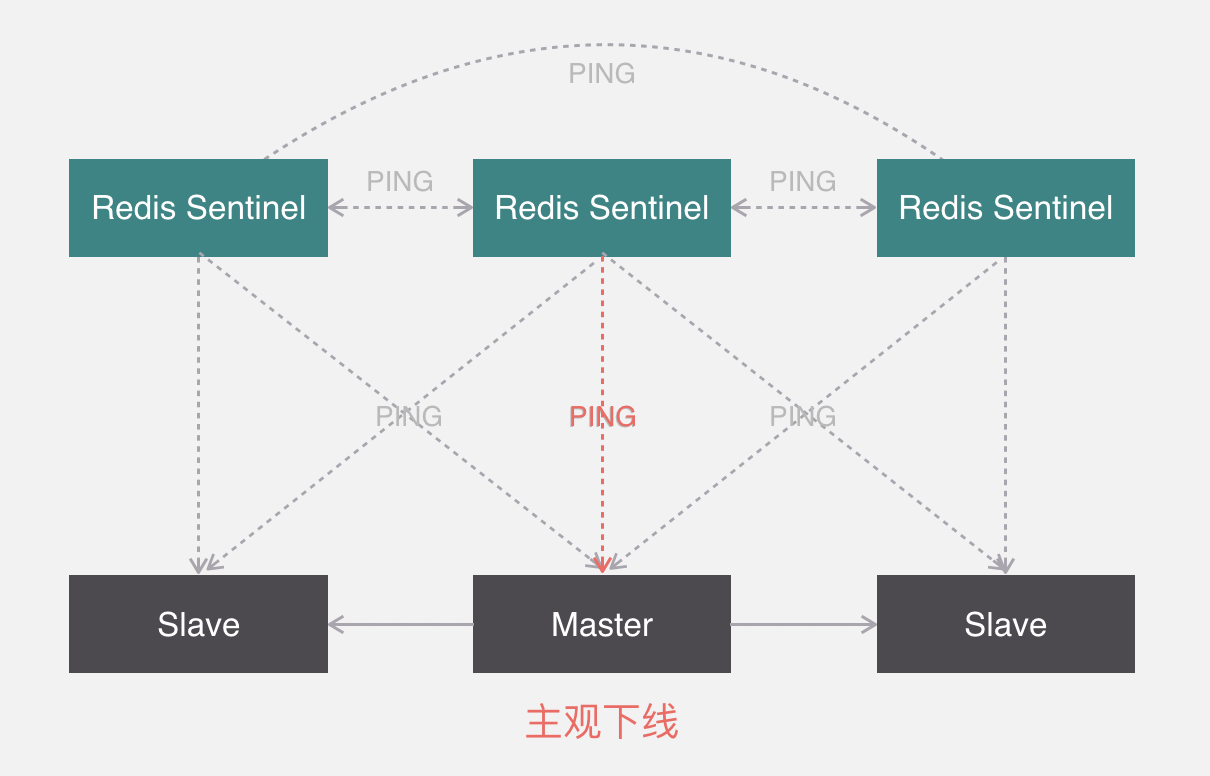

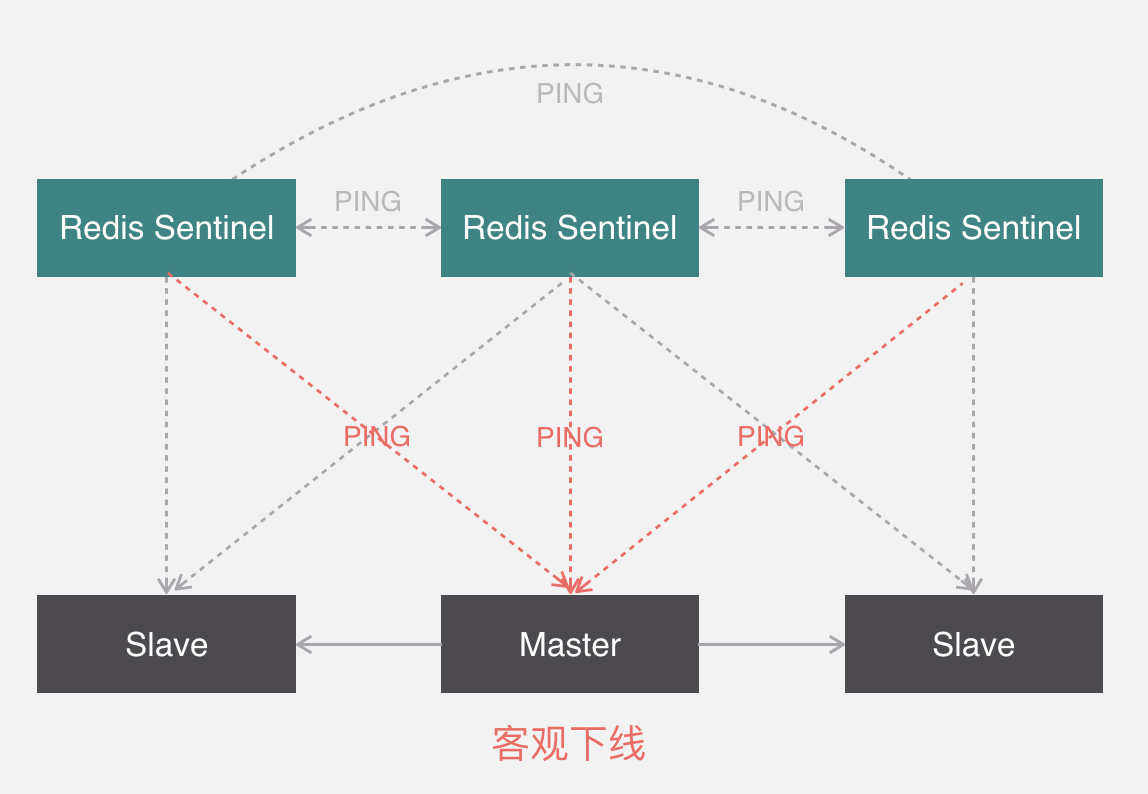

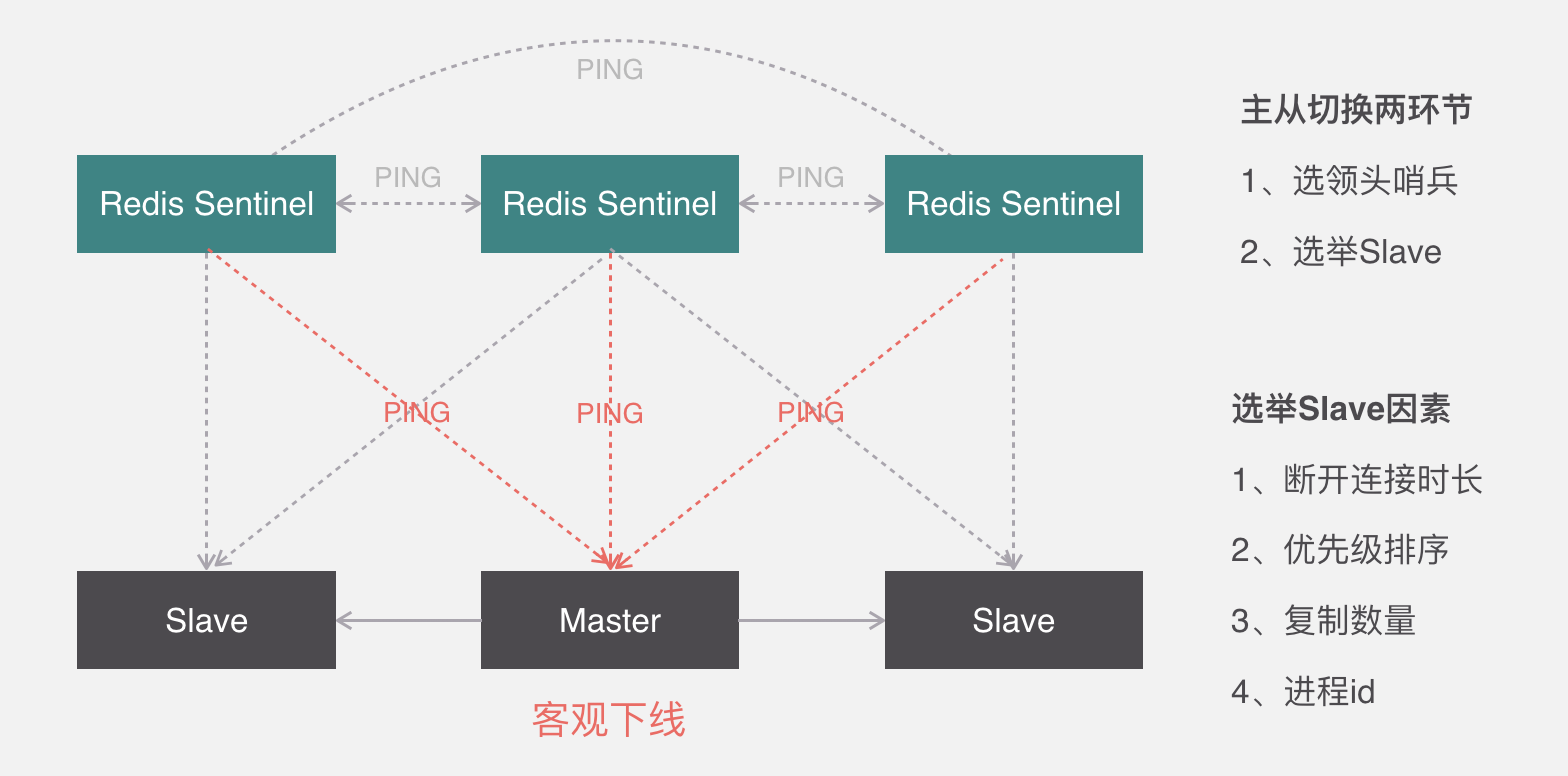

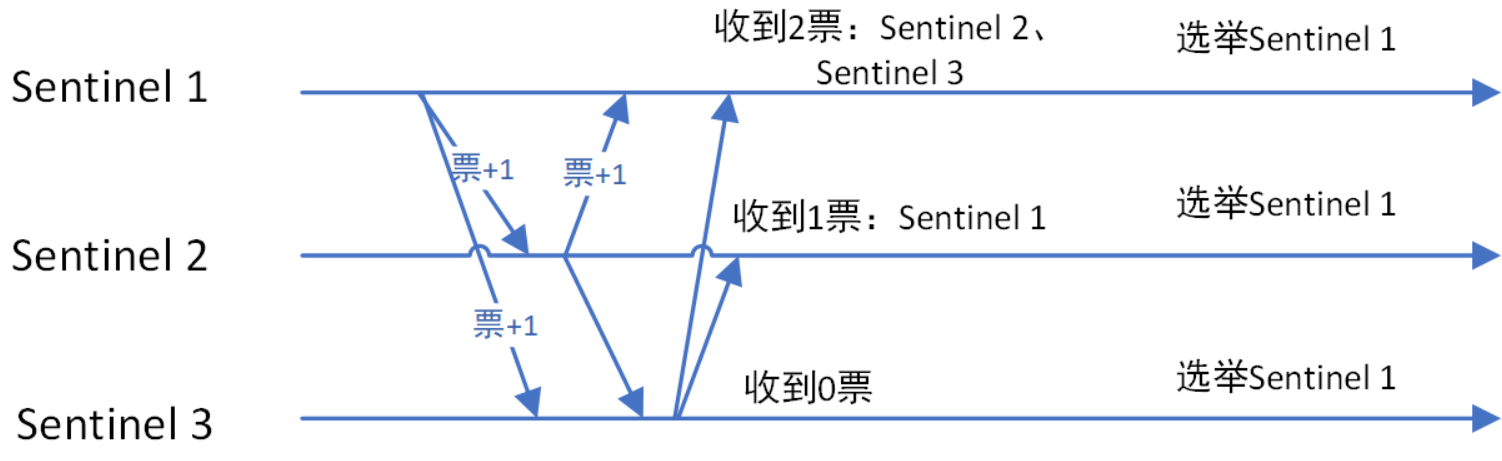

哨兵本身也有单点故障的问题,可以使用多个哨兵进行监控,哨兵不仅会监控redis集群,哨兵之间也会相互监控。每一个哨兵都是一个独立的进程,作为进程,它会独立运行。

Redis sentinel 是一个分布式系统中监控 redis 主从服务器,并在主服务器下线时自动进行故障转移。

Redis sentinel 其中三个特性:

- 监控(Monitoring):

Sentinel 会不断地检查你的主服务器和从服务器是否运作正常。

- 提醒(Notification):

当被监控的某个 Redis 服务器出现问题时, Sentinel 可以通过 API 向管理员或者其他应用程序发送通知。

- 自动故障迁移(Automatic failover):

当一个主服务器不能正常工作时, Sentinel 会开始一次自动故障迁移操作。

特点:

-

1、保证高可用

-

2、监控各个节点

-

3、自动故障迁移

缺点:

主从模式,切换需要时间丢数据

没有解决 master 写的压力

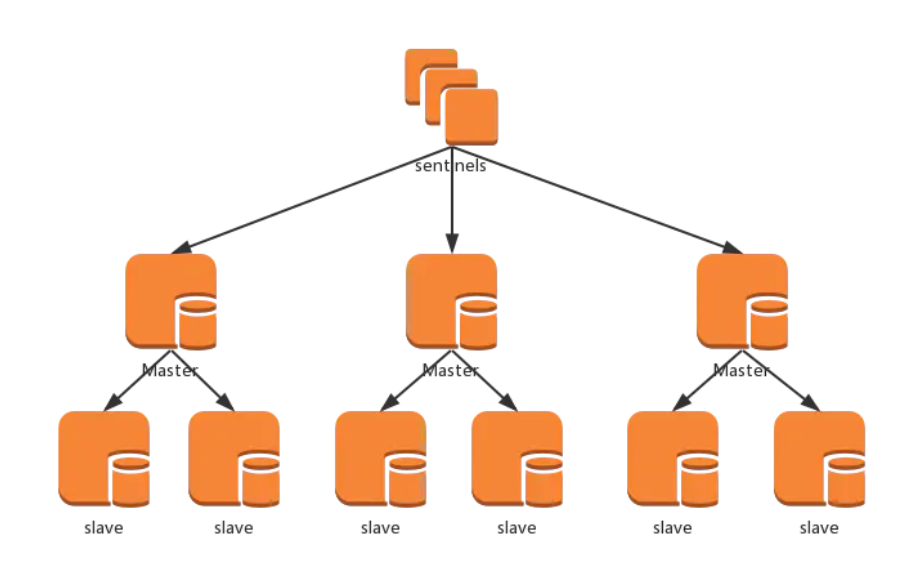

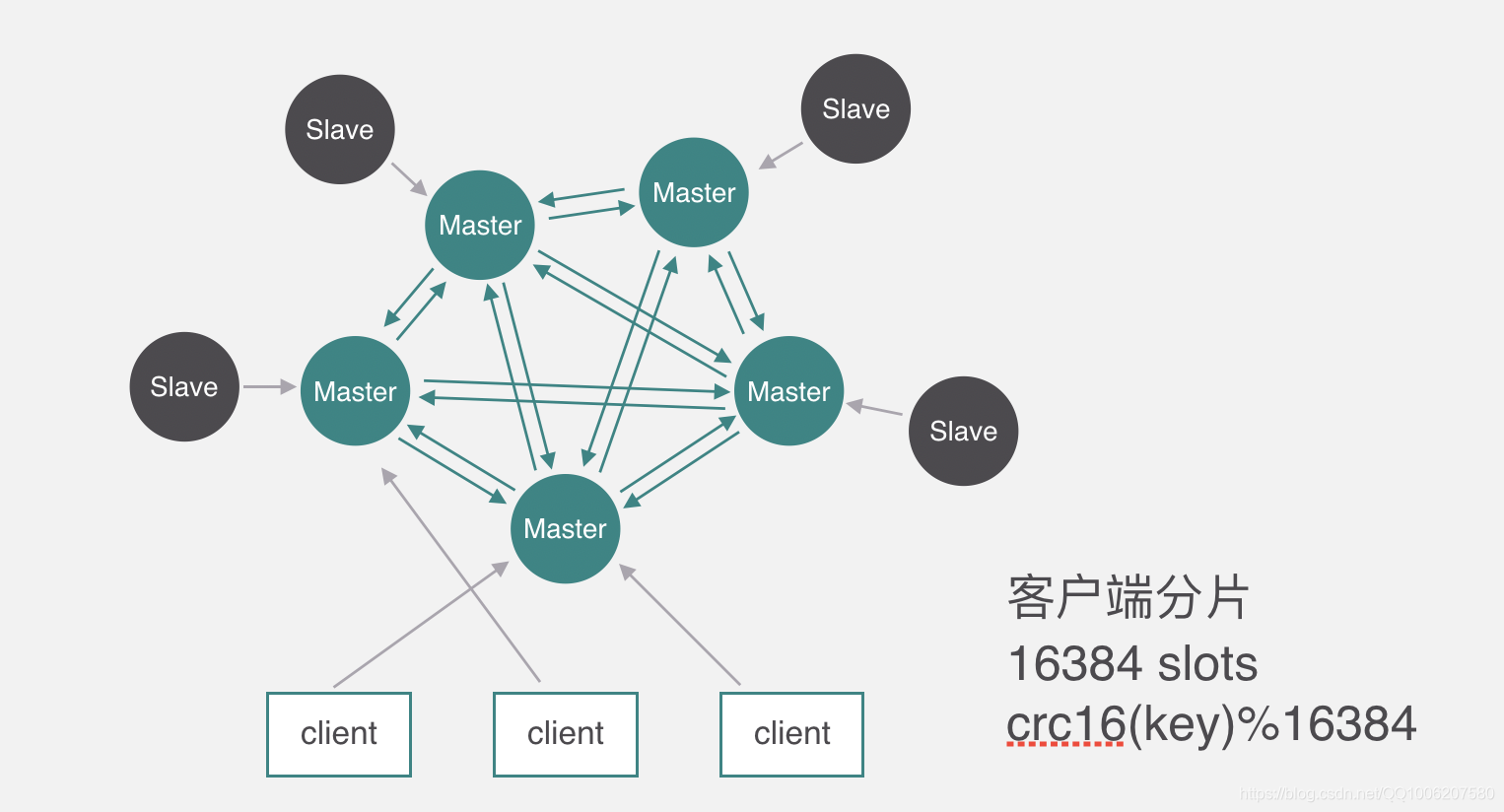

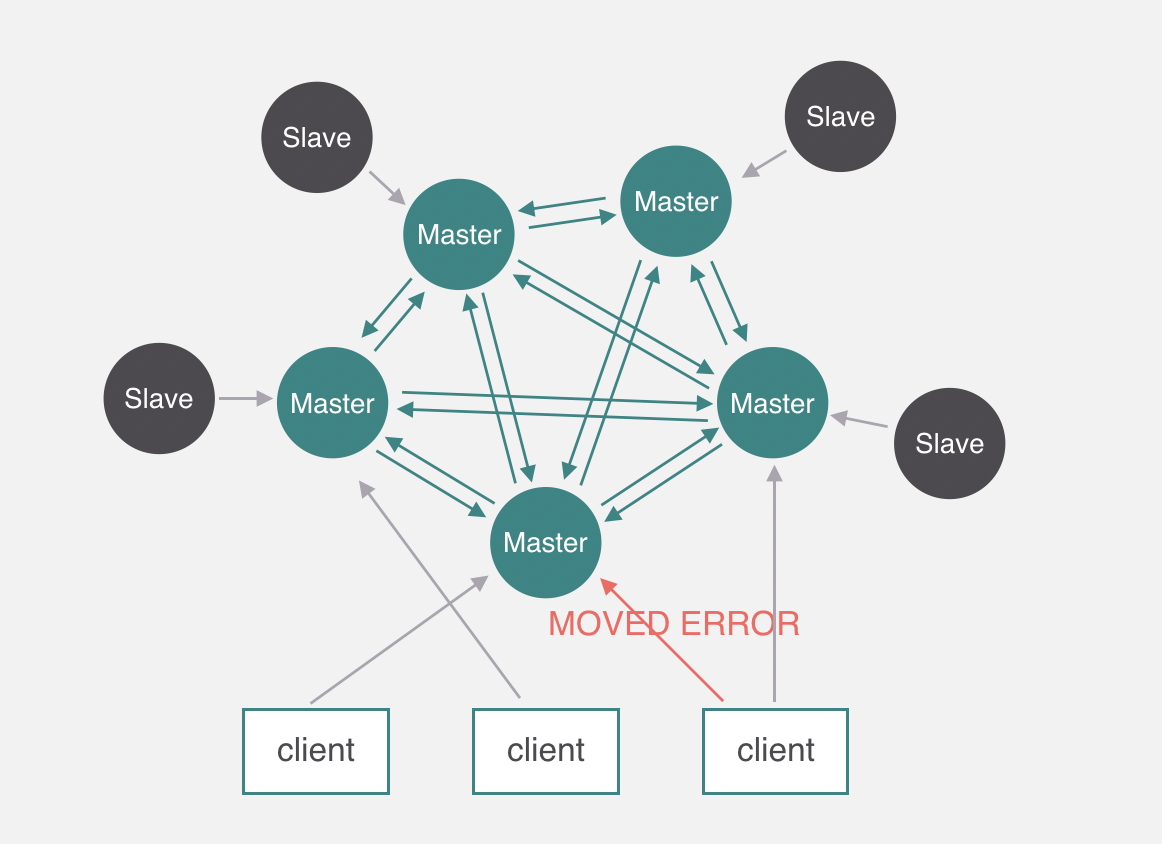

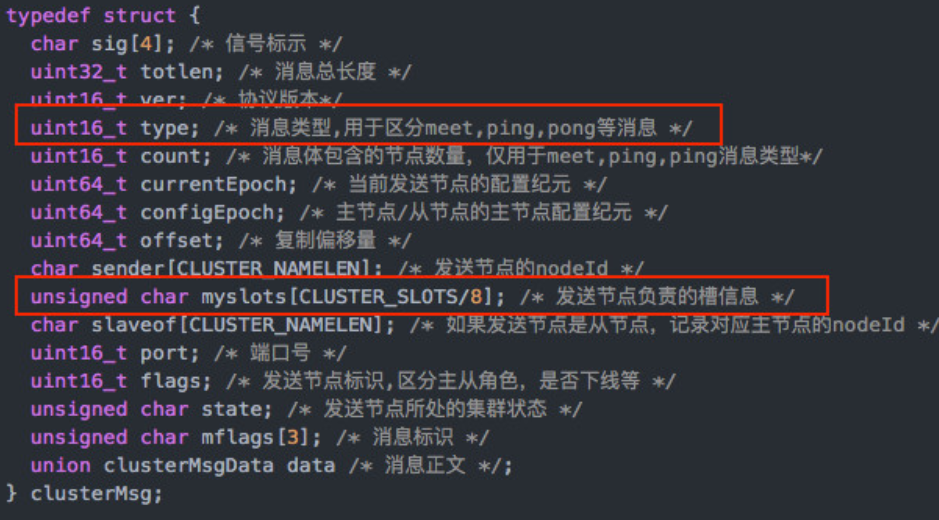

集群模式

集群模式方案主要包括以下几个:

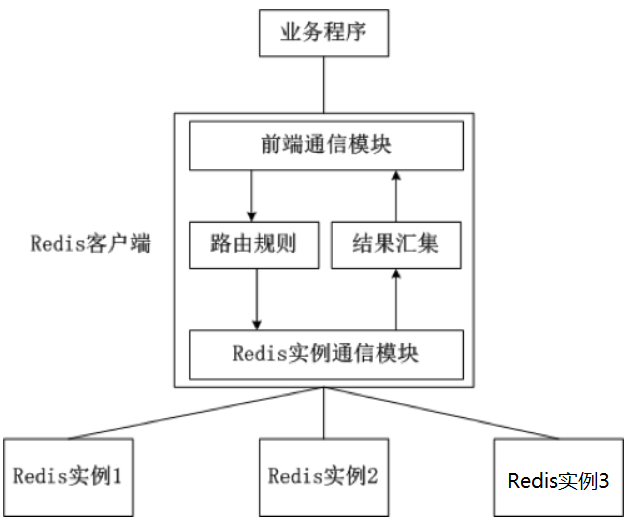

- 客户端分片

- 代理分片

- 服务端分片

- 代理模式和服务端分片相结合的模式

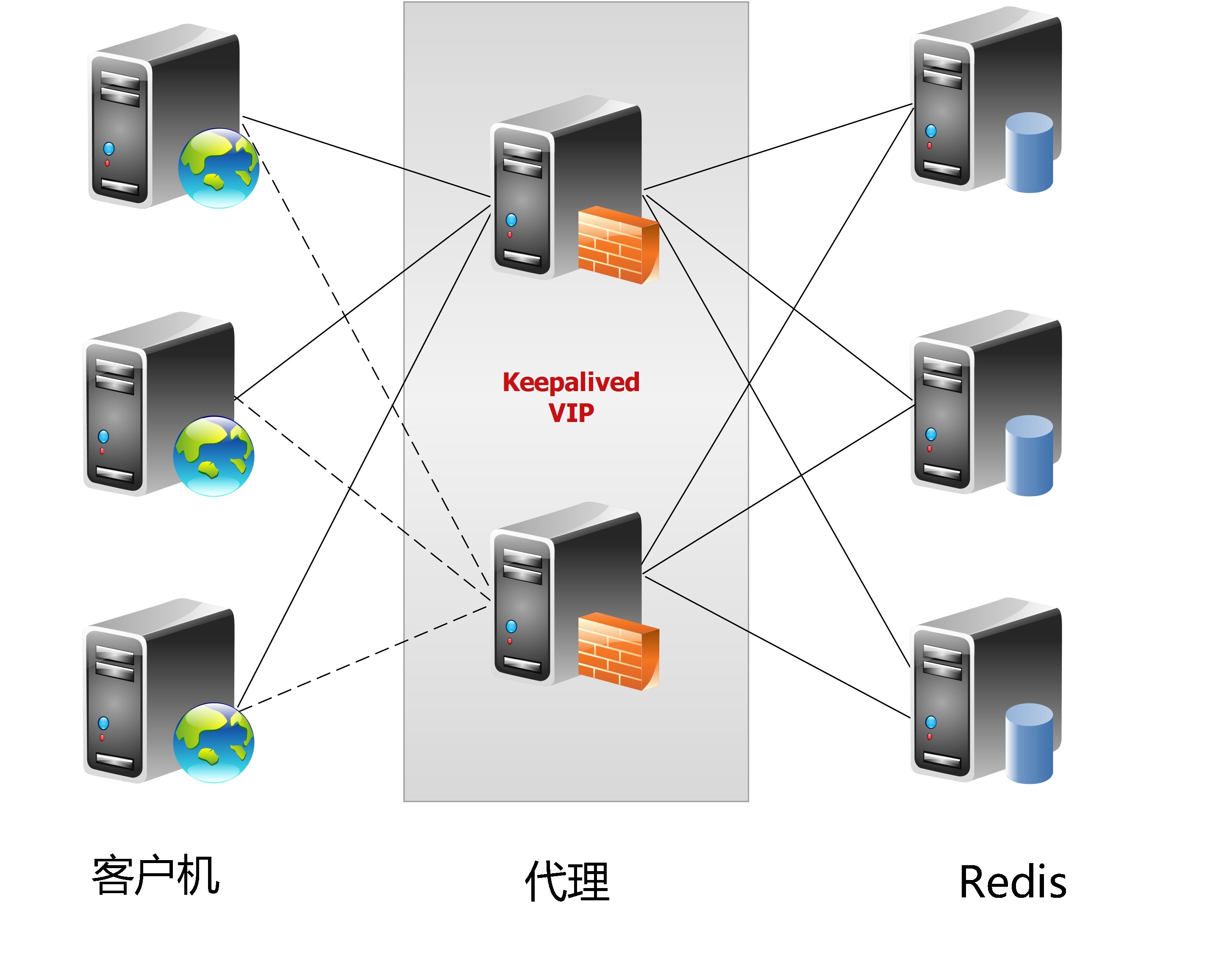

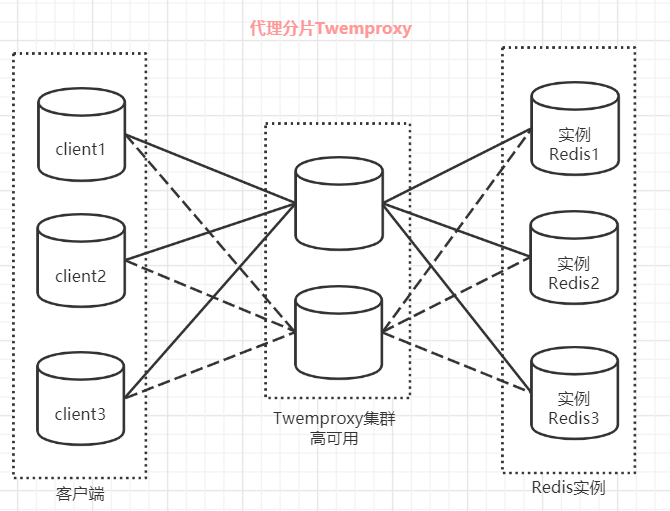

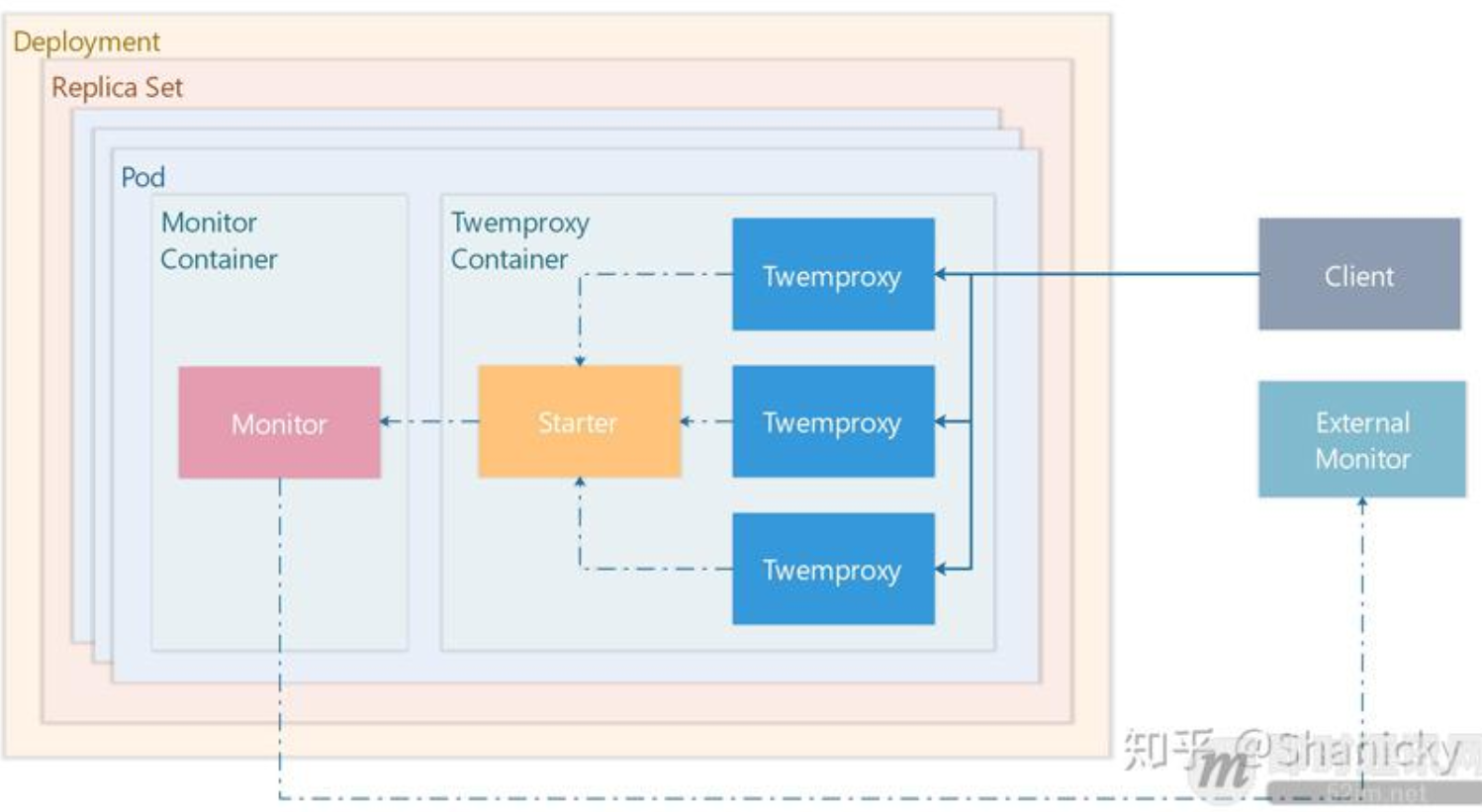

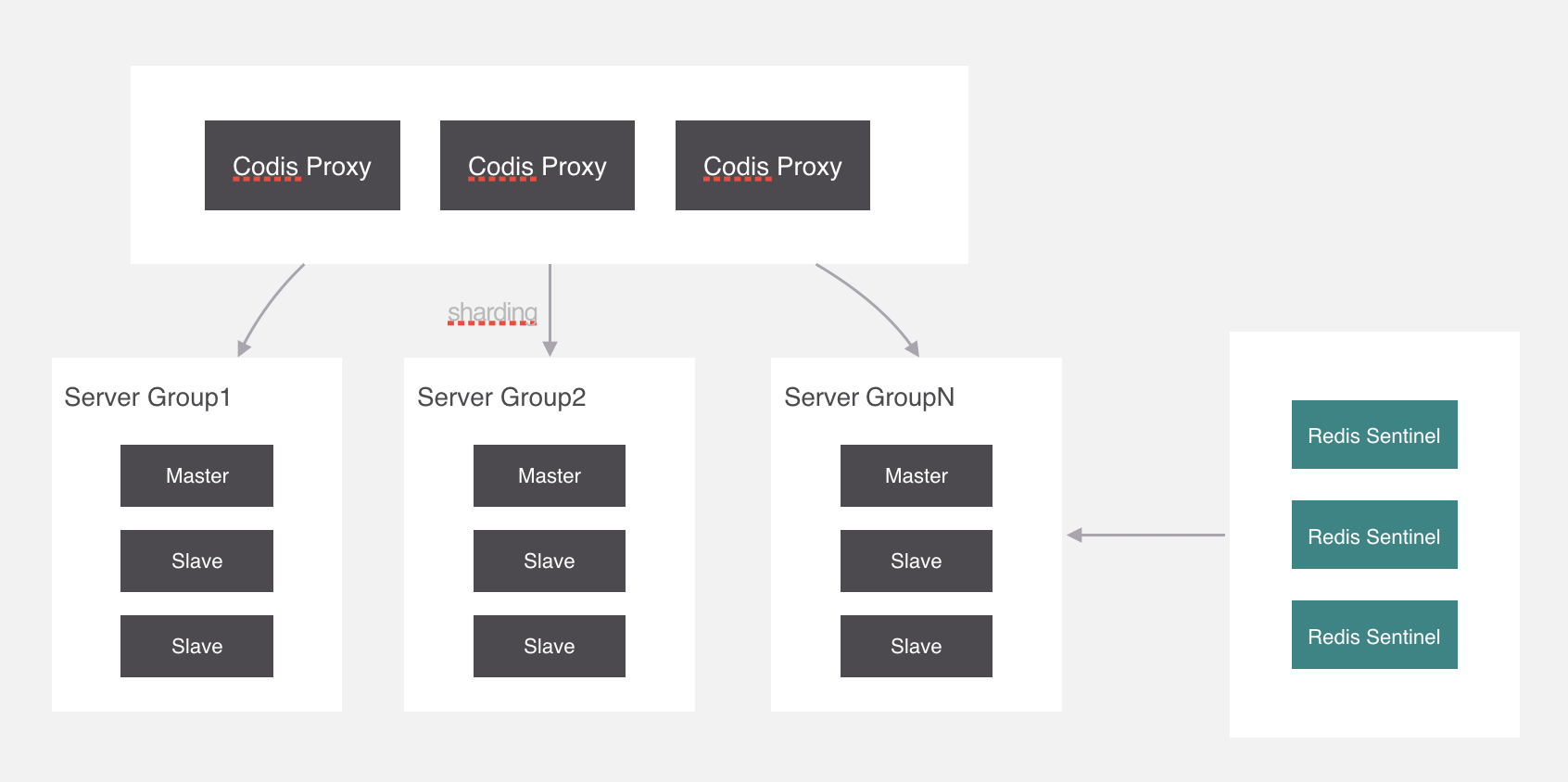

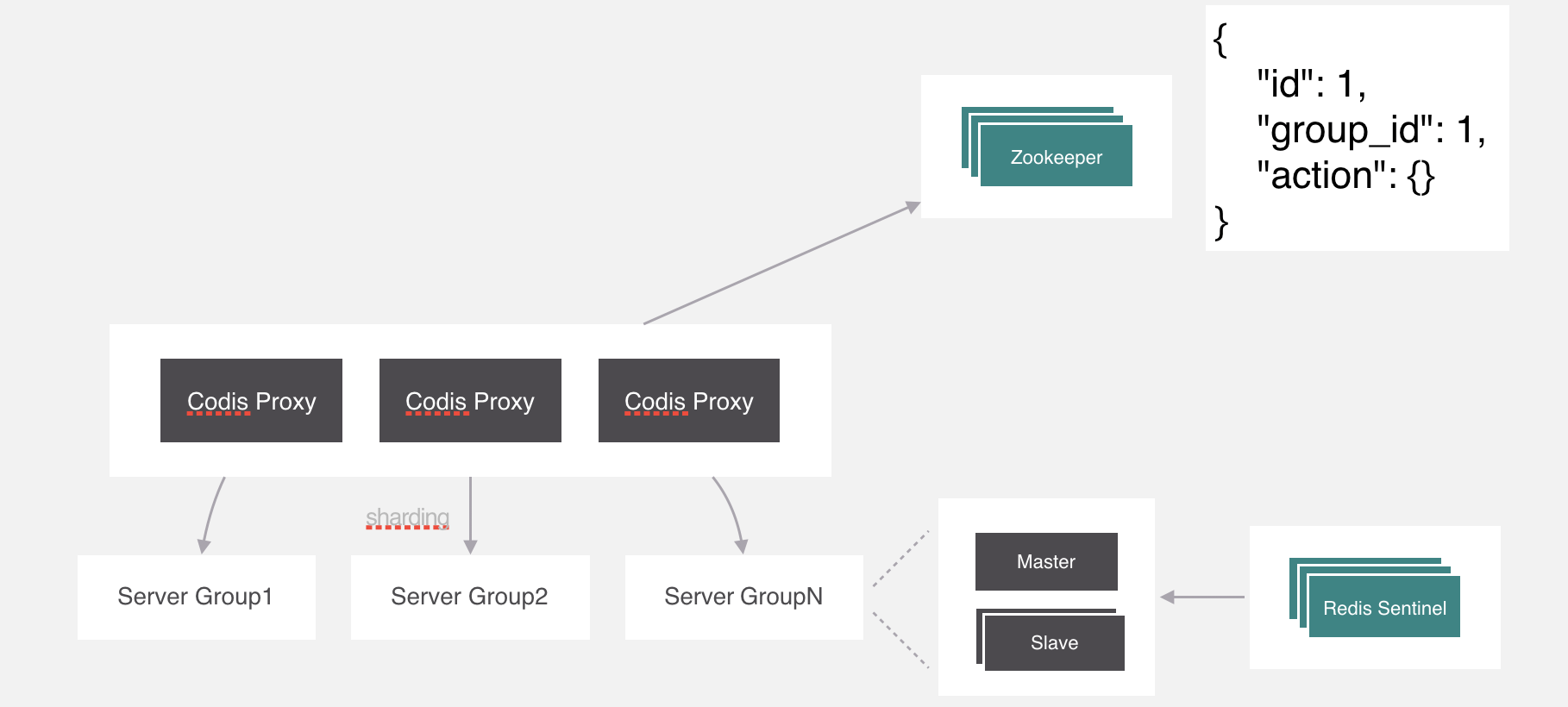

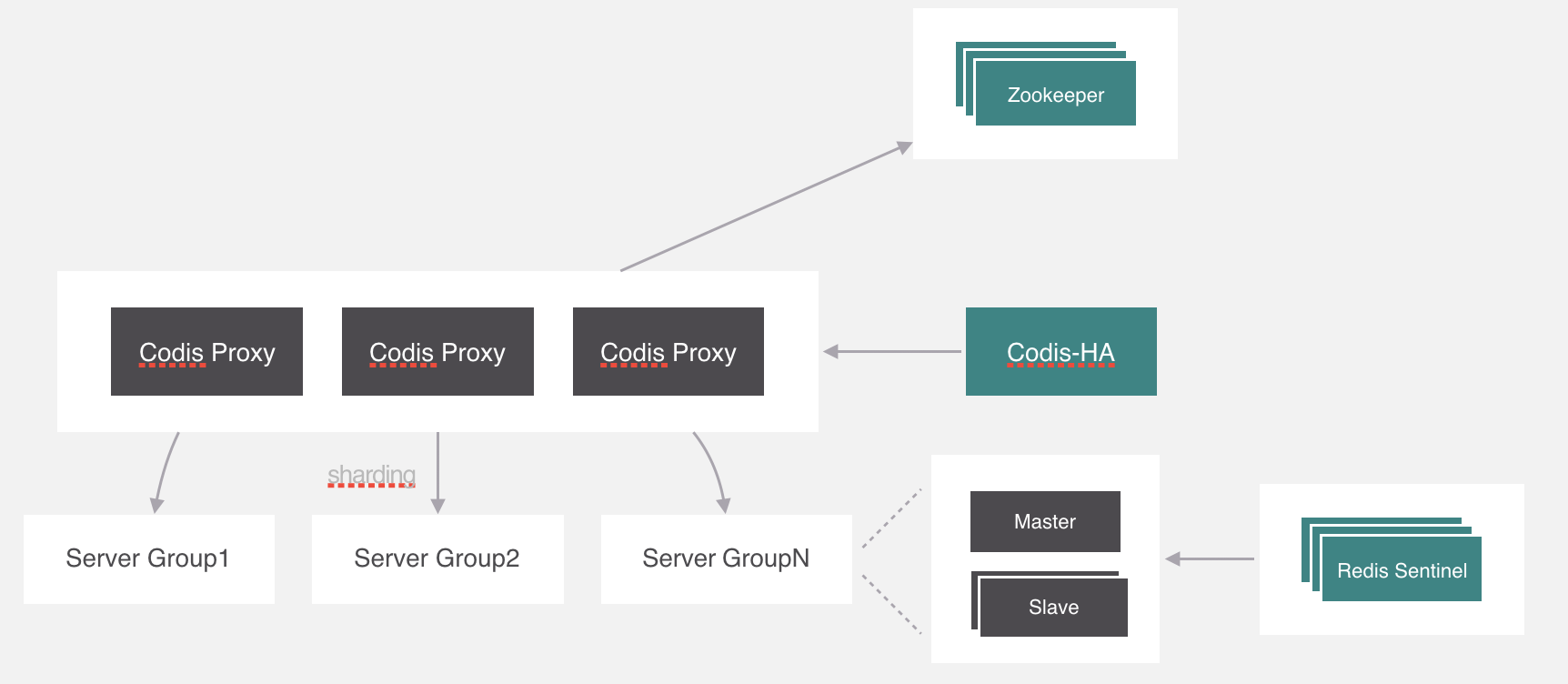

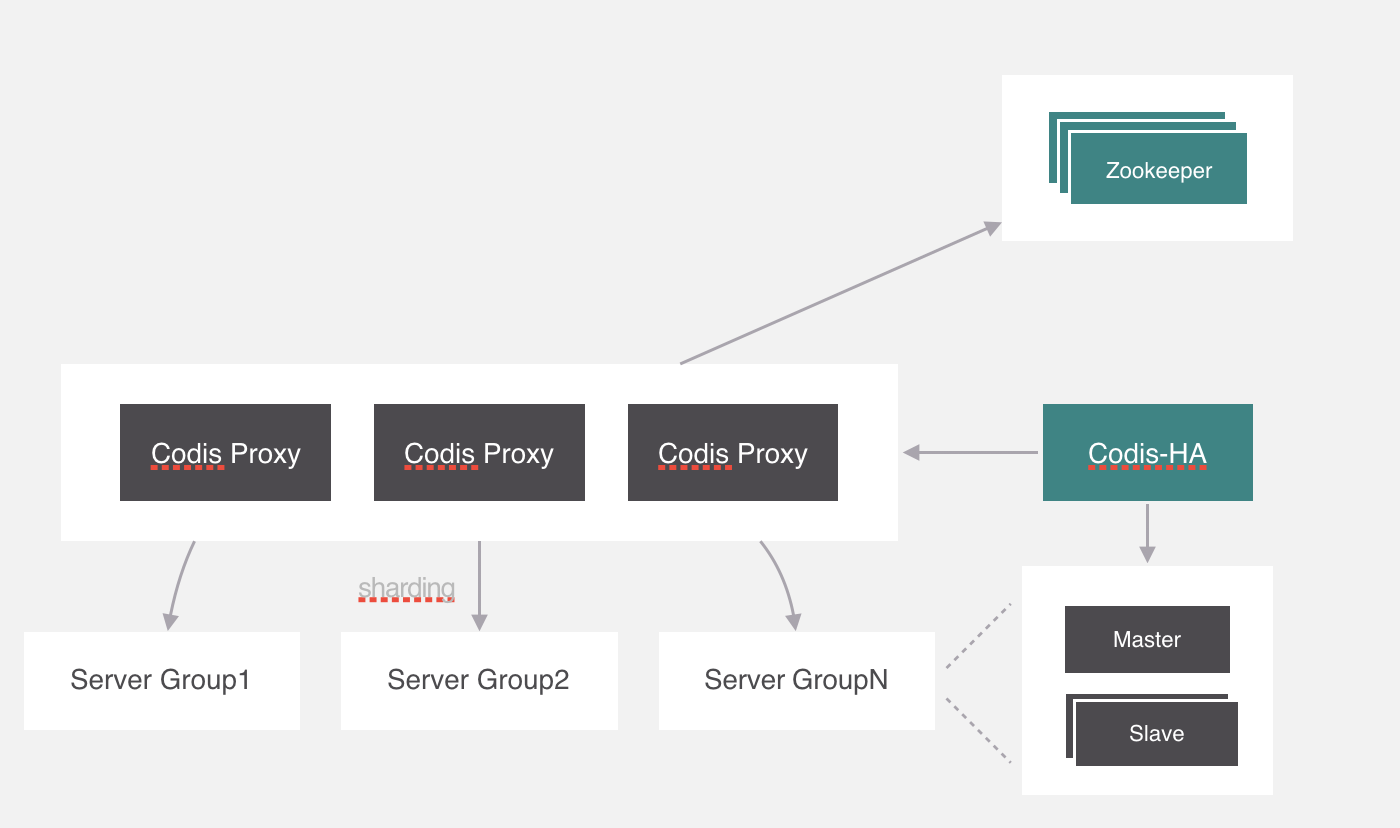

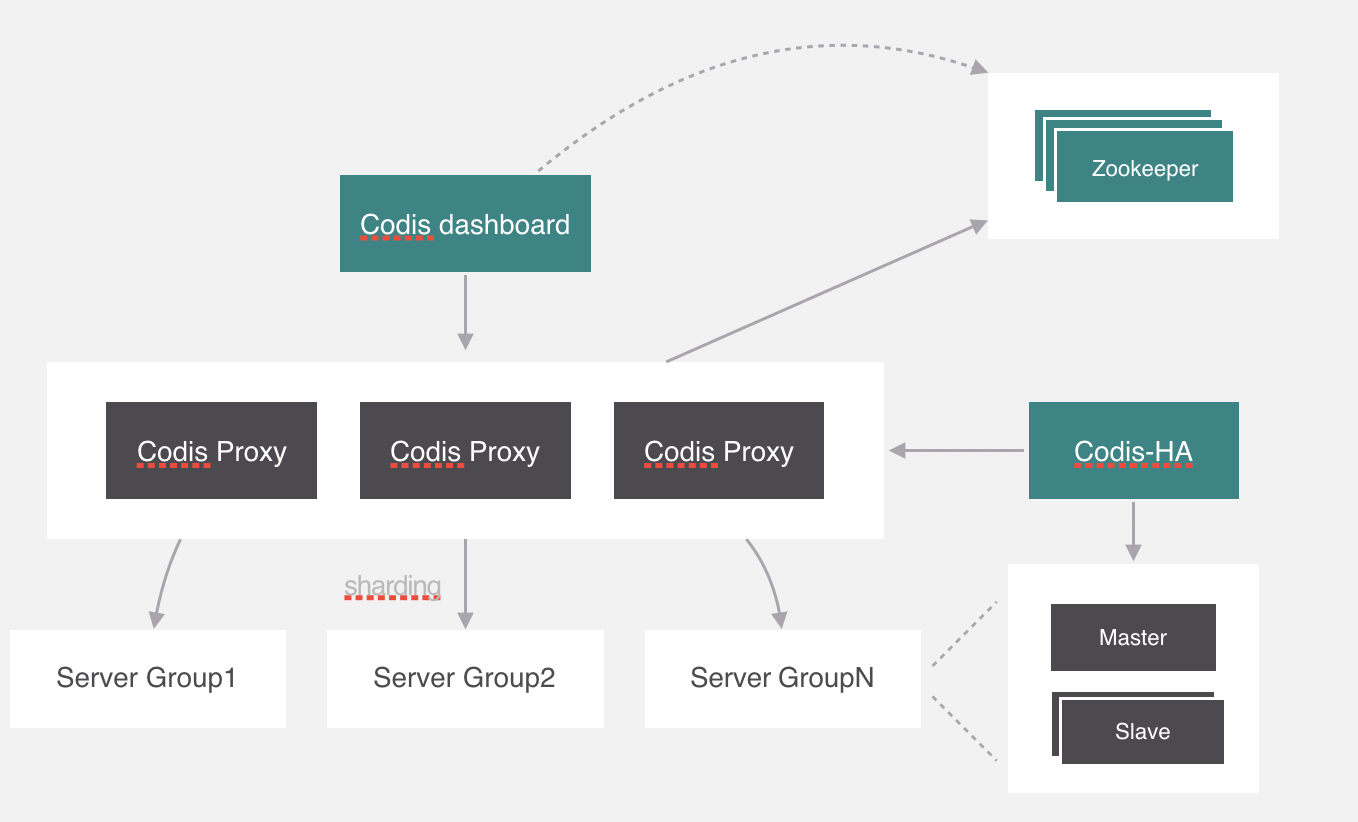

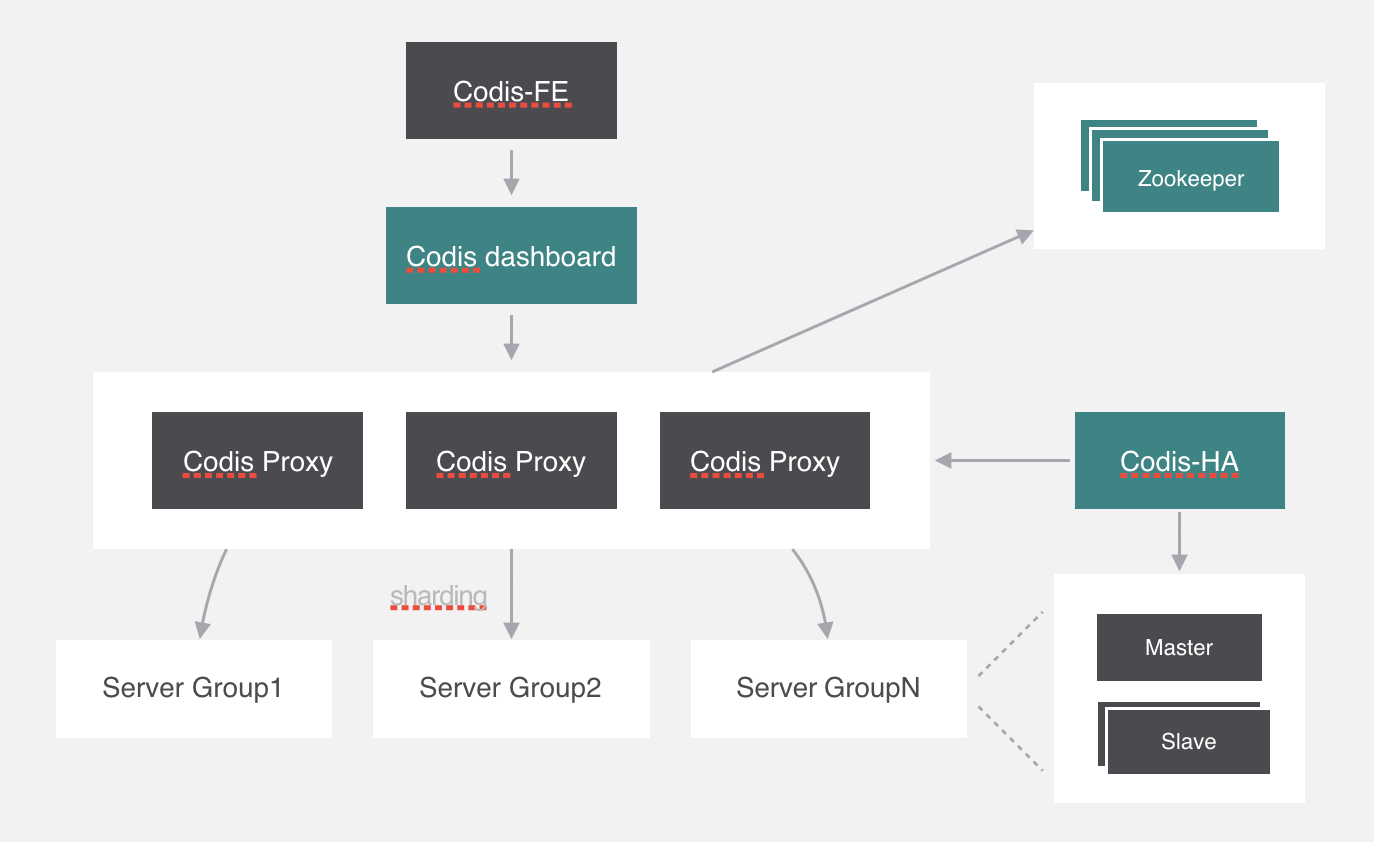

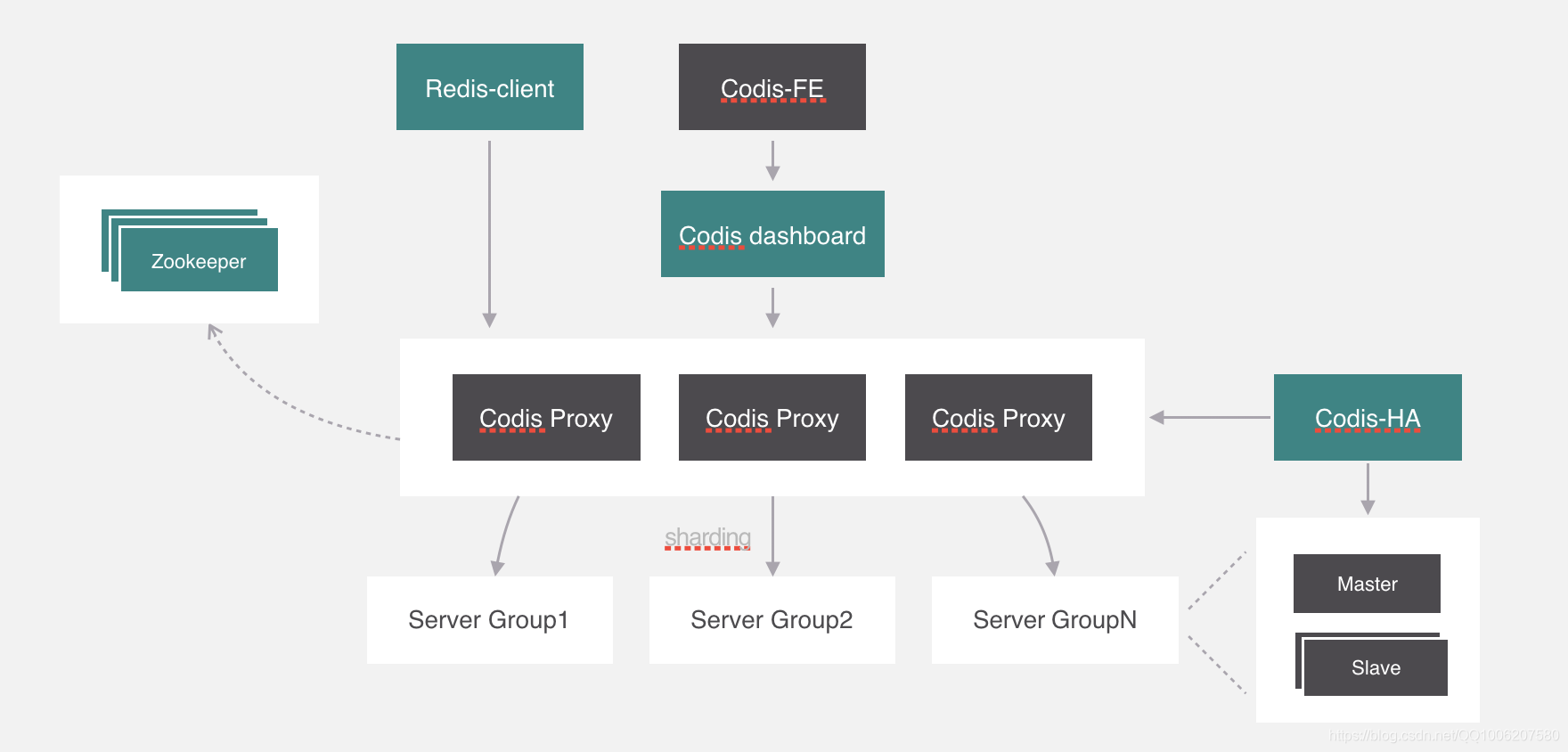

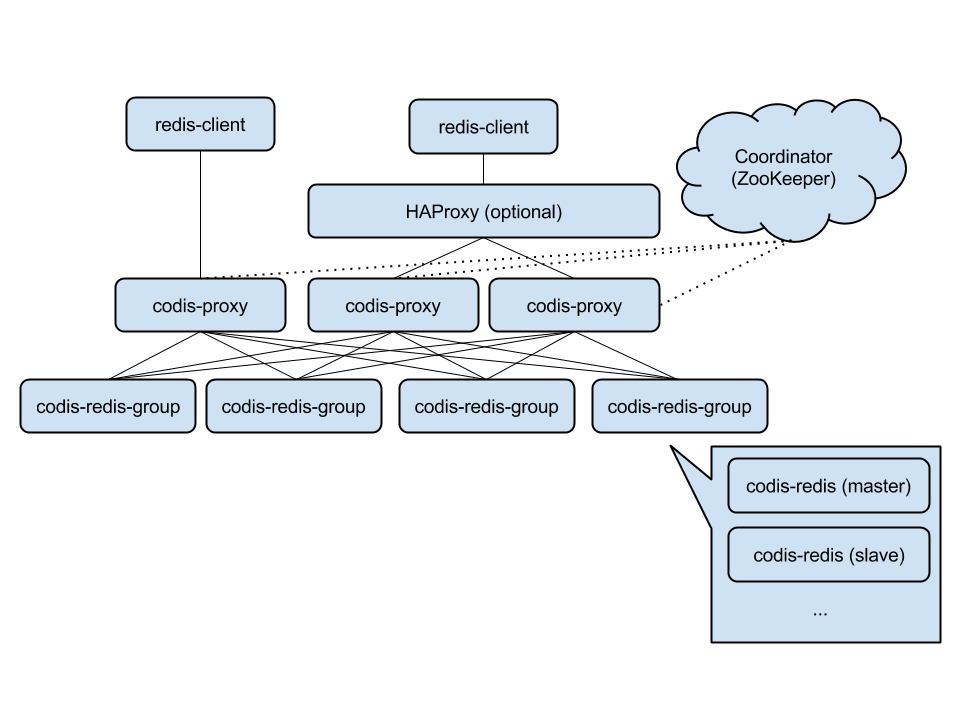

代理分片包括:

-

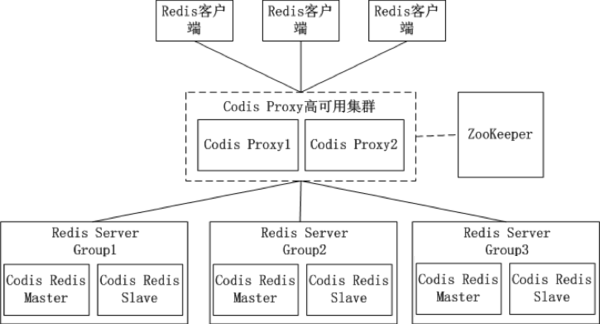

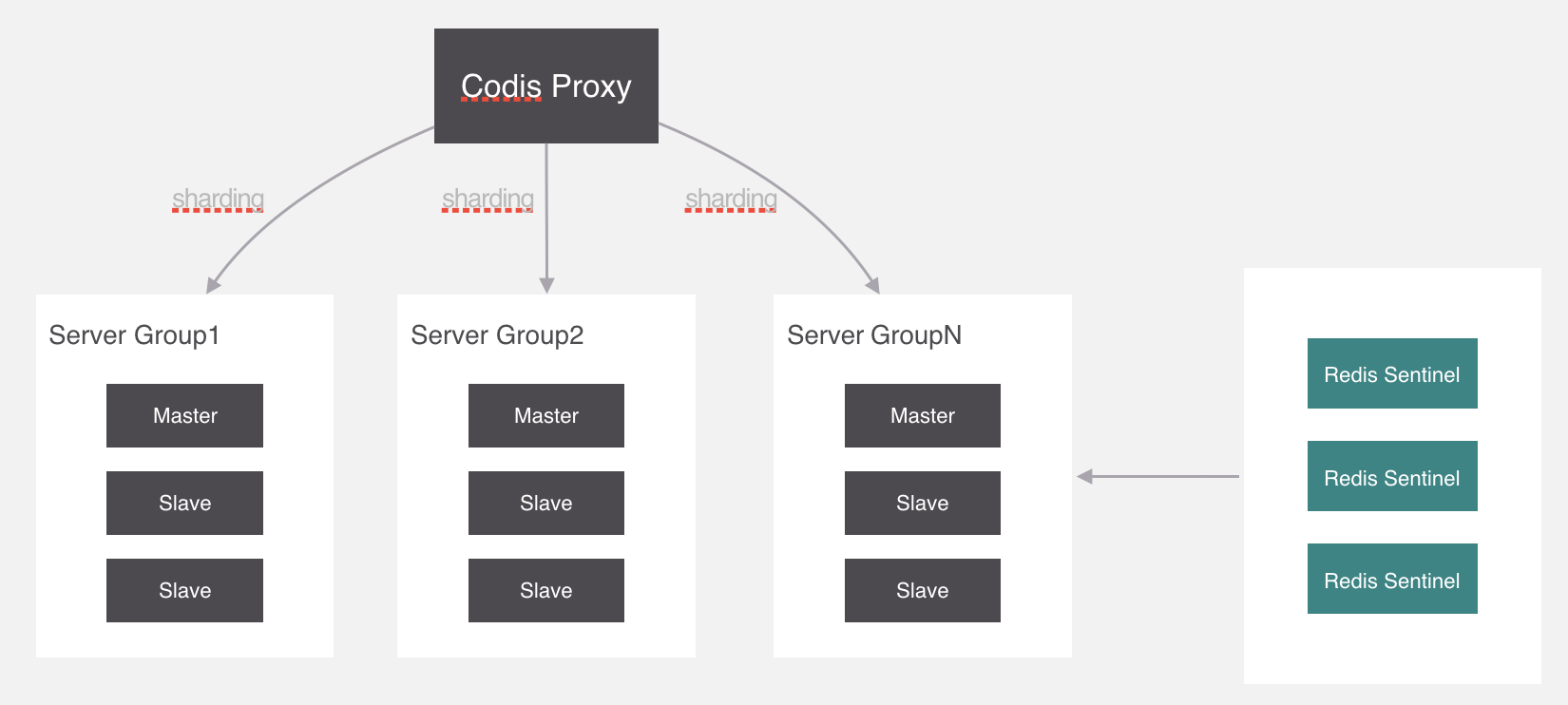

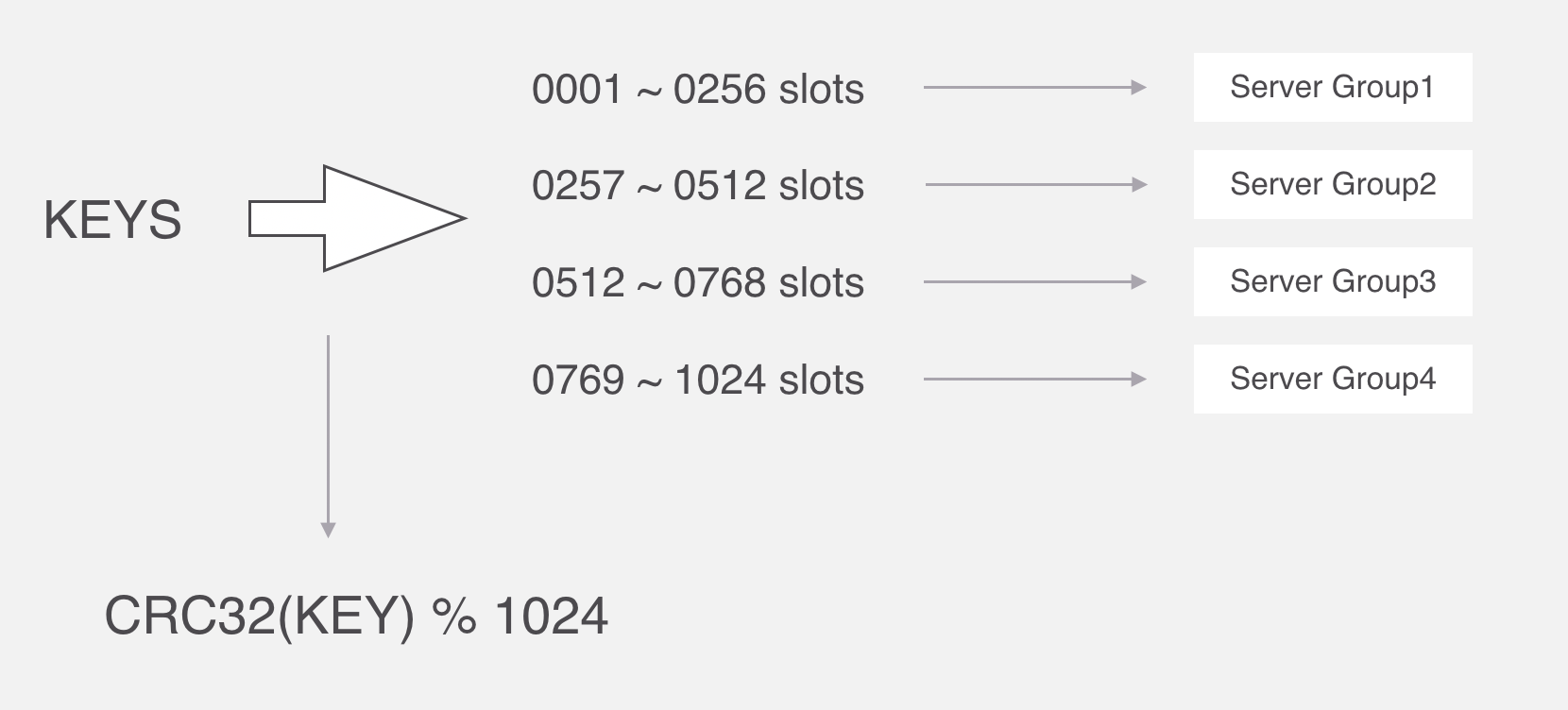

Codis

-

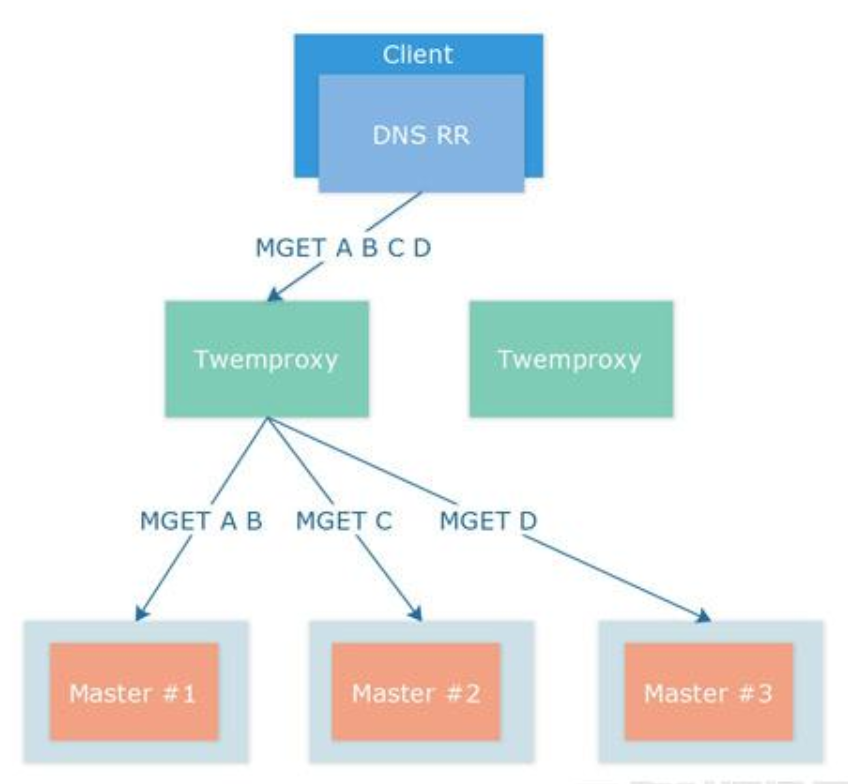

Twemproxy

服务端分片包括:

- Redis Cluster

它们还可以用是否中心化来划分,其中客户端分片、Redis Cluster属于无中心化的集群方案,Codis、Tweproxy属于中心化的集群方案。

是否中心化是指客户端访问多个Redis节点时,是直接访问还是通过一个中间层Proxy来进行操作,直接访问的就属于无中心化的方案,通过中间层Proxy访问的就属于中心化的方案,它们有各自的优劣,下面分别来介绍。

集群的必要性

所谓的集群,就是通过添加服务器的数量,提供相同的服务,从而让服务器达到一个稳定、高效的状态。

问题:我们已经部署好了redis,并且能启动一个redis,实现数据的读写,为什么还要学习redis集群?

答:

(1)单个redis存在不稳定性。当redis服务宕机了,就没有可用的服务了。

(2)单个redis的读写能力是有限的。

总结:redis集群是为了强化redis的读写能力。

如何学习redis集群

说明:

(1)redis集群中,每一个redis称之为一个节点。

(2)redis集群中,有两种类型的节点:主节点(master)、从节点(slave)。

(3)redis集群,是基于redis主从复制实现。

所以,学习redis集群,就是从学习redis主从模式开始的。

而学习主从模式,需要从redis主从复制开始。

redis主从复制

主从复制,是指将一台Redis服务器的数据,复制到其他的Redis服务器。前者称为主节点(master),后者称为从节点(slave);数据的复制是单向的,只能由主节点到从节点。

默认情况下,每台Redis服务器都是主节点;且一个主节点可以有多个从节点(或没有从节点),但一个从节点只能有一个主节点。

主从复制的使用场景

主从复制的作用

主从复制的作用主要包括:

- 数据冗余:主从复制实现了数据的热备份,是持久化之外的一种数据冗余方式。

- 故障恢复:当主节点出现问题时,可以由从节点提供服务,实现快速的故障恢复;实际上是一种服务的冗余。

- 负载均衡:在主从复制的基础上,配合读写分离,可以由主节点提供写服务,由从节点提供读服务(即写Redis数据时应用连接主节点,读Redis数据时应用连接从节点),分担服务器负载;尤其是在写少读多的场景下,通过多个从节点分担读负载,可以大大提高Redis服务器的并发量。

- 高可用基石:除了上述作用以外,主从复制还是哨兵和集群能够实施的基础,因此说主从复制是Redis高可用的基础。

主从(master-slave)架构涉及到主从复制

单机的 redis,能够承载的 QPS 大概就在上万到几万不等。对于缓存来说,一般都是用来支撑读高并发的。

因此架构做成主从(master-slave)架构,一主多从,主负责写,并且将数据复制到其它的 slave 节点,从节点负责读。所有的读请求全部走从节点。这样也可以很轻松实现水平扩容,支撑读高并发。

为了更直观的理解主从复制,在介绍其内部原理之前,先说明我们需要如何操作才能开启主从复制。

建立复制

需要注意,主从复制的开启,完全是在从节点发起的;不需要我们在主节点做任何事情。

从节点开启主从复制,有3种方式:

(1)配置文件

在从服务器的配置文件中加入:slaveof

(2)启动命令

redis-server启动命令后加入 --slaveof

(3)客户端命令

Redis服务器启动后,直接通过客户端执行命令:slaveof

上述3种方式是等效的,下面以客户端命令的方式为例,看一下当执行了slaveof后,Redis主节点和从节点的变化。

主从复制实例

准备工作:启动两个节点

方便起见,实验所使用的主从节点是在一台机器上的不同Redis实例,其中主节点监听6379端口,从节点监听6380端口;从节点监听的端口号可以在配置文件中修改:

启动后可以看到:

两个Redis节点启动后(分别称为6379节点和6380节点),默认都是主节点。

建立复制关系

此时在6380节点执行slaveof命令,使之变为从节点:

观察效果

下面验证一下,在主从复制建立后,主节点的数据会复制到从节点中。

(1)首先在从节点查询一个不存在的key:

(2)然后在主节点中增加这个key:

(3)此时在从节点中再次查询这个key,会发现主节点的操作已经同步至从节点:

(4)然后在主节点删除这个key:

(5)此时在从节点中再次查询这个key,会发现主节点的操作已经同步至从节点:

断开复制

通过slaveof

从节点执行slaveof no one后,打印日志如下所示;可以看出断开复制后,从节点又变回为主节点。

主节点打印日志如下:

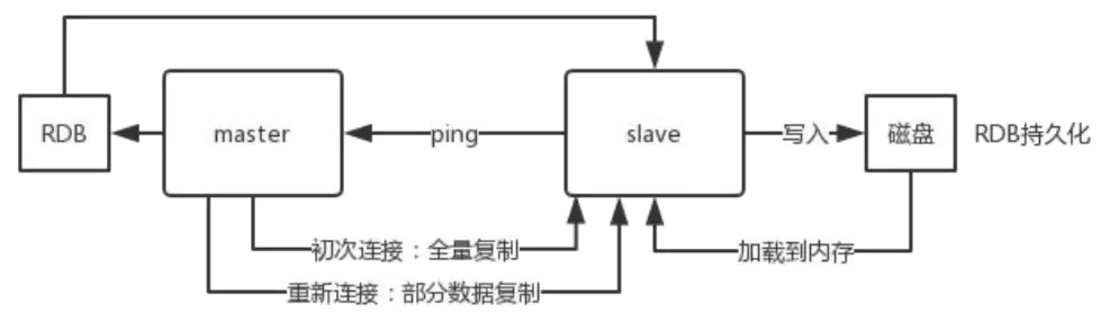

核心原理: 主从复制的核心原理

上面一节中,介绍了如何操作可以建立主从关系;本小节将介绍主从复制的实现原理。

1 当启动一个 slave node 的时候,它会发送一个 PSYNC 命令给 master node。

2 如果这是 slave node 初次连接到 master node,那么会触发一次 full resynchronization 全量复制。

此时 master 会启动一个后台线程,开始生成一份 RDB 快照文件,同时还会将从客户端 client 新收到的所有写命令缓存在内存中。RDB 文件生成完毕后, master 会将这个 RDB 发送给 slave,

slave接收到RDB , 会先写入本地磁盘,然后再从本地磁盘加载到内存中,

3 接着 master 会将内存中缓存的写命令发送到 slave,slave 也会同步这些数据。

如果slave node跟 master node 有网络故障,断开了连接,会自动重连,连接之后 master node 仅会复制给 slave 部分缺少的数据。

主从复制过程大体可以分为3个阶段:

- 连接建立阶段(即准备阶段)

- 数据同步阶段

- 命令传播阶段;

下面分别进行介绍。

连接建立阶段

该阶段的主要作用是在主从节点之间建立连接,为数据同步做好准备。

步骤1:保存主节点信息

从节点服务器内部维护了两个字段,即masterhost和masterport字段,用于存储主节点的ip和port信息。

需要注意的是,slaveof是异步命令,从节点完成主节点ip和port的保存后,向发送slaveof命令的客户端直接返回OK,实际的复制操作在这之后才开始进行。

这个过程中,可以看到从节点打印日志如下:

步骤2:建立socket连接

从节点每秒1次调用复制定时函数replicationCron(),如果发现了有主节点可以连接,便会根据主节点的ip和port,创建socket连接。

如果连接成功,则:

- 从节点:

为该socket建立一个专门处理复制工作的文件事件处理器,负责后续的复制工作,如接收RDB文件、接收命令传播等。

- 主节点:

接收到从节点的socket连接后(即accept之后),为该socket创建相应的客户端状态,并将从节点看做是连接到主节点的一个客户端,后面的步骤会以从节点向主节点发送命令请求的形式来进行。

这个过程中,从节点打印日志如下:

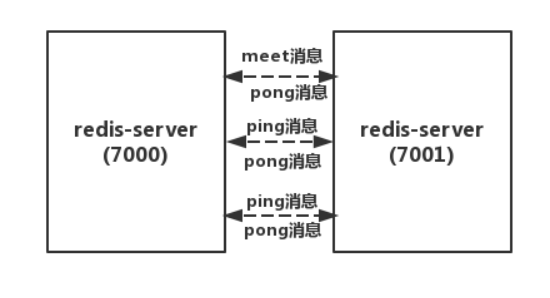

步骤3:发送ping命令

从节点成为主节点的客户端之后,发送ping命令进行首次请求,目的是:检查socket连接是否可用,以及主节点当前是否能够处理请求。

从节点发送ping命令后,可能出现3种情况:

(1)返回pong:说明socket连接正常,且主节点当前可以处理请求,复制过程继续。

(2)超时:一定时间后从节点仍未收到主节点的回复,说明socket连接不可用,则从节点断开socket连接,并重连。

(3)返回pong以外的结果:如果主节点返回其他结果,如正在处理超时运行的脚本,说明主节点当前无法处理命令,则从节点断开socket连接,并重连。

在主节点返回pong情况下,从节点打印日志如下:

步骤4:身份验证

如果从节点中设置了masterauth选项,则从节点需要向主节点进行身份验证;没有设置该选项,则不需要验证。从节点进行身份验证是通过向主节点发送auth命令进行的,auth命令的参数即为配置文件中的masterauth的值。

如果主节点设置密码的状态,与从节点masterauth的状态一致(一致是指都存在,且密码相同,或者都不存在),则身份验证通过,复制过程继续;如果不一致,则从节点断开socket连接,并重连。

步骤5:发送从节点端口信息

身份验证之后,从节点会向主节点发送其监听的端口号(前述例子中为6380),主节点将该信息保存到该从节点对应的客户端的slave_listening_port字段中;该端口信息除了在主节点中执行info Replication时显示以外,没有其他作用。

数据同步阶段

主从节点之间的连接建立以后,便可以开始进行数据同步,该阶段可以理解为从节点数据的初始化。

具体执行的方式是:从节点向主节点发送psync命令(Redis2.8以前是sync命令),开始同步。

数据同步阶段是主从复制最核心的阶段,根据主从节点当前状态的不同,可以分为全量复制和部分复制。

在Redis2.8以前,从节点向主节点发送sync命令请求同步数据,此时的同步方式是全量复制;

在Redis2.8及以后,从节点可以发送psync命令请求同步数据,此时根据主从节点当前状态的不同,同步方式可能是全量复制或部分复制。后文介绍以Redis2.8及以后版本为例。

- 全量复制:用于初次复制或其他无法进行部分复制的情况,将主节点中的所有数据都发送给从节点,是一个非常重型的操作。

- 部分复制:用于网络中断等情况后的复制,只将中断期间主节点执行的写命令发送给从节点,与全量复制相比更加高效。需要注意的是,如果网络中断时间过长,导致主节点没有能够完整地保存中断期间执行的写命令,则无法进行部分复制,仍使用全量复制。

全量复制

Redis通过psync命令进行全量复制的过程如下:

(1)从节点判断无法进行部分复制,向主节点发送全量复制的请求;或从节点发送部分复制的请求,但主节点判断无法进行部分复制;具体判断过程需要在讲述了部分复制原理后再介绍。

(2)主节点收到全量复制的命令后,执行bgsave,在后台生成RDB文件,并使用一个缓冲区(称为复制缓冲区)记录从现在开始执行的所有写命令

(3)主节点的bgsave执行完成后,将RDB文件发送给从节点;从节点首先清除自己的旧数据,然后载入接收的RDB文件,将数据库状态更新至主节点执行bgsave时的数据库状态

(4)主节点将前述复制缓冲区中的所有写命令发送给从节点,从节点执行这些写命令,将数据库状态更新至主节点的最新状态

(5)如果从节点开启了AOF,则会触发bgrewriteaof的执行,从而保证AOF文件更新至主节点的最新状态

下面是执行全量复制时,主从节点打印的日志;可以看出日志内容与上述步骤是完全对应的。

主节点的打印日志如下:

从节点打印日志如下图所示:

其中,有几点需要注意:从节点接收了来自主节点的89260个字节的数据;从节点在载入主节点的数据之前要先将老数据清除;从节点在同步完数据后,调用了bgrewriteaof。

通过全量复制的过程可以看出,全量复制是非常重型的操作:

(1)主节点通过bgsave命令fork子进程进行RDB持久化,该过程是非常消耗CPU、内存(页表复制)、硬盘IO的;

(2)主节点通过网络将RDB文件发送给从节点,对主从节点的带宽都会带来很大的消耗

(3)从节点清空老数据、载入新RDB文件的过程是阻塞的,无法响应客户端的命令;如果从节点执行bgrewriteaof,也会带来额外的消耗

部分复制

由于全量复制在主节点数据量较大时效率太低,因此Redis2.8开始提供部分复制,用于处理网络中断时的数据同步。

部分复制的实现,依赖于三个重要的概念:

(1)复制偏移量

主节点和从节点分别维护一个复制偏移量(offset),代表的是主节点向从节点传递的字节数;主节点每次向从节点传播N个字节数据时,主节点的offset增加N;从节点每次收到主节点传来的N个字节数据时,从节点的offset增加N。

offset用于判断主从节点的数据库状态是否一致:如果二者offset相同,则一致;如果offset不同,则不一致,此时可以根据两个offset找出从节点缺少的那部分数据。例如,如果主节点的offset是1000,而从节点的offset是500,那么部分复制就需要将offset为501-1000的数据传递给从节点。而offset为501-1000的数据存储的位置,就是下面要介绍的复制积压缓冲区。

(2)复制积压缓冲区

复制积压缓冲区是由主节点维护的、固定长度的、先进先出(FIFO)队列,默认大小1MB;当主节点开始有从节点时创建,其作用是备份主节点最近发送给从节点的数据。注意,无论主节点有一个还是多个从节点,都只需要一个复制积压缓冲区。

在命令传播阶段,主节点除了将写命令发送给从节点,还会发送一份给复制积压缓冲区,作为写命令的备份;除了存储写命令,复制积压缓冲区中还存储了其中的每个字节对应的复制偏移量(offset)。由于复制积压缓冲区定长且是先进先出,所以它保存的是主节点最近执行的写命令;时间较早的写命令会被挤出缓冲区。

由于该缓冲区长度固定且有限,因此可以备份的写命令也有限,当主从节点offset的差距过大超过缓冲区长度时,将无法执行部分复制,只能执行全量复制。反过来说,为了提高网络中断时部分复制执行的概率,可以根据需要增大复制积压缓冲区的大小(通过配置repl-backlog-size);例如如果网络中断的平均时间是60s,而主节点平均每秒产生的写命令(特定协议格式)所占的字节数为100KB,则复制积压缓冲区的平均需求为6MB,保险起见,可以设置为12MB,来保证绝大多数断线情况都可以使用部分复制。

从节点将offset发送给主节点后,主节点根据offset和缓冲区大小决定能否执行部分复制:

- 如果offset偏移量之后的数据,仍然都在复制积压缓冲区里,则执行部分复制;

- 如果offset偏移量之后的数据已不在复制积压缓冲区中(数据已被挤出),则执行全量复制。

(3)服务器运行ID(runid)

每个Redis节点(无论主从),在启动时都会自动生成一个随机ID(每次启动都不一样),由40个随机的十六进制字符组成;runid用来唯一识别一个Redis节点。通过info Server命令,可以查看节点的runid:

主从节点初次复制时,主节点将自己的runid发送给从节点,从节点将这个runid保存起来;当断线重连时,从节点会将这个runid发送给主节点;主节点根据runid判断能否进行部分复制:

- 如果从节点保存的runid与主节点现在的runid相同,说明主从节点之前同步过,主节点会继续尝试使用部分复制(到底能不能部分复制还要看offset和复制积压缓冲区的情况);

- 如果从节点保存的runid与主节点现在的runid不同,说明从节点在断线前同步的Redis节点并不是当前的主节点,只能进行全量复制。

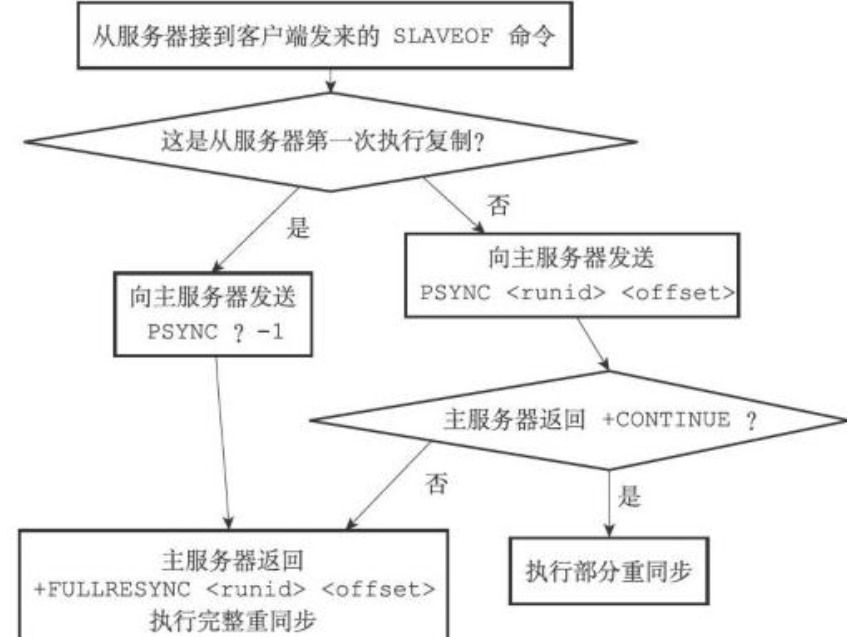

psync命令的执行

在了解了复制偏移量、复制积压缓冲区、节点运行id之后,本节将介绍psync命令的参数和返回值,从而说明psync命令执行过程中,主从节点是如何确定使用全量复制还是部分复制的。

psync命令的执行过程可以参见下图(图片来源:《Redis设计与实现》):

(1)首先,从节点根据当前状态,决定如何调用psync命令:

- 如果从节点之前未执行过slaveof或最近执行了slaveof no one,则从节点发送命令为psync ? -1,向主节点请求全量复制;

- 如果从节点之前执行了slaveof,则发送命令为psync

,其中runid为上次复制的主节点的runid,offset为上次复制截止时从节点保存的复制偏移量。

(2)主节点根据收到的psync命令,及当前服务器状态,决定执行全量复制还是部分复制:

- 如果主节点版本低于Redis2.8,则返回-ERR回复,此时从节点重新发送sync命令执行全量复制;

- 如果主节点版本够新,且runid与从节点发送的runid相同,且从节点发送的offset之后的数据在复制积压缓冲区中都存在,则回复+CONTINUE,表示将进行部分复制,从节点等待主节点发送其缺少的数据即可;

- 如果主节点版本够新,但是runid与从节点发送的runid不同,或从节点发送的offset之后的数据已不在复制积压缓冲区中(在队列中被挤出了),则回复+FULLRESYNC

,表示要进行全量复制,其中runid表示主节点当前的runid,offset表示主节点当前的offset,从节点保存这两个值,以备使用。

命令传播阶段

数据同步阶段完成后,主从节点进入命令传播阶段;在这个阶段主节点将自己执行的写命令发送给从节点,从节点接收命令并执行,从而保证主从节点数据的一致性。

在命令传播阶段,除了发送写命令,主从节点还维持着心跳机制:PING和REPLCONF ACK。

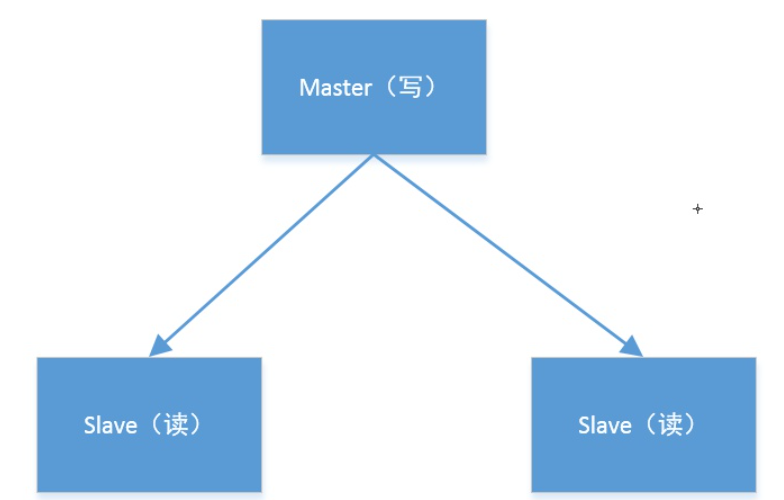

redis主从模式

redis主从模式架构

在软件架构中,master-slave(主从模式)是使用比较多的一种架构方式;

主(master)和 从(slave)部署在不同的服务器上,当主节点服务器写入数据时会同步到从节点的服务器上,一般主节点负责写入数据,从节点负责读取数据

所以,适用于读写分离的高并发场景:客户端可以通过主写入,通过从读取。

主从集群的搭建

单机配置一主多从

- 主服务器通过默认的redis.conf启动redis-server

- 复制主服务器的redis.conf为两个新的文件redis_slave1.conf和redis_slave2.conf

- 分别添加如下配置

# 端口

# 或者port 6381

port 6382

# AOF和快照文件文件夹

# dir /usr/local/var/db/redis_slave1/

dir /usr/local/var/db/redis_slave2/

# 从节点要跟随的主节点

slaveof 127.0.0.1 6379

# 如果设置了密码,就要设置

masterauth master-password

- 从服务器分别通过redis_slave1.conf和redis_slave2.conf启动

集群的运行结果(部分)

# 主节点

32314:M 13 Feb 2019 18:19:34.807 * Replica 127.0.0.1:6381 asks for synchronization

32314:M 13 Feb 2019 18:19:34.807 * Full resync requested by replica 127.0.0.1:6381

32314:M 13 Feb 2019 18:19:34.807 * Starting BGSAVE for SYNC with target: disk

32314:M 13 Feb 2019 18:19:34.807 * Background saving started by pid 33175

33175:C 13 Feb 2019 18:19:34.808 * DB saved on disk

32314:M 13 Feb 2019 18:19:34.838 * Background saving terminated with success

32314:M 13 Feb 2019 18:19:34.839 * Synchronization with replica 127.0.0.1:6381 succeeded

32314:M 13 Feb 2019 18:22:01.275 * Replica 127.0.0.1:6382 asks for synchronization

32314:M 13 Feb 2019 18:22:01.275 * Full resync requested by replica 127.0.0.1:6382

32314:M 13 Feb 2019 18:22:01.275 * Starting BGSAVE for SYNC with target: disk

32314:M 13 Feb 2019 18:22:01.276 * Background saving started by pid 33436

33436:C 13 Feb 2019 18:22:01.277 * DB saved on disk

32314:M 13 Feb 2019 18:22:01.359 * Background saving terminated with success

32314:M 13 Feb 2019 18:22:01.360 * Synchronization with replica 127.0.0.1:6382 succeeded

# 从节点

33174:S 13 Feb 2019 18:19:34.806 * MASTER <-> REPLICA sync started

33174:S 13 Feb 2019 18:19:34.806 * Non blocking connect for SYNC fired the event.

33174:S 13 Feb 2019 18:19:34.807 * Master replied to PING, replication can continue...

33174:S 13 Feb 2019 18:19:34.807 * Partial resynchronization not possible (no cached master)

33174:S 13 Feb 2019 18:19:34.807 * Full resync from master: deb0cb0abde947bba19c5224a3664e27c90a6b65:0

33174:S 13 Feb 2019 18:19:34.839 * MASTER <-> REPLICA sync: receiving 175 bytes from master

33174:S 13 Feb 2019 18:19:34.839 * MASTER <-> REPLICA sync: Flushing old data

33174:S 13 Feb 2019 18:19:34.839 * MASTER <-> REPLICA sync: Loading DB in memory

33174:S 13 Feb 2019 18:19:34.839 * MASTER <-> REPLICA sync: Finished with success

33174:S 13 Feb 2019 18:19:34.839 * Background append only file rewriting started by pid 33176

33174:S 13 Feb 2019 18:19:34.863 * AOF rewrite child asks to stop sending diffs.

33176:C 13 Feb 2019 18:19:34.863 * Parent agreed to stop sending diffs. Finalizing AOF...

33176:C 13 Feb 2019 18:19:34.863 * Concatenating 0.00 MB of AOF diff received from parent.

33176:C 13 Feb 2019 18:19:34.863 * SYNC append only file rewrite performed

33174:S 13 Feb 2019 18:19:34.909 * Background AOF rewrite terminated with success

33174:S 13 Feb 2019 18:19:34.910 * Residual parent diff successfully flushed to the rewritten AOF (0.00 MB)

33174:S 13 Feb 2019 18:19:34.910 * Background AOF rewrite finished successfully

不同机器上配置一主多从

如果redis-server在不同的机器上,只需要以下两个配置即可

# 从节点要跟随的主节点

slaveof 127.0.0.1 6379

# 如果设置了密码,就要设置

masterauth master-password

通过命令设置从服务器

- 可以通过向运行中的从服务器发送SLAVEOF命令来将其设置为从服务器。

- 如果用户使用的是 SLAVEOF配置选项,那么Redis在启动时首先会载入当前可用的任何快照文件或者AOF文件,然后连接主服务器并执行上述的复制过程。如果用户使用的是SLAVEOF命令,那么Redis会立即尝试连接主服务器,并在连接成功之后,开始上述复制过程。

优点

读写分离,提高效率

数据热备份,提供多个副本

问题:

- master无法保证高可用

主节点故障,集群则无法进行工作,可用性比较低,从节点升主节点需要人工手动干预

- 没有解决 master 写的压力

单点容易造成性能低下,主节点的写受到限制(只有一个主节点)

- 主节点的存储能力受到限制

只有一个主节点

- 全量同步可能会造成毫秒或者秒级的卡顿现象

redission访问redis集群

redission作为redis 官方推荐的java客户端。 redission使用netty4.x作为网络层。 redission使用异步io方式操作

redission的读写操作源码分析

从一个读、写操作的代码作为分析代码,如下:

//创建redis客户端

Redisson redisson =(Redisson) Redisson.create();

//创建RBucket对象

RBucket<String> bucket = redisson.getBucket("key1");

//设置对象

bucket.set("someValue");

//获取结果

String bucketObject = bucket.get();

System.out.println("bucketObject:"+bucketObject);

下面详细介绍Redission提供的RBucket 接口和RedissonBucket类。

RBucket 接口

/**

* Any object holder

* @author Nikita Koksharov

*/

public interface RBucket<V> extends RExpirable, RBucketAsync<V>

{

V get();

void set(V value);

void set(V value, long timeToLive, TimeUnit timeUnit);

}

RBucket提供set()和sget()方法用于保存和获取对象。

RedissonBucket 实现类

RedissonBucket 是对RBucket对象的实现。

RedissonBucket实现set()和get()同步方法和异步方法。

public class RedissonBucket<V> extends RedissonExpirable implements RBucket<V> {

protected RedissonBucket(CommandAsyncExecutor connectionManager, String name) {

super(connectionManager, name);

}

protected RedissonBucket(Codec codec, CommandAsyncExecutor connectionManager, String name)

{

super(codec, connectionManager, name);

}

@Override

public V get() {

return get(getAsync());

}

protected final <V> V get(RFuture<V> future) {

return commandExecutor.get(future);

}

@Override

public Future<V> getAsync() {

return commandExecutor.readAsync(getName(), codec, RedisCommands.GET, getName());

}

@Override

public void set(V value) {

get(setAsync(value));

}

@Override

public Future<Void> setAsync(V value) {

return commandExecutor.writeAsync(getName(), codec, RedisCommands.SET, getName(), value);

}

@Override

public void set(V value, long timeToLive, TimeUnit timeUnit) {

get(setAsync(value, timeToLive, timeUnit));

}

@Override

public Future<Void> setAsync(V value, long timeToLive, TimeUnit timeUnit) {

return commandExecutor.writeAsync(getName(), codec, RedisCommands.SETEX, getName(), timeUnit.toSeconds(timeToLive), value);

}

}

RedissonBucket 对象又继承了基类RedissonExpirable,RedissonExpirable继承了基类RedissionObject对象。

abstract class RedissonExpirable extends RedissonObject implements RExpirable {

RedissonExpirable(CommandAsyncExecutor connectionManager, String name) {

super(connectionManager, name);

}

RedissonExpirable(Codec codec, CommandAsyncExecutor connectionManager, String name) {

super(codec, connectionManager, name);

}

@Override

public boolean expire(long timeToLive, TimeUnit timeUnit) {

return commandExecutor.get(expireAsync(timeToLive, timeUnit));

}

...

}

//RedissonExpirable继承了基类RedissionObject对象。

abstract class RedissonObject implements RObject

{

final CommandAsyncExecutor commandExecutor; //连接池

private final String name;//作为键

final Codec codec; //编码解码器

}

在RedissionObject 包含name 作为键,codec 作为编码解码器,commandExecutor 用来执行操作的连接池。

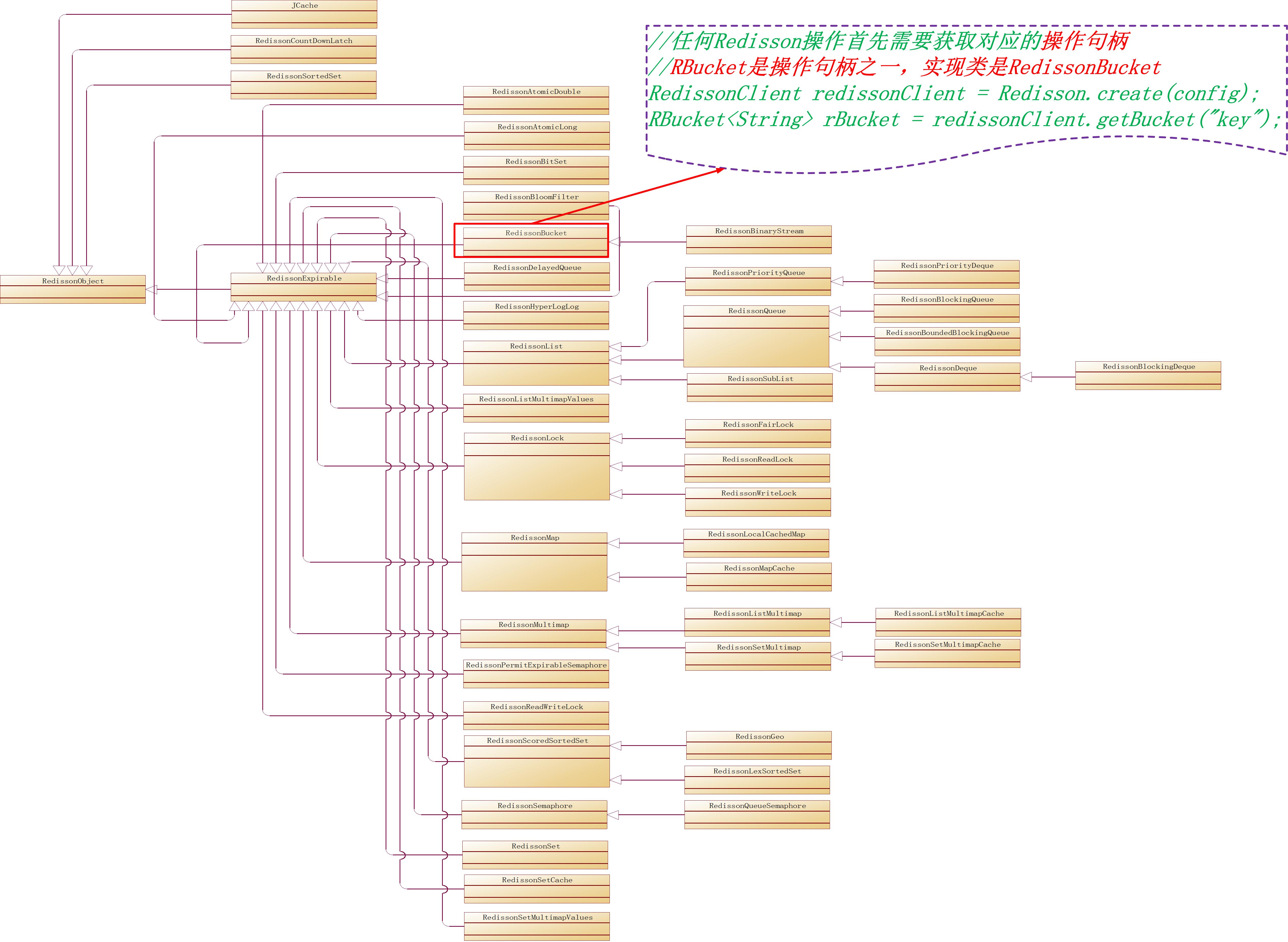

Redisstion的类型

对于Redisson的任何操作,都需要获取到操作句柄类RedissonObject,RedissonObject根据不同的数据类型有不同的RedissonObject实现类,RedissonObject的类继承关系图如下:

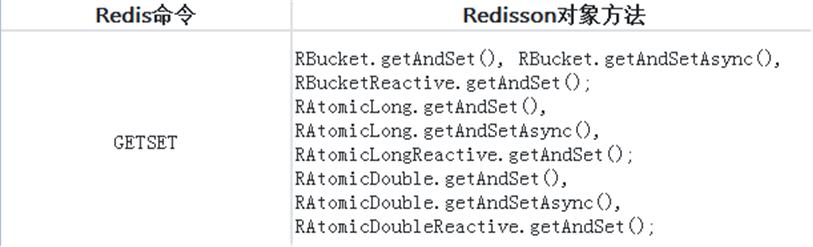

例如想设置redis服务端的key=key的值value=123,你需要查询Redis命令和Redisson对象匹配列表,找到如下对应关系:

然后我们就知道调用代码这么写:

Config config = new Config();// 创建配置

config.useMasterSlaveServers() // 指定使用主从部署方式

.setMasterAddress("redis://192.168.29.24:6379") // 设置redis主节点

.addSlaveAddress("redis://192.168.29.24:7000") // 设置redis从节点

.addSlaveAddress("redis://192.168.29.24:7001"); // 设置redis从节点

RedissonClient redisson = Redisson.create(config);// 创建客户端(发现这一操作非常耗时,基本在2秒-4秒左右)

//任何Redisson操作首先需要获取对应的操作句柄

//RBucket是操作句柄之一,实现类是RedissonBucket

RBucket<String> rBucket = redissonClient.getBucket("key");

//通过操作句柄rBucket进行读操作

rBucket.get();

//通过操作句柄rBucket进行写操作

rBucket.set("123");

至于其它的redis命令对应的redisson操作对象,都可以官网的Redis命令和Redisson对象匹配列表 查到。

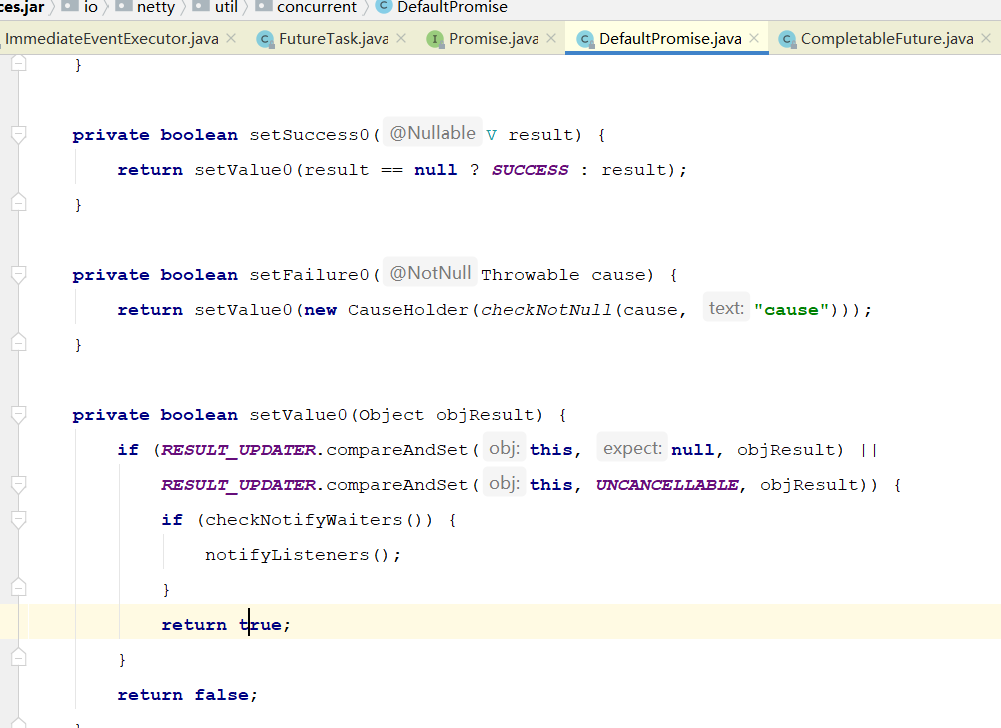

解密:redission的set()方法流程

RedissionBucket执行set()方法

当RedissionBucket执行set()方法时,这将是Redission整个流程的核心。

- RedissonBucket 执行set()方法,并通过get(RFuture

future)方法获取RFuture异步任务的返回值

public class RedissonBucket<V> extends RedissonExpirable implements RBucket<V>

{

@Override

public void set(V value) {

get(setAsync(value));

}

}

- setAsync(value)异步写入的方法

真正执行set操作,调用commandExecutor 来完成,参数为主要封装redis的键值,命令以及所需要的参数

public class RedissonBucket<V> extends RedissonExpirable implements RBucket<V>

{

@Override

public Future<Void> setAsync(V value) {

return commandExecutor.writeAsync(getName(), codec, RedisCommands.SET, getName(), value);

}

}

- CommandAsyncService 线程池的 writeAsync 异步写入

CommandAsyncService 首先通过netty框架创建一个promise接口,并且返回。

public class CommandAsyncService implements CommandAsyncExecutor

{

public <T, R> Future<R> writeAsync(String key, Codec codec, RedisCommand<T> command, Object ... params)

{

//通过netty创建一个Promise接口并且返回

Promise<R> mainPromise = connectionManager.newPromise();

NodeSource source = getNodeSource(key);

async(false, source, codec, command, params, mainPromise, 0);

return mainPromise;

}

}

在此,RBucket 执行一个set操作,由netty创建一个promise对象,并且RBucket通过get()同步方法获取promise完成时的结果。

前面的异步转同步的方法:

protected final <V> V get(RFuture<V> future) {

return commandExecutor.get(future);

}

- CommandAsyncService 线程池的同步get方法

public class CommandAsyncService implements CommandAsyncExecutor

{

@Override

public <V> V get(RFuture<V> future) {

try {

future.await();

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

}

if (future.isSuccess()) {

return future.getNow();

}

throw convertException(future);

}

}

在Redission引擎中,核心流程处理在于

CommandAsyncService.async() 创建异步任务

这个关键方法。CommandAsyncService.async()方法内部,一直在优化和改变。不过代码,一直朝着更加清晰的地方发展,这更加有利于我们的学习。

protected <V, R> void async(final boolean readOnlyMode,

final NodeSource source,

final Codec codec,

final RedisCommand<V> command,

final Object[] params,

final Promise<R> mainPromise,

final int attempt)

{

RedisExecutor<V, R> executor =

new RedisExecutor<>(readOnlyMode, source,

codec, command, params, mainPromise,

ignoreRedirect, connectionManager, objectBuilder);

executor.execute();

}

RedisExecutor 命令执行器

public RedisExecutor(boolean readOnlyMode, NodeSource source,

Codec codec, RedisCommand<V> command,

Object[] params, RPromise<R> mainPromise, boolean ignoreRedirect,

ConnectionManager connectionManager, RedissonObjectBuilder objectBuilder) {

super();

this.readOnlyMode = readOnlyMode;

this.source = source;

this.codec = codec;

this.command = command;

this.params = params;

this.mainPromise = mainPromise;

this.ignoreRedirect = ignoreRedirect;

this.connectionManager = connectionManager;

this.objectBuilder = objectBuilder;

this.attempts = connectionManager.getConfig().getRetryAttempts();

this.retryInterval = connectionManager.getConfig().getRetryInterval();

this.responseTimeout = connectionManager.getConfig().getTimeout();

}

命令执行方法

public void execute() {

if (mainPromise.isCancelled()) {

free();

return;

}

if (!connectionManager.getShutdownLatch().acquire()) {

free();

mainPromise.tryFailure(new RedissonShutdownException("Redisson is shutdown"));

return;

}

codec = getCodec(codec);

//获取连接

RFuture<RedisConnection> connectionFuture = getConnection();

RPromise<R> attemptPromise = new RedissonPromise<R>();

mainPromiseListener = (r, e) -> {

if (mainPromise.isCancelled() && connectionFuture.cancel(false)) {

log.debug("Connection obtaining canceled for {}", command);

timeout.cancel();

if (attemptPromise.cancel(false)) {

free();

}

}

};

if (attempt == 0) {

mainPromise.onComplete((r, e) -> {

if (this.mainPromiseListener != null) {

this.mainPromiseListener.accept(r, e);

}

});

}

scheduleRetryTimeout(connectionFuture, attemptPromise);

connectionFuture.onComplete((connection, e) -> {

if (connectionFuture.isCancelled()) {

connectionManager.getShutdownLatch().release();

return;

}

if (!connectionFuture.isSuccess()) {

connectionManager.getShutdownLatch().release();

exception = convertException(connectionFuture);

return;

}

if (attemptPromise.isDone() || mainPromise.isDone()) {

releaseConnection(attemptPromise, connectionFuture);

return;

}

sendCommand(attemptPromise, connection);

writeFuture.addListener(new ChannelFutureListener() {

@Override

public void operationComplete(ChannelFuture future) throws Exception {

checkWriteFuture(writeFuture, attemptPromise, connection);

}

});

releaseConnection(attemptPromise, connectionFuture);

});

attemptPromise.onComplete((r, e) -> {

checkAttemptPromise(attemptPromise, connectionFuture);

});

}

在RedisExecutor.execute()方法内部,获取一个连接

//获取连接

RFuture<RedisConnection> connectionFuture = getConnection();

获取一个连接 后,这里也使用了异步方式, 对connectionFuture 进行监听。

当connectFuture完成时,然后进行写操作。然后sendCommand 发送命令。

connectionFuture.onComplete((connection, e) -> {

if (connectionFuture.isCancelled()) {

connectionManager.getShutdownLatch().release();

return;

}

if (!connectionFuture.isSuccess()) {

connectionManager.getShutdownLatch().release();

exception = convertException(connectionFuture);

return;

}

if (attemptPromise.isDone() || mainPromise.isDone()) {

releaseConnection(attemptPromise, connectionFuture);

return;

}

sendCommand(attemptPromise, connection);

writeFuture.addListener(new ChannelFutureListener() {

@Override

public void operationComplete(ChannelFuture future) throws Exception {

checkWriteFuture(writeFuture, attemptPromise, connection);

}

});

releaseConnection(attemptPromise, connectionFuture);

});

当Redission接受到Redis服务器消息时,会取出发送时的信息。这个时候会设置attempPromise完成时通知,在attempPromise监听器中会通知MainPromise.这个时候MainPromise就会获取到通知。

protected void completeResponse(CommandData<Object, Object> data, Object result, Channel channel) {

if (data != null

&& !data.getPromise().trySuccess(result)

&& data.cause() instanceof RedisTimeoutException) {

log.warn("response has been skipped due to timeout! channel: {}, command: {}", channel, LogHelper.toString(data));

}

}

Redssion的处理流水线

@Override

protected void initChannel(Channel ch) throws Exception {

initSsl(config, ch);

if (type == Type.PLAIN) {

ch.pipeline().addLast(new RedisConnectionHandler(redisClient));

} else {

ch.pipeline().addLast(new RedisPubSubConnectionHandler(redisClient));

}

ch.pipeline().addLast(

connectionWatchdog,

CommandEncoder.INSTANCE,

CommandBatchEncoder.INSTANCE,

new CommandsQueue());

if (pingConnectionHandler != null) {

ch.pipeline().addLast(pingConnectionHandler);

}

if (type == Type.PLAIN) {

ch.pipeline().addLast(new CommandDecoder(config.getExecutor(), config.isDecodeInExecutor()));

} else {

ch.pipeline().addLast(new CommandPubSubDecoder(config.getExecutor(), config.isKeepPubSubOrder(), config.isDecodeInExecutor()));

}

}

redission命令发送处理器

public class CommandsQueue extends ChannelDuplexHandler {

@Override

public void write(ChannelHandlerContext ctx, Object msg, ChannelPromise promise) throws Exception {

if (msg instanceof QueueCommand) {

QueueCommand data = (QueueCommand) msg;

QueueCommandHolder holder = queue.peek();

if (holder != null && holder.getCommand() == data) {

super.write(ctx, msg, promise);

} else {

queue.add(new QueueCommandHolder(data, promise));

sendData(ctx.channel());

}

} else {

super.write(ctx, msg, promise);

}

}

private void sendData(Channel ch) {

QueueCommandHolder command = queue.peek();

if (command != null && command.trySend()) {

QueueCommand data = command.getCommand();

List<CommandData<Object, Object>> pubSubOps = data.getPubSubOperations();

if (!pubSubOps.isEmpty()) {

for (CommandData<Object, Object> cd : pubSubOps) {

for (Object channel : cd.getParams()) {

ch.pipeline().get(CommandPubSubDecoder.class).addPubSubCommand((ChannelName) channel, cd);

}

}

} else {

ch.attr(CURRENT_COMMAND).set(data);

}

command.getChannelPromise().addListener(listener);

ch.writeAndFlush(data, command.getChannelPromise());

}

}

}

NioSocketChannel 执行最终的写操作

public class NioSocketChannel extends AbstractNioByteChannel implements io.netty.channel.socket.SocketChannel {

@Override

protected void doWrite(ChannelOutboundBuffer in) throws Exception {

SocketChannel ch = javaChannel();

int writeSpinCount = config().getWriteSpinCount();

do {

if (in.isEmpty()) {

// All written so clear OP_WRITE

clearOpWrite();

// Directly return here so incompleteWrite(...) is not called.

return;

}

// Ensure the pending writes are made of ByteBufs only.

int maxBytesPerGatheringWrite = ((NioSocketChannelConfig) config).getMaxBytesPerGatheringWrite();

ByteBuffer[] nioBuffers = in.nioBuffers(1024, maxBytesPerGatheringWrite);

int nioBufferCnt = in.nioBufferCount();

// Always us nioBuffers() to workaround data-corruption.

// See https://github.com/netty/netty/issues/2761

switch (nioBufferCnt) {

case 0:

// We have something else beside ByteBuffers to write so fallback to normal writes.

writeSpinCount -= doWrite0(in);

break;

case 1: {

// Only one ByteBuf so use non-gathering write

// Zero length buffers are not added to nioBuffers by ChannelOutboundBuffer, so there is no need

// to check if the total size of all the buffers is non-zero.

ByteBuffer buffer = nioBuffers[0];

int attemptedBytes = buffer.remaining();

final int localWrittenBytes = ch.write(buffer);

if (localWrittenBytes <= 0) {

incompleteWrite(true);

return;

}

adjustMaxBytesPerGatheringWrite(attemptedBytes, localWrittenBytes, maxBytesPerGatheringWrite);

in.removeBytes(localWrittenBytes);

--writeSpinCount;

break;

}

default: {

// Zero length buffers are not added to nioBuffers by ChannelOutboundBuffer, so there is no need

// to check if the total size of all the buffers is non-zero.

// We limit the max amount to int above so cast is safe

long attemptedBytes = in.nioBufferSize();

final long localWrittenBytes = ch.write(nioBuffers, 0, nioBufferCnt);

if (localWrittenBytes <= 0) {

incompleteWrite(true);

return;

}

// Casting to int is safe because we limit the total amount of data in the nioBuffers to int above.

adjustMaxBytesPerGatheringWrite((int) attemptedBytes, (int) localWrittenBytes,

maxBytesPerGatheringWrite);

in.removeBytes(localWrittenBytes);

--writeSpinCount;

break;

}

}

} while (writeSpinCount > 0);

incompleteWrite(writeSpinCount < 0);

}

ChannelOutboundBuffer回调Promise的接口

ChannelOutboundBuffer写完之后,回调Promise的接口。

Future 有两种模式:将来式和回调式。而回调式会出现回调地狱的问题,由此衍生出了 Promise 模式来解决这个问题。这才是 Future 模式和 Promise 模式的相关性。

public final class ChannelOutboundBuffer {

/**

* Removes the fully written entries and update the reader index of the partially written entry.

* This operation assumes all messages in this buffer is {@link ByteBuf}.

*/

public void removeBytes(long writtenBytes) {

for (;;) {

Object msg = current();

if (!(msg instanceof ByteBuf)) {

assert writtenBytes == 0;

break;

}

final ByteBuf buf = (ByteBuf) msg;

final int readerIndex = buf.readerIndex();

final int readableBytes = buf.writerIndex() - readerIndex;

if (readableBytes <= writtenBytes) {

if (writtenBytes != 0) {

progress(readableBytes);

writtenBytes -= readableBytes;

}

remove();

} else { // readableBytes > writtenBytes

if (writtenBytes != 0) {

buf.readerIndex(readerIndex + (int) writtenBytes);

progress(writtenBytes);

}

break;

}

}

clearNioBuffers();

}

/**

* Will remove the current message, mark its {@link ChannelPromise} as success and return {@code true}. If no

* flushed message exists at the time this method is called it will return {@code false} to signal that no more

* messages are ready to be handled.

*/

public boolean remove() {

Entry e = flushedEntry;

if (e == null) {

clearNioBuffers();

return false;

}

Object msg = e.msg;

ChannelPromise promise = e.promise;

int size = e.pendingSize;

removeEntry(e);

if (!e.cancelled) {

// only release message, notify and decrement if it was not canceled before.

ReferenceCountUtil.safeRelease(msg);

safeSuccess(promise);

decrementPendingOutboundBytes(size, false, true);

}

// recycle the entry

e.recycle();

return true;

}

回到写完后的异步回调接口

RedisExecutor 发送命令sendCommand

public class RedisExecutor<V, R> {

protected void sendCommand(RPromise<R> attemptPromise, RedisConnection connection) {

if (source.getRedirect() == Redirect.ASK) {

List<CommandData<?, ?>> list = new ArrayList<CommandData<?, ?>>(2);

RPromise<Void> promise = new RedissonPromise<Void>();

list.add(new CommandData<Void, Void>(promise, codec, RedisCommands.ASKING, new Object[]{}));

list.add(new CommandData<V, R>(attemptPromise, codec, command, params));

RPromise<Void> main = new RedissonPromise<Void>();

writeFuture = connection.send(new CommandsData(main, list, false));

} else {

if (log.isDebugEnabled()) {

log.debug("acquired connection for command {} and params {} from slot {} using node {}... {}",

command, LogHelper.toString(params), source, connection.getRedisClient().getAddr(), connection);

}

writeFuture = connection.send(new CommandData<V, R>(attemptPromise, codec, command, params));

}

}

来自于 AbstractChannelHandlerContext 的异步回调:

abstract class AbstractChannelHandlerContext implements ChannelHandlerContext, ResourceLeakHint {

@Override

public ChannelFuture writeAndFlush(Object msg) {

return writeAndFlush(msg, newPromise());

}

}

RedisExecutor启动超时重试定时器

public class RedisExecutor<V, R> {

public void execute() {

writeFuture.addListener(new ChannelFutureListener() {

@Override

public void operationComplete(ChannelFuture future) throws Exception {

checkWriteFuture(writeFuture, attemptPromise, connection);

}

});

}

private void checkWriteFuture(ChannelFuture future, RPromise<R> attemptPromise, RedisConnection connection) {

if (future.isCancelled() || attemptPromise.isDone()) {

return;

}

if (!future.isSuccess()) {

exception = new WriteRedisConnectionException(

"Unable to send command! Node source: " + source + ", connection: " + connection +

", command: " + LogHelper.toString(command, params)

+ " after " + attempt + " retry attempts", future.cause());

if (attempt == attempts) {

if (!attemptPromise.tryFailure(exception)) {

log.error(exception.getMessage());

}

}

return;

}

timeout.cancel();

scheduleResponseTimeout(attemptPromise, connection);

}

private void scheduleResponseTimeout(RPromise<R> attemptPromise, RedisConnection connection) {

long timeoutTime = responseTimeout;

if (command != null

&& (RedisCommands.BLOCKING_COMMAND_NAMES.contains(command.getName())

|| RedisCommands.BLOCKING_COMMANDS.contains(command))) {

Long popTimeout = null;

if (RedisCommands.BLOCKING_COMMANDS.contains(command)) {

boolean found = false;

for (Object param : params) {

if (found) {

popTimeout = Long.valueOf(param.toString()) / 1000;

break;

}

if ("BLOCK".equals(param)) {

found = true;

}

}

} else {

popTimeout = Long.valueOf(params[params.length - 1].toString());

}

handleBlockingOperations(attemptPromise, connection, popTimeout);

if (popTimeout == 0) {

return;

}

timeoutTime += popTimeout * 1000;

// add 1 second due to issue https://github.com/antirez/redis/issues/874

timeoutTime += 1000;

}

long timeoutAmount = timeoutTime;

TimerTask timeoutTask = new TimerTask() {

@Override

public void run(Timeout timeout) throws Exception {

if (attempt < attempts) {

if (!attemptPromise.cancel(false)) {

return;

}

attempt++;

if (log.isDebugEnabled()) {

log.debug("attempt {} for command {} and params {}",

attempt, command, LogHelper.toString(params));

}

mainPromiseListener = null;

execute();

return;

}

attemptPromise.tryFailure(

new RedisResponseTimeoutException("Redis server response timeout (" + timeoutAmount + " ms) occured"

+ " after " + attempts + " retry attempts. Command: "

+ LogHelper.toString(command, params) + ", channel: " + connection.getChannel()));

}

};

timeout = connectionManager.newTimeout(timeoutTask, timeoutTime, TimeUnit.MILLISECONDS);

}

CommandDecoder 命令解码器

public class CommandDecoder extends ReplayingDecoder<State> {

@Override

protected final void decode(ChannelHandlerContext ctx, ByteBuf in, List<Object> out) throws Exception {

QueueCommand data = ctx.channel().attr(CommandsQueue.CURRENT_COMMAND).get();

if (state() == null) {

state(new State());

}

if (data == null) {

while (in.writerIndex() > in.readerIndex()) {

int endIndex = skipCommand(in);

try {

decode(ctx, in, data);

} catch (Exception e) {

in.readerIndex(endIndex);

throw e;

}

}

} else {

int endIndex = 0;

if (!(data instanceof CommandsData)) {

endIndex = skipCommand(in);

}

try {

decode(ctx, in, data);

} catch (Exception e) {

if (!(data instanceof CommandsData)) {

in.readerIndex(endIndex);

}

throw e;

}

}

}

private void decode(ChannelHandlerContext ctx, ByteBuf in, QueueCommand data) throws Exception {

decodeCommand(ctx.channel(), in, data);

}

protected void decodeCommand(Channel channel, ByteBuf in, QueueCommand data) throws Exception {

if (data instanceof CommandData) {

CommandData<Object, Object> cmd = (CommandData<Object, Object>) data;

try {

decode(in, cmd, null, channel, false, null);

sendNext(channel, data);

} catch (Exception e) {

cmd.tryFailure(e);

sendNext(channel);

throw e;

}

}

}

protected void decode(ByteBuf in, CommandData<Object, Object> data, List<Object> parts, Channel channel, boolean skipConvertor, List<CommandData<?, ?>> commandsData) throws IOException {

int code = in.readByte();

if (code == '+') {

String result = readString(in);

handleResult(data, parts, result, skipConvertor, channel);

} else if (code == '-') {

String error = readString(in);

} else if (code == ':') {

Long result = readLong(in);

handleResult(data, parts, result, false, channel);

} else if (code == '$') {

} else {

String dataStr = in.toString(0, in.writerIndex(), CharsetUtil.UTF_8);

throw new IllegalStateException("Can't decode replay: " + dataStr);

}

}

private void handleResult(CommandData<Object, Object> data, List<Object> parts, Object result, boolean skipConvertor, Channel channel) {

if (data != null && !skipConvertor) {

result = data.getCommand().getConvertor().convert(result);

}

if (parts != null) {

parts.add(result);

} else {

completeResponse(data, result, channel);

}

}

protected void completeResponse(CommandData<Object, Object> data, Object result, Channel channel) {

if (data != null

&& !data.getPromise().trySuccess(result)

&& data.cause() instanceof RedisTimeoutException) {

log.warn("response has been skipped due to timeout! channel: {}, command: {}", channel, LogHelper.toString(data));

}

}

回到最初的mainPromise 回调

public class CommandAsyncService implements CommandAsyncExecutor

{

public <T, R> Future<R> writeAsync(String key, Codec codec, RedisCommand<T> command, Object ... params)

{

//通过netty创建一个Promise接口并且返回

Promise<R> mainPromise = connectionManager.newPromise();

NodeSource source = getNodeSource(key);

async(false, source, codec, command, params, mainPromise, 0);

return mainPromise;

}

}

public class RedissonPromise<T> extends CompletableFuture<T> implements RPromise<T> {

private final Promise<T> promise = ImmediateEventExecutor.INSTANCE.newPromise();

@Override

public boolean trySuccess(T result) {

if (promise.trySuccess(result)) {

complete(result);

return true;

}

return false;

}

}

取消重试定时器

mainPromiseListener = (r, e) -> {

if (mainPromise.isCancelled() && connectionFuture.cancel(false)) {

log.debug("Connection obtaining canceled for {}", command);

timeout.cancel();

if (attemptPromise.cancel(false)) {

free();

}

}

};

同步,异步,阻塞,非阻塞实战

同步,异步,阻塞,非阻塞的理解需要花费很大的精力,从 IO 模型和内核进行深入地理解,才能分清区别。在日常开发中往往没必要过于纠结到底是何种调用,但得对调用的特性有所了解,比如是否占用主线程的时间片,出现异常怎么捕获,超时怎么解决等等

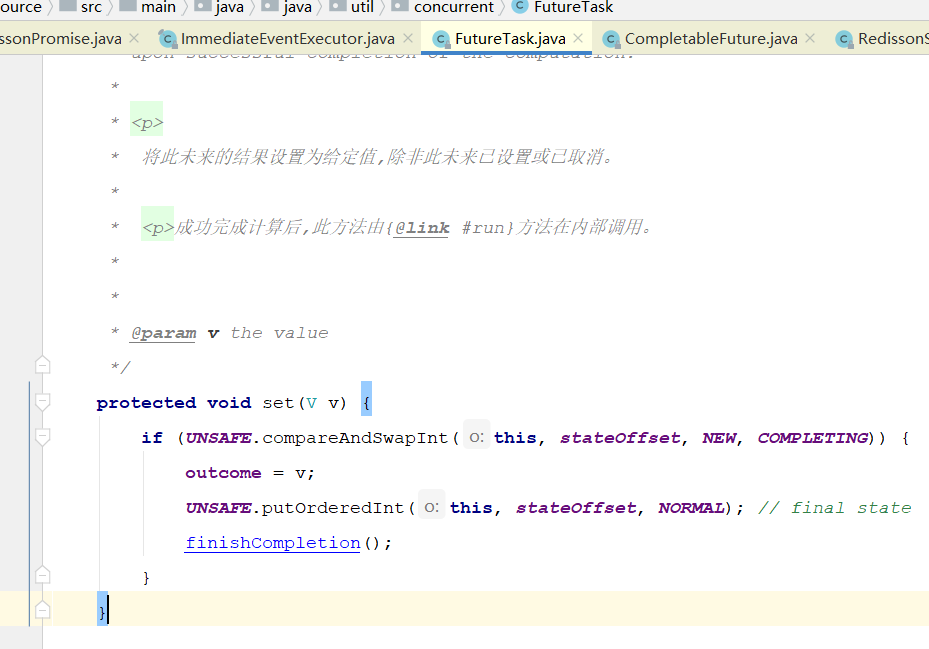

Future 和 Promise的区别

Future 的结果由异步计算的结果确定。请注意,必须使用Callable或Runnable初始化FutureTask(经典的Future),没有无参数构造函数,并且Future和FutureTask都是从外部只读的(FutureTask的set方法受保护)。该值将从内部设置为计算结果。

Promise和 Future 是非常相似的概念,不同之处在于,Future 是针对尚不存在的结果的只读容器,而 Promise 可以被写入(通常只能写入一次)。

Promise 的结果可以由你(或实际上任何人)随时设置,因为它具有公共设置方法。你向客户代码发送一个 Promise,并在以后根据需要执行。

在Java 8中,Promise最终被称为CompletableFuture,它的javadoc解释了:可以明确完成(设置其值和状态)并可以用作CompletionStage的Future,它支持在完成时触发的相关功能和操作。

在Java 8中,可以创建CompletableFuture和SettableFuture,而无需执行任何任务,并且可以随时设置它们的值。注意,CompletableFuture不是“纯粹的”Promise,可以使用诸如FutureTask之类的任务对其进行初始化,并且它最有用的功能是与处理链的步骤无关。

连接的获取

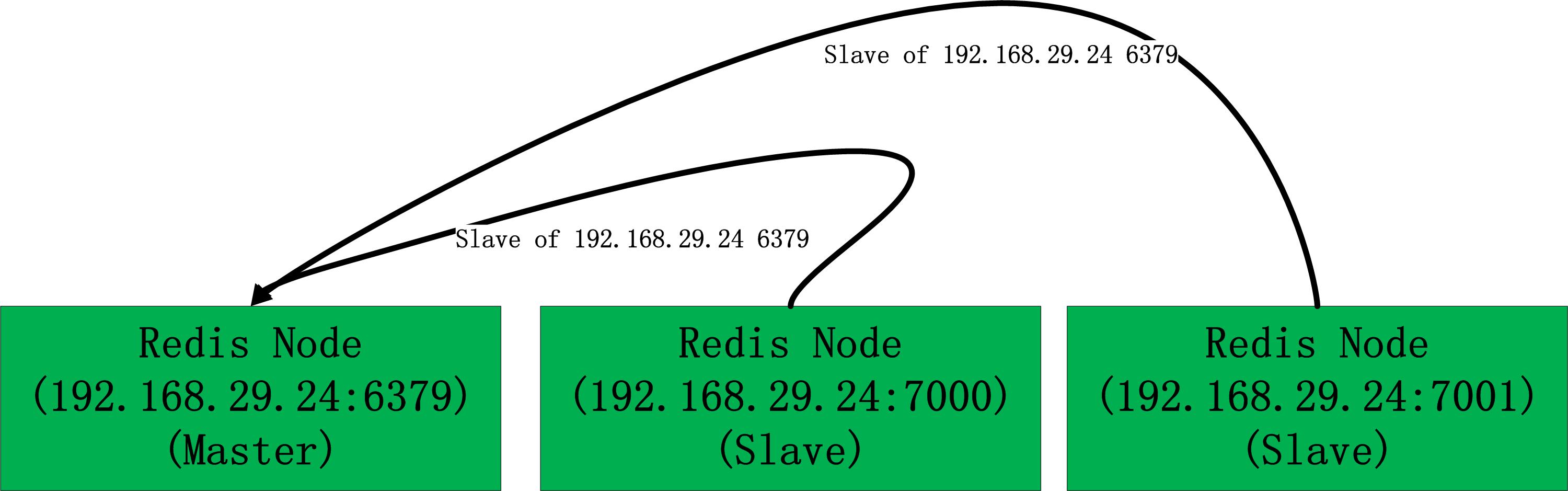

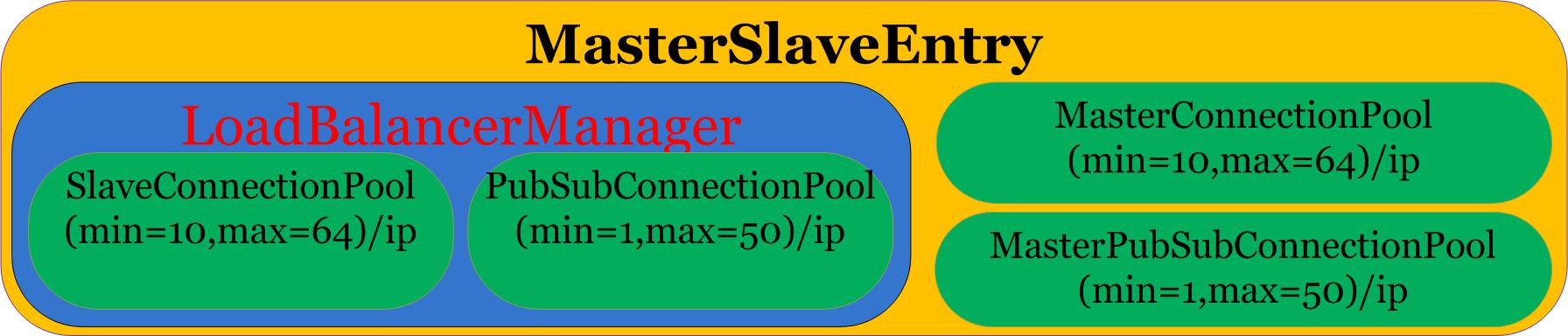

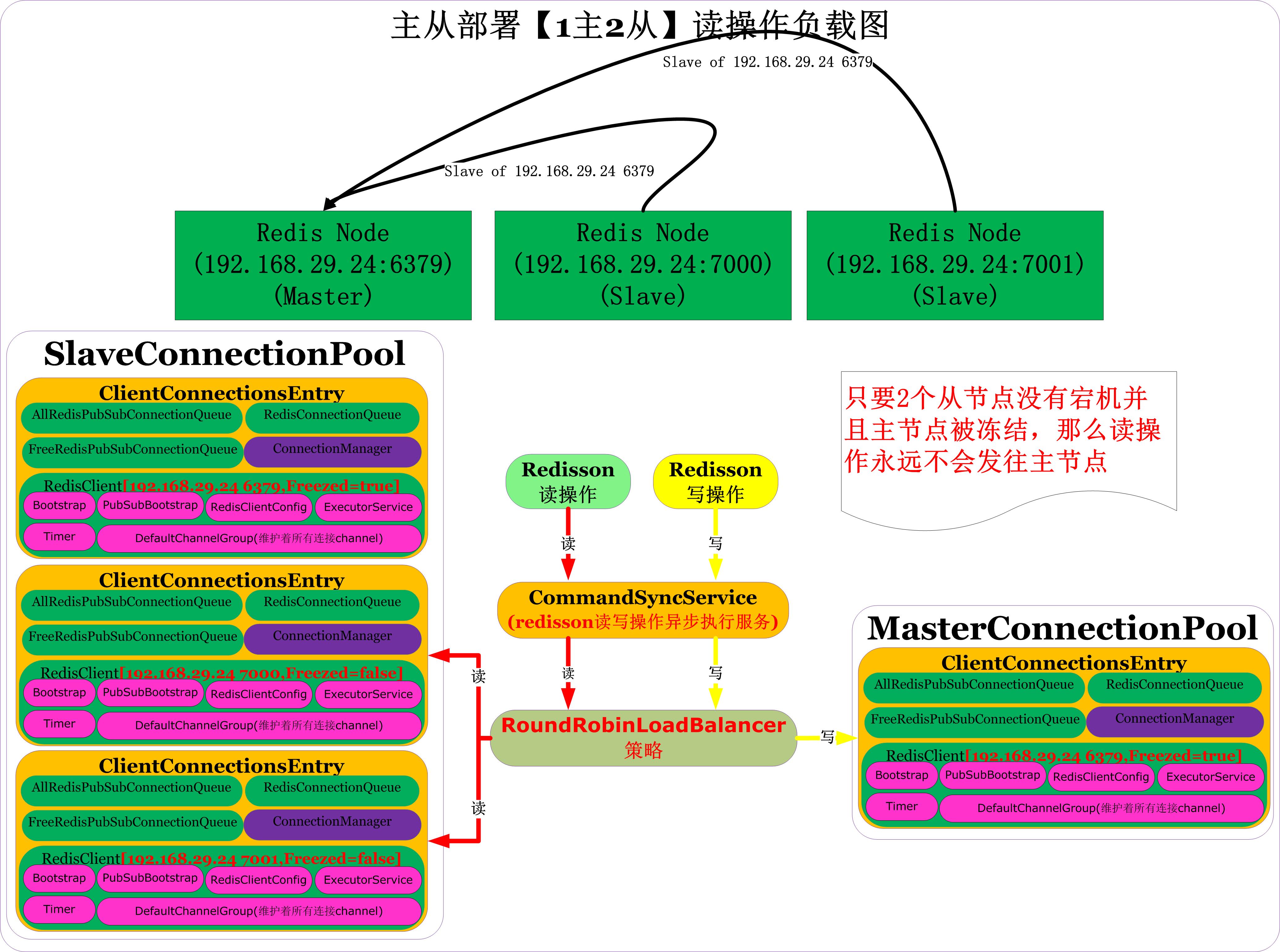

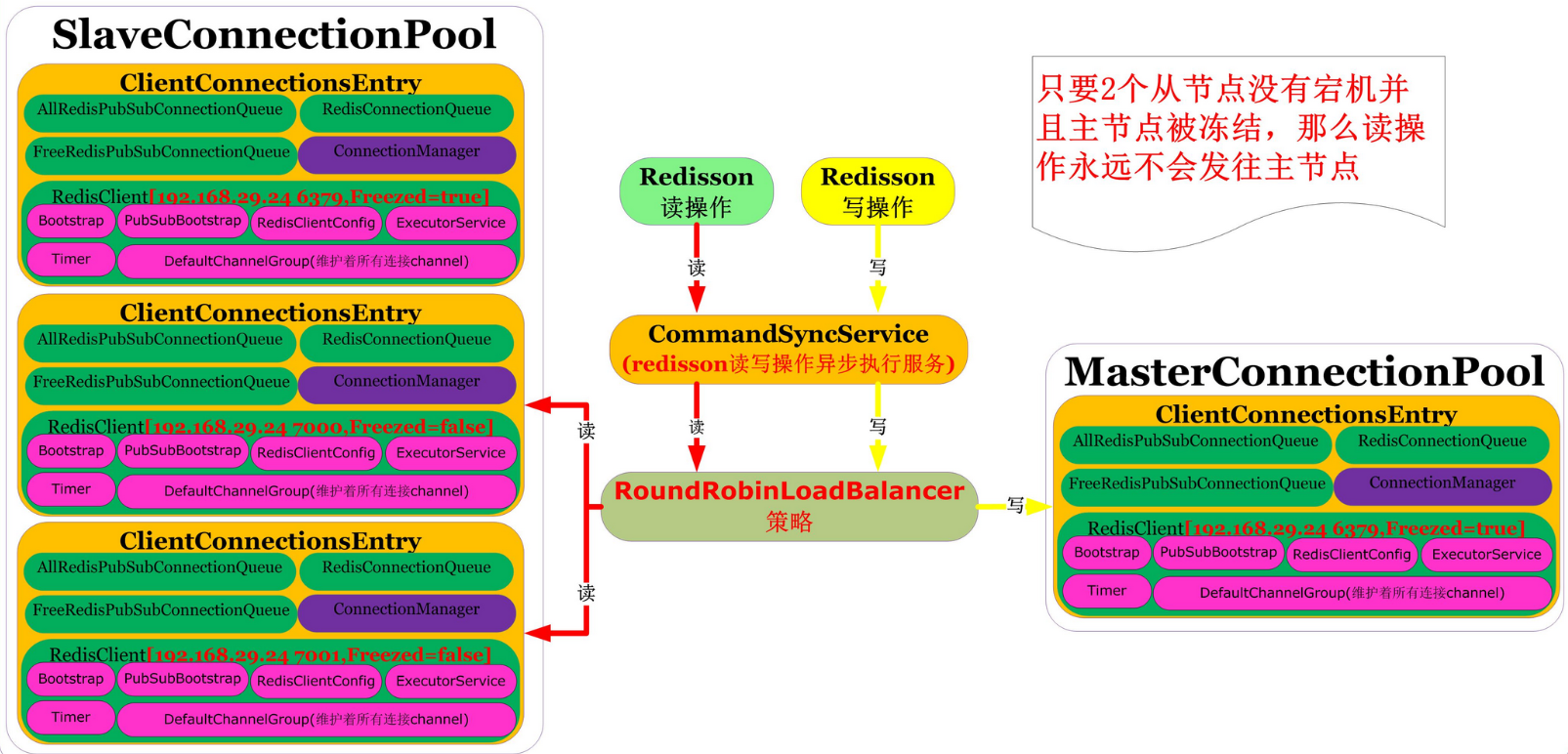

RedissonClient一主两从部署时连接池组成

对如下图的主从部署(1主2从):

redisson纯java操作代码如下:

redisson纯java操作代码如下:

Config config = new Config();// 创建配置

config.useMasterSlaveServers() // 指定使用主从部署方式

//.setReadMode(ReadMode.SLAVE) 默认值SLAVE,读操作只在从节点进行

//.setSubscriptionMode(SubscriptionMode.SLAVE) 默认值SLAVE,订阅操作只在从节点进行

//.setMasterConnectionMinimumIdleSize(10) 默认值10,针对每个master节点初始化10个连接

//.setMasterConnectionPoolSize(64) 默认值64,针对每个master节点初始化10个连接,最大可以扩展至64个连接

//.setSlaveConnectionMinimumIdleSize(10) 默认值10,针对每个slave节点初始化10个连接

//.setSlaveConnectionPoolSize(64) 默认值,针对每个slave节点初始化10个连接,最大可以扩展至64个连接

//.setSubscriptionConnectionMinimumIdleSize(1) 默认值1,在SubscriptionMode=SLAVE时候,针对每个slave节点初始化1个连接

//.setSubscriptionConnectionPoolSize(50) 默认值50,在SubscriptionMode=SLAVE时候,针对每个slave节点初始化1个连接,最大可以扩展至50个连接

.setMasterAddress("redis://192.168.29.24:6379") // 设置redis主节点

.addSlaveAddress("redis://192.168.29.24:7000") // 设置redis从节点

.addSlaveAddress("redis://192.168.29.24:7001"); // 设置redis从节点

RedissonClient redisson = Redisson.create(config);// 创建客户端(发现这一操作非常耗时,基本在2秒-4秒左右)

上面代码执行完毕后,如果在redis服务端所在服务器执行以下linux命令:

#6379上建立了10个连接

netstat -ant |grep 6379|grep ESTABLISHED

#7000上建立了11个连接

netstat -ant |grep 7000|grep ESTABLISHED

#7001上建立了11个连接

netstat -ant |grep 7001|grep ESTABLISHED

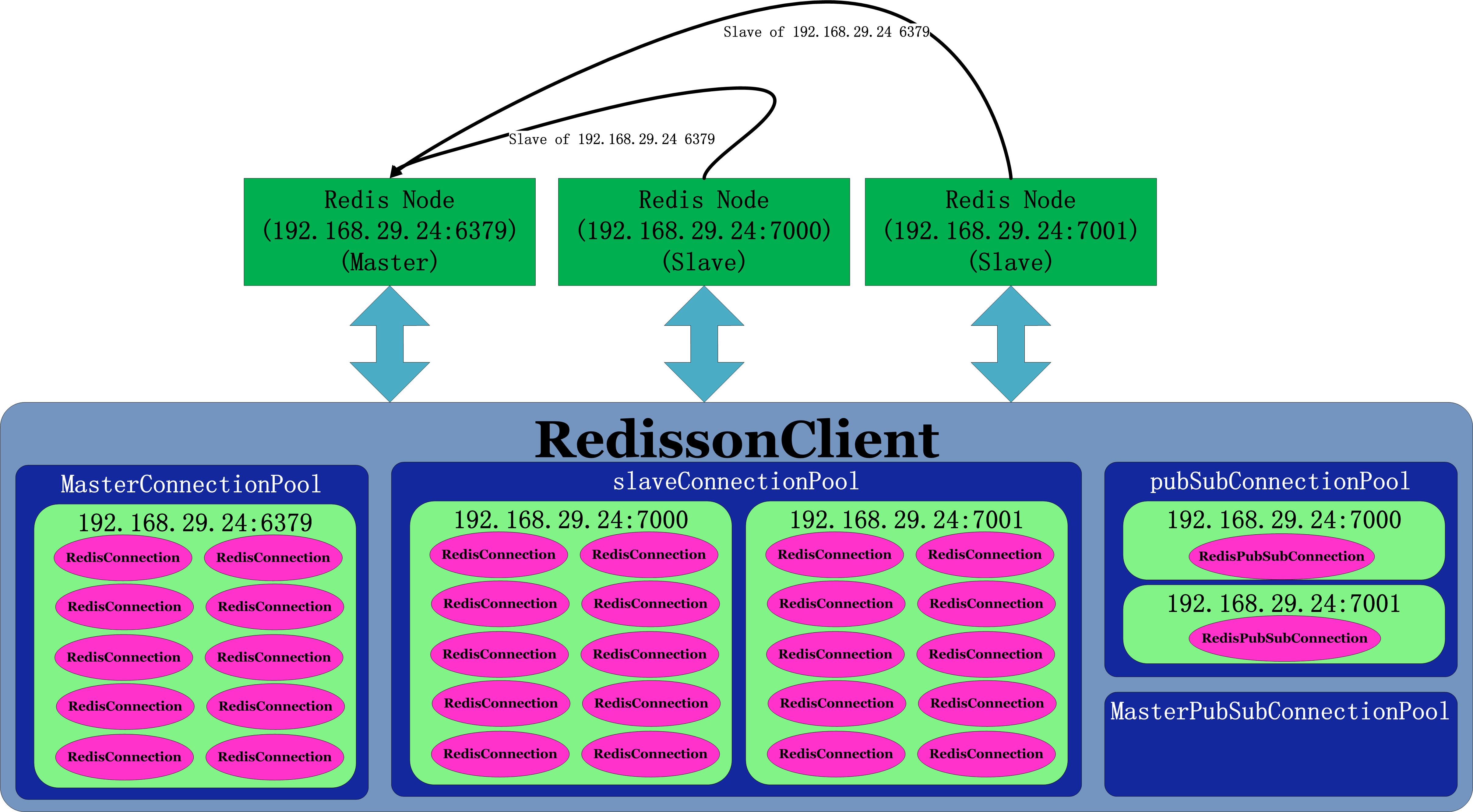

你会发现redisson连接到redis服务端总计建立了32个连接,其中masterpool占据10个连接,slavepool占据20个连接,另外pubSubConnectionPool占据2个连接

连接池中池化对象分布

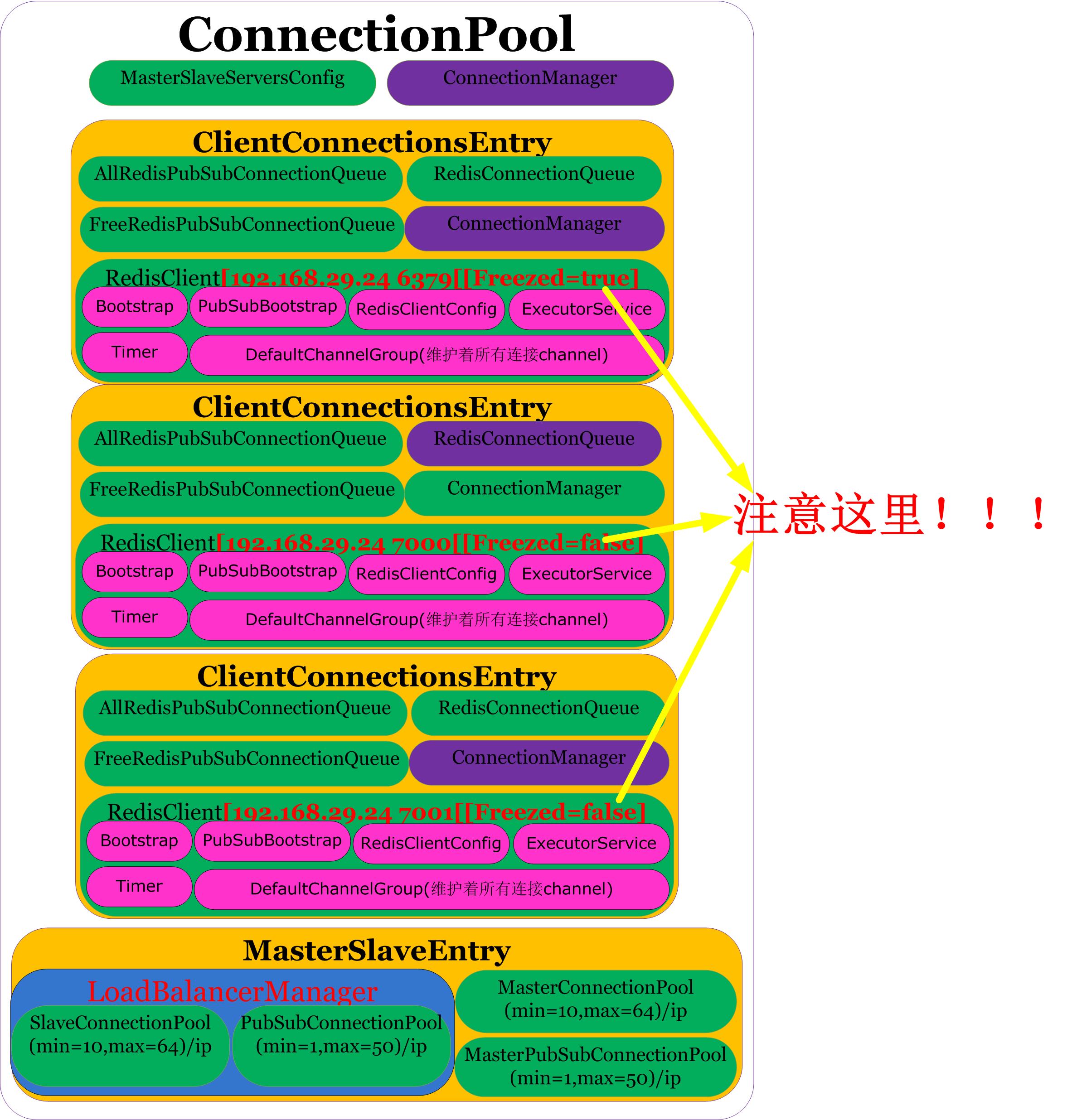

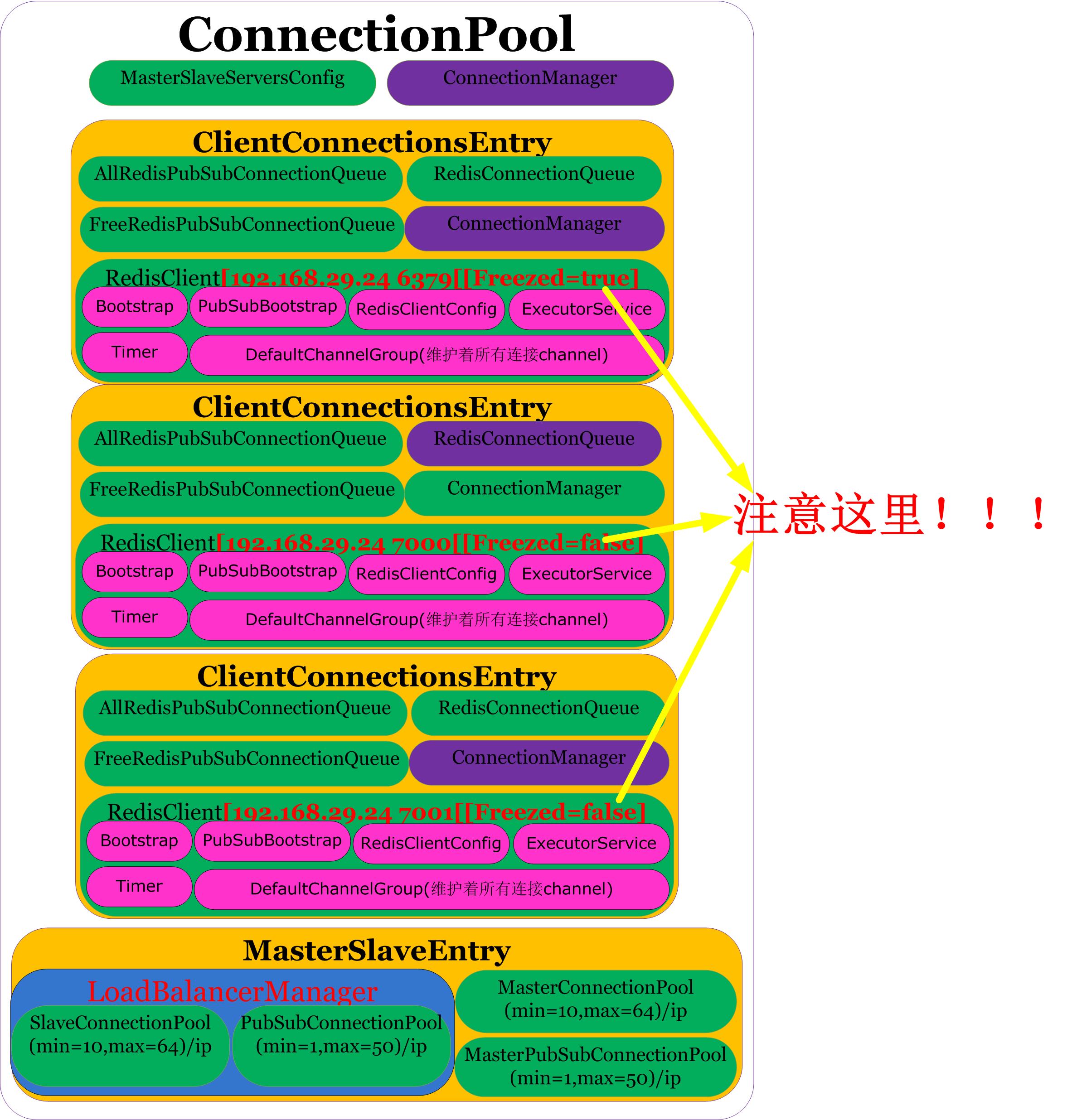

连接池中池化对象分布如下图:

从上图可以看出,连接池是针对每个IP端口都有一个独立的池,连接池也按照主从进行划分,具体如下:

-

MasterConnectionPool:

默认针对每个不同的IP+port组合,初始化10个对象,最大可扩展至64个,因为只有一个master,所以上图创建了10个连接;

-

MasterPubSubConnectionPool:

默认针对每个不同的IP+port组合,初始化1个对象,最大可扩展至50个,因为默认SubscriptionMode=SubscriptionMode.SLAVE,所以master上不会创建连接池,所以上图MasterPubSubConnectionPool里没有创建任何连接;

-

SlaveConnectionPool:

默认针对每个不同的IP+port组合,初始化10个对象,最大可扩展至64个,因为有两个slave,每个slave上图创建了10个连接,总计创建了20个连接;

-

PubSubConnectionPool:

默认针对每个不同的IP+port组合,初始化1个对象,最大可扩展至50个,因为有两个slave,每个slave上图创建了1个连接,总计创建了2个连接。

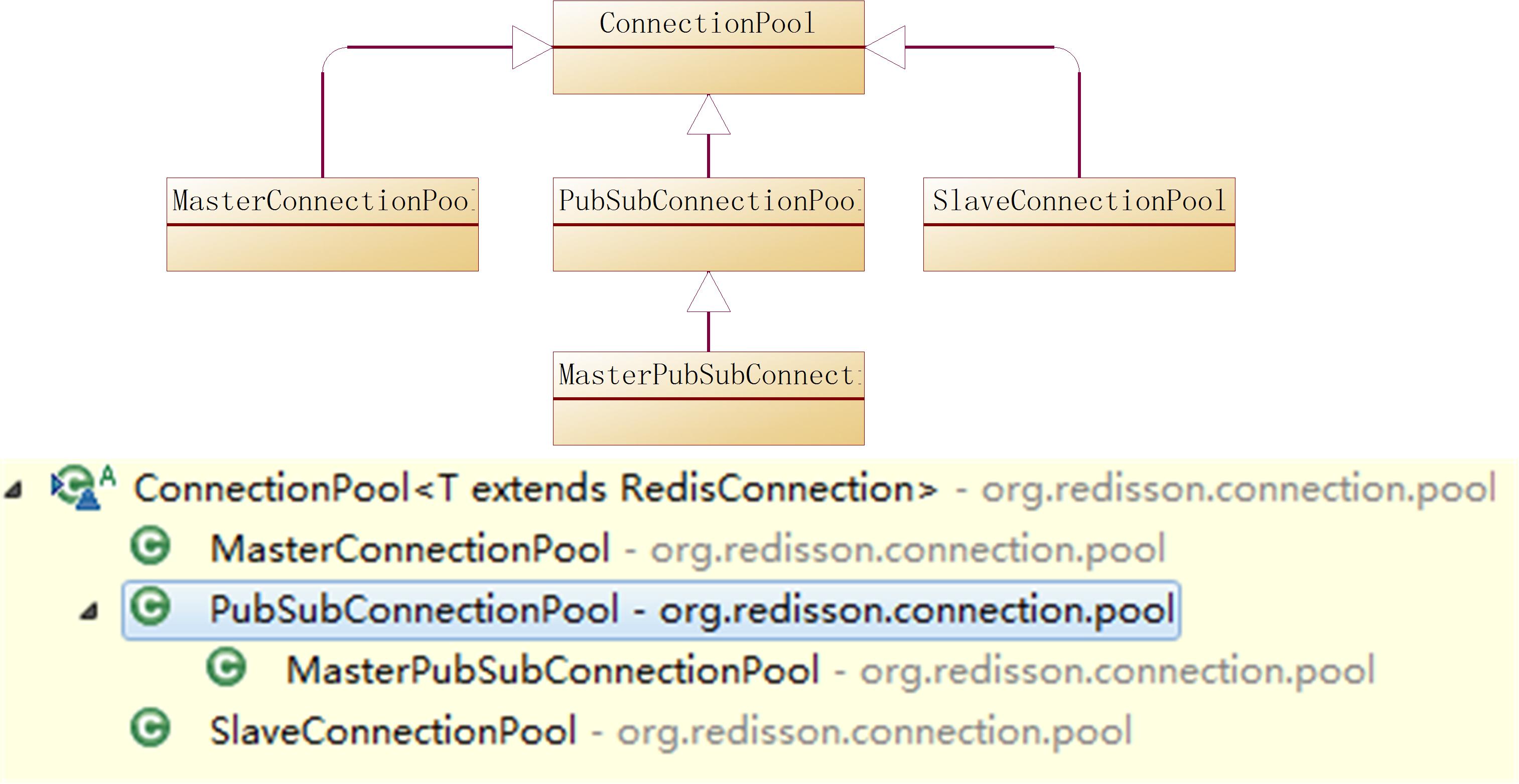

Redisson的4类连接池

这里我们来详细介绍下Redisson的连接池实现类,Redisson里有4种连接池,它们是

-

MasterConnectionPool、

-

MasterPubSubConnectionPool、

-

SlaveConnectionPool

-

PubSubConnectionPool,

Redisson里有4种连接池,它们的父类都是ConnectionPool,其类继承关系图如下:

通过上图我们了解了ConnectionPool类的继承关系图

用一张图来解释ConnectionPool干了些啥,如下图:

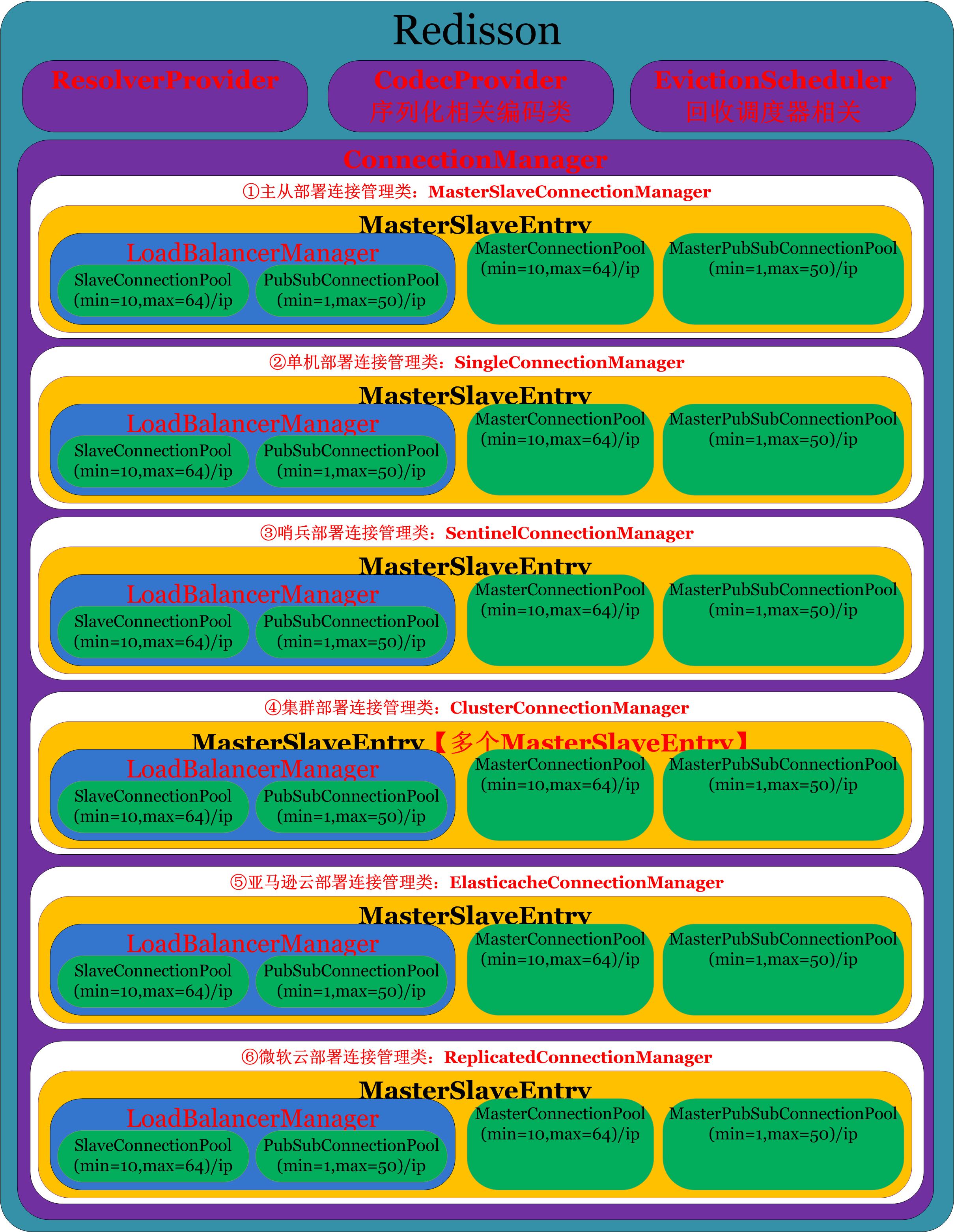

都到这里了,不介意再送一张图了解各种部署方式下的连接池分布了,如下图:

ConnectionPool类的组成

通过上图我们了解了ConnectionPool类的继承关系图,再来一张图来了解下ConnectionPool.java类的组成,如下:

好了,再来图就有点啰嗦了,注释ConnectionPool.java代码如下:

abstract class ConnectionPool<T extends RedisConnection> {

private final Logger log = LoggerFactory.getLogger(getClass());

//维持着连接池对应的redis节点信息

//比如1主2从部署MasterConnectionPool里的entries只有一个主节点(192.168.29.24 6379)

//比如1主2从部署MasterPubSubConnectionPool里的entries为空,因为SubscriptionMode=SubscriptionMode.SLAVE

//比如1主2从部署SlaveConnectionPool里的entries有3个节点(192.168.29.24 6379,192.168.29.24 7000,192.168.29.24 7001,但是注意192.168.29.24 6379冻结属性freezed=true不会参与读操作除非2个从节点全部宕机才参与读操作)

//比如1主2从部署PubSubConnectionPool里的entries有2个节点(192.168.29.24 7000,192.168.29.24 7001),因为SubscriptionMode=SubscriptionMode.SLAVE,主节点不会加入

protected final List<ClientConnectionsEntry> entries = new CopyOnWriteArrayList<ClientConnectionsEntry>();

//持有者RedissonClient的组件ConnectionManager

final ConnectionManager connectionManager;

//持有者RedissonClient的组件ConnectionManager里的MasterSlaveServersConfig

final MasterSlaveServersConfig config;

//持有者RedissonClient的组件ConnectionManager里的MasterSlaveEntry

final MasterSlaveEntry masterSlaveEntry;

//构造函数

public ConnectionPool(MasterSlaveServersConfig config, ConnectionManager connectionManager, MasterSlaveEntry masterSlaveEntry) {

this.config = config;

this.masterSlaveEntry = masterSlaveEntry;

this.connectionManager = connectionManager;

}

//连接池中需要增加对象时候调用此方法

public RFuture<Void> add(final ClientConnectionsEntry entry) {

final RPromise<Void> promise = connectionManager.newPromise();

promise.addListener(new FutureListener<Void>() {

@Override

public void operationComplete(Future<Void> future) throws Exception {

entries.add(entry);

}

});

initConnections(entry, promise, true);

return promise;

}

//初始化连接池中最小连接数

private void initConnections(final ClientConnectionsEntry entry, final RPromise<Void> initPromise, boolean checkFreezed) {

final int minimumIdleSize = getMinimumIdleSize(entry);

if (minimumIdleSize == 0 || (checkFreezed && entry.isFreezed())) {

initPromise.trySuccess(null);

return;

}

final AtomicInteger initializedConnections = new AtomicInteger(minimumIdleSize);

int startAmount = Math.min(50, minimumIdleSize);

final AtomicInteger requests = new AtomicInteger(startAmount);

for (int i = 0; i < startAmount; i++) {

createConnection(checkFreezed, requests, entry, initPromise, minimumIdleSize, initializedConnections);

}

}

//创建连接对象到连接池中

private void createConnection(final boolean checkFreezed, final AtomicInteger requests, final ClientConnectionsEntry entry, final RPromise<Void> initPromise,

final int minimumIdleSize, final AtomicInteger initializedConnections) {

if ((checkFreezed && entry.isFreezed()) || !tryAcquireConnection(entry)) {

int totalInitializedConnections = minimumIdleSize - initializedConnections.get();

Throwable cause = new RedisConnectionException(

"Unable to init enough connections amount! Only " + totalInitializedConnections + " from " + minimumIdleSize + " were initialized. Server: "

+ entry.getClient().getAddr());

initPromise.tryFailure(cause);

return;

}

acquireConnection(entry, new Runnable() {

@Override

public void run() {

RPromise<T> promise = connectionManager.newPromise();

createConnection(entry, promise);

promise.addListener(new FutureListener<T>() {

@Override

public void operationComplete(Future<T> future) throws Exception {

if (future.isSuccess()) {

T conn = future.getNow();

releaseConnection(entry, conn);

}

releaseConnection(entry);

if (!future.isSuccess()) {

int totalInitializedConnections = minimumIdleSize - initializedConnections.get();

String errorMsg;

if (totalInitializedConnections == 0) {

errorMsg = "Unable to connect to Redis server: " + entry.getClient().getAddr();

} else {

errorMsg = "Unable to init enough connections amount! Only " + totalInitializedConnections

+ " from " + minimumIdleSize + " were initialized. Redis server: " + entry.getClient().getAddr();

}

Throwable cause = new RedisConnectionException(errorMsg, future.cause());

initPromise.tryFailure(cause);

return;

}

int value = initializedConnections.decrementAndGet();

if (value == 0) {

log.info("{} connections initialized for {}", minimumIdleSize, entry.getClient().getAddr());

if (!initPromise.trySuccess(null)) {

throw new IllegalStateException();

}

} else if (value > 0 && !initPromise.isDone()) {

if (requests.incrementAndGet() <= minimumIdleSize) {

createConnection(checkFreezed, requests, entry, initPromise, minimumIdleSize, initializedConnections);

}

}

}

});

}

});

}

//连接池中租借出连接对象

public RFuture<T> get(RedisCommand<?> command) {

for (int j = entries.size() - 1; j >= 0; j--) {

final ClientConnectionsEntry entry = getEntry();

if (!entry.isFreezed()

&& tryAcquireConnection(entry)) {

return acquireConnection(command, entry);

}

}

List<InetSocketAddress> failedAttempts = new LinkedList<InetSocketAddress>();

List<InetSocketAddress> freezed = new LinkedList<InetSocketAddress>();

for (ClientConnectionsEntry entry : entries) {

if (entry.isFreezed()) {

freezed.add(entry.getClient().getAddr());

} else {

failedAttempts.add(entry.getClient().getAddr());

}

}

StringBuilder errorMsg = new StringBuilder(getClass().getSimpleName() + " no available Redis entries. ");

if (!freezed.isEmpty()) {

errorMsg.append(" Disconnected hosts: " + freezed);

}

if (!failedAttempts.isEmpty()) {

errorMsg.append(" Hosts disconnected due to `failedAttempts` limit reached: " + failedAttempts);

}

RedisConnectionException exception = new RedisConnectionException(errorMsg.toString());

return connectionManager.newFailedFuture(exception);

}

//连接池中租借出连接对象执行操作RedisCommand

public RFuture<T> get(RedisCommand<?> command, ClientConnectionsEntry entry) {

if ((!entry.isFreezed() || entry.getFreezeReason() == FreezeReason.SYSTEM) &&

tryAcquireConnection(entry)) {

return acquireConnection(command, entry);

}

RedisConnectionException exception = new RedisConnectionException(

"Can't aquire connection to " + entry);

return connectionManager.newFailedFuture(exception);

}

//通过向redis服务端发送PING看是否返回PONG来检测连接

private void ping(RedisConnection c, final FutureListener<String> pingListener) {

RFuture<String> f = c.async(RedisCommands.PING);

f.addListener(pingListener);

}

//归还连接对象到连接池

public void returnConnection(ClientConnectionsEntry entry, T connection) {

if (entry.isFreezed()) {

connection.closeAsync();

} else {

releaseConnection(entry, connection);

}

releaseConnection(entry);

}

//释放连接池中连接对象

protected void releaseConnection(ClientConnectionsEntry entry) {

entry.releaseConnection();

}

//释放连接池中连接对象

protected void releaseConnection(ClientConnectionsEntry entry, T conn) {

entry.releaseConnection(conn);

}

}

Redisson初始化connectionManager

那么这些连接池是在哪里初始化的?如何初始化的?读操作和写操作如何获取连接的?

Redisson接口

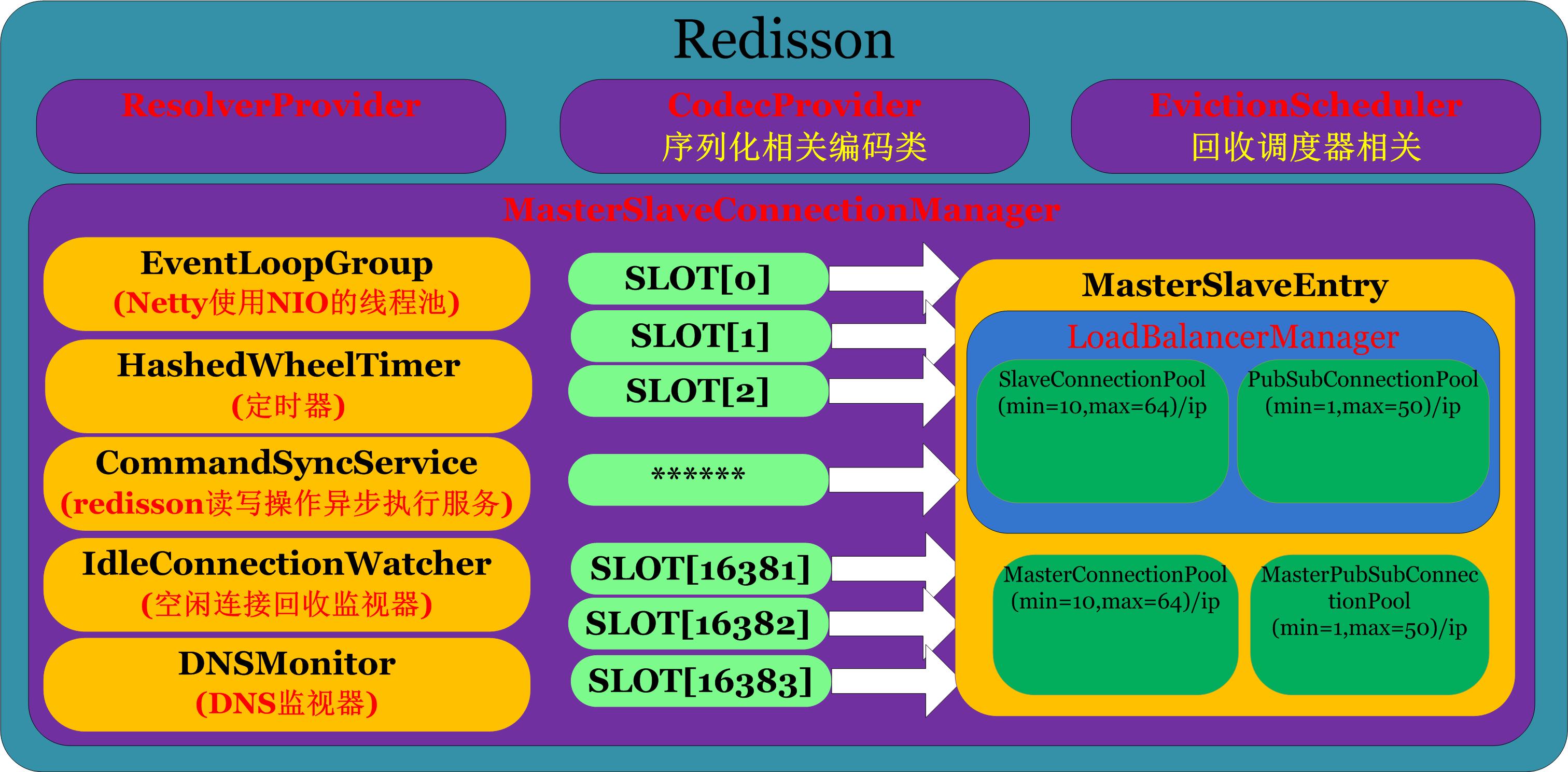

RedissonClient.java是一个接口类,它的实现类是Redisson.java,对于Redisson.java的介绍先以一张Redisson的4大组件关系图开始,如下图:

对Redisson.java的代码注释如下:

/**

* 根据配置Config创建redisson操作类RedissonClient

* @param config for Redisson

* @return Redisson instance

*/

public static RedissonClient create(Config config) {

//调用构造方法

Redisson redisson = new Redisson(config);

if (config.isRedissonReferenceEnabled()) {

redisson.enableRedissonReferenceSupport();

}

return redisson;

}

/**

* Redisson构造方法

* @param config for Redisson

* @return Redisson instance

*/

protected Redisson(Config config) {

//赋值变量config

this.config = config;

//产生一份对于传入config的备份

Config configCopy = new Config(config);

//根据配置config的类型(主从模式、单机模式、哨兵模式、集群模式、亚马逊云模式、微软云模式)而进行不同的初始化

connectionManager = ConfigSupport.createConnectionManager(configCopy);

//连接池对象回收调度器

evictionScheduler = new EvictionScheduler(connectionManager.getCommandExecutor());

//Redisson的对象编码类

codecProvider = configCopy.getCodecProvider();

//Redisson的ResolverProvider,默认为org.redisson.liveobject.provider.DefaultResolverProvider

resolverProvider = configCopy.getResolverProvider();

}

其中与连接池相关的就是ConnectionManager.

ConnectionManager的初始化转交工具类ConfigSupport.java进行,ConfigSupport.java会根据部署方式(主从模式、单机模式、哨兵模式、集群模式、亚马逊云模式、微软云模式)的不同而分别进行。

ConfigSupport.java

这里现将ConfigSupport.java创建ConnectionManager的核心代码注释如下:

/**

* 据配置config的类型(主从模式、单机模式、哨兵模式、集群模式、亚马逊云模式、微软云模式)而进行不同的初始化

* @param configCopy for Redisson

* @return ConnectionManager instance

*/

public static ConnectionManager createConnectionManager(Config configCopy) {

if (configCopy.getMasterSlaveServersConfig() != null) {//配置configCopy类型为主从模式

validate(configCopy.getMasterSlaveServersConfig());

return new MasterSlaveConnectionManager(configCopy.getMasterSlaveServersConfig(), configCopy);

} else if (configCopy.getSingleServerConfig() != null) {//配置configCopy类型为单机模式

validate(configCopy.getSingleServerConfig());

return new SingleConnectionManager(configCopy.getSingleServerConfig(), configCopy);

} else if (configCopy.getSentinelServersConfig() != null) {//配置configCopy类型为哨兵模式

validate(configCopy.getSentinelServersConfig());

return new SentinelConnectionManager(configCopy.getSentinelServersConfig(), configCopy);

} else if (configCopy.getClusterServersConfig() != null) {//配置configCopy类型为集群模式

validate(configCopy.getClusterServersConfig());

return new ClusterConnectionManager(configCopy.getClusterServersConfig(), configCopy);

} else if (configCopy.getElasticacheServersConfig() != null) {//配置configCopy类型为亚马逊云模式

validate(configCopy.getElasticacheServersConfig());

return new ElasticacheConnectionManager(configCopy.getElasticacheServersConfig(), configCopy);

} else if (configCopy.getReplicatedServersConfig() != null) {//配置configCopy类型为微软云模式

validate(configCopy.getReplicatedServersConfig());

return new ReplicatedConnectionManager(configCopy.getReplicatedServersConfig(), configCopy);

} else if (configCopy.getConnectionManager() != null) {//直接返回configCopy自带的默认ConnectionManager

return configCopy.getConnectionManager();

}else {

throw new IllegalArgumentException("server(s) address(es) not defined!");

}

}

上面可以看到根据传入的配置Config.java的不同,会分别创建不同的ConnectionManager的实现类。

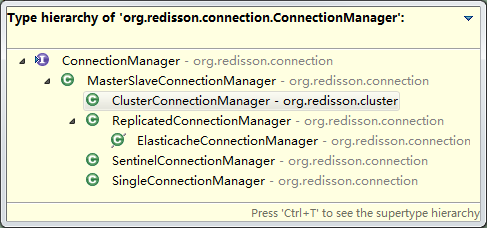

ConnectionManager的6个实现类

这里开始介绍ConnectionManager,ConnectionManager.java是一个接口类,它有6个实现类,分别对应着不同的部署模式(主从模式、单机模式、哨兵模式、集群模式、亚马逊云模式、微软云模式)

如下如所示:

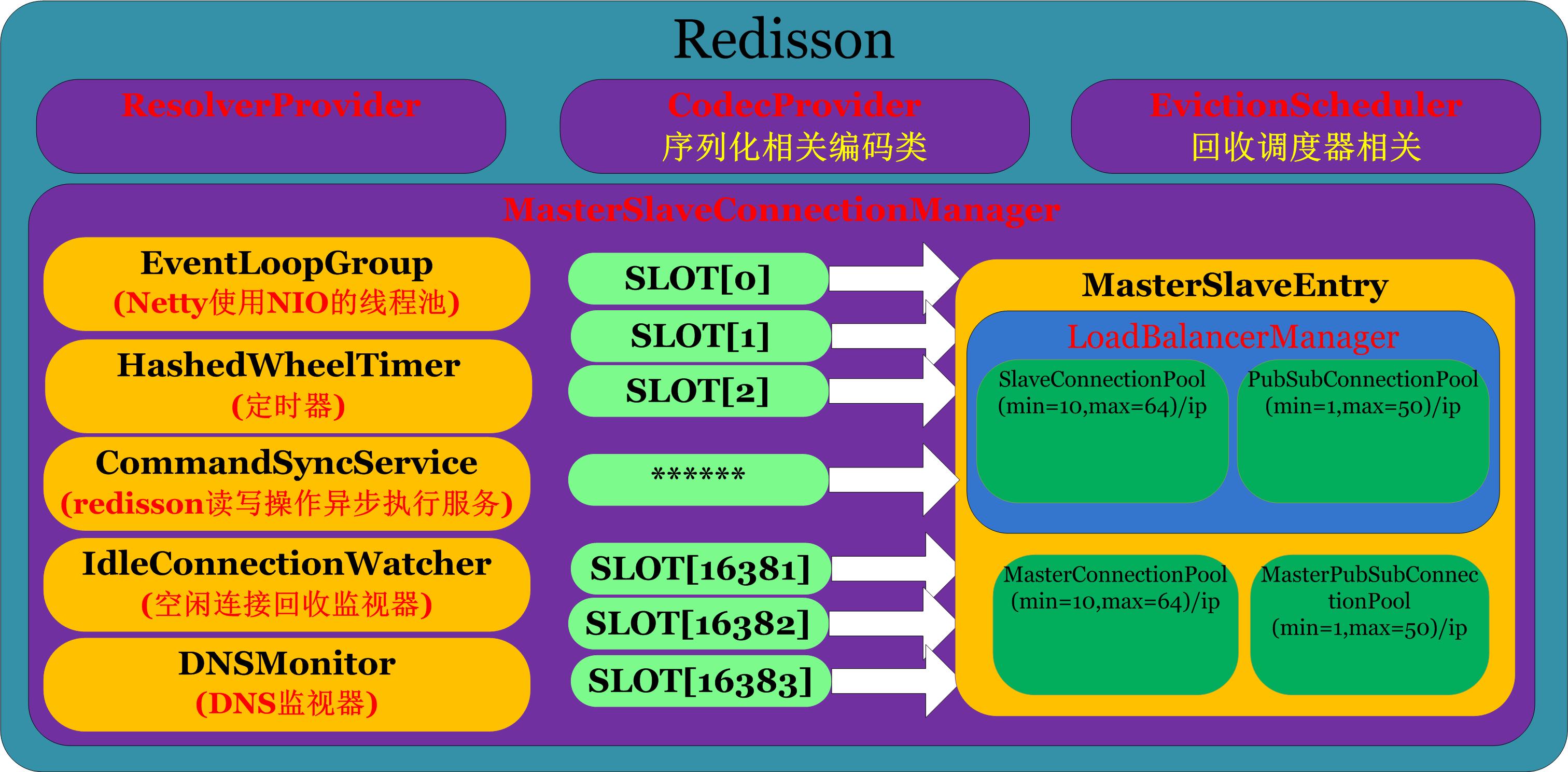

MasterSlaveConnectionManager.java

这里以主从部署方式进行讲解,先通过一张图了解MasterSlaveConnectionManager的组成:

上图中最终要的组件要数MasterSlaveEntry,在后面即将进行介绍,这里注释

MasterSlaveConnectionManager.java的核心代码如下:

/**

* MasterSlaveConnectionManager的构造方法

* @param cfg for MasterSlaveServersConfig

* @param config for Config

*/

public MasterSlaveConnectionManager(MasterSlaveServersConfig cfg, Config config) {

//调用构造方法

this(config);

//

initTimer(cfg);

this.config = cfg;

//初始化MasterSlaveEntry

initSingleEntry();

}

/**

* MasterSlaveConnectionManager的构造方法

* @param cfg for Config

*/

public MasterSlaveConnectionManager(Config cfg) {

//读取redisson的jar中的文件META-INF/MANIFEST.MF,打印出Bundle-Version对应的Redisson版本信息

Version.logVersion();

//EPOLL是linux的多路复用IO模型的增强版本,这里如果启用EPOLL,就让redisson底层netty使用EPOLL的方式,否则配置netty里的NIO非阻塞方式

if (cfg.isUseLinuxNativeEpoll()) {

if (cfg.getEventLoopGroup() == null) {

//使用linux IO非阻塞模型EPOLL

this.group = new EpollEventLoopGroup(cfg.getNettyThreads(), new DefaultThreadFactory("redisson-netty"));

} else {

this.group = cfg.getEventLoopGroup();

}

this.socketChannelClass = EpollSocketChannel.class;

} else {

if (cfg.getEventLoopGroup() == null) {

//使用linux IO非阻塞模型NIO

this.group = new NioEventLoopGroup(cfg.getNettyThreads(), new DefaultThreadFactory("redisson-netty"));

} else {

this.group = cfg.getEventLoopGroup();

}

this.socketChannelClass = NioSocketChannel.class;

}

if (cfg.getExecutor() == null) {

//线程池大小,对于2U 2CPU 8cores/cpu,意思是有2块板子,每个板子上8个物理CPU,那么总计物理CPU个数为16

//对于linux有个超线程概念,意思是每个物理CPU可以虚拟出2个逻辑CPU,那么总计逻辑CPU个数为32

//这里Runtime.getRuntime().availableProcessors()取的是逻辑CPU的个数,所以这里线程池大小会是64

int threads = Runtime.getRuntime().availableProcessors() * 2;

if (cfg.getThreads() != 0) {

threads = cfg.getThreads();

}

executor = Executors.newFixedThreadPool(threads, new DefaultThreadFactory("redisson"));

} else {

executor = cfg.getExecutor();

}

this.cfg = cfg;

this.codec = cfg.getCodec();

//一个可以获取异步执行任务返回值的回调对象,本质是对于java的Future的实现,监控MasterSlaveConnectionManager的shutdown进行一些必要的处理

this.shutdownPromise = newPromise();

//一个持有MasterSlaveConnectionManager的异步执行服务

this.commandExecutor = new CommandSyncService(this);

}

/**

* 初始化定时调度器

* @param config for MasterSlaveServersConfig

*/

protected void initTimer(MasterSlaveServersConfig config) {

//读取超时时间配置信息

int[] timeouts = new int[]{config.getRetryInterval(), config.getTimeout(), config.getReconnectionTimeout()};

Arrays.sort(timeouts);

int minTimeout = timeouts[0];

//设置默认超时时间

if (minTimeout % 100 != 0) {

minTimeout = (minTimeout % 100) / 2;

} else if (minTimeout == 100) {

minTimeout = 50;

} else {

minTimeout = 100;

}

//创建定时调度器

timer = new HashedWheelTimer(Executors.defaultThreadFactory(), minTimeout, TimeUnit.MILLISECONDS, 1024);

// to avoid assertion error during timer.stop invocation

try {

Field leakField = HashedWheelTimer.class.getDeclaredField("leak");

leakField.setAccessible(true);

leakField.set(timer, null);

} catch (Exception e) {

throw new IllegalStateException(e);

}

//检测MasterSlaveConnectionManager的空闲连接的监视器IdleConnectionWatcher,会清理不用的空闲的池中连接对象

connectionWatcher = new IdleConnectionWatcher(this, config);

}

/**

* 创建MasterSlaveConnectionManager的MasterSlaveEntry

*/

protected void initSingleEntry() {

try {

//主从模式下0~16383加入到集合slots

HashSet<ClusterSlotRange> slots = new HashSet<ClusterSlotRange>();

slots.add(singleSlotRange);

MasterSlaveEntry entry;

if (config.checkSkipSlavesInit()) {//ReadMode不为MASTER并且SubscriptionMode不为MASTER才执行

entry = new SingleEntry(slots, this, config);

RFuture<Void> f = entry.setupMasterEntry(config.getMasterAddress());

f.syncUninterruptibly();

} else {//默认主从部署ReadMode=SLAVE,SubscriptionMode=SLAVE,这里会执行

entry = createMasterSlaveEntry(config, slots);

}

//将每个分片0~16383都指向创建的MasterSlaveEntry

for (int slot = singleSlotRange.getStartSlot(); slot < singleSlotRange.getEndSlot() + 1; slot++) {

addEntry(slot, entry);

}

//DNS相关

if (config.getDnsMonitoringInterval() != -1) {

dnsMonitor = new DNSMonitor(this, Collections.singleton(config.getMasterAddress()),

config.getSlaveAddresses(), config.getDnsMonitoringInterval());

dnsMonitor.start();

}

} catch (RuntimeException e) {

stopThreads();

throw e;

}

}

/**

* MasterSlaveEntry的构造方法

* @param config for MasterSlaveServersConfig

* @param slots for HashSet<ClusterSlotRange>

* @return MasterSlaveEntry

*/

protected MasterSlaveEntry createMasterSlaveEntry(MasterSlaveServersConfig config, HashSet<ClusterSlotRange> slots) {

//创建MasterSlaveEntry

MasterSlaveEntry entry = new MasterSlaveEntry(slots, this, config);

//从节点连接池SlaveConnectionPool和PubSubConnectionPool的默认的最小连接数初始化

List<RFuture<Void>> fs = entry.initSlaveBalancer(java.util.Collections.<URI>emptySet());

for (RFuture<Void> future : fs) {

future.syncUninterruptibly();

}

主节点连接池MasterConnectionPool和MasterPubSubConnectionPool的默认的最小连接数初始化

RFuture<Void> f = entry.setupMasterEntry(config.getMasterAddress());

f.syncUninterruptibly();

return entry;

}

上面个人觉得有两处代码值得我们特别关注,特别说明如下:

- entry.initSlaveBalancer:从节点连接池SlaveConnectionPool和PubSubConnectionPool的默认的最小连接数初始化。

- entry.setupMasterEntry:主节点连接池MasterConnectionPool和MasterPubSubConnectionPool的默认的最小连接数初始化。

MasterSlaveEntry.java

用一张图来解释MasterSlaveEntry的组件如下:

MasterSlaveEntry.java里正是我们一直在寻找着的四个连接池

-

MasterConnectionPool、

-

MasterPubSubConnectionPool、

-

SlaveConnectionPool和

-

PubSubConnectionPool,

MasterSlaveEntry.java的核心代码如下:

/**

* MasterSlaveEntry的构造方法

* @param slotRanges for Set<ClusterSlotRange>

* @param connectionManager for ConnectionManager

* @param config for MasterSlaveServersConfig

*/

public MasterSlaveEntry(Set<ClusterSlotRange> slotRanges, ConnectionManager connectionManager, MasterSlaveServersConfig config) {

//主从模式下0~16383加入到集合slots

for (ClusterSlotRange clusterSlotRange : slotRanges) {

for (int i = clusterSlotRange.getStartSlot(); i < clusterSlotRange.getEndSlot() + 1; i++) {

slots.add(i);

}

}

//赋值MasterSlaveConnectionManager给connectionManager

this.connectionManager = connectionManager;

//赋值config

this.config = config;

//创建LoadBalancerManager

//其实LoadBalancerManager里持有者从节点的SlaveConnectionPool和PubSubConnectionPool

//并且此时连接池里还没有初始化默认的最小连接数

slaveBalancer = new LoadBalancerManager(config, connectionManager, this);

//创建主节点连接池MasterConnectionPool,此时连接池里还没有初始化默认的最小连接数

writeConnectionHolder = new MasterConnectionPool(config, connectionManager, this);

//创建主节点连接池MasterPubSubConnectionPool,此时连接池里还没有初始化默认的最小连接数

pubSubConnectionHolder = new MasterPubSubConnectionPool(config, connectionManager, this);

}

/**

* 从节点连接池SlaveConnectionPool和PubSubConnectionPool的默认的最小连接数初始化

* @param disconnectedNodes for Collection<URI>

* @return List<RFuture<Void>>

*/

public List<RFuture<Void>> initSlaveBalancer(Collection<URI> disconnectedNodes) {

//这里freezeMasterAsSlave=true

boolean freezeMasterAsSlave = !config.getSlaveAddresses().isEmpty() && !config.checkSkipSlavesInit() && disconnectedNodes.size() < config.getSlaveAddresses().size();

List<RFuture<Void>> result = new LinkedList<RFuture<Void>>();

//把主节点当作从节点处理,因为默认ReadMode=ReadMode.SLAVE,所以这里不会添加针对该节点的连接池

RFuture<Void> f = addSlave(config.getMasterAddress(), freezeMasterAsSlave, NodeType.MASTER);

result.add(f);

//读取从节点的地址信息,然后针对每个从节点地址创建SlaveConnectionPool和PubSubConnectionPool

//SlaveConnectionPool【初始化10个RedisConnection,最大可以扩展至64个】

//PubSubConnectionPool【初始化1个RedisPubSubConnection,最大可以扩展至50个】

for (URI address : config.getSlaveAddresses()) {

f = addSlave(address, disconnectedNodes.contains(address), NodeType.SLAVE);

result.add(f);

}

return result;

}

/**

* 从节点连接池SlaveConnectionPool和PubSubConnectionPool的默认的最小连接数初始化

* @param address for URI

* @param freezed for boolean

* @param nodeType for NodeType

* @return RFuture<Void>

*/

private RFuture<Void> addSlave(URI address, boolean freezed, NodeType nodeType) {

//创建到从节点的连接RedisClient

RedisClient client = connectionManager.createClient(NodeType.SLAVE, address);

ClientConnectionsEntry entry = new ClientConnectionsEntry(client,

this.config.getSlaveConnectionMinimumIdleSize(),

this.config.getSlaveConnectionPoolSize(),

this.config.getSubscriptionConnectionMinimumIdleSize(),

this.config.getSubscriptionConnectionPoolSize(), connectionManager, nodeType);

//默认只有主节点当作从节点是会设置freezed=true

if (freezed) {

synchronized (entry) {

entry.setFreezed(freezed);

entry.setFreezeReason(FreezeReason.SYSTEM);

}

}

//调用slaveBalancer来对从节点连接池SlaveConnectionPool和PubSubConnectionPool的默认的最小连接数初始化

return slaveBalancer.add(entry);

}

/**

* 主节点连接池MasterConnectionPool和MasterPubSubConnectionPool的默认的最小连接数初始化

* @param address for URI

* @return RFuture<Void>

*/

public RFuture<Void> setupMasterEntry(URI address) {

//创建到主节点的连接RedisClient

RedisClient client = connectionManager.createClient(NodeType.MASTER, address);

masterEntry = new ClientConnectionsEntry(

client,

config.getMasterConnectionMinimumIdleSize(),

config.getMasterConnectionPoolSize(),

config.getSubscriptionConnectionMinimumIdleSize(),

config.getSubscriptionConnectionPoolSize(),

connectionManager,

NodeType.MASTER);

//如果配置的SubscriptionMode=SubscriptionMode.MASTER就初始化MasterPubSubConnectionPool

//默认SubscriptionMode=SubscriptionMode.SLAVE,MasterPubSubConnectionPool这里不会初始化最小连接数

if (config.getSubscriptionMode() == SubscriptionMode.MASTER) {

//MasterPubSubConnectionPool【初始化1个RedisPubSubConnection,最大可以扩展至50个】

RFuture<Void> f = writeConnectionHolder.add(masterEntry);

RFuture<Void> s = pubSubConnectionHolder.add(masterEntry);

return CountListener.create(s, f);

}

//调用MasterConnectionPool使得连接池MasterConnectionPool里的对象最小个数为10个

//MasterConnectionPool【初始化10个RedisConnection,最大可以扩展至64个】

return writeConnectionHolder.add(masterEntry);

}

上面代码个人觉得有四个地方值得我们特别关注,它们是一个连接池创建对象的入口,列表如下:

- writeConnectionHolder.add(masterEntry):其实writeConnectionHolder的类型就是MasterConnectionPool,这里是连接池MasterConnectionPool里添加对象

- pubSubConnectionHolder.add(masterEntry):其实pubSubConnectionHolder的类型是MasterPubSubConnectionPool,这里是连接池MasterPubSubConnectionPool添加对象

- slaveConnectionPool.add(entry):这里是连接池SlaveConnectionPool里添加对象

- pubSubConnectionPool.add(entry):这里是连接池PubSubConnectionPool里添加对象

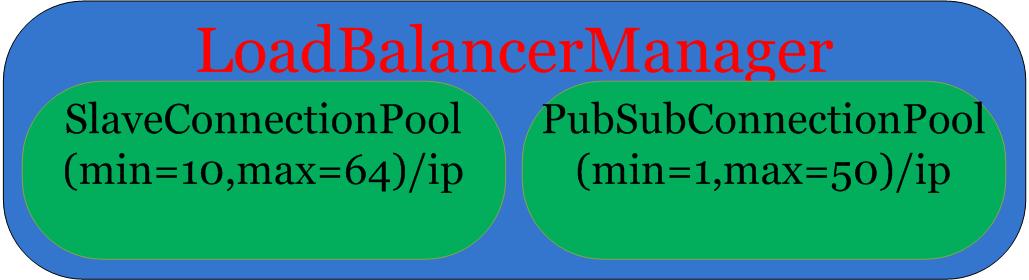

LoadBalancerManager.java

图解LoadBalancerManager.java的内部组成如下:

LoadBalancerManager.java里面有着从节点相关的两个重要的连接池SlaveConnectionPool和PubSubConnectionPool,这里注释LoadBalancerManager.java的核心代码如下:

/**

* LoadBalancerManager的构造方法

* @param config for MasterSlaveServersConfig

* @param connectionManager for ConnectionManager

* @param entry for MasterSlaveEntry

*/

public LoadBalancerManager(MasterSlaveServersConfig config, ConnectionManager connectionManager, MasterSlaveEntry entry) {

//赋值connectionManager

this.connectionManager = connectionManager;

//创建连接池SlaveConnectionPool

slaveConnectionPool = new SlaveConnectionPool(config, connectionManager, entry);

//创建连接池PubSubConnectionPool

pubSubConnectionPool = new PubSubConnectionPool(config, connectionManager, entry);

}

/**

* LoadBalancerManager的连接池SlaveConnectionPool和PubSubConnectionPool里池化对象添加方法,也即池中需要对象时,调用此方法添加

* @param entry for ClientConnectionsEntry

* @return RFuture<Void>

*/

public RFuture<Void> add(final ClientConnectionsEntry entry) {

final RPromise<Void> result = connectionManager.newPromise();

//创建一个回调监听器,在池中对象创建失败时,进行2次尝试

FutureListener<Void> listener = new FutureListener<Void>() {

AtomicInteger counter = new AtomicInteger(2);

@Override

public void operationComplete(Future<Void> future) throws Exception {

if (!future.isSuccess()) {

result.tryFailure(future.cause());

return;

}

if (counter.decrementAndGet() == 0) {

String addr = entry.getClient().getIpAddr();

ip2Entry.put(addr, entry);

result.trySuccess(null);

}

}

};

//调用slaveConnectionPool添加RedisConnection对象到池中

RFuture<Void> slaveFuture = slaveConnectionPool.add(entry);

slaveFuture.addListener(listener);

//调用pubSubConnectionPool添加RedisPubSubConnection对象到池中

RFuture<Void> pubSubFuture = pubSubConnectionPool.add(entry);

pubSubFuture.addListener(listener);

return result;

}

至此,我们已经了解了开篇提到的四个连接池是在哪里创建的。

连接池的初始化

ConnectionPool.java里获取读写操作的连接,是遍历ConnectionPool里维持的ClientConnectionsEntry列表,找到一非冻结的ClientConnectionsEntry;

然后调用ClientConnectionsEntry里的freeConnectionsCounter尝试将值减1,如果成功,说明连接池中可以获取到连接,那么就从ClientConnectionsEntry里获取一个连接出来,如果拿不到连接,会调用ClientConnectionsEntry创建一个新连接放置到连接池中,并返回此连接

回顾一下 ClientConnectionsEntry的组成图:

上面的代码说明如果 ClientConnectionsEntry里的 freeConnections有空闲连接,那么直接返回该连接,如果没有那么调用 RedisClient.connectAsync创建一个新的连接

/**

* 真正从连接池中获取连接

* @param entry for ClientConnectionsEntry

* @param promise for RPromise<T>

*/

private void connectTo(ClientConnectionsEntry entry, RPromise<T> promise) {

if (promise.isDone()) {

releaseConnection(entry);

return;

}

//从连接池中取出一个连接

T conn = poll(entry);

if (conn != null) {

if (!conn.isActive()) {

promiseFailure(entry, promise, conn);

return;

}

connectedSuccessful(entry, promise, conn);

return;

}

//如果仍然获取不到连接,可能连接池中连接对象都被租借了,这里开始创建一个新的连接对象放到连接池中

createConnection(entry, promise);

}

/**

* 从连接池中获取连接

* @param entry for ClientConnectionsEntry

* @return T

*/

protected T poll(ClientConnectionsEntry entry) {

return (T) entry.pollConnection();

}

/**

* 调用ClientConnectionsEntry创建一个连接放置到连接池中并返回此连接

* @param entry for ClientConnectionsEntry

* @param promise for RPromise<T>

*/

private void createConnection(final ClientConnectionsEntry entry, final RPromise<T> promise) {

//调用ClientConnectionsEntry创建一个连接放置到连接池中并返回此连接

RFuture<T> connFuture = connect(entry);

connFuture.addListener(new FutureListener<T>() {

@Override

public void operationComplete(Future<T> future) throws Exception {

if (!future.isSuccess()) {

promiseFailure(entry, promise, future.cause());

return;

}

T conn = future.getNow();

if (!conn.isActive()) {

promiseFailure(entry, promise, conn);

return;

}

connectedSuccessful(entry, promise, conn);

}

});

}

从freeConnections里获取一个连接并返回给读写操作使用

/**

* ClientConnectionsEntry里从freeConnections里获取一个连接并返回给读写操作使用

*/

public RedisConnection pollConnection() {

return freeConnections.poll();

}

新创建一个连接对象返回给读写操作使用

/**

* ClientConnectionsEntry里新创建一个连接对象返回给读写操作使用

*/

public RFuture<RedisConnection> connect() {

//调用RedisClient利用netty连接redis服务端,将返回的netty的outboundchannel包装成RedisConnection并返回

RFuture<RedisConnection> future = client.connectAsync();

future.addListener(new FutureListener<RedisConnection>() {

@Override

public void operationComplete(Future<RedisConnection> future) throws Exception {

if (!future.isSuccess()) {

return;

}

RedisConnection conn = future.getNow();

onConnect(conn);

log.debug("new connection created: {}", conn);

}

});

return future;

}

RedisClient管理Netty连接

使用java里的网络编程框架Netty连接redis服务端 RedisClient.java

package org.redisson.client;

...

/**

* 使用java里的网络编程框架Netty连接redis服务端

* 作者: Nikita Koksharov

*/

public class RedisClient {

private final Bootstrap bootstrap;//Netty的工具类Bootstrap,用于连接建立等作用

private final Bootstrap pubSubBootstrap;//Netty的工具类Bootstrap,用于连接建立等作用

private final InetSocketAddress addr;//socket连接的地址

//channels是netty提供的一个全局对象,里面记录着当前socket连接上的所有处于可用状态的连接channel

//channels会自动监测里面的channel,当channel断开时,会主动踢出该channel,永远保留当前可用的channel列表

private final ChannelGroup channels = new DefaultChannelGroup(GlobalEventExecutor.INSTANCE);

private ExecutorService executor;//REACOTR模型的java异步执行线程池

private final long commandTimeout;//超时时间

private Timer timer;//定时器

private boolean hasOwnGroup;

private RedisClientConfig config;//redis连接配置信息

//构造方法

public static RedisClient create(RedisClientConfig config) {

if (config.getTimer() == null) {

config.setTimer(new HashedWheelTimer());

}

return new RedisClient(config);

}

//构造方法

private RedisClient(RedisClientConfig config) {

this.config = config;

this.executor = config.getExecutor();

this.timer = config.getTimer();

addr = new InetSocketAddress(config.getAddress().getHost(), config.getAddress().getPort());

bootstrap = createBootstrap(config, Type.PLAIN);

pubSubBootstrap = createBootstrap(config, Type.PUBSUB);

this.commandTimeout = config.getCommandTimeout();

}

//java的网路编程框架Netty工具类Bootstrap初始化

private Bootstrap createBootstrap(RedisClientConfig config, Type type) {

Bootstrap bootstrap = new Bootstrap()

.channel(config.getSocketChannelClass())

.group(config.getGroup())

.remoteAddress(addr);

//注册netty相关socket数据处理RedisChannelInitializer

bootstrap.handler(new RedisChannelInitializer(bootstrap, config, this, channels, type));

//设置超时时间

bootstrap.option(ChannelOption.CONNECT_TIMEOUT_MILLIS, config.getConnectTimeout());

return bootstrap;

}

//构造方法

@Deprecated

public RedisClient(String address) {

this(URIBuilder.create(address));

}

//构造方法

@Deprecated

public RedisClient(URI address) {

this(new HashedWheelTimer(), Executors.newFixedThreadPool(Runtime.getRuntime().availableProcessors() * 2), new NioEventLoopGroup(), address);

hasOwnGroup = true;

}

//构造方法

@Deprecated

public RedisClient(Timer timer, ExecutorService executor, EventLoopGroup group, URI address) {

this(timer, executor, group, address.getHost(), address.getPort());

}

//构造方法

@Deprecated

public RedisClient(String host, int port) {

this(new HashedWheelTimer(), Executors.newFixedThreadPool(Runtime.getRuntime().availableProcessors() * 2), new NioEventLoopGroup(), NioSocketChannel.class, host, port, 10000, 10000);

hasOwnGroup = true;

}

//构造方法

@Deprecated

public RedisClient(Timer timer, ExecutorService executor, EventLoopGroup group, String host, int port) {

this(timer, executor, group, NioSocketChannel.class, host, port, 10000, 10000);

}

//构造方法

@Deprecated

public RedisClient(String host, int port, int connectTimeout, int commandTimeout) {

this(new HashedWheelTimer(), Executors.newFixedThreadPool(Runtime.getRuntime().availableProcessors() * 2), new NioEventLoopGroup(), NioSocketChannel.class, host, port, connectTimeout, commandTimeout);

}

//构造方法

@Deprecated

public RedisClient(final Timer timer, ExecutorService executor, EventLoopGroup group, Class<? extends SocketChannel> socketChannelClass, String host, int port,

int connectTimeout, int commandTimeout) {

RedisClientConfig config = new RedisClientConfig();

config.setTimer(timer).setExecutor(executor).setGroup(group).setSocketChannelClass(socketChannelClass)

.setAddress(host, port).setConnectTimeout(connectTimeout).setCommandTimeout(commandTimeout);

this.config = config;

this.executor = config.getExecutor();

this.timer = config.getTimer();

addr = new InetSocketAddress(config.getAddress().getHost(), config.getAddress().getPort());

//java的网路编程框架Netty工具类Bootstrap初始化

bootstrap = createBootstrap(config, Type.PLAIN);

pubSubBootstrap = createBootstrap(config, Type.PUBSUB);

this.commandTimeout = config.getCommandTimeout();

}

//获取连接的IP地址

public String getIpAddr() {

return addr.getAddress().getHostAddress() + ":" + addr.getPort();

}

//获取socket连接的地址

public InetSocketAddress getAddr() {

return addr;

}

//获取超时时间

public long getCommandTimeout() {

return commandTimeout;

}

//获取netty的线程池

public EventLoopGroup getEventLoopGroup() {

return bootstrap.config().group();

}

//获取redis连接配置

public RedisClientConfig getConfig() {

return config;

}

//获取连接RedisConnection

public RedisConnection connect() {

try {

return connectAsync().syncUninterruptibly().getNow();

} catch (Exception e) {

throw new RedisConnectionException("Unable to connect to: " + addr, e);

}

}

//启动netty去连接redis服务端,设置java的Future尝试将netty连接上的OutBoundChannel包装成RedisConnection并返回RedisConnection

public RFuture<RedisConnection> connectAsync() {

final RPromise<RedisConnection> f = new RedissonPromise<RedisConnection>();

//netty连接redis服务端

ChannelFuture channelFuture = bootstrap.connect();

channelFuture.addListener(new ChannelFutureListener() {

@Override

public void operationComplete(final ChannelFuture future) throws Exception {

if (future.isSuccess()) {

//将netty连接上的OutBoundChannel包装成RedisConnection并返回RedisConnection

final RedisConnection c = RedisConnection.getFrom(future.channel());

c.getConnectionPromise().addListener(new FutureListener<RedisConnection>() {

@Override

public void operationComplete(final Future<RedisConnection> future) throws Exception {

bootstrap.config().group().execute(new Runnable() {

@Override

public void run() {

if (future.isSuccess()) {

if (!f.trySuccess(c)) {

c.closeAsync();

}

} else {

f.tryFailure(future.cause());

c.closeAsync();

}

}

});

}

});

} else {

bootstrap.config().group().execute(new Runnable() {

public void run() {

f.tryFailure(future.cause());

}

});

}

}

});

return f;

}

//获取订阅相关连接RedisPubSubConnection

public RedisPubSubConnection connectPubSub() {

try {

return connectPubSubAsync().syncUninterruptibly().getNow();

} catch (Exception e) {

throw new RedisConnectionException("Unable to connect to: " + addr, e);

}

}

//启动netty去连接redis服务端,设置java的Future尝试将netty连接上的OutBoundChannel包装成RedisPubSubConnection并返回RedisPubSubConnection

public RFuture<RedisPubSubConnection> connectPubSubAsync() {

final RPromise<RedisPubSubConnection> f = new RedissonPromise<RedisPubSubConnection>();

//netty连接redis服务端

ChannelFuture channelFuture = pubSubBootstrap.connect();

channelFuture.addListener(new ChannelFutureListener() {

@Override

public void operationComplete(final ChannelFuture future) throws Exception {

if (future.isSuccess()) {

//将netty连接上的OutBoundChannel包装成RedisPubSubConnection并返回RedisPubSubConnection