09 Hive安装与配置

一、hive下载

1.下载并解压hive源程序,重命名,权限

hive下载官网:http://www.apache.org/dyn/closer.cgi/hive/

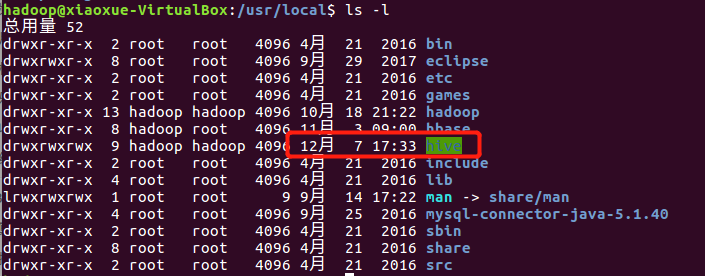

sudo tar -zxvf ./apache-hive-1.2.1-bin.tar.gz -C /usr/local #解压到/usr/local中

cd /usr/local

sudo mv apache-hive-1.2.1-bin hive #将文件夹名改为hive

sudo chown -R hadoop:hadoop hive #修改文件权限

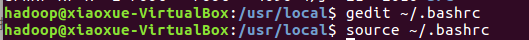

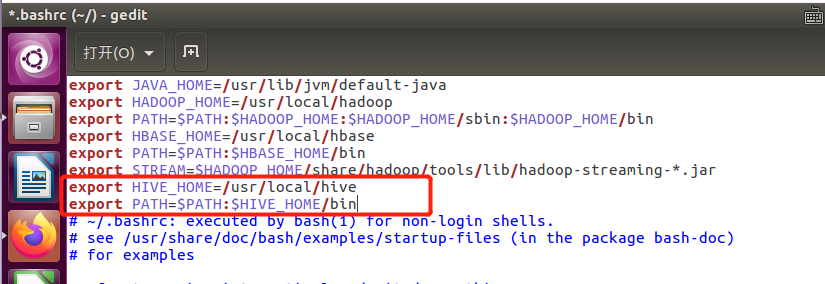

2.配置环境变量

编辑~/.bashrc配置,将hive命令加入到环境变量中去,配置完成后使其生效

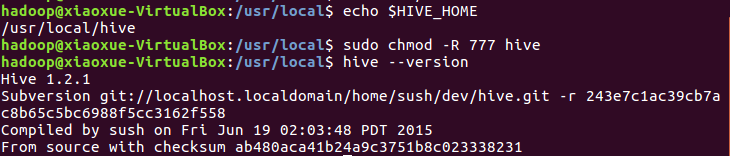

查看路径;修改文件夹权限;查看版本

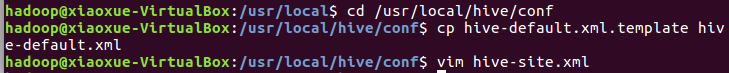

3.修改配置文件

1 <?xml version="1.0" encoding="UTF-8" standalone="no"?> 2 <?xml-stylesheet type="text/xsl" href="configuration.xsl"?> 3 <configuration> 4 <property> 5 <name>javax.jdo.option.ConnectionURL</name> 6 <value>jdbc:mysql://localhost:3306/hive?createDatabaseIfNotExist=true</value> 7 <description>JDBC connect string for a JDBC metastore</description> 8 </property> 9 <property> 10 <name>javax.jdo.option.ConnectionDriverName</name> 11 <value>com.mysql.jdbc.Driver</value> 12 <description>Driver class name for a JDBC metastore</description> 13 </property> 14 <property> 15 <name>javax.jdo.option.ConnectionUserName</name> 16 <value>hive</value> 17 <description>username to use against metastore database</description> 18 </property> 19 <property> 20 <name>javax.jdo.option.ConnectionPassword</name> 21 <value>hive</value> 22 <description>password to use against metastore database</description> 23 </property> 24 </configuration>

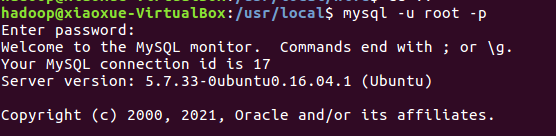

二、安装MySQL并配置MySQLl驱动

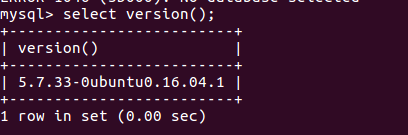

1. 查看MySQL版本和jar包版本

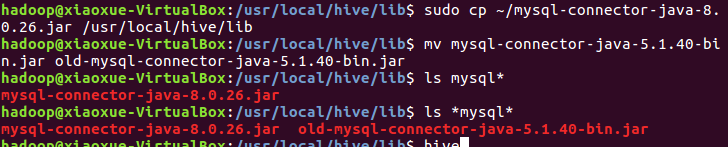

2.选择新版JAR包:

1)将jar包拷贝到/usr/local/hive/lib目录下

2)删除mysql-connector-java-5.1.40-bin.jar

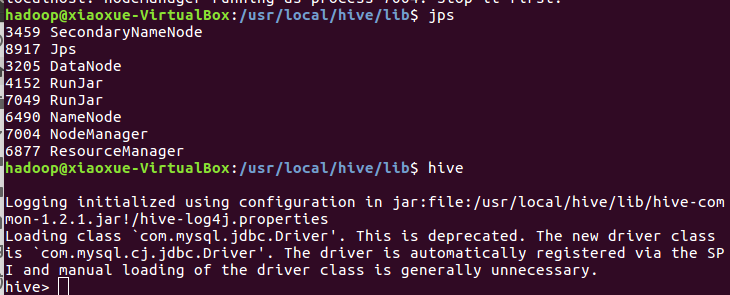

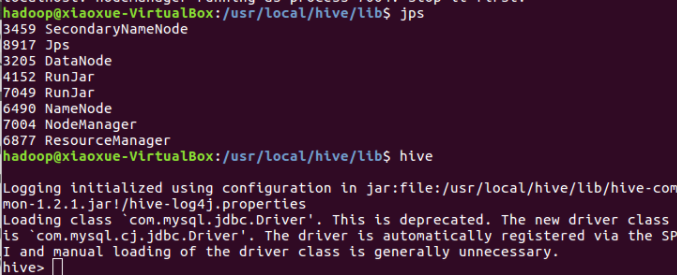

3)启动hadoop集进入hive

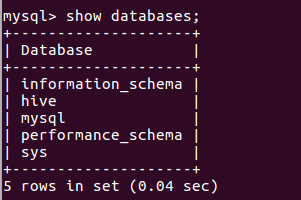

4)在mysql新建hive数据库 show databases;

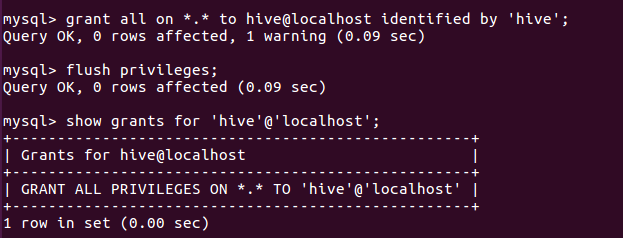

5)配置mysql允许hive接入 show grants for 'hive'@'localhost';

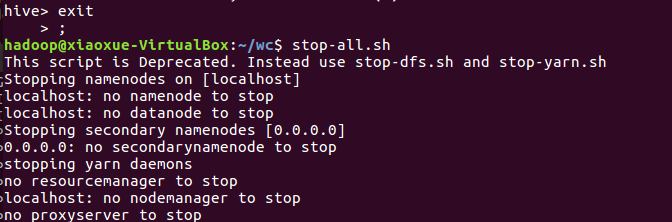

启停启动Hadoop--启动Hive--退出Hive--停止Hadoop

二、Hive操作

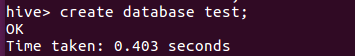

- hive创建与查看数据库

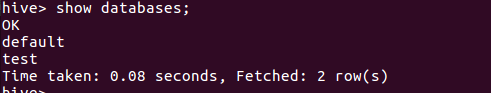

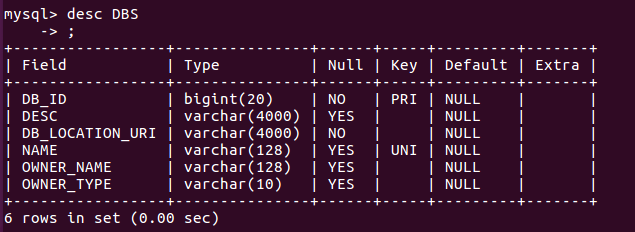

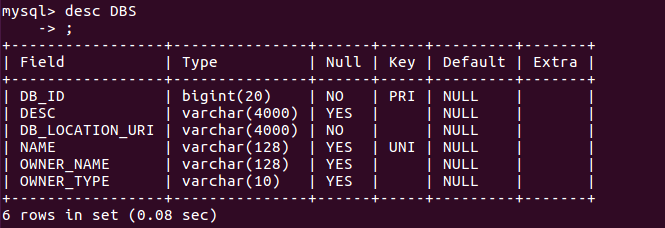

2.mysql查看hive元数据表DBS

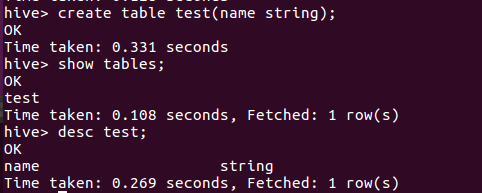

3.hive创建与查看表

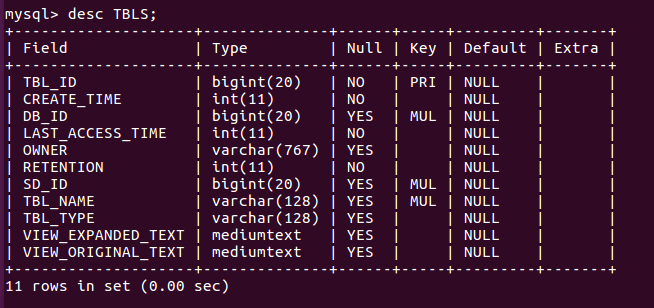

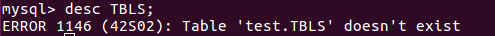

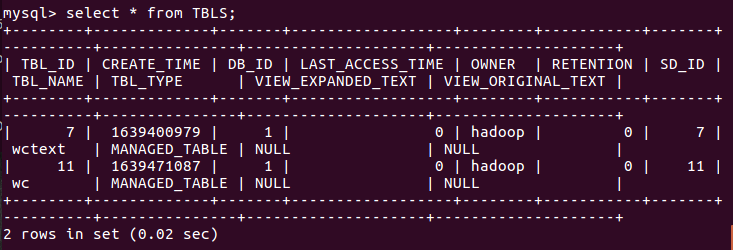

4.mysql查看hive元数据表TBLS

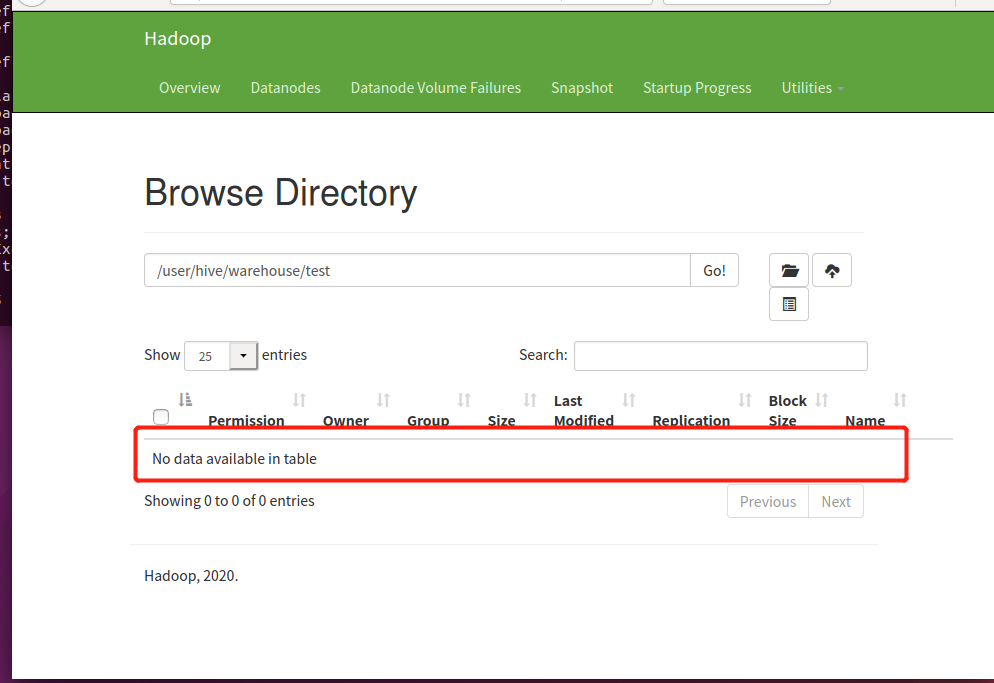

5.hdfs查看表文件位置

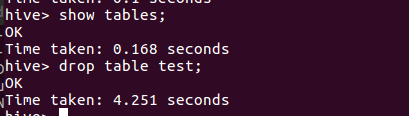

6.hive删除表

7.mysql查看hive元数据表TBLS

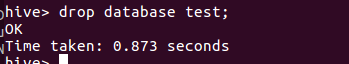

8.hive删除数据库

9.mysql查看hive元数据表DBS

10.hdfs查看表文件夹变化

三、hive进行词频统计

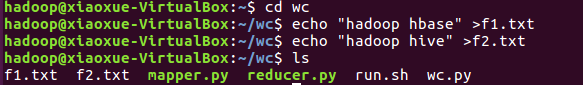

- 准备txt文件

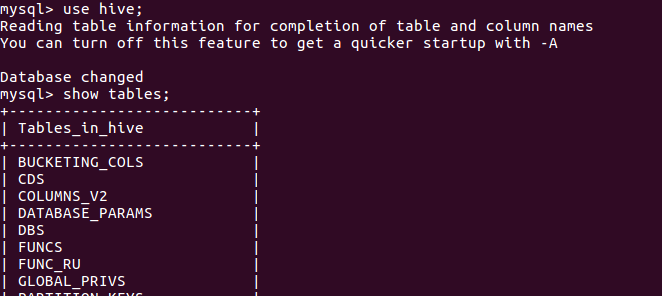

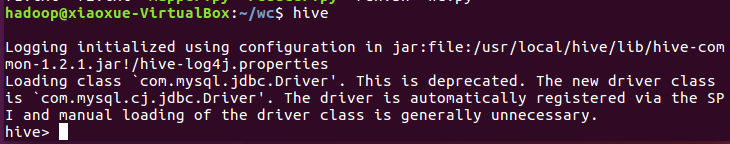

2.启动hadoop,启动hive

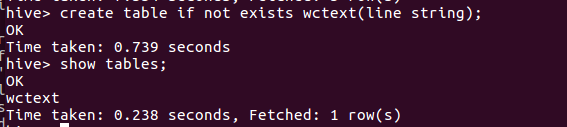

3.创建并查看文本表 create table

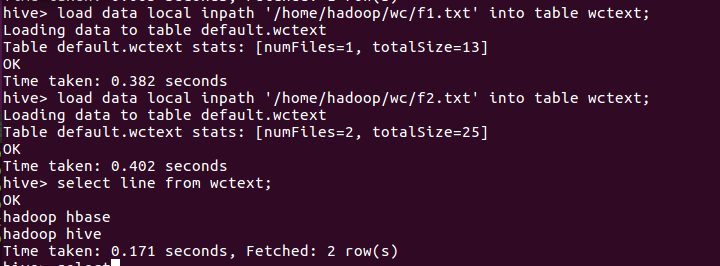

4.导入文件的数据到文本表中 load data local inpat

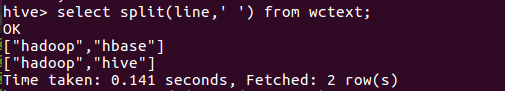

5.分割文本 split

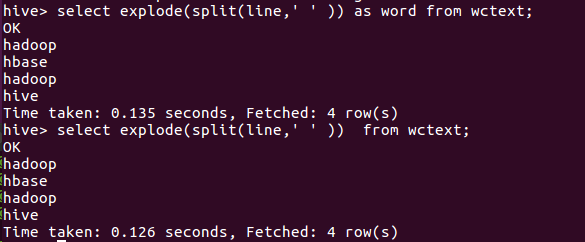

6.行转列explode

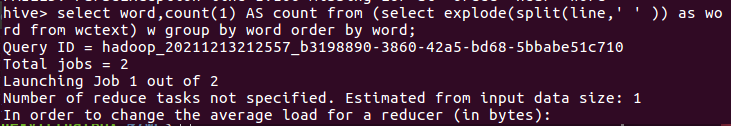

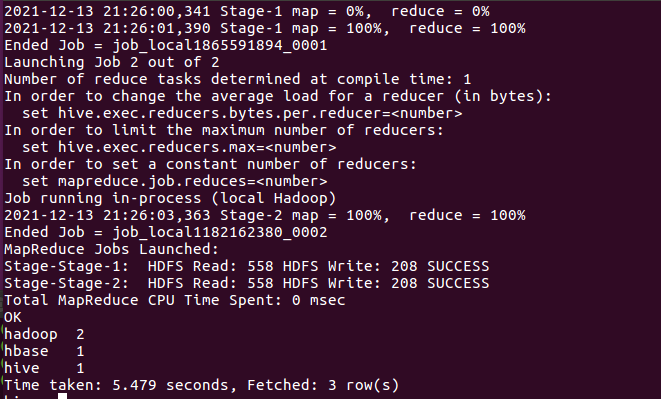

7.统计词频group by

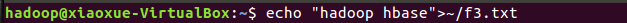

8.准备txt文件

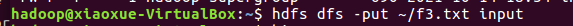

9.上传文件至hdfs

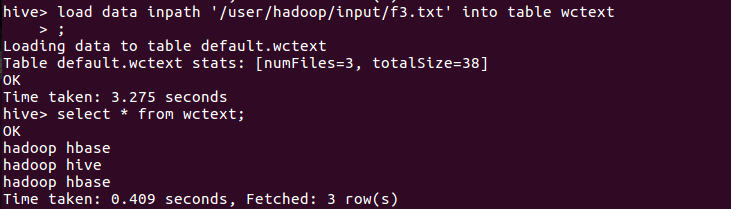

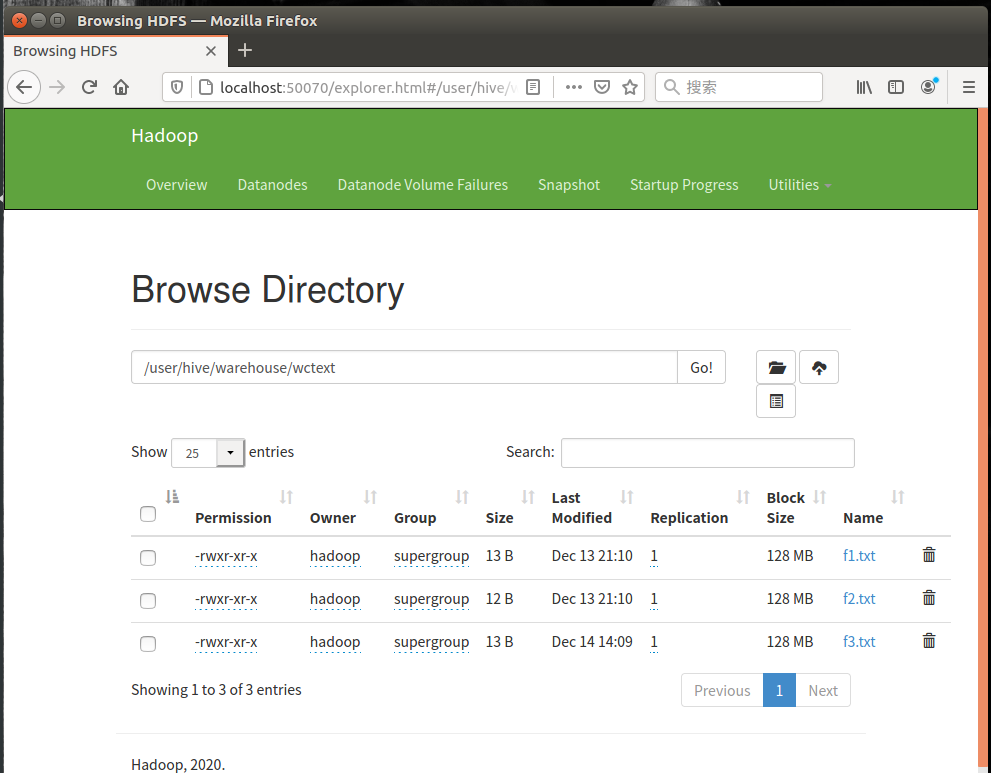

10.从hdfs导入文件内容到表wctext, 并查看hdfs源文件,hfds数据库文件

-

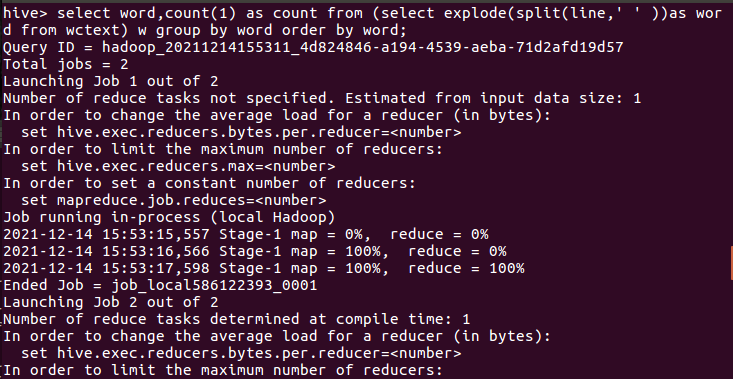

11.统计词频

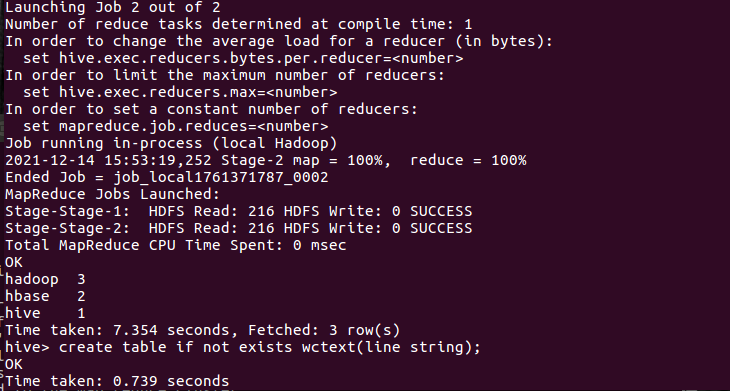

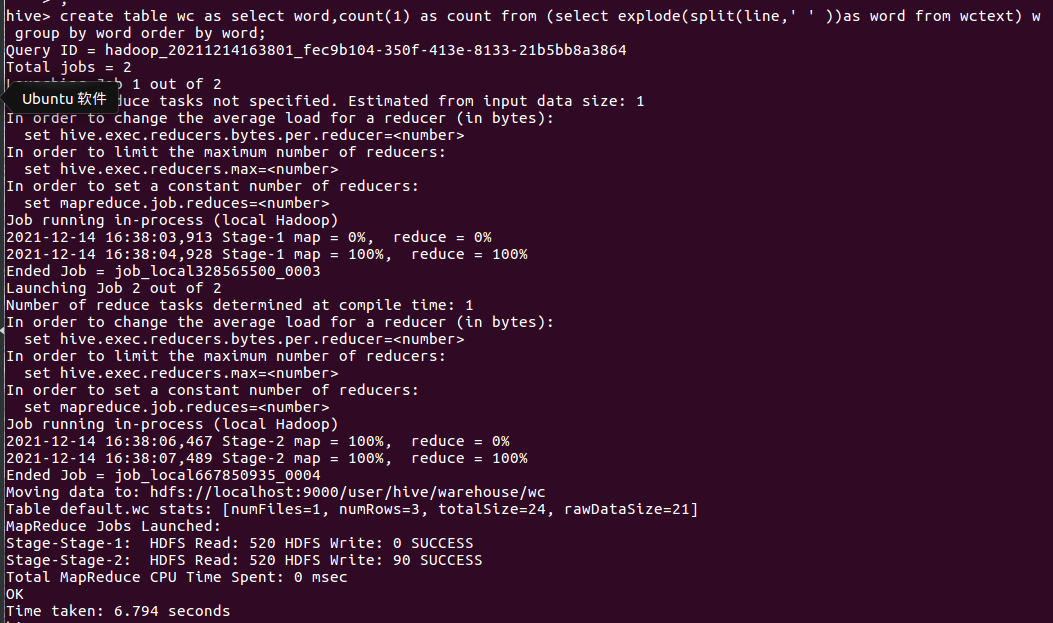

12.词频统计结果存到数据表里,并查看表和文件

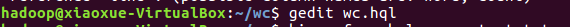

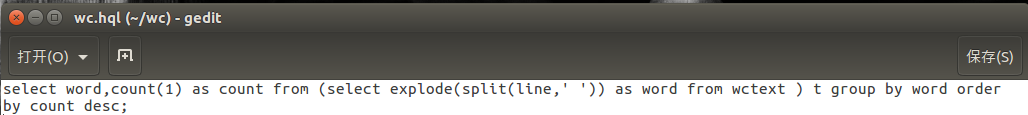

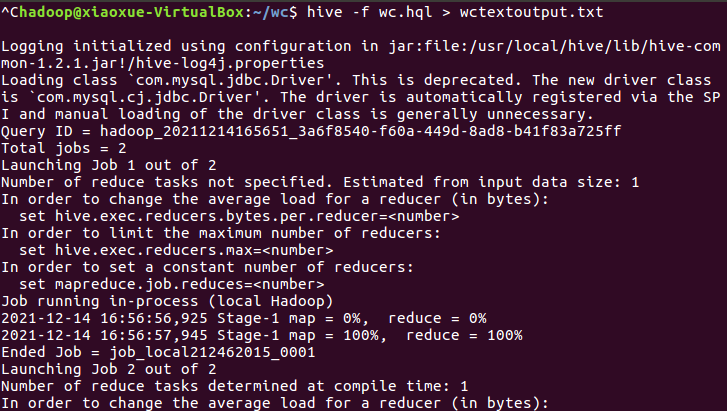

13.本地调用本地hql文件进行词频统计,将结果保存为本地文件

四、大作业

浙公网安备 33010602011771号

浙公网安备 33010602011771号