Hadoop 3.3 安装部署

- Hadoop 3.3 安装部署

Hadoop 版本 3.3

Linux 版本 Centos 7.7

JDK 版本 1.8.0

HADOOP_HOME=/root/hadoop/hadoop-3.3.3

- 前期准备工作

解压安装包

tar -zxvf hadoop-3.3.3.tar.gz cd hadoop-3.3.3/

创建hadoop 的数据目录

mkdir database cd database mkdir logs pwd

修改环境配置,设置 JDK HOME 目录,及设置Hadoop 环境下,shell 的执行用户

vi etc/hadoop/hadoop-env.sh export JAVA_HOME=/root/jdk1.8.0_202 export HDFS_DATANODE_USER=root export HDFS_DATANODE_SECURE_USER=root export HDFS_NAMENODE_USER=root export HDFS_SECONDARYNAMENODE_USER=root export YARN_RESOURCEMANAGER_USER=root export YARN_NODEMANAGER_USER=root export HADOOP_SHELL_EXECNAME=root

设置 HADOOP_HOME 环境变量

vi ~/.bashrc export HADOOP_HOME=/root/hadoop/hadoop-3.3.3 export HADOOP_CLASSPATH=`${HADOOP_HOME}/bin/hadoop classpath` export HADOOP_CONF_DIR=${HADOOP_HOME}/etc/hadoop source ~/.bashrc

- 部署 Hadoop 集群

修改 etc/hadoop/core-site.xml 配置如下

<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://HOSTNAME:9000</value> </property> <!-- 指定hadoop运行时产生文件的存储目录 --> <property> <name>hadoop.tmp.dir</name> <value>/root/hadoop/hadoop-3.3.3/database</value> </property> <!-- 在Web UI访问HDFS使用的用户名。--> <property> <name>hadoop.http.staticuser.user</name> <value>root</value> </property> </configuration>

修改 etc/hadoop/hdfs-site.xml 配置如下

<configuration> <property> <name>dfs.namenode.secondary.http-address</name> <value>HOSTNAME:9868</value> </property> <!-- 指定HDFS副本的数量 --> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.permissions.enabled</name> <value>false</value> </property>

<property>

<name>dfs.datanode.address</name>

<value>0.0.0.0:50010</value>

<description>DataNode data transfer address</description>

</property>

<property>

<name>dfs.datanode.http.address</name>

<value>0.0.0.0:50075</value>

<description>DataNode HTTP server address</description>

</property>

<property>

<name>dfs.datanode.ipc.address</name>

<value>0.0.0.0:50020</value>

<description>DataNode IPC server address</description>

</property>

</configuration>

修改 etc/hadoop/mapred-site.xml 配置如下

<configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> <property> <name>yarn.app.mapreduce.am.env</name> <value>HADOOP_MAPRED_HOME=${HADOOP_HOME}</value> </property> <property> <name>mapreduce.map.env</name> <value>HADOOP_MAPRED_HOME=${HADOOP_HOME}</value> </property> <property> <name>mapreduce.reduce.env</name> <value>HADOOP_MAPRED_HOME=${HADOOP_HOME}</value> </property> </configuration>

修改 etc/hadoop/yarn-site.xml 配置如下

<configuration> <!-- Site specific YARN configuration properties --> <property> <name>yarn.resourcemanager.hostname</name> <value>HOSTNAME</value> </property> <!-- reducer获取数据的方式 --> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <!-- 关闭yarn内存检查 --> <property> <name>yarn.nodemanager.pmem-check-enabled</name> <value>false</value> </property> <property> <name>yarn.nodemanager.vmem-check-enabled</name> <value>false</value> </property> <property> <!--开启日志聚合--> <name>yarn.log-aggregation-enable</name> <value>true</value> </property> <property> <!--日志聚合hdfs存储路径--> <name>yarn.nodemanager.remote-app-log-dir</name> <value>/root/hadoop/hadoop-3.3.3/logs</value> </property> <property> <!--hdfs上的日志保留时间--> <name>yarn.log-aggregation.retain-seconds</name> <value>604800</value> </property> <property> <!--应用执行时存储路径--> <name>yarn.nodemanager.log-dirs</name> <value>file:///root/hadoop/hadoop-3.3.3/logs</value> </property> <property> <!--应用执行完日志保留的时间,默认0,即执行完立刻删除--> <name>yarn.nodemanager.delete.debug-delay-sec</name> <value>604800</value> </property> </configuration>

格式化 namenode 节点

bin/hdfs namenode -format

修改 etc/hadoop/worker 配置如下

HOSTNAME1

HOSTNAME2

HOSTNAME3

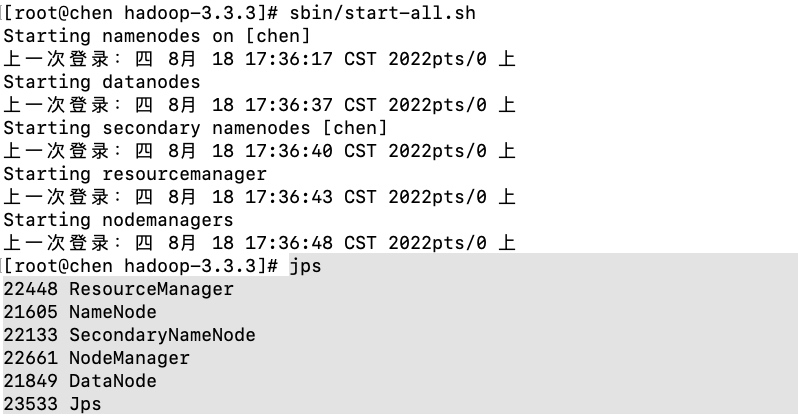

启动Hadoop 环境

sbin/start-all.sh

环境部署成功

再进击

浙公网安备 33010602011771号

浙公网安备 33010602011771号