使用约束类型注意力的基于路径推理的知识图谱补全

原文

Path-based reasoning with constrained type attention for knowledge graph completion

出版

- Neural Computing and Applications

- Volume 32

- Issue 11

- Jun 2020

- pp 6957–6966

- https://doi.org/10.1007/s00521-019-04181-1

申明

版权归原文作者及出版单位所有,如有侵权请联系删除

摘要

知识图谱中路径的多跳推理在知识图谱补全领域引起了越来越多的研究兴趣。实体类型和关系类型都包含各种各样的信息内容,尽管只有其中的一个子集在特定的三元组中很有帮助。

虽然现有的模型已经取得了重大进展,但它们有两个主要的缺点。首先,这些模型很少学习实体的显式表示和与语义信息的关系的表示。其次,他们在不区分不同角色类型的情况下推理具有多个类型的同一实体在不同的三元组中扮演的角色类型。

为了解决这些问题,我们开发了一种新的基于路径的约束类型注意推理模型,该模型试图通过利用相应三元组中的关系类型约束来识别实体类型。我们的实验评估表明,所提出的模型在真实数据集上优于现有的技术。进一步的分析也证实了我们的模型的词级和三级注意机制都是有效的。

文章贡献

- 这是研究KGC路径推理中的实体类型识别的第一次努力。我们提出了一种新的深度学习模型,即基于路径的约束类型注意推理(PRCTA)模型,用于知识图补全(KGC)。

- 我们将实体和关系类型作为文本语义特征来学习,并利用词级的注意力来捕获重要的语义信息,这克服了表示稀疏性的局限性。

- 为了减少噪声实体类型的影响,我们提出了一种约束实体类型注意方法,对不同三元组中的实体类型进行软类型选择。这包含了关系类型,通过同时考虑实体类型的多样性和表示精度,限制了相应三元组中实体的语义。

模型介绍

模型概述

我们首先利用类型属性和双向递归神经网络(bi-LSTM)通过语义注意力来学习实体和关系的编码。然后,我们描述了具有约束类型注意力的路径编码,它自动选择特定三元组中给定实体类型中最相关的部分,以减少噪声类型的权重。最后,我们在多个实例上建立路径注意力来动态调整路径权值。图2展示了我们所提出的模型的概述。

实体和关系编码

一个关系或者实体所拥有的类型属性与很多,可以视为一个单词序列,然后我们对这个单词序列使用对应的bi-LSTM和一个语义层。

在编码阶段,我们先将一个类型序列中的每个单词转换为一个二维向量,然后将单词向量序列输入到Bi-LSTM,来更完整地捕获序列特征。

在原始的类型序列向量中,包含的信息只有其中一部分是有用的,为此在最后一层我们采用word级别的注意力机制获取每个输出向量的注意力权重。

类型约束的注意力

与关系不同,实体的类型属性在不同的场合(不同的三元组中)侧重点是不同的,比如特朗普这个实体在部分三元组中是侧重于政治家这个类型,而在另外一些三元组中可能侧重于商人这个类型,为此我们需要根据具体场景对实体类型进行约束。

实体类型包括贡献类型和噪声类型,而贡献类型应该以不同的权重来参加。由于不同场景下类型数量和贡献类型的选择的不确定性,因此在给定路径中的节点之间进行推理时,很难在不同的表示中表示一个实体。在本节中,我们提出了一种约束类型注意机制,该机制考虑使用软类型选择来处理由单词级注意提取的高级类型特征。

路径编码

我们首先利用bi-LSTM将路径编码为向量表示,然后通过路径注意整合给定实体对之间的所有路径。

模型评估

数据集

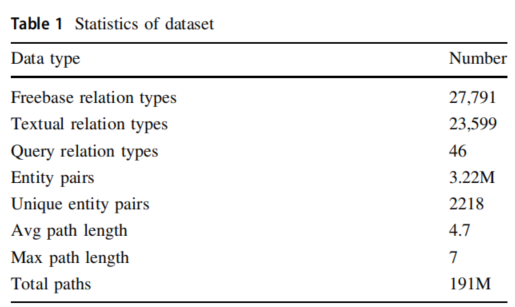

我们使用的数据集来自于真实世界,包含了Freebase的数据信息并且使用ClueWeb数据集进行扩充和丰富。该数据集包含了46种查询关系的实体对之间的路径集,具体各项数据如下表:

基线模型介绍

-

PRA

核心思想是使用随机游走算法来寻找路径并且把路径编码成二进制特征。 -

Path-RNN

核心思想是使用使用RNN来预测收集到的路径序列上的二进制目标关系的模型。 -

Single-Model

这是一个基于Path-RNN的改进RNN模型,它是考虑了所有查询关系的一个模型,并且利用LogSomExp对多条路径进行评分。 -

Single-Model + Type

在Single-Model模型中,将实体表示为实体和所有实体类型的平均的组合。 -

Att-Model

这是一个使用注意力机制而不是LogSumWxp来处理实体之间的多条路径的模型。 -

Att-Model + Type

在Att-Model模型的基础上,将实体表示为实体和所有实体类型的平均的组合。

消融实验结果

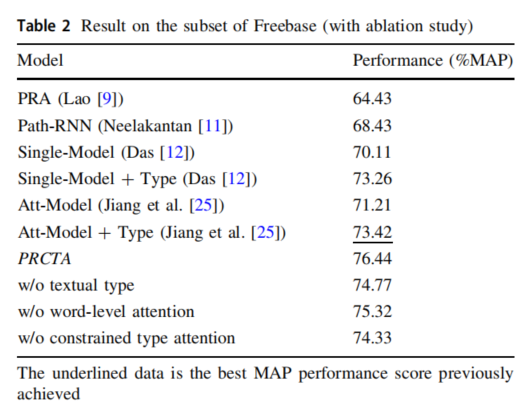

具体实验结果如下表:

- PRCTA在我们使用的真实数据集上优于最先进的基线模型,表明了在多跳任务推理上具有有效性。

- 考虑到消融测试,我们可以发现文本类型和所有的注意机制都有贡献,它为在约束类型注意下进行实体类型辨别提供了更大的性能提升。

- 文本信息为节点的表示提供了有效的特征,也丰富了路径的语义信息,从而可以正确地解决表示的稀疏性问题。

- 本文所采用的注意机制能够显著降低噪声。词级注意通过降低整个类型上下文中的噪声来减轻表示稀疏性,而约束类型注意进一步减少了有噪声的实体类型,从而减轻了具有大量类型的实体的低效率。

浙公网安备 33010602011771号

浙公网安备 33010602011771号