EIGAT:将全局信息纳入局部注意力中,进行知识表示学习

原文

EIGAT: Incorporating global information in local attention for knowledge representation learning

出版

Knowledge-Based Systems 237 (2022) 107909

代码

未开源

版权申明

版权归原文作者及出版单位所有,如有侵权请联系删除

摘要

图注意网络(GATs)已经被证明是一种很有前途的模型,它利用局部注意机制对图结构数据(例如知识图(KGs))进行知识表示学习(KRL)。虽然这些方法对实体的局部成对重要性进行建模,但它们缺乏相对于kg的其他实体建模全局重要性的能力。这导致这些模型在任务中遗漏关键信息,而任务中全局信息也是任务的重要组成部分,例如在知识表示学习中。为了解决这个问题,我们允许通过使用比例实体重要性将全局信息适当地纳入GAT族模型中,这是由一个基于注意力的全局随机游走算法计算出来的。在KRL的环境中,合并全局信息可以显著提高性能。对KG实体预测的实验结果充分证明了我们所提出的模型的有效性。

实体重要性(Entity Importance, EI)定义

给定一个用G=(E,R)表示的知识图谱KG,表示多关系图,E和R分别代表实体(节点)和关系(边)。实体的重要性是一个非负的实际得分,代表一个实体在图G上的重要性或权重,即EI(ei)∈R≥0,∀ei∈e。

文章贡献

- 我们建议将全局信息纳入局部关注的知识表示学习。

- 我们提出了EIGAT,一种新的实体重要性感知图注意网络,它将全局实体的重要性整合到局部实体聚合中。

- 大量的实验结果证明了我们提出的模型在链接预测方面的有效性。

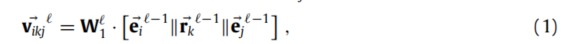

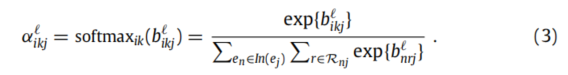

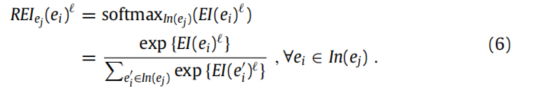

局部注意力评估

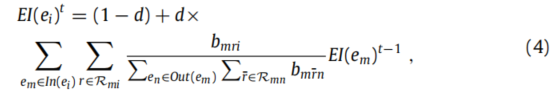

全球实体重要性评估

注意:其中d是一个超参数,表示一个假想的游走者随机移动到邻近实体的概率,(1−d)表示随机传送到任何其他实体的概率。Out(e(m))表示一个实体e(m)所指向的邻域。

特点

- 当对一个给定实体的重要性得分进行建模时,可以考虑到邻近实体的重要性得分

- 关系意识,即不同的关系可以在传播实体重要性得分中发挥不同的作用。

- 中心性意识,即更多的中心节点内在和合理地比较少的中心节点更重要。

- 通用的和灵活的,即它只利用图的全局结构信息。

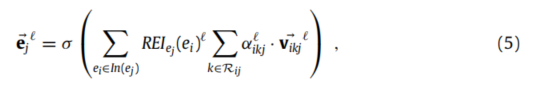

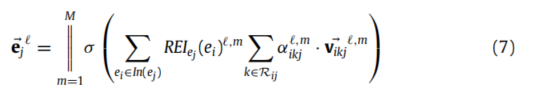

纳入全局信息的局部注意力

并且可以通过使用多头注意力机制来稳定自我注意的学习过程,具体如下:

模型架构

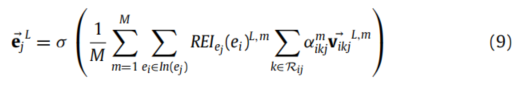

编码器

基于上面介绍的单一注意层,我们使用L层构建了编码器模型的整体架构。在实践中,我们为我们的编码器模型设置了L=2。在最后的第L个层,不采用连接运算,我们采用平均的非线性激活:

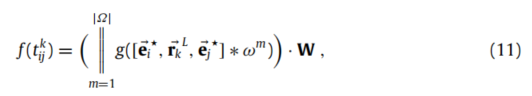

为了在最终嵌入中保留初始实体信息,我们将转换后的初始嵌入e0与L层的eL相结合,得到最终嵌入的e⋆,如下所示:

解码器

在现有的KG补全(KGC)模型中,我们使用最新的模型ConvKB作为解码器模型。给定一个三重t(i, j, k),评分函数被正式定义为:

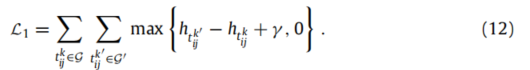

优化器

我们对编码器-解码器框架采用了一个两步训练程序,两步的损失函数如下:

评估

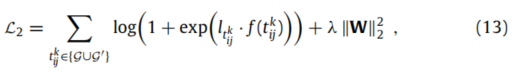

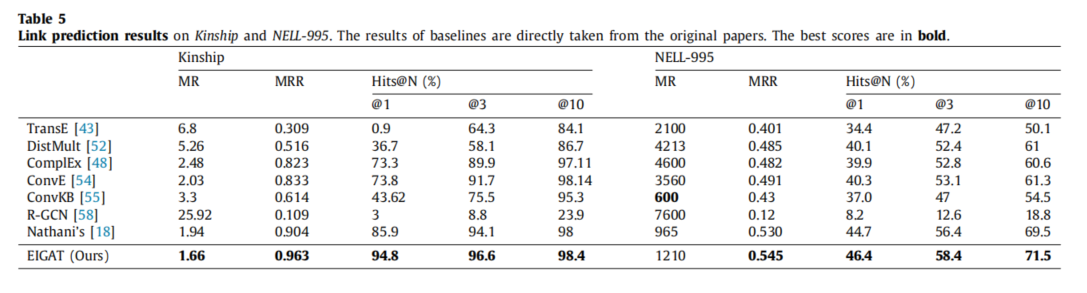

具体的评估结果如下面两张图所示:

从上图我们可以得出如下结论:

- EIGAT在所有基准数据集中的大多数指标上显著且始终优于所有最先进的基线,这证明了我们提出的模型的有效性。

- 与NELL-995的基线相比,EIGAT的优势似乎比其他的要小。这是因为相对密集图中丰富的全局结构信息,即FB15和K-237,与相对稀疏图中较少的全局结构知识,即相对稀疏图相比,全局随机游走方法可以更有效地估计实体的重要性。

结果表明,NELL-995比其他类型的EIGAT更难学习,但可比性结果也验证了我们的模型在两种情况下的有效性和鲁棒性。

浙公网安备 33010602011771号

浙公网安备 33010602011771号