服务器的一些使用命令

使用 watch -n 0.5 nvidia-smi 命令来0.5秒刷新一次显卡运行资源占用情况

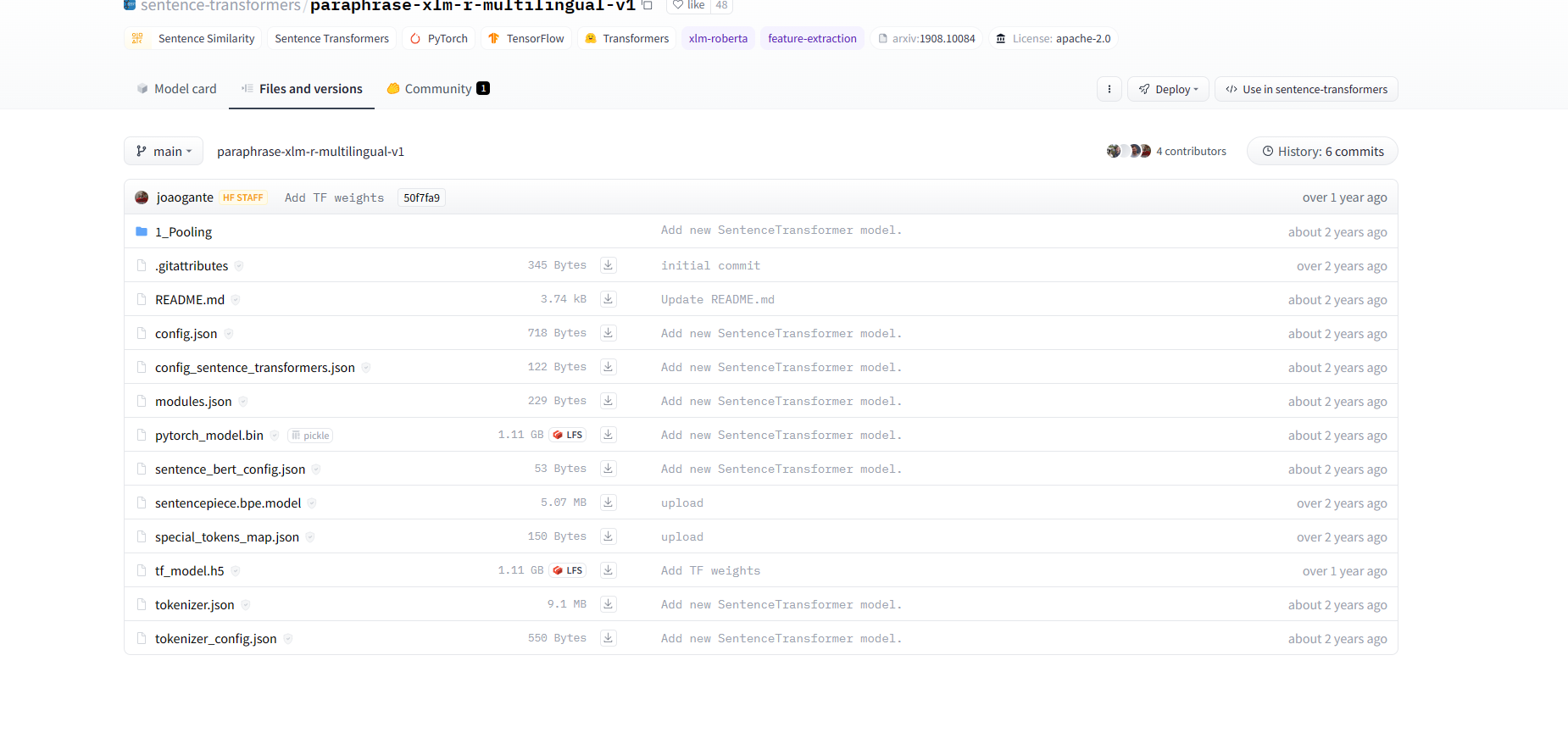

另外再huggingface上的模型直接用代码下载不下来,可以去官网 https://huggingface.co/ 找对应的模型代码 进行下载

一般下载第一个是配置文件;config.json。第二个是词典文件,vocab.json。第三个是预训练模型文件,如果你使用pytorch则保存pytorch_model.bin文件,如果你使用tensorflow 2,则保存tf_model.h5。

一般moudle.json 不要下 会报错, 其他都可以下载,然后放入以模型命名的文件夹中 ,在调用时

在linux中创建循环境并按照requirements.txt 安装

conda create -n jxppytorch python=3.9

pip install -r /media/b417/E/Workspace/jxp/formula-embedding-master/requirements.txt

显卡算力强 需要高版本cuda才能驱动

# 首先卸载已有的pytorch

pip uninstall torch

pip uninstall torchvision

pip uninstall torchaudio

# 安装

pip3 install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu116

a6000的环境创建

conda create -n jxp python=3.10

pip install torch==2.1.0 torchvision==0.16.0 torchaudio==2.1.0 --index-url https://download.pytorch.org/whl/cu118

浙公网安备 33010602011771号

浙公网安备 33010602011771号