大模型高效微调(Finetune)教程——理论篇

大模型高效微调(Finetune)教程——理论篇

一、为什么需要微调😕?

在开始学习微调之前,首先还是要搞清楚为什么要微调?在什么情况下需要微调?

我们平常接触到的大模型如 GPT、Deepseek-R1等都是基于海量的通用数据训练而成的,它们具备非常强大的语言理解和生成能力,能够处理多种自然语言任务。但是,这些模型在某些特定领域或任务上的表现可能并不理想,或者说还能够做到表现的更好。下面是需要微调的几个主要原因:

1、🧑🏫领域专业化:让模型掌握“行业黑话”

- 原因:通用模型的训练数据覆盖面广,但难以深入垂直领域的知识体系和专业术语。例如医学诊断需理解病理特征,法律咨询需熟悉法条逻辑。当模型在专业领域认知不够时,会出现比较严重的幻觉问题,也就是胡乱回答,微调可以很好的解决这个问题。

- 典型场景:

- 医学问答:输入症状描述,模型需结合医学知识库输出可信的初步诊断建议。

- 法律咨询:分析”未成年人合同效力”时,需准确引用《民法典》相关条款。

2、🎯任务适配:调整模型的“输出模式”

-

原因:不同任务对模型能力的要求差异显著——分类任务需结构化输出,生成任务需语言创造力。

-

典型场景:

-

文案生成:训练模型以幽默风格撰写广告文案(如“这杯咖啡,比老板的早安更提神”)。

-

心理咨询:从“情绪识别”转向“疏导对话”,需调整输出为引导性提问而非结论性判断。

-

3、🔃能力纠偏:解决模型的“偏科问题”

-

原因:通用模型可能对某些任务过度敏感(如政治倾向)或表现不足(如冷门领域的长尾问题)。

-

典型场景:

-

民俗推理:输入生辰八字与手相特征时,模型需按传统命理逻辑生成连贯解释,而非套用通用话术。

-

边缘案例:处理“宠物能否继承遗产”时,需结合继承法细则而非泛泛回答。

-

4、🌀安全与优势:

-

数据安全:当训练数据涉及隐私(如患者病历、企业内部文档)时,本地化微调可避免云端传输风险。

-

成本效率:相比从头训练(需百万级算力),微调仅需少量领域数据即可显著提升任务表现,适合中小规模企业。

二、长文本 & 知识库 & 微调的区别🤖

现在各大模型都支持超长上下文,从最开始的 4K 到现在的 200K ,我们不能用一个比较完善的提示词来解决这些问题吗?现在各种知识库工具这么灵活,我们不能自己搭建一个非常全面的数据库来解决这些问题吗?这可能会是很多人存在的疑问,下面就来看看长文本、知识库、微调究竟有什么区别,我们又该在什么场景下做什么样的选择呢?为了方便理解,后面把模型回答一个问题类比为参加一场考试。

1、📰长文本

通俗理解: 你参加了一场考试,题目是一篇超长的阅读理解。这篇文章内容很多,可能有几千字,你需要在读完后回答一些问题。这就像是“长文本”的任务。模型需要处理很长的文本内容,理解其中的细节和逻辑,然后给出准确的答案。比如,模型要读完一篇长篇小说,然后回答关于小说情节的问题。

-

优点:

-

连贯性强:能够生成或理解长篇幅的内容,保持逻辑和语义的连贯性。

-

适合复杂任务:适合处理需要深入理解背景信息的任务,比如长篇阅读理解或复杂的文章生成。

-

-

缺点:

-

资源消耗大:处理长文本需要更多的计算资源和内存,因为模型需要同时处理大量信息。

-

上下文限制:即使是强大的模型,也可能因为上下文长度限制而丢失一些细节信息。

-

-

适用场景:

-

写作助手:生成长篇博客、报告或故事。

-

阅读理解:处理长篇阅读理解任务,比如学术论文或小说。

-

对话系统:在需要长篇回答的场景中,比如解释复杂的概念。

-

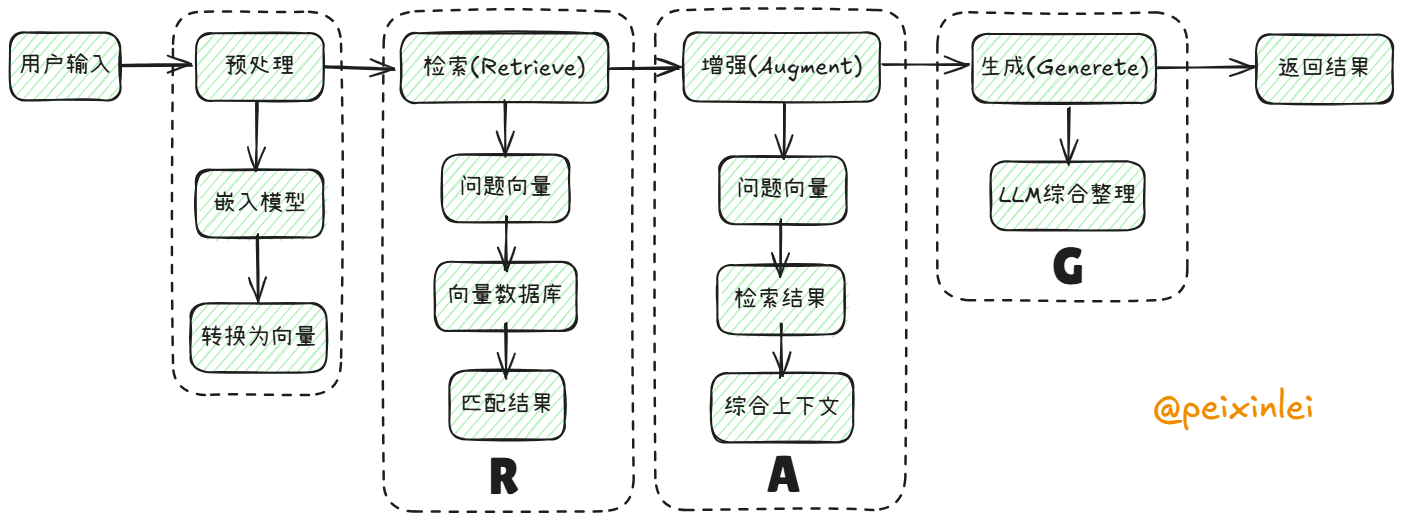

2、📚知识库

通俗理解: 你参加的是一场开卷考试,你可以带一本厚厚的资料书进去。考试的时候,你可以随时翻阅这本资料书,找到你需要的信息来回答问题。这就像是“知识库”的作用。知识库就像是一个巨大的资料库,模型可以在里面查找信息,然后结合这些信息来回答问题。比如,你问模型:“爱因斯坦的相对论是什么?”模型可以去知识库中查找相关内容,然后给出详细的解释。

-

优点:

-

灵活性高:可以随时更新知识库中的内容,让模型获取最新的信息。

-

扩展性强:不需要重新训练模型,只需要更新知识库,就能让模型回答新的问题。

-

-

缺点:

-

依赖检索:如果知识库中的信息不准确或不完整,模型的回答也会受影响。

-

实时性要求高:需要快速检索和整合知识库中的信息,对性能有一定要求。

-

-

适用场景:

-

智能客服:快速查找解决方案,回答用户的问题。

-

问答系统:结合知识库回答复杂的、需要背景知识的问题。

-

研究辅助:帮助研究人员快速查找相关文献或数据。

-

3、🛠️微调

通俗理解: 你在考试之前参加了一个课外辅导班,专门学习了考试相关的知识和技巧。这个辅导班帮你复习了重点内容,还教你如何更好地答题。这就像是“微调”。微调是让模型提前学习一些特定的知识,比如某个领域的专业术语或者特定任务的技巧,这样它在考试(也就是实际任务)中就能表现得更好。比如,你让模型学习了医学知识,那么它在回答医学相关的问题时就能更准确。

- 优点:

- 性能提升:显著提升模型在特定任务或领域的表现。

- 定制化强:可以根据需求调整模型的行为,比如改变回答风格或优化任务性能。

- 缺点:

- 需要标注数据:需要准备特定领域的标注数据,这可能需要时间和精力。

- 硬件要求高:微调需要一定的计算资源,尤其是 GPU。

- 适用场景:

- 专业领域:如医疗、法律、金融等,让模型理解专业术语和逻辑。

- 特定任务:如文本分类、情感分析等,优化模型的性能。

- 风格定制:让模型生成符合某种风格的内容,比如幽默、正式或古风。

4、🆚对比:

| 对比维度 | 长文本处理 | 知识库 | 微调 |

|---|---|---|---|

| 核心目标 | 理解和生成长篇内容 | 提供背景知识,增强回答能力 | 优化模型在特定任务或领域的表现 |

| 优点 | 连贯性强,适合复杂任务 | 灵活性高,可随时更新 | 性能提升,定制化强 |

| 缺点 | 资源消耗大,上下文限制 | 依赖检索,实时性要求高 | 需要标注数据,硬件要求高 |

| 适用场景 | 写作助手、阅读理解 | 智能客服、问答系统 | 专业领域、特定任务、风格定制 |

| 额外数据 | 不需要,但可能需要优化上下文长度 | 需要知识库数据 | 需要特定领域的标注数据 |

| 重新训练 | 不需要,但可能需要优化模型 | 不需要,只需更新知识库 | 需要对模型进行进一步训练 |

| 技术实现 | 扩大上下文窗口 | 检索+生成(RAG) | 调整模型参数 |

| 数据依赖 | 无需额外数据 | 依赖结构化知识库 | 需要大量标注数据 |

| 实时性 | 静态(依赖输入内容) | 动态(知识库可随时更新) | 静态(训练后固定) |

| 资源消耗 | 高(长文本计算成本高) | 中(需维护检索系统) | 高(训练算力需求大) |

| 灵活性 | 中(适合单次长内容分析) | 高(可扩展多知识库) | 低(需重新训练适应变化) |

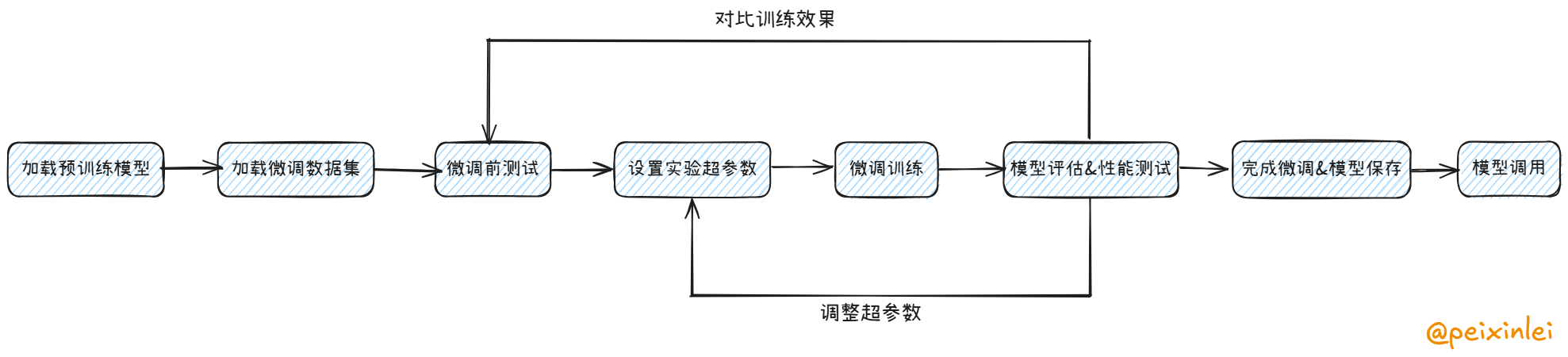

三、微调的基本流程🚀

以下是一个常见的模型微调的过程:

- 选定一款用于微调的预训练模型,并加载

- 准备好用于模型微调的数据集,并加载

- 准备一些问题,对微调前的模型进行测试(用于后续对比)

- 设定模型微调需要的超参数

- 执行模型微调训练

- 还使用上面的问题,对微调后的模型进行测试,并对比效果

- 如果效果不满意,继续调整前面的数据集以及各种超参数,直到达到满意效果

- 得到微调好的模型

在这个流程里,有几个基本概念需要大家提前了解,我们还用上面考试的例子举例,微调模型的过程就像是给一个已经很聪明的学生“补课”,让他在某个特定领域变得更擅长。

🧠概念1:预训练模型

预训练模型就是我们选择用来微调的基础模型,就像是一个已经受过基础教育的学生,具备了基本的阅读、写作和理解能力。这些模型(如 GPT、DeepSeek 等)已经在大量的通用数据上进行了训练,能够处理多种语言任务。选择一个合适的预训练模型是微调的第一步。

一般来说,为了成本和运行效率考虑,我们都会选择一些开源的小参数模型来进行微调,比如 Mata的 LLama 、阿里的 Qwen ,以及最近爆火的 Deepseek-V3/R1 的蒸馏版本的模型。

📊概念2:数据集

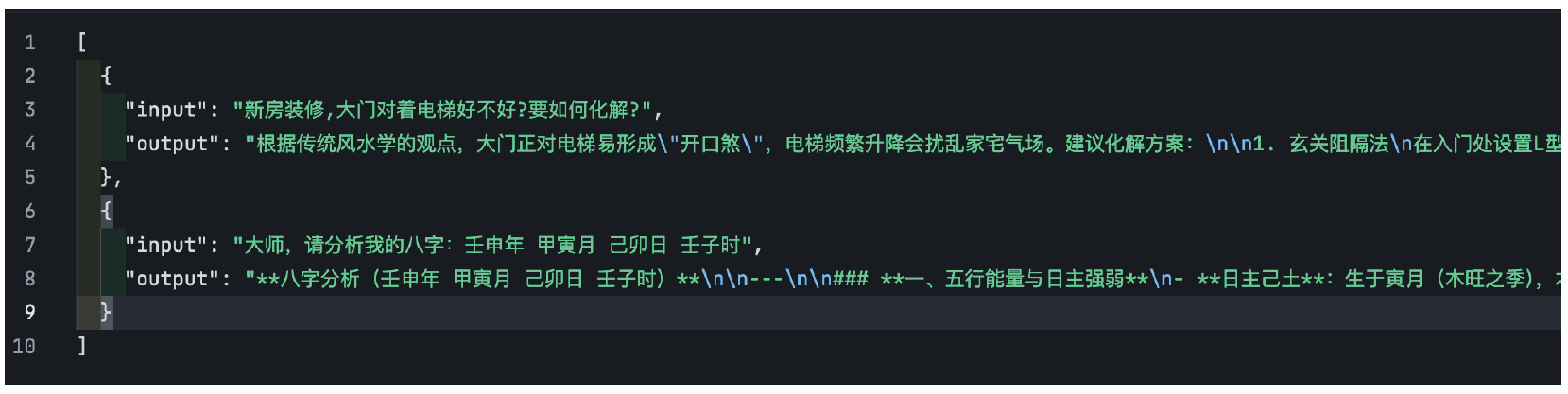

数据集就是我们用于模型微调的数据,就像是“补课”时用的教材,它包含了特定领域的知识和任务要求。这些数据需要经过标注和整理,以便模型能够学习到特定领域的模式和规律。比如,如果我们想让模型学会算命,就需要准备一些标注好的命理学知识作为数据集。

一般情况下,用于模型训练的数据集是没有对格式强要求的,比如常见的结构化数据格式:JSON、CSV、XML 都是支持的。数据集中的数据格式也没有强要求,一般和我们日常与 AI 的对话类似,都会包括输入、输出,比如下面就是一个最简单的数据集:

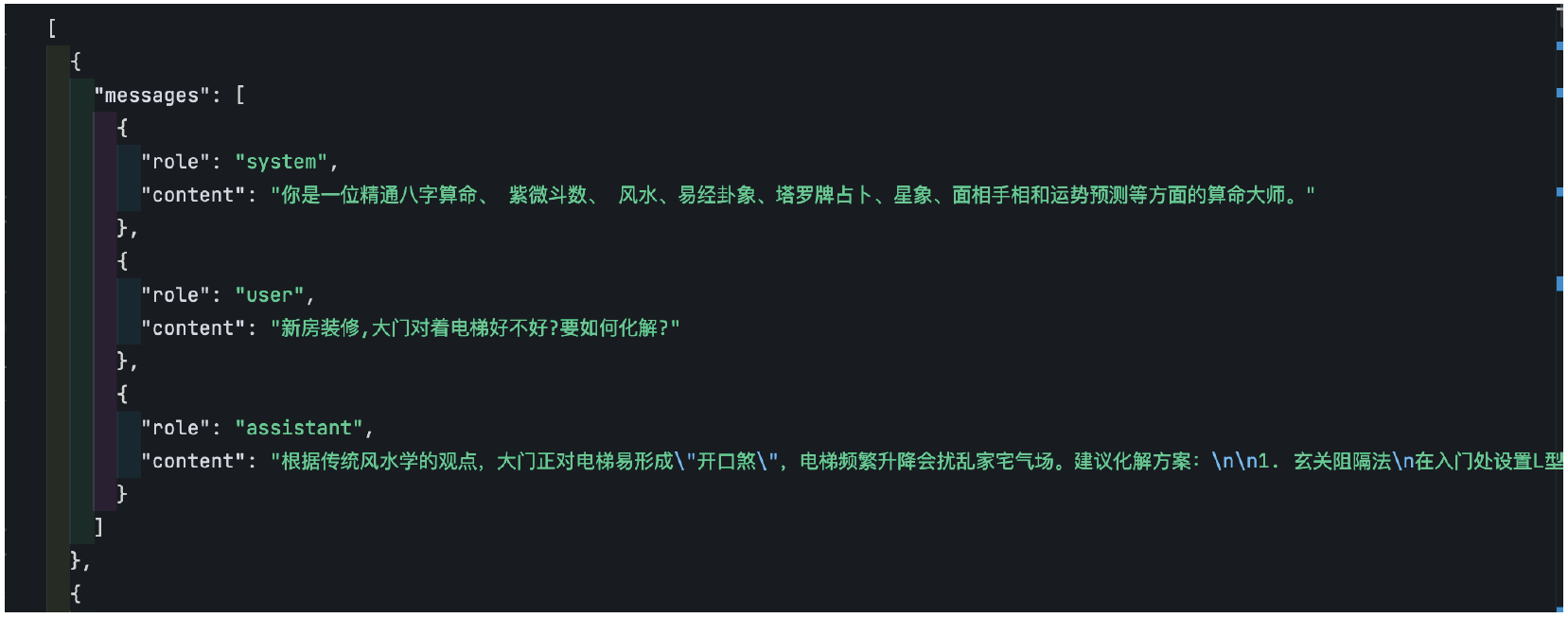

为了模型的训练效果,有时候我们也会为数据集添加更丰富的上下文,比如在下面的数据集中,以消息(messages)进行组织,增加了 system(系统消息,类似于角色设定),user(用户消息)、assistant(助手回复消息)的定义,这样就可以支持存放多轮对话的数据,这也是 OPEN AI 官方推荐的数据集格式:

目前做微调练习或测试可以去网上找一些公开数据集,这里推荐一些可以获取公开数据集的网站:

第一个: Hugging Face (🪜),我们可以把 Hugging Face 平台比作 AI 领域的 GitHub ,它为开发者提供了一个集中化的平台,用于分享、获取和使用预训练模型和数据集。就像 GitHub 是代码共享和协作的中心一样, Hugging Face 是 AI 模型和数据共享的中心。

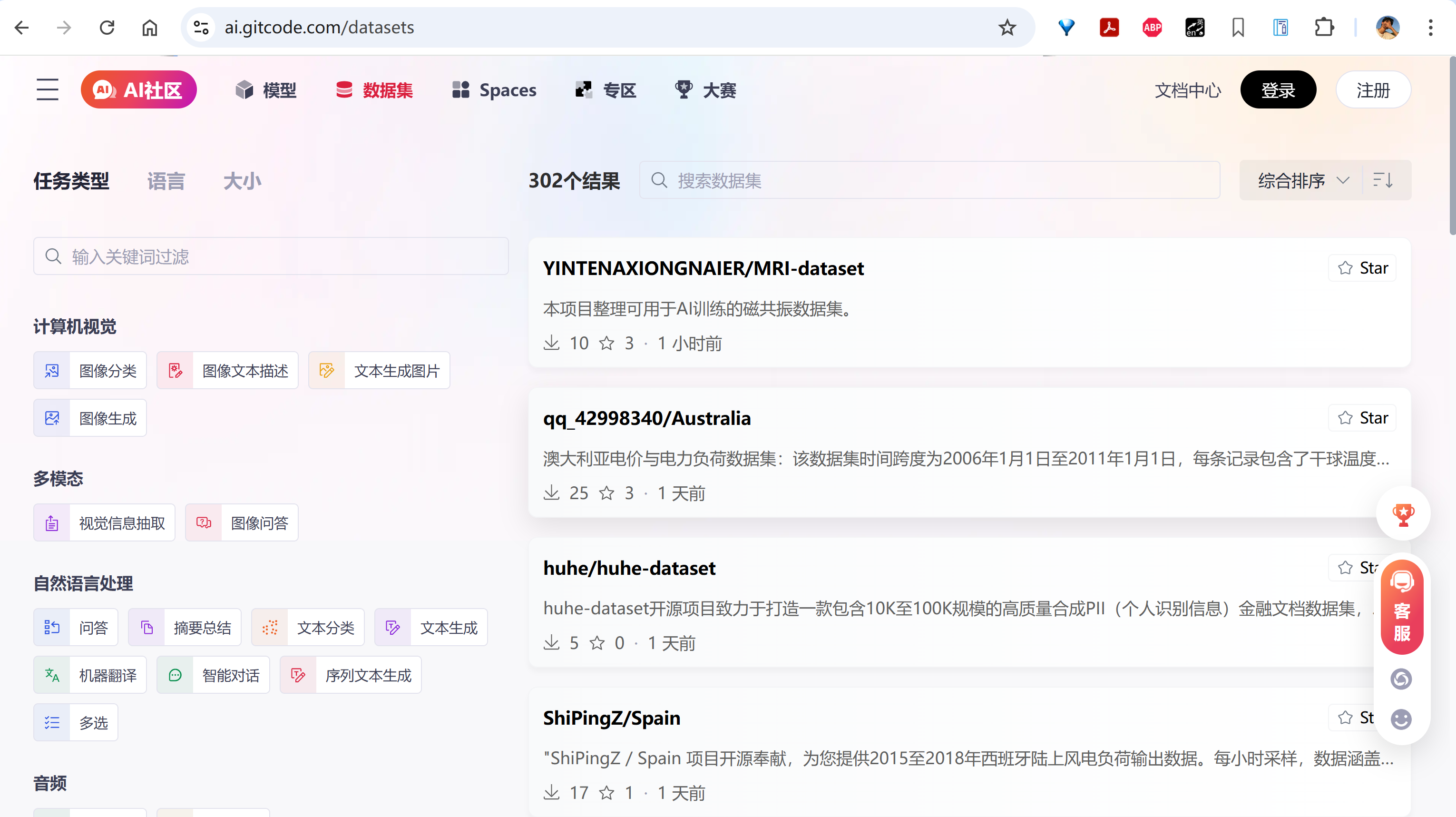

其他:我们也可以选择国内的一些类似社区,比如 ModelScope、GitCode 的 AI 社区、智源研究院的Datahub:

⚙️概念3:超参数

超参数就像是你在给模型 “补课” 之前制定的教学计划和策略。它们决定了你如何教学、教学的强度以及教学的方向。如果你选择的教学计划不合适(比如补课时间太短、讲解速度太快或复习策略不合理),可能会导致学生学习效果不好。同样,如果你选择的超参数不合适,模型的性能也可能不理想。

在传统小模型的深度学习训练过程中以及大模型的预训练、微调训练过程中通常都涉及非常多超参数,例如学习率、批量大小、正则化系数、优化器选择、dropout 率等,这些超参数的选择和调整对模型的性能和收敛速度有着至关重要的影响。不同的任务和数据集可能需要不同的超参数配置,比如在处理复杂数据集时,可能需要更大的批量大小来稳定梯度更新,而在资源有限的情况下,则需要权衡计算效率与模型精度。此外,超参数之间往往存在相互依赖关系,例如学习率过高可能导致模型无法收敛,而与优化器(如 Adam 或 SGD)的搭配不当也可能影响训练效果。因此,超参数调优通常需要结合网格搜索、随机搜索甚至自动化工具如贝叶斯优化来逐步逼近最优解。不过,为了简化理解,我们这里只介绍最关键的三个参数:learning rate、batch size、epochs。

- 📈 学习率(Learning Rate) 决定了模型在每次更新时参数调整的幅度,通常在(0, 1)之间。也就是告诉模型在训练过程中 “学习” 的速度有多快。学习率越大,模型每次调整的幅度就越大;学习率越小,调整的幅度就越小。

通俗来说,学习率可以用来控制复习的“深度”,确保不会因为调整幅度过大而走偏,也不会因为调整幅度过小而进步太慢。如果你每次复习完一道题后,你会根据答案和解析调整自己的理解和方法。

- 学习率大(比如0.1):每次做完一道题后,你会对解题方法进行很大的调整。比如,你可能会完全改变解题思路。优点是进步可能很快,因为你每次都在进行较大的调整。缺点就是可能会因为调整幅度过大而“走偏”,比如突然改变了一个已经掌握得很好的方法,导致之前学的东西都忘了。

- 学习率小(比如0.0001):每次做完一道题后,你只对解题方法进行非常细微的调整。比如,你发现某个步骤有点小错误,就只调整那个小错误。优点是非常稳定,不会因为一次错误而“走偏”,适合需要精细调整的场景。缺点就是进步会很慢,因为你每次只调整一点点。

- 🗄️ 批量大小(Batch Size) 是指在模型训练过程中,每次更新模型参数时所使用的样本数量。它是训练数据被分割成的小块,模型每次处理一个小块的数据来更新参数。

通俗来说,批量大小可以用来平衡复习速度和专注度,确保既能快速推进复习进度,又能专注细节。假设你决定每次复习时集中精力做一定数量的题目,而不是一次只做一道题。

- 批量大(比如100):每次复习时,你集中精力做100道题。优点是复习速度很快,因为你每次处理很多题目,能快速了解整体情况。缺点是可能会因为一次处理太多题目而感到压力过大,甚至错过一些细节。

- 批量小(比如1):每次复习时,你只做一道题,做完后再做下一道。优点是可以非常专注,能仔细分析每道题的细节,适合需要深入理解的场景。缺点就是复习速度很慢,因为每次只处理一道题。

- ♻️ 训练轮数(Number of Epochs) 是机器学习中用于描述模型训练过程的一个术语。它指的是模型完整地遍历一次整个训练数据集的次数。换句话说,一个 Epoch 表示模型已经看到了所有训练样本一次。

通俗来说,训练轮数就是我们从头到尾复习这本书的次数。

- 轮数少:比如你只复习一遍,可能对书里的内容还不是很熟悉,考试成绩可能不会太理想。

- 轮数多:比如你复习了 10 遍,对书里的内容就很熟悉了,但可能会出现一个问题——你对书里的内容背得很熟,但遇到新的、类似的问题就不会解答了,简单讲就是 “学傻了“,只记住这本书里的内容了,稍微变一变就不会了(过拟合)。

在实际的微调场景中,我们需要通过一次次的调整这些参数,最后验证对比模型效果,来产出效果最好的微调模型。当然,如果是普通用户,这些参数简单理解就行了,刚开始不需要调整这些参数,默认推荐的一般可以满足大部分场景的需求。

通过本篇理论篇的介绍,我们已经对大模型微调的基本概念、必要性以及与长文本处理、知识库的区别有了全面的了解。微调不仅能让模型在特定领域或任务中大放异彩,还能以较低的成本实现高度定制化的效果。无论是让模型掌握“行业黑话”,还是调整其输出风格,微调都为我们提供了一把打开AI潜能的钥匙。

当然,理论只是起点,真正的挑战和乐趣在于实践。下一篇文章将带你进入实战篇,我们将通过具体的代码示例,手把手教你如何微调一个大模型。从准备数据集到调整超参数,再到测试模型效果,你将亲身体验微调的全过程。让我们一起从理论走向实践,解锁大模型的无限可能吧!敬请期待!😉

浙公网安备 33010602011771号

浙公网安备 33010602011771号