服务器侧简单测试大模型问答实现

🚩基于A100服务器简单测试大模型

A100服务器具备python环境,可以联网,VScode直连服务器

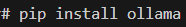

安装ollama工具, pip install ollama

使用ollama下载大模型

本实例安装的是deepseek-r1:7b

简单实现网上案例

from ollama import chat

messages = [

{

'role': 'user',

'content': '欠薪了怎么办?',

},

]

response = chat('deepseek-r1:7b', messages=messages)

print(response['message']['content'])

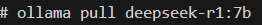

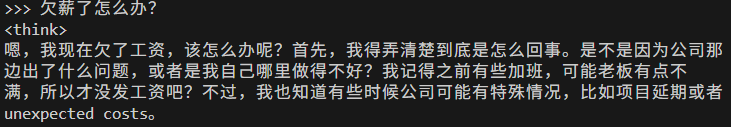

结果展示:

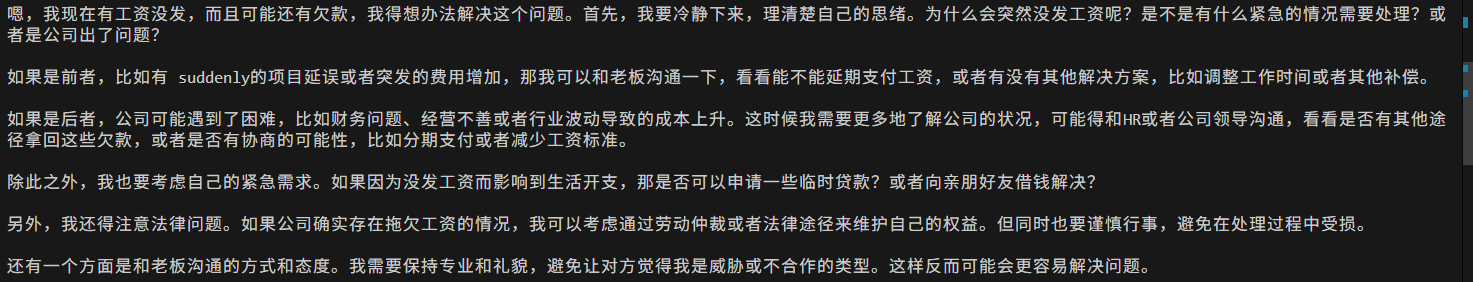

在终端实现大模型

直接在终端运行ollama run deepseek-r1:7b,就会给出,问答界面

,

,

则展示结果如下:

浏览器侧布置UI界面

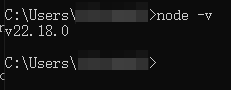

首先先安装Node.js,安装成功后,在cmd下验证,如下图

还需要安装Git,Git主要用来从github下拉代码,或者代码管理,然后执行

git clone https://github.com/ollama-webui/ollama-webui-lite ollama-webui或者直接下载压缩包,然后解压也可以。

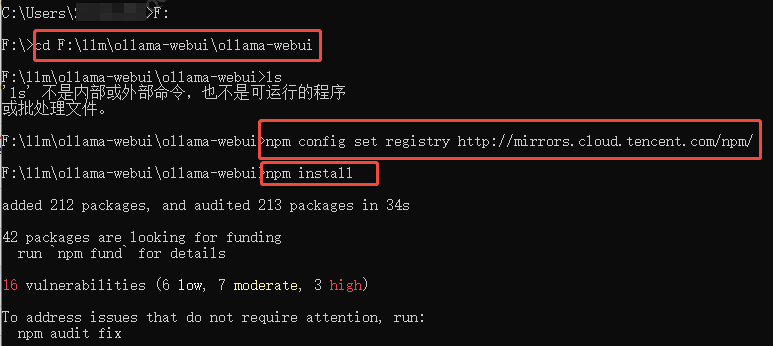

完成下拉代码后,cmd cd进入ollama-webui,执行命令npm config set registry http://mirrors.cloud.tencent.com/npm/ 和 npm install,

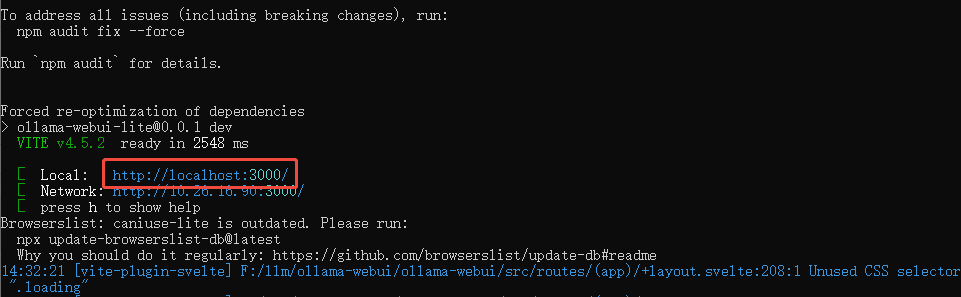

执行命令npm run dev

后面就可以直接在浏览器打开了

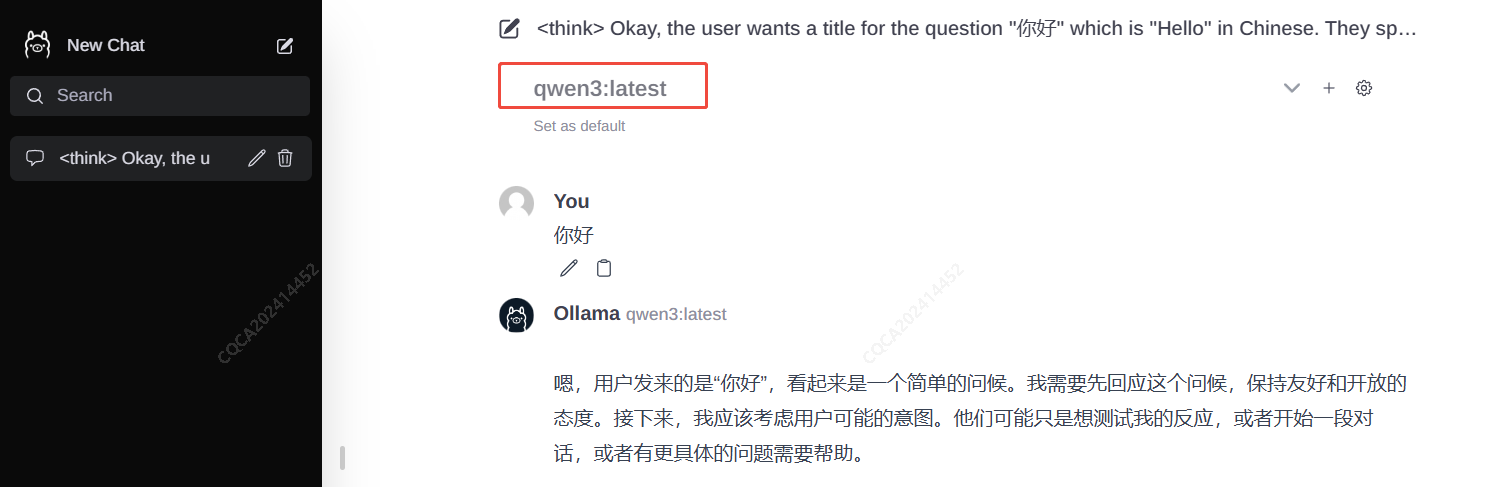

因为我安装的是qwen3:latest模型,因此这里就是显示这个模型

下面就可以进行问答了。

服务器安装 ollama-webui-lite在浏览器呈现

执行命令git clone https://github.com/ollama-webui/ollama-webui-lite.git下拉ollama-webui-lite代码。

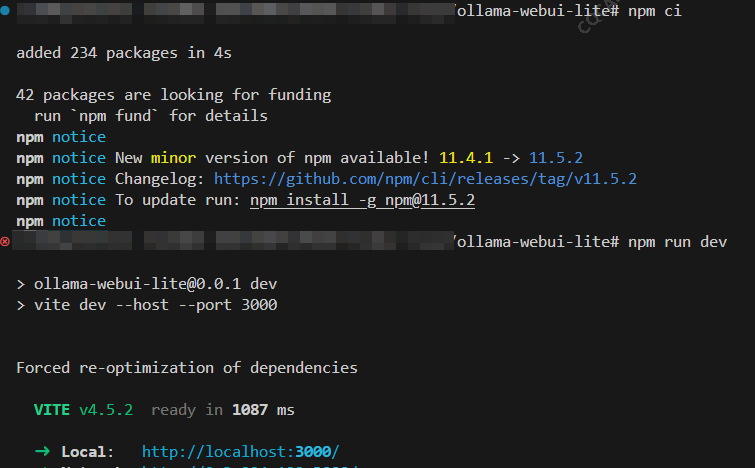

执行命令npm ci和npm run dev

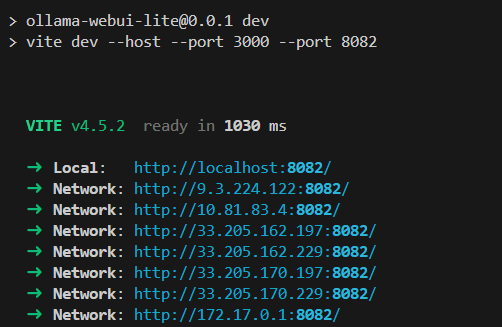

如果想修改端口的话,执行命令npm run dev -- --port 8082将默认端口改为8082.

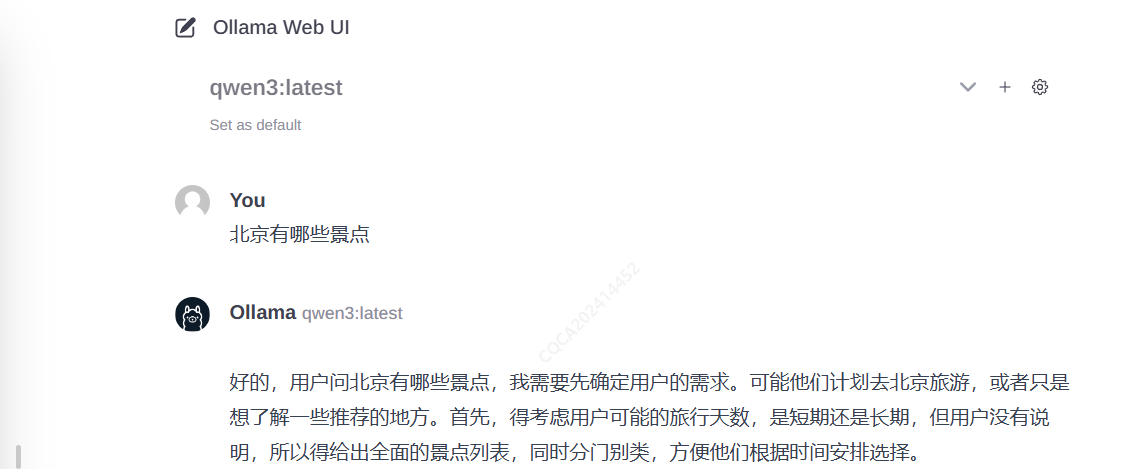

就可以进行问答了。

浙公网安备 33010602011771号

浙公网安备 33010602011771号