如何通俗理解ROPE?=》“旋转”能表达相对位置,数学的优雅在这里面体现得淋漓尽致

非常棒的问题 👍!

你要的是对 RoPE(Rotary Position Embedding) 的直觉 + 向量化例子,

也就是想清楚 到底“旋转”在干什么、向量到底怎么动 ——

那我就用一个动脑可视化的向量故事给你解释清楚。

🧭 一、RoPE 要解决什么问题?

在 Transformer 里,每个词都是一个向量。

模型要理解句子“我 爱 你”,不仅要知道是哪些词,

还要知道它们的 顺序和相对位置。

传统位置编码(比如 sin, cos)是给每个词附上“坐标标签”;

而 RoPE(旋转位置编码) 则是:

👉 在隐空间里,把每个词向量 按一定角度旋转一下。

这样位置关系就隐含在角度里了。

🌀 二、二维直觉(简单可视化)

先从二维开始(简单到能画出来):

假设我们有一个二维词向量

x=(x1,x2)x=(x1,x2)RoPE 对位置 pp 的变换就是:

RoPEp(x)=[cosθp−sinθpsinθpcosθp][x1x2]RoPEp(x)=[cosθpsinθp−sinθpcosθp][x1x2]换句话说:

把向量 xx 绕原点逆时针旋转一个角度 θpθp。

其中角度一般设定为:

θp=p⋅ωθp=p⋅ωωω 是在不同维度上固定的旋转速率。

📐 三、一个“可感知”的例子

设这三个词向量的初始值(没加位置编码前)几乎相同:

| position | token | 向量初值 | 旋转角度 |

|---|---|---|---|

| 1 | “我” | (1, 0) | 0°0° |

| 2 | “爱” | (1, 0) | 30°30° |

| 3 | “你” | (1, 0) | 60°60° |

经过 RoPE 后:

| token | 编码后向量 = (cos, sin) |

|---|---|

| “我” | (1.00,0.00)(1.00,0.00) |

| “爱” | (0.87,0.50)(0.87,0.50) |

| “你” | (0.50,0.87)(0.50,0.87) |

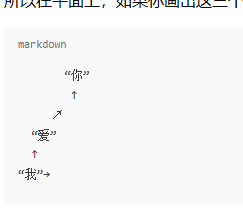

所以在平面上,如果你画出这三个点,就是一个顺次转动的扇形:

它们的顺序在角度上已经被写进去了。

🧮 五、扩展到高维(向量化操作)

RoPE 实际上是对每两个连续的特征通道做二维旋转,例如:

输入维度 d=6d=6 时,

我们分成 3 组 2D 小对:

| 维度 | 向量对 | 旋转角度(例) |

|---|---|---|

| (0,1) | (x0,x1)(x0,x1) | p⋅ω0p⋅ω0 |

| (2,3) | (x2,x3)(x2,x3) | p⋅ω1p⋅ω1 |

| (4,5) | (x4,x5)(x4,x5) | p⋅ω2p⋅ω2 |

每个小组旋转不同速率的角度,

从而让不同维度编码不同频率的位置信息。

最终结果就是:

每个 token 的隐空间表示,被“多频率旋转”之后,

角度模式能同时表示“绝对位置 + 相对偏移”。

🎻 六、一段向量化伪代码(PyTorch风格)

def rope(x, position, base=10000):

dim = x.shape[-1]

half = dim // 2

freqs = torch.exp(-torch.arange(0, half) / half * np.log(base))

theta = position[:, None] * freqs[None, :]

cos, sin = torch.cos(theta), torch.sin(theta)

x1, x2 = x[..., :half], x[..., half:]

x_rotated = torch.cat([x1 * cos - x2 * sin,

x1 * sin + x2 * cos], dim=-1)

return x_rotated

🚀 七、总结一句话:

RoPE = 在高维空间中,让每个维度成对组成一个旋转系,随着位置不断转动角度。

角度差 encode 了相对距离,也让模型能自然地“外推”到更长的文本序列。

🌈 八、延伸想象(生活比喻)

想象每个词向量是一个指向的箭头(罗盘指针):

第一词指东,第二词东南,第三词南……

当你看一群箭头时,不光看到词语,还能看到它们顺序方向的节奏。

这就是 RoPE 的“旋转语义”。

要不要我帮你画一张二维图——显示三个词在平面上被依次旋转后的向量方向?

一眼能看出角度差就是相对位置信息。

浙公网安备 33010602011771号

浙公网安备 33010602011771号