纯属部署踩坑笔记,若有未注明出处,请联系删除

一、下载并启动Ollama

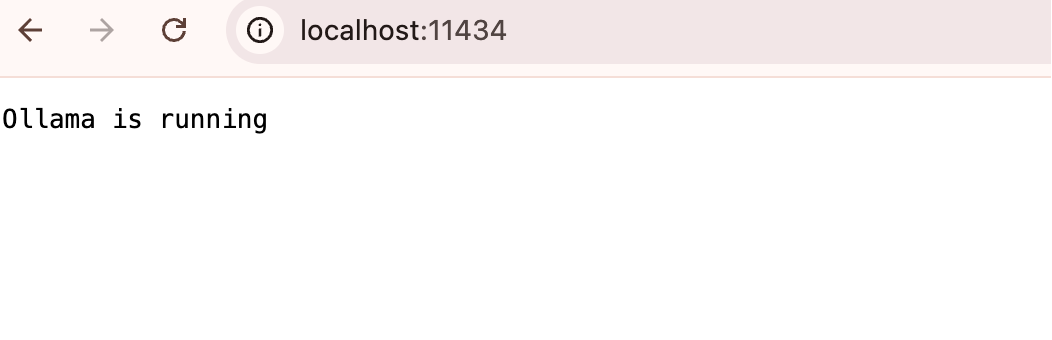

- 下载Ollama并启动(打开浏览器,访问http://localhost:11434)

![Clipboard_Screenshot_1754662434]()

二、运行Ollama并与Qwen3聊天

- ollama run qwen3:8b

- 启动成功后,ollama 在本地 11434 端口启动了一个 API 服务,可通过

http://localhost:11434 访问。 如需运行其它模型,访问 Ollama Models 了解详情

三、在Dify中接入Ollama

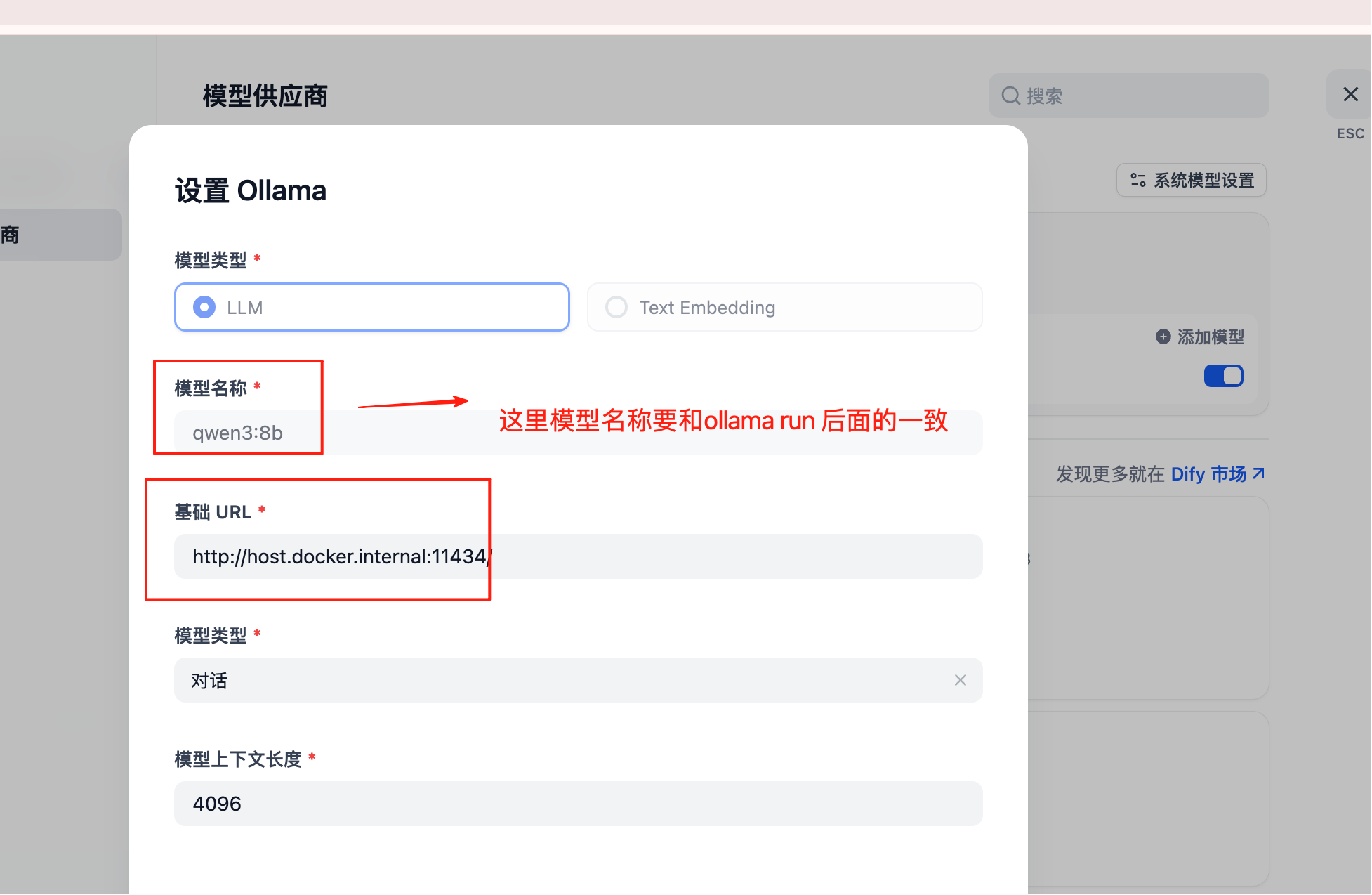

- 在Dify--设置--模型供应商-安装模型供应商中找到Ollama(若Ollama已安装部署且启动成功,这里就能找到Ollama--然后点击install安装)

- Ollama安装后,在Ollama下选择“添加模型”--按如下截图设置

- 基础URL填写ollama服务地址,若是Docker部署的,则建议填写局域网IP地址,Docker容器的内部IP地址 http://host.docker.internal:11434

![Clipboard_Screenshot_1754663157]()

四、使用Ollama模型

- 在Dify平台上设置聊天机器人应用,并输入内容,得到响应

![Clipboard_Screenshot_1754664289]()

![Clipboard_Screenshot_1754662077]()

posted @

2025-08-08 22:46

Balllyh

阅读(

406)

评论()

收藏

举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号