day29-shadoop

day29-shadoop

hadoop

Hadoop运行环境的搭建

虚拟环境准备

- 配置网络

- 修改主机名

- vim /etc/hostname

- 配置主机名称映射

- vim /etc/hosts

- 修改windows的映射文件(hosts)

- 关闭防火墙

- 创建atguigu用户

- 配置atguigu用户具有root权限

vim /etc/sudoers

sudoers:修改用户权限的配置文件

atguigu ALL=(ALL) NOPASSWD:ALL

- 再/opt目录下创建module software文件夹

- 修改module、software文件夹的所有者

安装JDK

- 下载jdk tar.gz

- 解压jdk

- 配置环境变量

- 查看是否安装成功

java -version

安装hadoop

- 下载安装包 tar.gz

- 解压缩

- 配置环境变量 bin sbin

- 查看是否安装成功

hadoop version

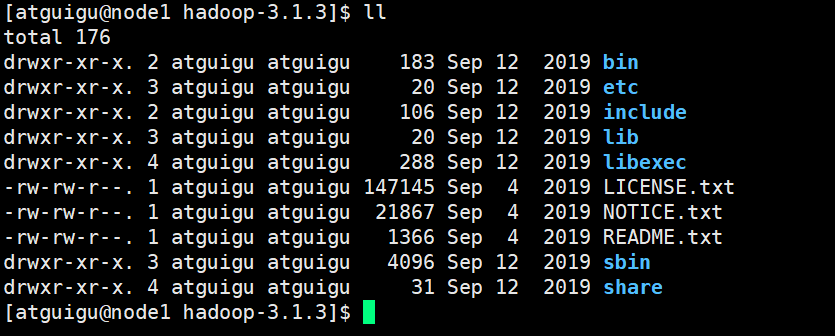

Hadoop的目录结构

bin 命令:

hadoop

hdfs

mapred

yarn

sbin 脚本:

start-dfs.sh

start-yarn.sh

start-all.sh

stop-all.sh

stop-dfs.sh

yarn-daemon.sh

- etc 配置文件

capacity-scheduler.xml

core-site.xml

hdfs-site.xml

hadoop-env.sh

workers

yarn-site.xml

mapred-site.xml

- share 存放jar包

把写好的代码保存jar包的形式,保存再share文件中

官方提供的案例,用来测试搭好的hadoop框架是否有问题

hadoop-mapreduce-examples-3.1.3.jar

Hadoop运行模式

Hadoop 运行模式包括:本地模式、伪分布式、完全分布式

本地模式(单点模式)

Hadoop默认配置就是本地模式,因此不需要进行任何设置即可运行本地模式。

官方Grep案例

- 在hadoop-3.1.3文件下面创建一个input文件夹

mkdir input

- 将Hadoop的xml配置文件复制到input

cp etc/hadoop/*.xml input

- 执行share目录下的MapReduce程序

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar grep input output 'dfs[a-z]+'

hadoop 执行命令

jar 执行一个jar包

share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar jar包错在的路径

grep jar包中的一个案例

input 作为输入数据的目录

output 结果输出的目录

dfs[a-z]+ 解析输入数据的规则

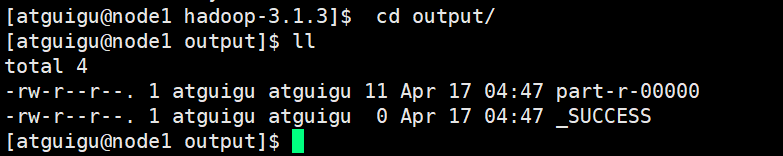

- 查看输出结果

_SUCCESS 作为标记,说明当前运行是成功的,里面没有内容。

part-r-00000 结果文件

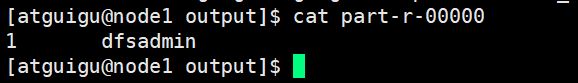

解析的结果内容:dfsadmin

从input目录中的文件解析得到的数据

其他

epel-release

EPEL(Extra Packages for Enterprise Linux)是基于Fedora的项目,为 红帽系 的操作系统提供额外的软件包,适用于RHEL、CentOS和Scientific Linux

装上了EPEL之后,就相当于添加了一个地三方源,官方的rpm repository提供的rpm包也不够丰富,很多时候需要自己编译,而EPEL恰恰可以解决这两方面的问题。

浙公网安备 33010602011771号

浙公网安备 33010602011771号