tensorflow零起点快速入门(5) --强化学习摘录截图(tf与np)

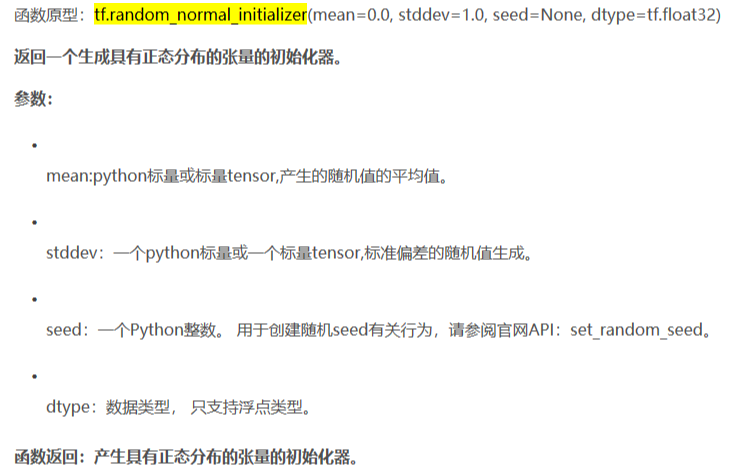

tf.random_normal_initializer

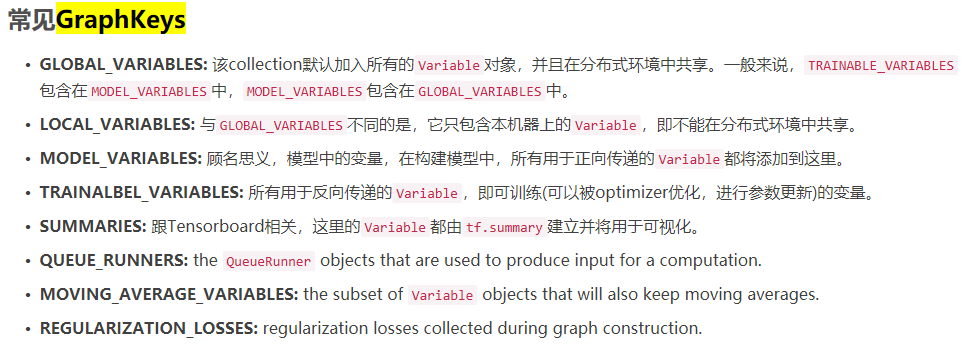

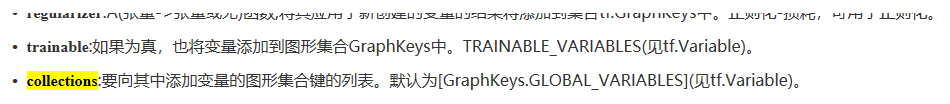

tf的GraphKeys用法

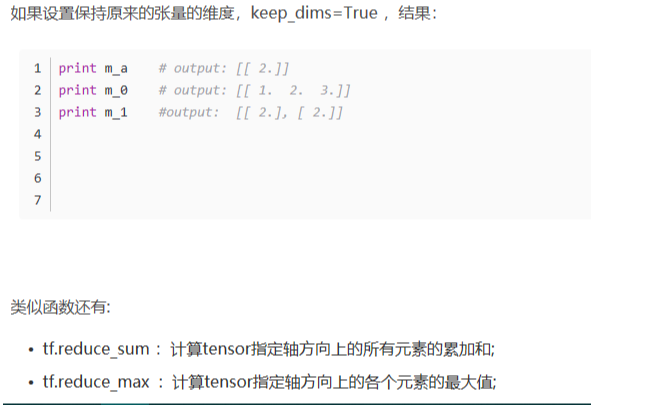

tf.reduce_mean

tf.squared_difference

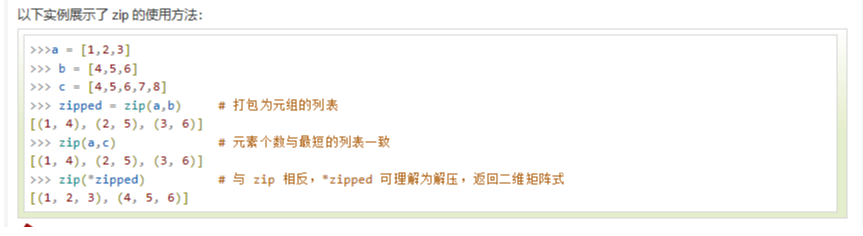

非tf中的zip,python的zip用法

非tf中的hstack,numpy的hstack用法

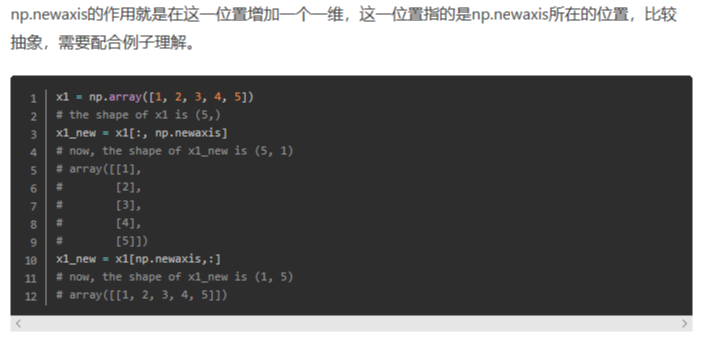

非tf中的newaxis,numpy的newaxis用法

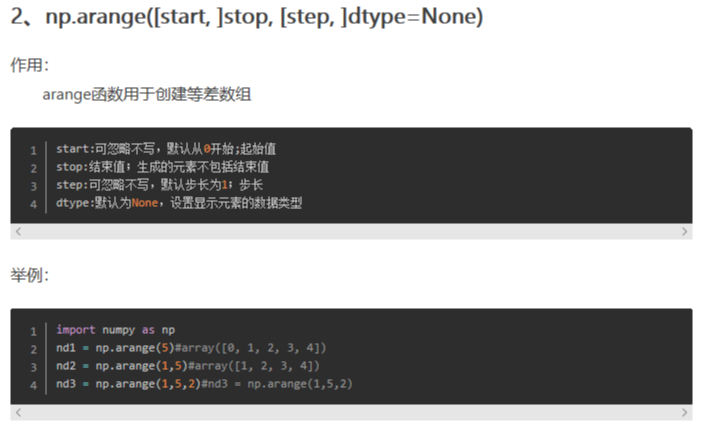

非tf中的arange,numpy的arange用法

tf.nn.relu6

tf.nn.tanh

tf.distributions.Normal

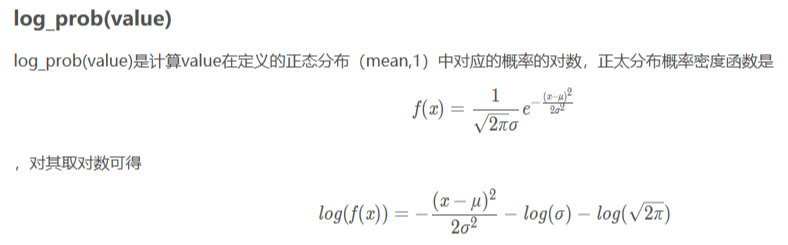

log_prob---tf.distributions.Normal

如下取了对数,应该是后面两项少了一个括号吧。。。

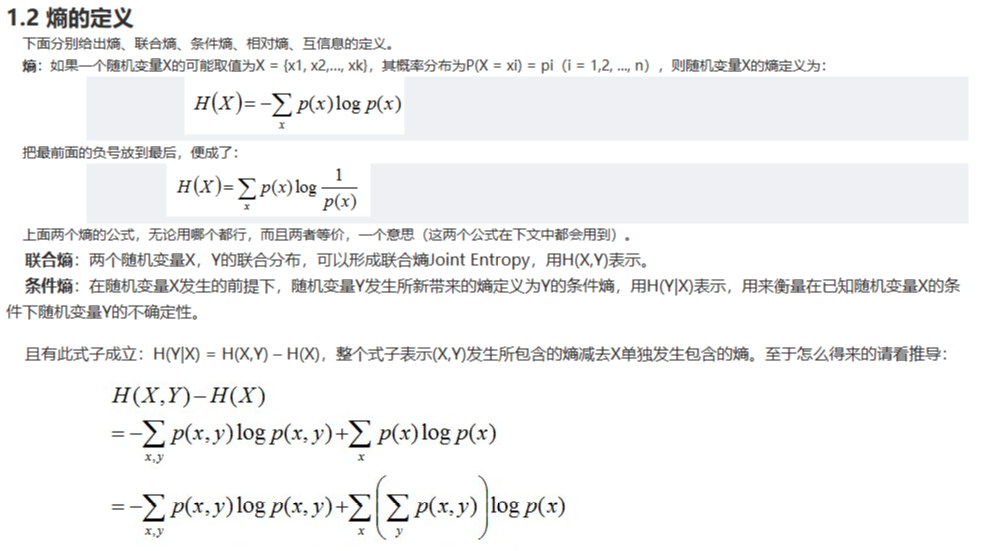

熵的定义

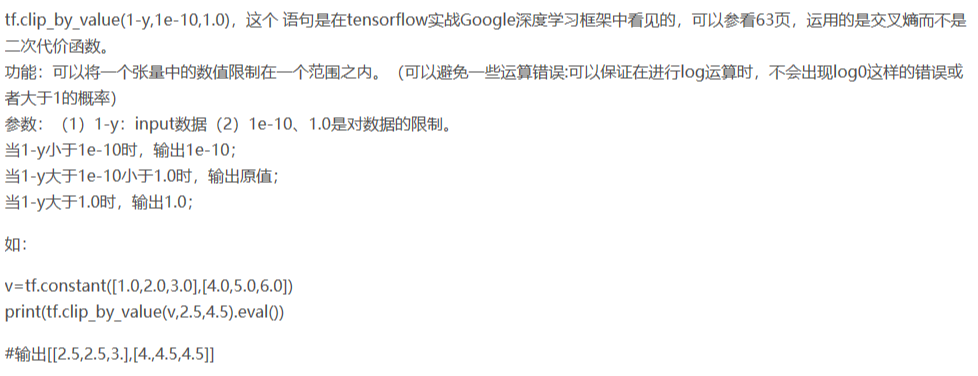

tf.clip_by_value

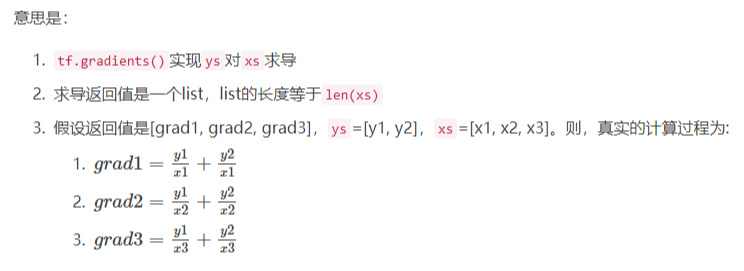

tf.gradients

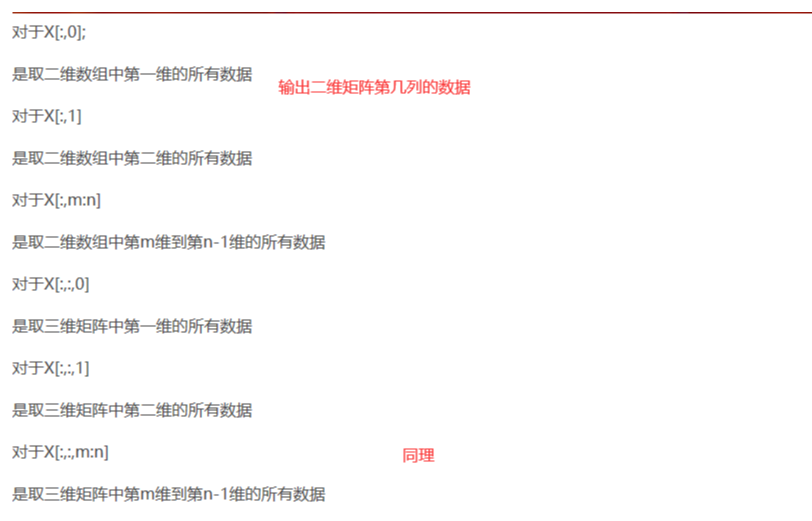

二维及以上矩阵取值运算

tf的softmax策略迭代与对应求导

非tf中的random.choice,numpy的random.choice用法

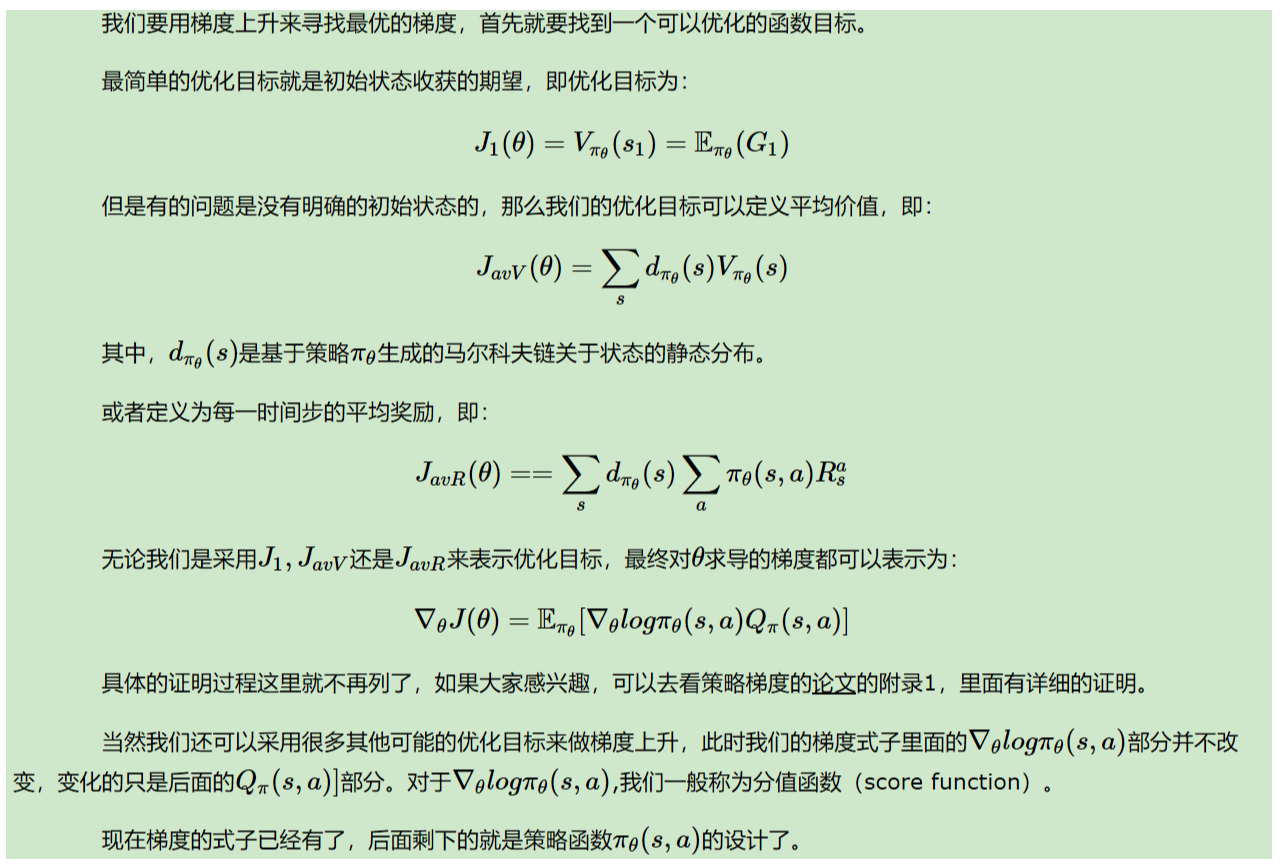

策略梯度的梯度上升问题

策略表示中的softmax

计算交叉熵

tf.truncated normal与tf.random normal

numpy的shape

numpy的ravel、flatten、squeeze数据拉平

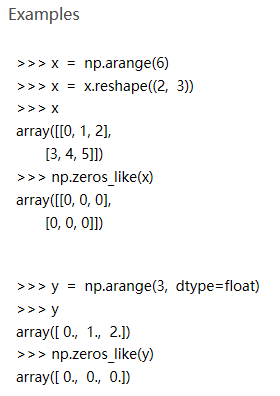

numpy的zeros_like

Le vent se lève! . . . il faut tenter de vivre!

Le vent se lève! . . . il faut tenter de vivre!

浙公网安备 33010602011771号

浙公网安备 33010602011771号