稀疏大规模多目标优化问题

阅读文献: An Enhanced Competitive Swarm Optimizer With Strongly Convex Sparse Operator for Large-Scale Multiobjective Optimization

是由王翔宇、王健等人发表在 IEEE TRANSACTIONS ON EVOLUTIONARY COMPUTATION(JCR一区)上的一篇文章

Abstract

考虑到稀疏大规模MOPs的Pareto最优集是稀疏的,提出了三重竞争机制的竞争群体优化来充分探索空间和利用优秀解;用强凸稀疏算子来保证生成解的稀疏性。

Introduction

粒子群优化(PSO):惯性+向lBest移动+向gBest移动,变体:前期探索,后期收敛

多目标优化问题(MOPS):具有多个待优化目标

大规模:决策变量的维度高,搜索空间↑

竞争群体优化器(CSO):惯性+向胜者移动+向平均位置移动,变体:加速项、更新比例

稀疏指的是?

在大规模优化问题中,并不是每一维变量都会对目标函数函数产生影响,也就是虽然决策变量的维度很高,但是有意义的维度却很少

为什么稀疏的大规模问题比较难以解决?

1.维度越高,搜索空间越大,越需要搜索能力更强的算法.

2.交叉变异有可能对没有意义的维度进行操作,会使种群中存在大量冗余的个体.

Background

Pareto最优解、非支配解

- 可以获得多个解作为相互冲突的目标之间的权衡

- 如果没有任何解既能在一个目标上比A更好,同时在其他目标上至少和A一样好,那么A就是一个非支配解。

Pareto前沿面

- 由所有Pareto最优解构成的Pareto集在客观空间上的像

- 在没有恶化某个目标的情况下,无法改善任何其他目标的解。

Method

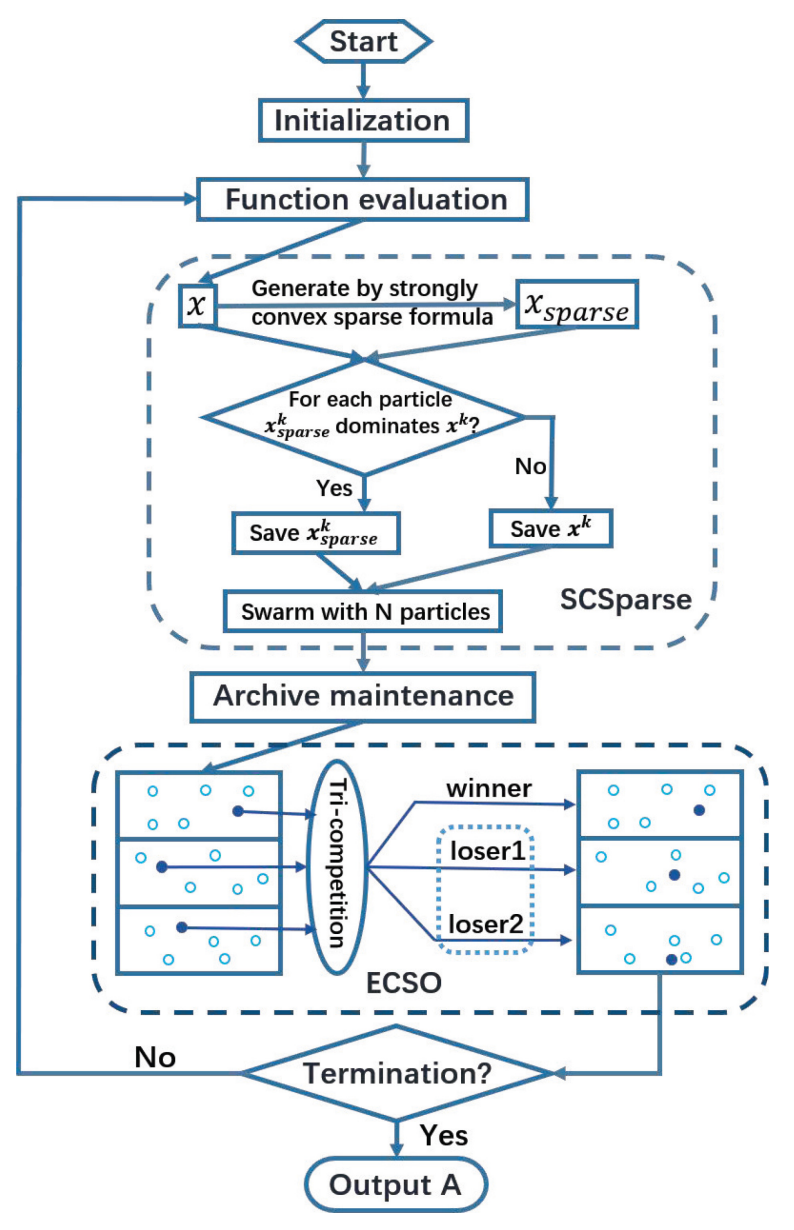

A. 总体结构

框架从随机初始化N个粒子的位置和速度开始。在主循环中,评估粒子的适应度值。然后,在SCSparse中,通过优化一个强凸函数,基于推导出的公式生成一个更稀疏的解。根据适应度值,保存原始解和新生成解之间的非支配解。之后,维护归档,并且在ECSO的一次三方竞争中获得的两个失败者通过两种不同的更新策略进行更新,以平衡探索和利用。如果迭代未终止,粒子将传递到下一代。

初始化:位置代表了潜在解,而速度决定了粒子搜索新解的方向和距离。

粒子的适应度值(Fitness Value):用来评价这个点(即解)对于目标函数的适应程度,或者说是这个解的质量。

通过优化一个强凸函数,基于推导出的公式生成一个更稀疏的解。根据适应度值,保存原始解和新生成解之间的非支配解

“强凸”指的是具有特定数学性质的函数,这种性质保证了函数的最小化问题有唯一解,并且解对于输入的微小变化具有良好的稳定性。“稀疏”则指解向量中大部分元素为零或接近零,这有助于简化模型并提高计算效率。

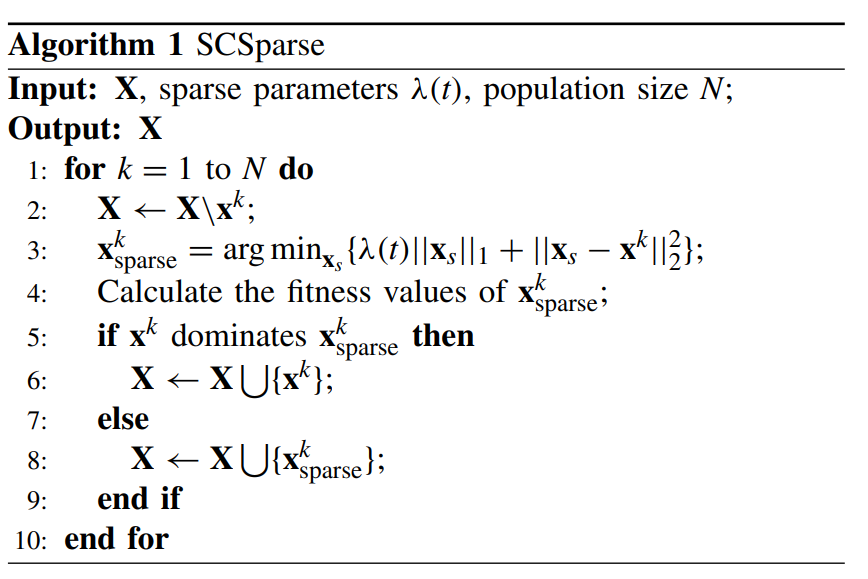

B. 强凸稀疏算子

输入:当前解集,参数,种群大小

输出:更新后解集

循环遍历每个候选解:

将当前候选解从解集中移除

构造稀疏解,使其在当前候选解的附近并且具有稀疏性

计算稀疏解的适应度值(fitness values),确定性能

比较原始解和稀疏解,保留性能较好的

构造稀疏解:

处理每个决策变量的稀疏性:非微分点计算次梯度

当初值足够小,不超过参数时,直接设为零,以产生稀疏解。

当初值超过参数时,通过减去或加上参数来调整,确保解的合理性和稀疏性,防止过度稀疏而丧失有效信息。

C. 存档维护

选择更新:计算并比较适应度,即如果原粒子和稀疏粒子互不支配,则同时保留,否则只保留支配关系最优解。

多样性:添加扰动(高斯变异),有助于跳出局部最优

容量管理:截断

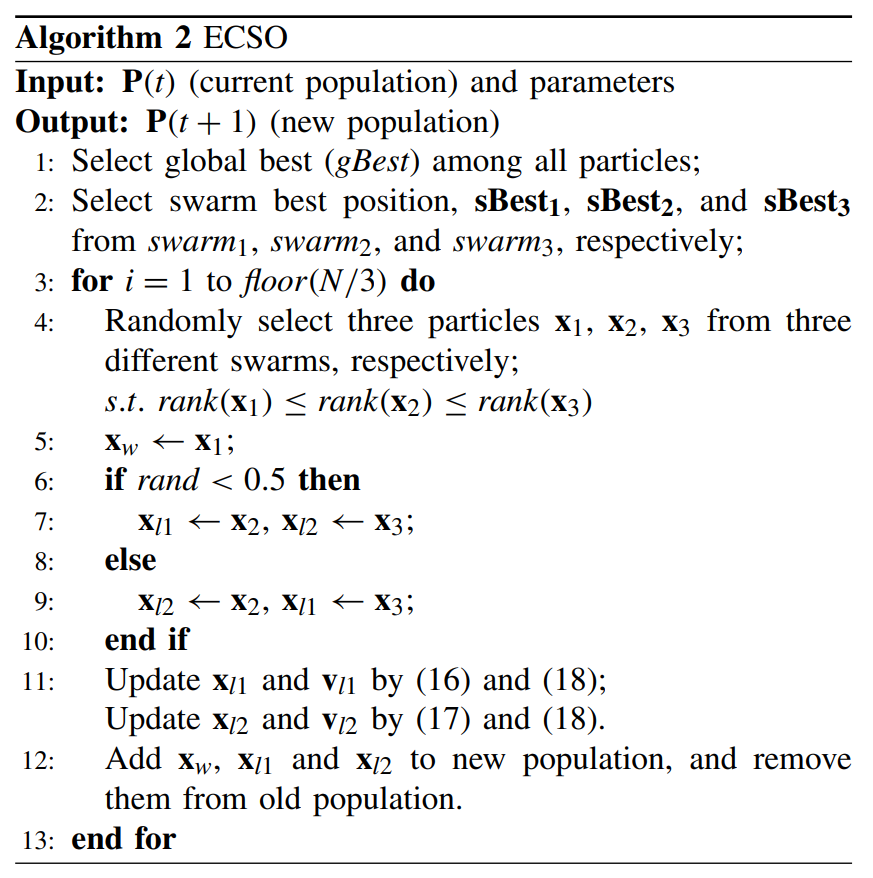

D. 增强型竞争群优化算法

输入:当前种群、参数

输出:更新后的种群

1:从所有粒子中选择适应度最优的解作为全局最优解gBest

2:从三个不同的子群中分别选择群体最优位置

3-13:循环遍历

遍历种群中的每个粒子,随机选择来自不同子群的三个粒子,这三个粒子按适应度排序。

按照排序结果设定获胜粒子(此处x1获胜)

随机选择变更策略(跟据随机数确定粒子的角色)

更新粒子位置和速度

将更新后的粒子添加到新种群,并从旧种群中移除

变更策略:

利用角色l1:惯性+向群体最优靠近+向全局最优靠近

探索角色l2:惯性+向获胜者靠近

Experiment

接近真实前沿面(收敛性)

Conclusion

专门为解决稀疏MOPs而设计

SCSparse能够有效提升算法识别稀疏解的能力

在探索和利用之间取得良好的平衡,在三竞争机制的基础上,引入了两种不同的策略来更新失败者的速度。

Discussion

进一步探索所提出算法解决现实世界问题的能力,例如,在更大的数据集上进行深度神经架构搜索。此外,未来还应考虑S-ECSO的自适应参数。

浙公网安备 33010602011771号

浙公网安备 33010602011771号