【Datawhale AI夏令营--day1】科大讯飞AI大赛(大模型技术)

一直想学习大模型和AI相关的知识,偶然发现了DataWhale的这个夏令营。

have a try~

虽然是学软件计算机的,但机器学习和大模型,完全没学过。里面总会遇到些不认识的名词。。。

一边跟着教程走一遍问deepseek各种问题哈哈哈。

-

什么是大模型

总结来说:大语言模型 (LLM) 是利用海量数据和巨大参数规模的深度神经网络(主要是Transformer)训练出来的,能够理解、生成和操作人类语言的强大人工智能系统。 -

微调

(Fine-tuning)利用相对少量的任务特定数据,对预训练好的大语言模型进行“精加工”,使其参数朝着解决特定问题、适应特定领域或遵循特定要求的方向进行精细调整,从而释放大模型在特定应用场景下的最大潜力。 -

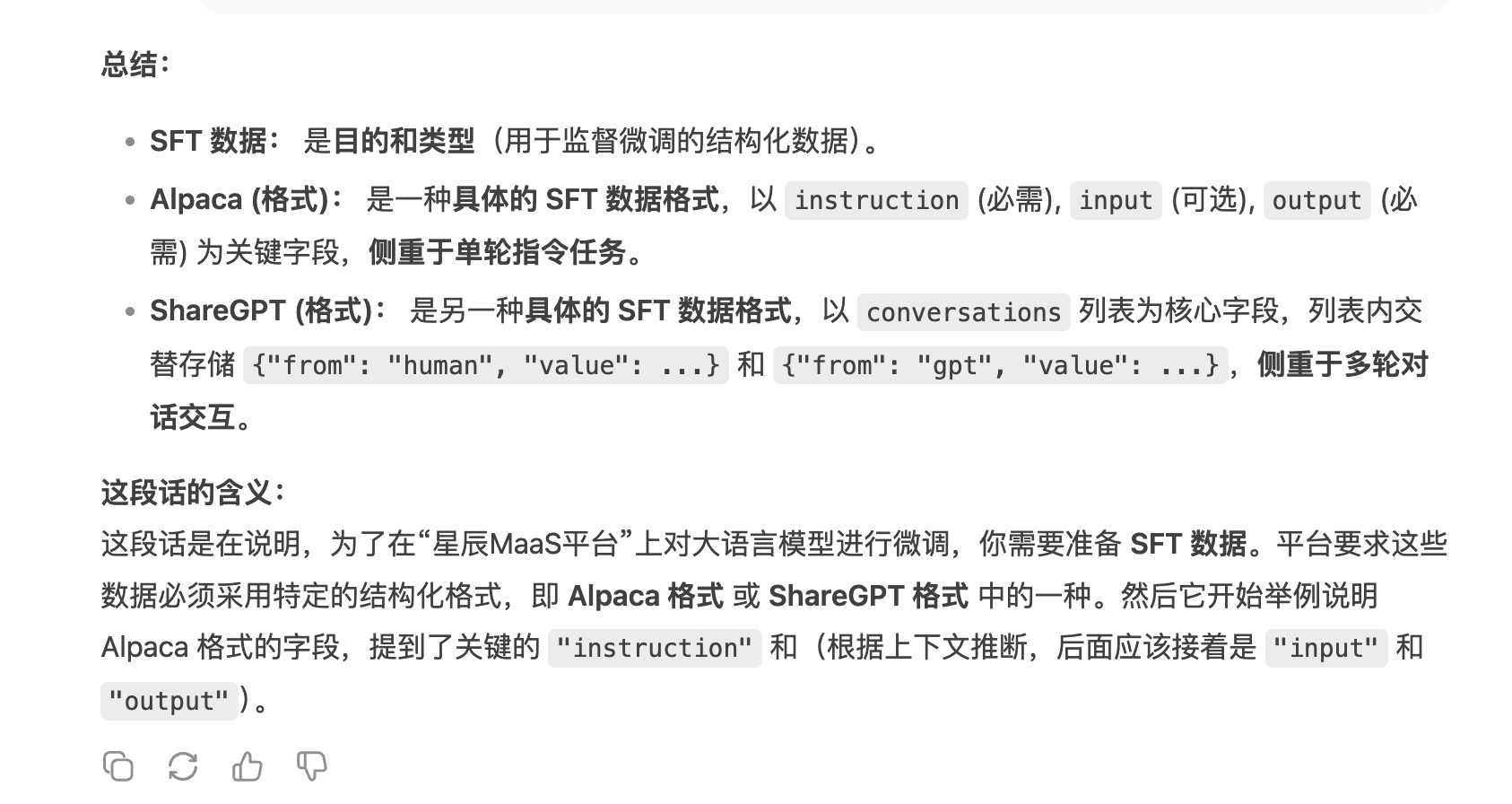

SFT 数据

Supervised Fine-Tuning Data (监督微调数据)是专门用于监督式微调大语言模型(LLM)的数据集。

核心特点: 结构化的 (input, expected_output) 或 (prompt, response) 配对数据。 -

Alpaca (格式)

这是一种结构化的 JSON 格式,用于表示 SFT 数据,源自斯坦福大学发布的 Alpaca 模型项目。

以 instruction (必需), input (可选), output (必需) 为关键字段,侧重于单轮指令任务。 -

ShareGPT(格式)

另一种具体的 SFT 数据格式,以 conversations 列表为核心字段,列表内交替存储 {"from": "human", "value": ...} 和 {"from": "gpt", "value": ...},侧重于多轮对话交互。 -

QA对(Question-Answer Pair)

结构化训练数据,包含 问题(Question) 和对应的 标准答案(Answer)。适用于单轮对话。 -

LoRA精调(Low-Rank Adaptation)

冻结预训练模型权重,仅训练少量低秩矩阵(LoRA Adapters),大幅降低计算成本 -

模型蒸馏(Model Distillation)

一种将大型复杂模型(教师模型)的知识迁移到小型轻量模型(学生模型)的技术,旨在保留高性能的同时显著降低计算开销和部署成本

浙公网安备 33010602011771号

浙公网安备 33010602011771号