Python 网络爬虫基本概念篇

爬虫的概念

网络爬虫(又称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。这是百度百科对爬虫的定义,其实,说简单点,爬虫就是利用写好的程序自动的提取网页的信息。

爬虫的价值

抓取互联网上的数据,为自己服务,有了大量的数据,就如同有了一个数据银行一样,下一步做的就是如何将这些爬取的数据产品化,商业化。马云都说过:未来最值钱的不是房子,而是数据。所以,有了数据,就如同有了大把的财富。从就业来看,做一个爬虫工程师或者数据分析师也是不错的选择。然后,在大数据非常火热的今天(简直是火热到一种无法形容的程度了,2017年我刚高中毕业的时候好像全国开大数据专业的就30个学校左右,如今,我们台州学院今年也申请成功了。前年,我们学院合并,数信和电子合并为电子与信息工程学院,又叫大数据学院。我们一直调侃说连大数据专业都没有,还叫什么大数据学院啊。现在,我们就可以从容的说我们是大数据学院了,这听起来还是挺高大上的,哈哈),爬虫技术的应用场景会越来越多,将来肯定会有很好的发展空间。

爬虫的合法性

这个怎么说呢,技术本身是好的,它只是一个工具,但是你用来做一些违法乱纪的事情,那当然就不好了。所以,具体情况具体分析吧,你做的犯不犯法,自己心里还是得有点逼数的。

爬虫的分类

- 通用爬虫:通用爬虫是搜索引擎(Baidu、Google、Yahoo等)“抓取系统”的重要组成部分。主要目的是将互联网上的网页下载到本地,形成一个互联网内容的镜像备份。 简单来讲就是尽可能的;把互联网上的所有的网页下载下来,放到本地服务器里形成备分,在对这些网页做相关处理(提取关键字、去掉广告),最后提供一个用户检索接口。

- 聚焦爬虫:聚焦爬虫是根据指定的需求抓取网络上指定的数据。例如:获取豆瓣上电影的名称和影评,而不是获取整张页面中所有的数据值。

- 增量式爬虫:增量式是用来检测网站数据更新的情况,且可以将网站更新的数据进行爬取。

robots协议

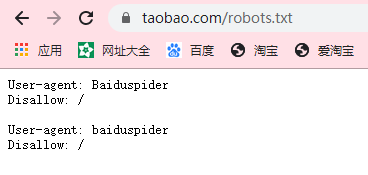

就是所谓的"君子协议",是一个文本格式的文件,它里面表明了哪些内容可以爬取,哪些不可以爬取.这样既可以保护隐私和敏感信息,又可以被搜索引擎收录、增加流量。

可以通过网站域名 + /robots.txt的形式访问该网站的协议详情,例如:https://www.taobao.com/robots.txt ,下面就是淘宝网的robots协议截图:

浙公网安备 33010602011771号

浙公网安备 33010602011771号