Attentional Factorization Machines: Learning the Weight of Feature Interactions via Attention Networks阅读笔记

动机

本文是2017年IJCAI上的一篇论文。FM方法通过结合二阶特征交互来增强线性回归模型,它将这些特征交互一视同仁,给予它们一个相同的权重,但是并不是所有特征的交互都是有意义的,更具体的,不同的特征交互之间有不同的重要性。而FM模型忽略了这一点,这可能会带来一些噪声,本文作者提出了AFM模型,通过注意力机制学习到不同特征交互的重要性从而解决上述问题。

方法

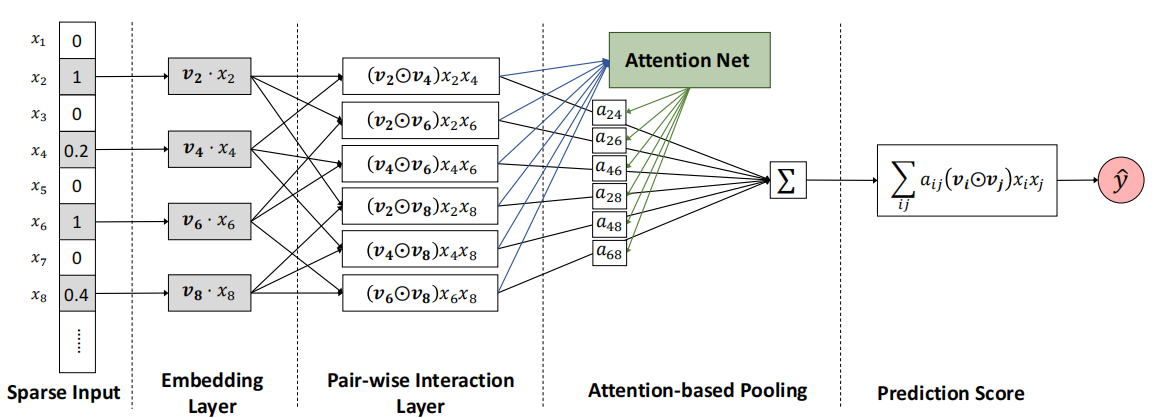

AFM结构如下图。

从左往右,首先是Sparse Input层,这一层是特征的输入,输入是稀疏的。

之后通过一个embedding层,获取用户(物品)的特征表示。

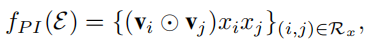

接着是Pair-wise Interaction层,这一层计算的是特征之间的交互,具体计算方法为

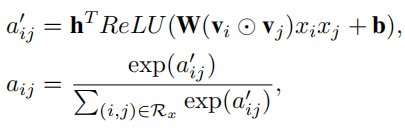

然后是Attention-based Pooling,这一层通过一个MLP计算出特征交互的注意力分数,之后再将交互加权求和。

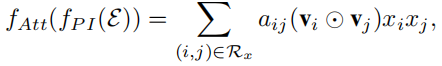

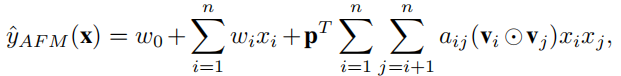

最终的预测为

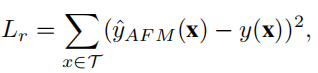

本文中的任务是预测用户评分,是一个回归任务,使用mse loss。其他任务可根据具体情况使用不同的损失函数。

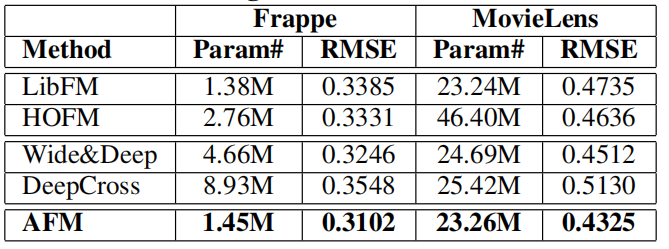

实验结果

作者在两个数据集上做了相关实验,本文提出的AFM取得最好效果。

总结

本文主要贡献就在于Attention-based Pooling这一层,通过注意力网络计算出不同特征交互的重要性,提高模型表达能力,同时也提高了模型的可解释性,可以通过注意力分数就看出哪些特征交互重要性更高,具有一定的指导性意义。

浙公网安备 33010602011771号

浙公网安备 33010602011771号