Ollama+DeepSeek-R1+Open WebUI 操作指南

近期在各大视频网站中看到关于AI技术去帮助用户进行答疑的,比如文生图,图生图,文生视频等操作,不得不感叹技术的强大,尤其是最近很火的DeekSeek,能给人输出很优美的文字。网上deepseek开导一个独自异地打拼的失业小女孩的故事很打动我,仿佛一位穿越历史的智慧老人,用富有哲理,优美的话,鼓励小女孩,给出建设性建议。这个故事让我看到了deepseek发光的点,因此也让我萌生了想自己搭建一下这个框架的想法。以下是我今天通过摸索学习和实践,整理出来的操作步骤,分享给有需要的同学,大家共同学习。

一 Ollama

1.Ollama 介绍

Ollama 是一个让你能在本地运行大语言模型的工具,为用户在本地环境使用和交互大语言模型提供了便利,具有以下特点:

1)多模型支持:Ollama 支持多种大语言模型,比如 Llama 2、Mistral 等。这意味着用户可以根据自己的需求和场景,选择不同的模型来完成各种任务,如文本生成、问答系统、对话交互等。

2)易于安装和使用:它的安装过程相对简单,在 macOS、Linux 和 Windows 等主流操作系统上都能方便地部署。用户安装完成后,通过简洁的命令行界面就能与模型进行交互,降低了使用大语言模型的技术门槛。

3)本地运行:Ollama 允许模型在本地设备上运行,无需依赖网络连接来访问云端服务。这不仅提高了数据的安全性和隐私性,还能减少因网络问题导致的延迟,实现更快速的响应。

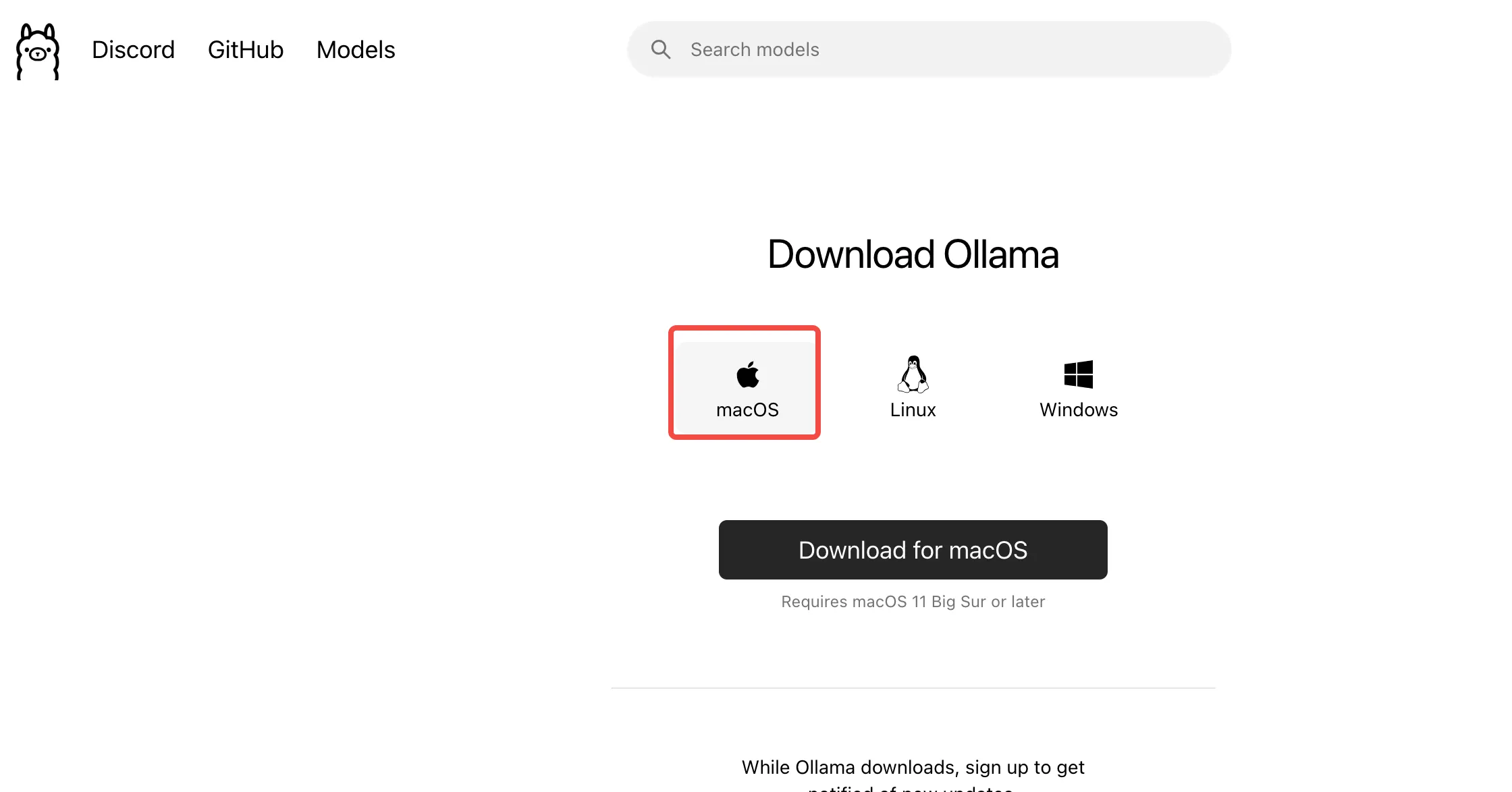

2.Ollama 官网下载安装

搜索Ollama进入官网https://ollama.com/download,选择安装MAC版本的安装包,点击安装即可

或者用命令去安装

# 使用Homebrew安装 brew install ollama # 或直接下载安装包 curl https://ollama.ai/download/Ollama-darwin.zip -o Ollama.zip unzip Ollama.zip

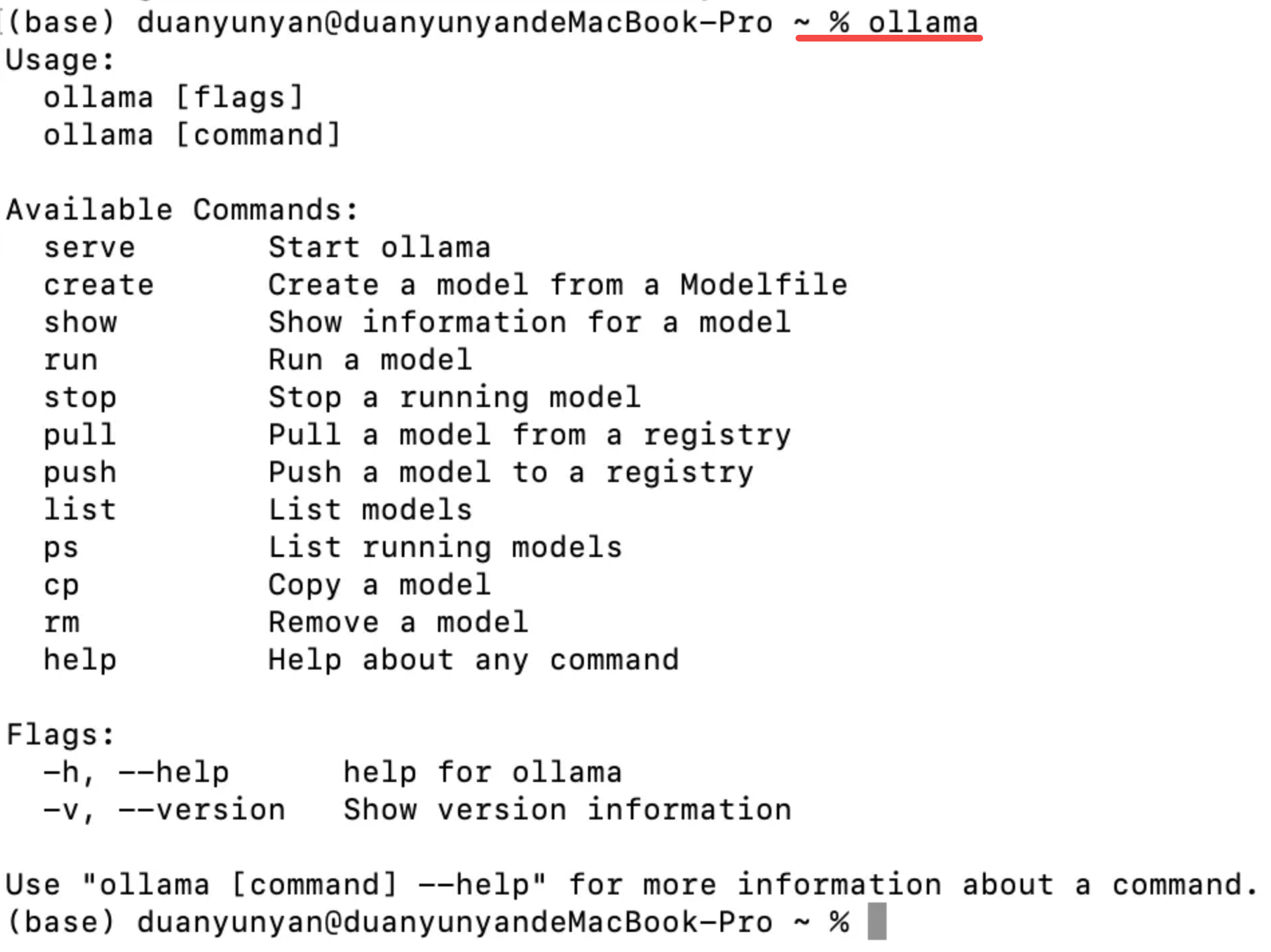

3.输入命令,检查是否安装成功

命令:ollama,出现下面内容,说明安装成功

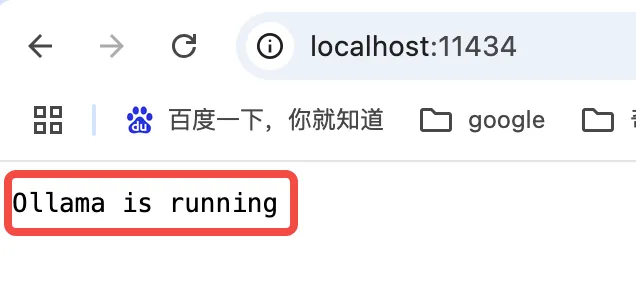

4.启动Ollama服务

#输入命令【ollama serve】,浏览器http://localhost:11434/打开,显示running,说明启动成功

5.模型存储位置

Mac下,Ollama的默认存储位置:

- 模型文件:

~/.ollama/models - 配置文件:

~/Library/Application Support/Ollama

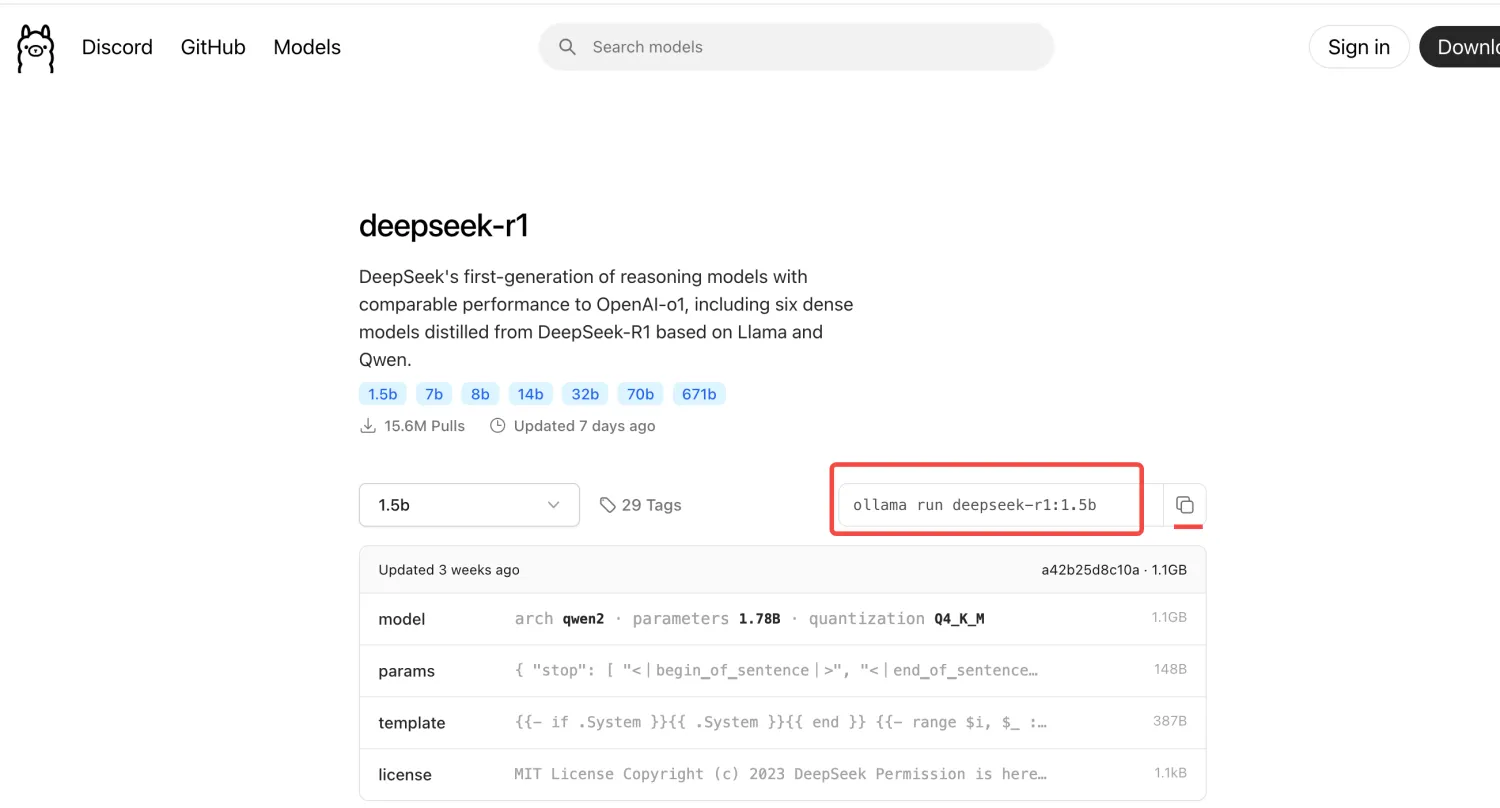

二 deepseek-R1模型安装

1.在https://ollama.com/library/deepseek-r1:1.5b 搜索deepseek-R1,跳转到下面的页面,复制这个命令,在终端执行,下载模型

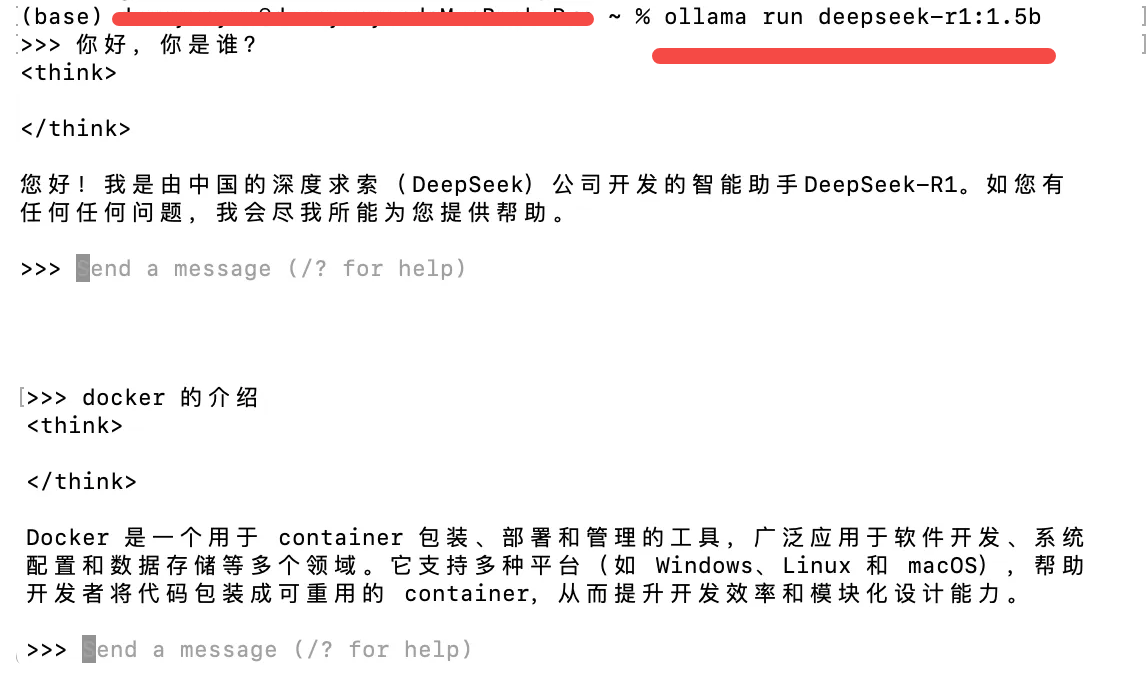

2.下载完成以后,会出现success,可以问:你好,你是谁?deepseek-R1,会给出回复。

3.下次访问,需要2步:

1)点击桌面的Ollama图标,只是启动了软件,可以打开http://localhost:11434/打开,显示running。具体与deepseek对话,还需要在终端提问。

2)再次打开终端,想访问deepseek-R1,运行ollama run deepseek-r1:1.5b 命令,就可以

三 OpenWebUI 的安装

1.Docker的安装

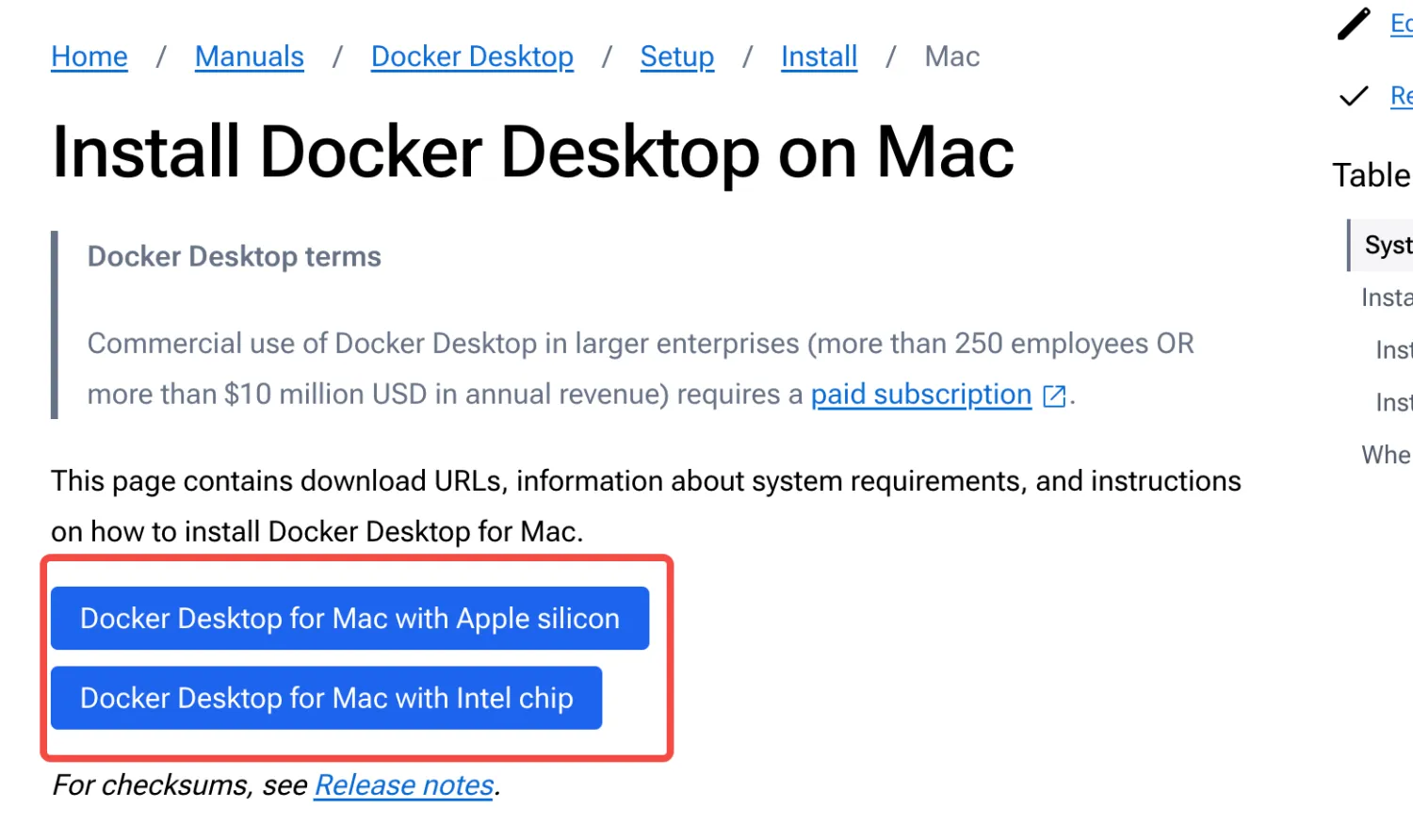

Docker的官网:https://docs.docker.com/desktop/setup/install/mac-install/ 根据自己的电脑配置信息,下载需要的Mac docker 版本。此时要求MACOS 12以上

2.Open WebUi 的安装

进入Open-WebUI官网(https://openwebui.com)点击【Get OpenWebUI】按钮,跳转到代码页

3.安装Open WebUI

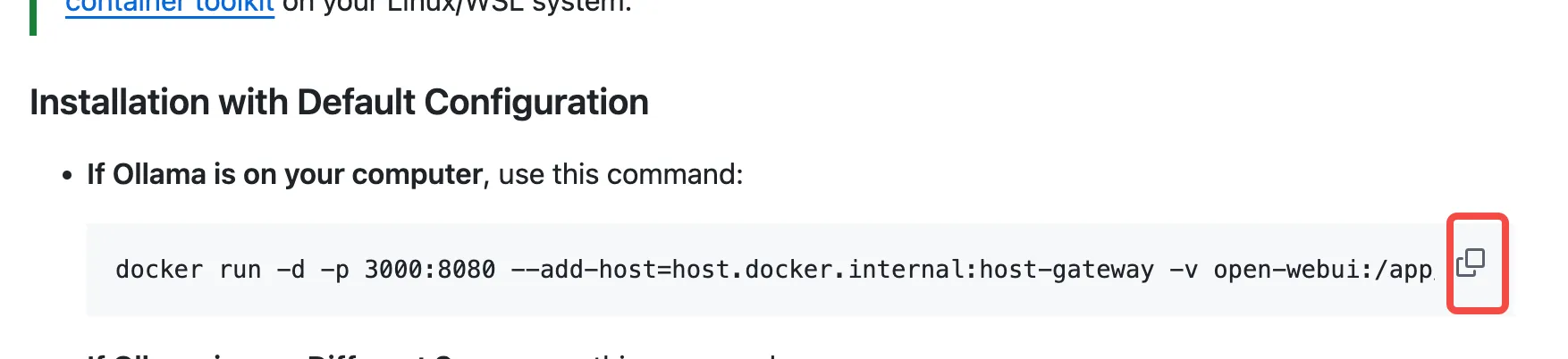

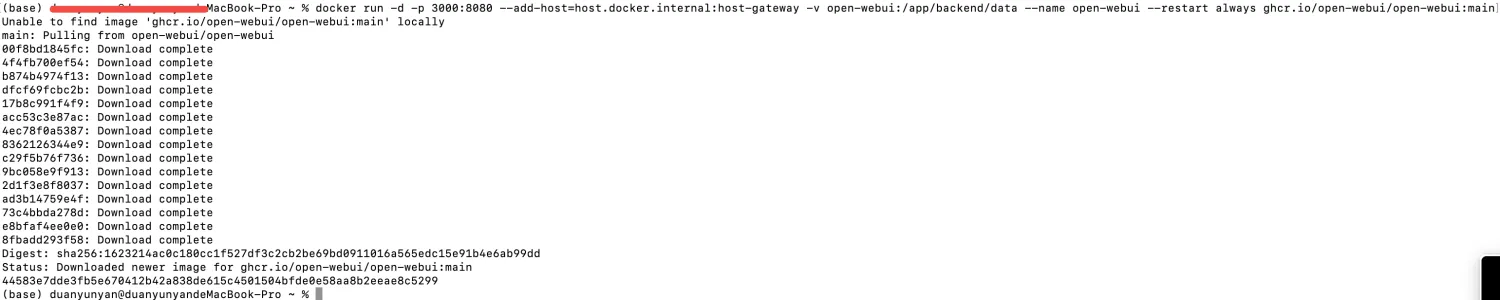

复制下面的命令,到终端,安装Open WebUI

4.运行Open WebUI

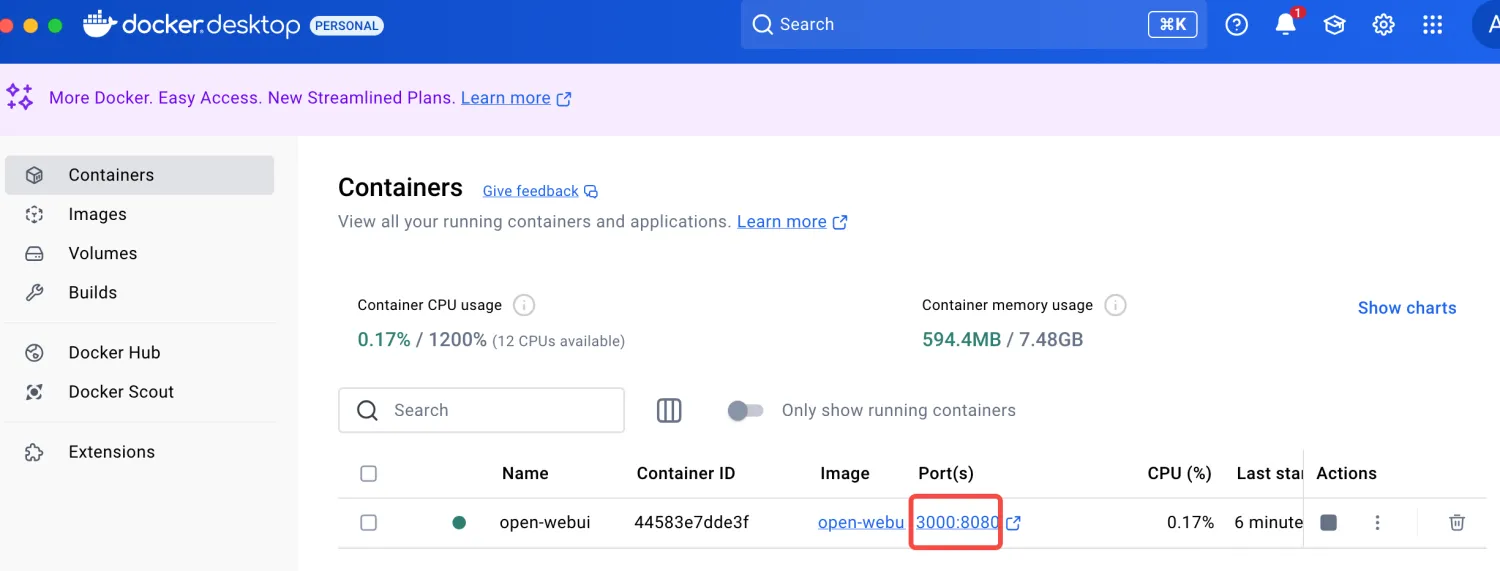

安装完以后,双击Docker图标,点击下面的端口,就可以运行Open WebUI,实现可视化问答,如下:

进入可视化页面,进行问答体验。

浙公网安备 33010602011771号

浙公网安备 33010602011771号