As a reader --> Diffusion Models for Imperceptible and Transferable Adversarial Attack

- 📌论文分类5:

https://github.com/WindVChen/DiffAttack- 论文名称 Diffusion Models for Imperceptible and Transferable Adversarial Attack

- 作者 Chen J, Chen H, Chen K, et al.

- 期刊名称 arXiv preprint arXiv:2305.08192, 2023.

- 简要摘要

许多现有的对抗性攻击在图像RGB空间上产生lp范数扰动。尽管在可转移性和攻击成功率方面取得了一些成就,但精心制作的对抗性样本很容易被人眼感知。对于视觉的不可感知性,最近的一些研究探索了不受lp范数约束的无限制攻击,但缺乏攻击黑箱模型的可转移性。这项工作利用扩散模型的生成和判别能力,提出了一种新的难以察觉和可转移的攻击。具体来说,不是在像素空间中直接操作,而是在扩散模型的潜在空间中制造扰动。结合精心设计的内容保存结构,可以生成嵌入语义线索的人类不敏感的扰动。

为了更好的可转移性,本文进一步“欺骗”可以被视为隐式识别代理的扩散模型,通过将其注意力从目标区域转移开。提出的方法DiffAttack是第一个将扩散模型引入对抗性攻击领域的方法。在各种模型结构、数据集和防御方法上进行的大量实验表明,攻击优于现有的攻击方法。

- 关键词

- ✏️论文内容

- 【内容1】

- 💡Introduction & Related Works

- 基于lp范数的方法

采用RGB色彩空间中的lp -范数作为人类感知的指标,并将对抗性扰动的幅度限制在一个特定的值下。尽管付出了努力,但这些基于像素的攻击仍然容易被人眼感知,并且Lp-norm最近被发现不适合测量两幅图像之间的感知距离。这可能会阻碍向其他黑箱模型的可转移性,并且很容易被净化防御方法防御。

- 面向难以察觉的攻击

无限制的攻击通过对物体属性、颜色映射矩阵等空间施加扰动,尽管RGB空间中的lp -范数很大,但对抗性样本仍然难以被感知。这揭示了无限制攻击产生的扰动更多地关注于具有高级语义的相对大规模模式,而不是操纵像素级强度,从而有利于攻击转移到其他黑盒模型,甚至防御的黑盒模型。然而,这些方法的可移植性仍然落后于基于像素的方法。

- 本文提出了一种基于扩散模型的新型无限制攻击。没有直接操作像素,而是优化了现有的预训练扩散模型的潜在优势。除了上面提到的高级扰动的基本可转移性优势外,将扩散模型引入对抗性攻击领域的动机主要来自它的两个有益特性:

- ①良好的隐蔽性

扩散模型最初是为图像合成而设计的,它倾向于生成符合人类感知的自然图像。这种固有的特性很好地符合对抗性攻击的不可感知性要求。此外,扩散模型内的迭代去噪过程有助于降低可感知的高频噪声。

- ②隐式代理的近似性

尽管最初是为图像合成而设计的,但在大规模数据集上训练的扩散模型表现出显著的判别能力。基于这个特性,能够将它们近似为基于传输的攻击的隐式代理模型。利用这种“隐式代理”,可以潜在地增强不同模型和防御方之间的可转移性。

- 此外,扩散模型的去噪过程类似于强大的净化防御,可以进一步增强攻击防御机制的有效性。

- ①良好的隐蔽性

- 为了利用扩散模型的有利属性,本文工作包括三个关键方面:

- ①建立了一个基本的攻击框架,该框架首先将干净图像转换为噪声,然后在潜在空间中引入修改。这与现有的图像编辑技术不同(操纵引导文本以实现内容编辑)。本文直接操作扩散模型的潜力,这可以显著提高攻击成功率。

- ②提出偏离文本和图像像素之间的交叉注意映射,可以将扩散模型转换为可以被实际欺骗和攻击的隐式代理模型。最后,为了避免扭曲初始语义,具体考虑了自注意约束和反转强度等措施。

- 将提出的无限制攻击称为DiffAttack,贡献总结如下:

- 第一个揭示扩散模型具有显著生成和隐式判别能力,它是创建具有高度不可感知性和可转移性的对抗性样本的有希望的基础。

- 提出了DiffAttack,这是一种新的不受限制的攻击,通过精心设计利用了扩散模型的良好特性。通过利用交叉注意图和自注意图,攻击扩散模型的潜在性,使DiffAttack具有隐蔽性和可转移性。

- 在各种模型架构、数据集和防御方法上进行的广泛实验,证明了工作优于现有的攻击方法。

- ①建立了一个基本的攻击框架,该框架首先将干净图像转换为噪声,然后在潜在空间中引入修改。这与现有的图像编辑技术不同(操纵引导文本以实现内容编辑)。本文直接操作扩散模型的潜力,这可以显著提高攻击成功率。

- 基于lp范数的方法

- 💡Introduction & Related Works

- 【内容2】

- 💡Method

![]()

- 基本框架

- 图2中展示了DiffAttack的整个框架,采用开源的Stable Diffusion (Rombach et al, 2022),该框架对海量文本图像对进行了预训练。由于对抗性攻击的目的是通过干扰初始图像来欺骗目标模型,因此可以近似为一种特殊的真实图像编辑。受到最近扩散编辑方法的启发(Couairon et al, 2022;Mokady等,2022;Parmar等人,2023),框架利用DDIM反演技术(Song等人,2021),通过反转确定性采样过程,将干净图像映射回扩散潜空间:

![]()

- Inverse(·)表示DDIM反演操作。为了简单起见,忽略了稳定扩散的自编码器阶段,对从x0(初始图像)到xt的几个时间步进行反演。

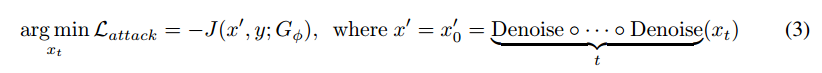

- 许多现有的图像编辑方法提出对图像编辑中的文本嵌入进行修改,在文本引导下,图像潜文本在迭代去噪过程中逐渐向目标语义空间偏移。然而,发现在引导文本嵌入上的扰动很难在其他黑盒模型上起作用,导致较弱的可转移性。因此,与编辑方法不同,在这里提出直接扰动潜在的xt:

![]()

- 其中J(·)为交叉熵损失,Denoise(·)为扩散去噪过程。对于使用这种简单的方法可能会产生不自然的结果,最初可能会引起关注。然而,由扰动潜在图像重建的图像与原始的干净图像之间的差异几乎无法区分。此外,差异图像封装了许多高级语义线索,而不是与基于像素的攻击相关的高频噪声。将这种现象归因于扩散模型的去噪过程,它有效地降低了可感知的高频噪声。这些语义丰富的扰动不仅可以增强不可感知性,而且有利于攻击的可转移性。

- 图2中展示了DiffAttack的整个框架,采用开源的Stable Diffusion (Rombach et al, 2022),该框架对海量文本图像对进行了预训练。由于对抗性攻击的目的是通过干扰初始图像来欺骗目标模型,因此可以近似为一种特殊的真实图像编辑。受到最近扩散编辑方法的启发(Couairon et al, 2022;Mokady等,2022;Parmar等人,2023),框架利用DDIM反演技术(Song等人,2021),通过反转确定性采样过程,将干净图像映射回扩散潜空间:

- “欺骗”扩散模型

- 根据Nie et al(2022)的研究,扩散模型的反向过程是一种强大的对抗性净化防御。因此,在解码为最终图像之前,扰动潜信号将经历净化,从而确保精心制作的对抗示例的自然性以及对其他净化降噪的鲁棒性。

- 除了利用去噪组件外,还进一步提高了攻击的可转移性。给定图像及其对应的标题,,在重建过程中,交叉注意图显示了引导文本与图像像素之间很强的关系,这表明了预训练扩散模型潜在的识别能力。因此,在大量数据上训练的扩散模型可以近似为一个隐式识别模型。这里的动机是,如果精心设计的攻击可以“欺骗”这个模型,可以期望改进到其他黑盒模型的可转移性。

- C作为干净图像的标题,将其设置为groundtruth类别的名称。在所有去噪步骤中累积图像像素与C之间的交叉注意映射并得到平均值。为了“欺骗”预训练的扩散模型,建议最小化以下公式:

![]()

- 其中Var(·)计算输入的方差,Cross(·)表示去噪过程中所有交叉注意图的累加,SDM为稳定扩散。这种洞察力是为了分散扩散模型对标记对象的注意力。将注意力均匀地分配到每个像素,可以破坏原始的语义关系,确保精心制作的对抗样本很好地“欺骗”扩散模型。通过这样的设计,DiffAttack显示了隐式集成特性。

- 根据Nie et al(2022)的研究,扩散模型的反向过程是一种强大的对抗性净化防御。因此,在解码为最终图像之前,扰动潜信号将经历净化,从而确保精心制作的对抗示例的自然性以及对其他净化降噪的鲁棒性。

- 保留内容结构

- 无限制攻击可以近似为一种图像编辑方法,因此内容结构的改变是不可避免的。如果变化的程度没有得到控制,那么产生的对抗性示例可能会失去初始干净图像的大部分语义,这会失去对抗性攻击的意义。因此,在这里主要从两个角度来保存内容结构。

- Self-Attention Control.

基于自相似的描述符可以捕获结构信息,而忽略图像外观。根据这个想法,扩散模型中的自注意也嵌入了这个属性,这与主要关注高级语义的交叉注意形成对比。因此,建议利用自注意图进行结构保留,对所有去噪步骤应用自注意约束。

- Inversion Strength Trade-off.

随着DDIM反演强度的增加,潜函数xt将更接近于纯高斯分布,对其的扰动会受到更多去噪步骤的影响而造成严重的失真。而有限的反演无法提供足够的攻击空间,因为潜函数先验太强。反转强度是在不可感知性和攻击成功之间的权衡。

扩散模型倾向于在早期去噪步骤中添加粗糙的语义信息(例如布局),而在后期步骤中添加更精细的细节。因此,在去噪过程的后面控制反转以保留高级语义,并减少DDIM样本的总步骤以获得更多的编辑空间。

除了以上操作外,还采用Mokady等人(2022)的方法,通过优化无条件嵌入来获得良好的初始重构。

- 无限制攻击可以近似为一种图像编辑方法,因此内容结构的改变是不可避免的。如果变化的程度没有得到控制,那么产生的对抗性示例可能会失去初始干净图像的大部分语义,这会失去对抗性攻击的意义。因此,在这里主要从两个角度来保存内容结构。

- 💡Method

- 【内容3】

- 💡Experiments

- ImageNet-Compatible Dataset

- 评估了攻击在各种网络结构中的可转移性,包括:CNNs,Transformers,MLPs

- Results on Normally Trained Models

- five pixel-based attacks:MI-FGSM DI-FGSM TI-FGSM PI-FGSM S^2I-FGSM

- two unrestricted attacks: PerC-AL NCF

- ①DiffAttack可以在各种模型结构之间实现最佳的可转移性,而其他无限制攻击通常无法与基于像素的攻击竞争。

- ②与MI-FGSM, DI-FGSM, TI-FGSM, PIFGSM和S2 I-FGSM相比,本文攻击更加难以察觉,其他攻击存在容易被感知的高频噪声。与NCF相比,DiffAttack在色彩空间上更加自然。对于PerC-AL来说,虽然攻击很难被察觉,但其可移植性是最差的。

- five pixel-based attacks:MI-FGSM DI-FGSM TI-FGSM PI-FGSM S^2I-FGSM

- Results on Defense Approaches

- input preprocessing defenses and adversarially trained models

- 本文方法在应用一些防御措施的情况下,具有较好的鲁棒性,并且优于其他方法。对于对抗性净化防御,攻击成功率与其他攻击相比变化最小,这验证了DiffAttack的鲁棒性和设计的有效性。

- input preprocessing defenses and adversarially trained models

- 💡Experiments

- 【内容1】

- Conclusion

- 探索了扩散模型在制作对抗性样本中的潜力,并提出了一种强大的基于转移的无限制攻击。通过利用扩散模型的特性,实现了不可感知性和可转移性。

- 探索了扩散模型在制作对抗性样本中的潜力,并提出了一种强大的基于转移的无限制攻击。通过利用扩散模型的特性,实现了不可感知性和可转移性。

- 论文名称 Diffusion Models for Imperceptible and Transferable Adversarial Attack

To see I can not see,

to know I do not know.

浙公网安备 33010602011771号

浙公网安备 33010602011771号