InterLM第二课

InternLM-Chat-7B 智能对话 Demo

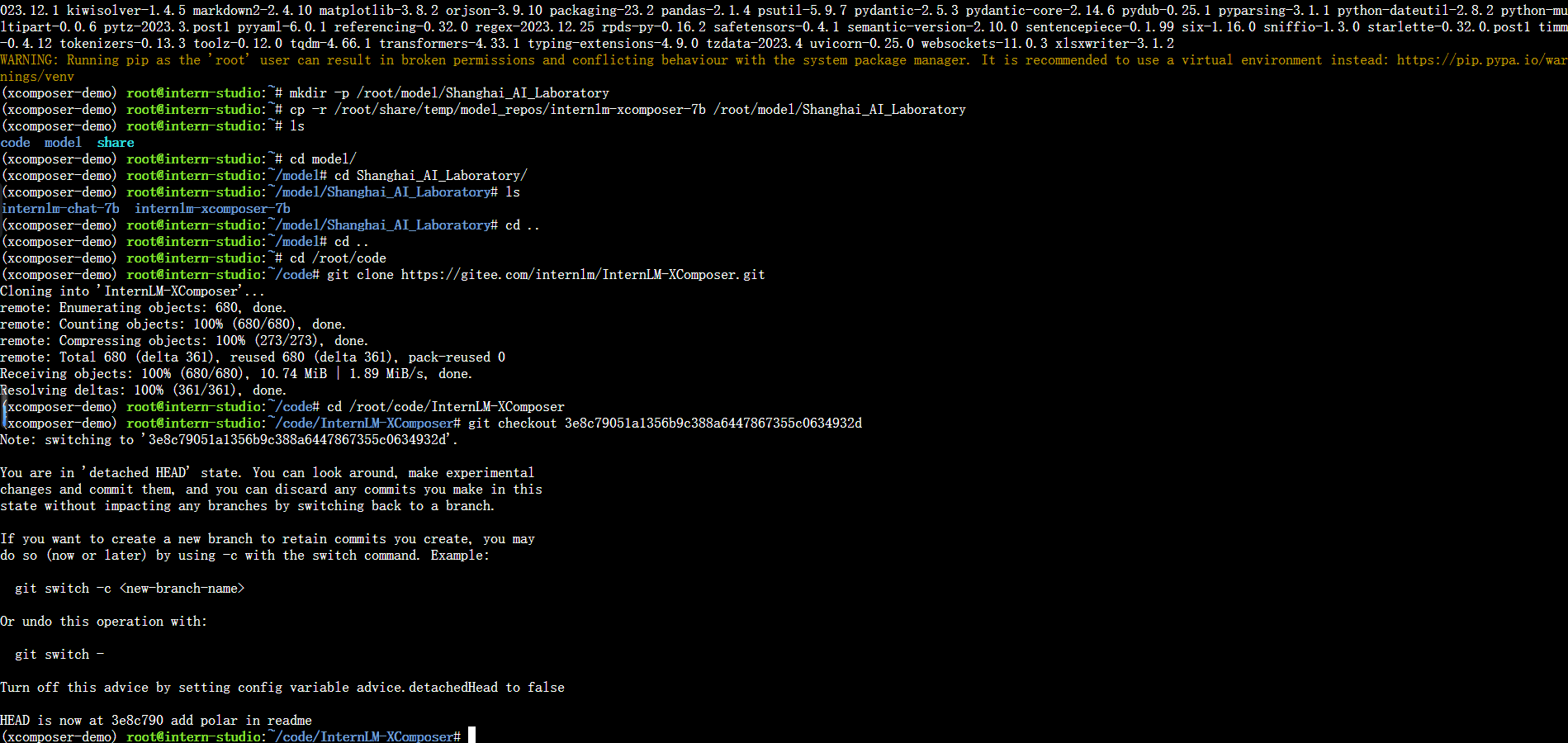

环境准备

python版本与需要安装的包

模型下载

从share文件夹中获取所需要的模型和数据

将代码移动到/root/code/InterLM文件夹,同时切换代码版本

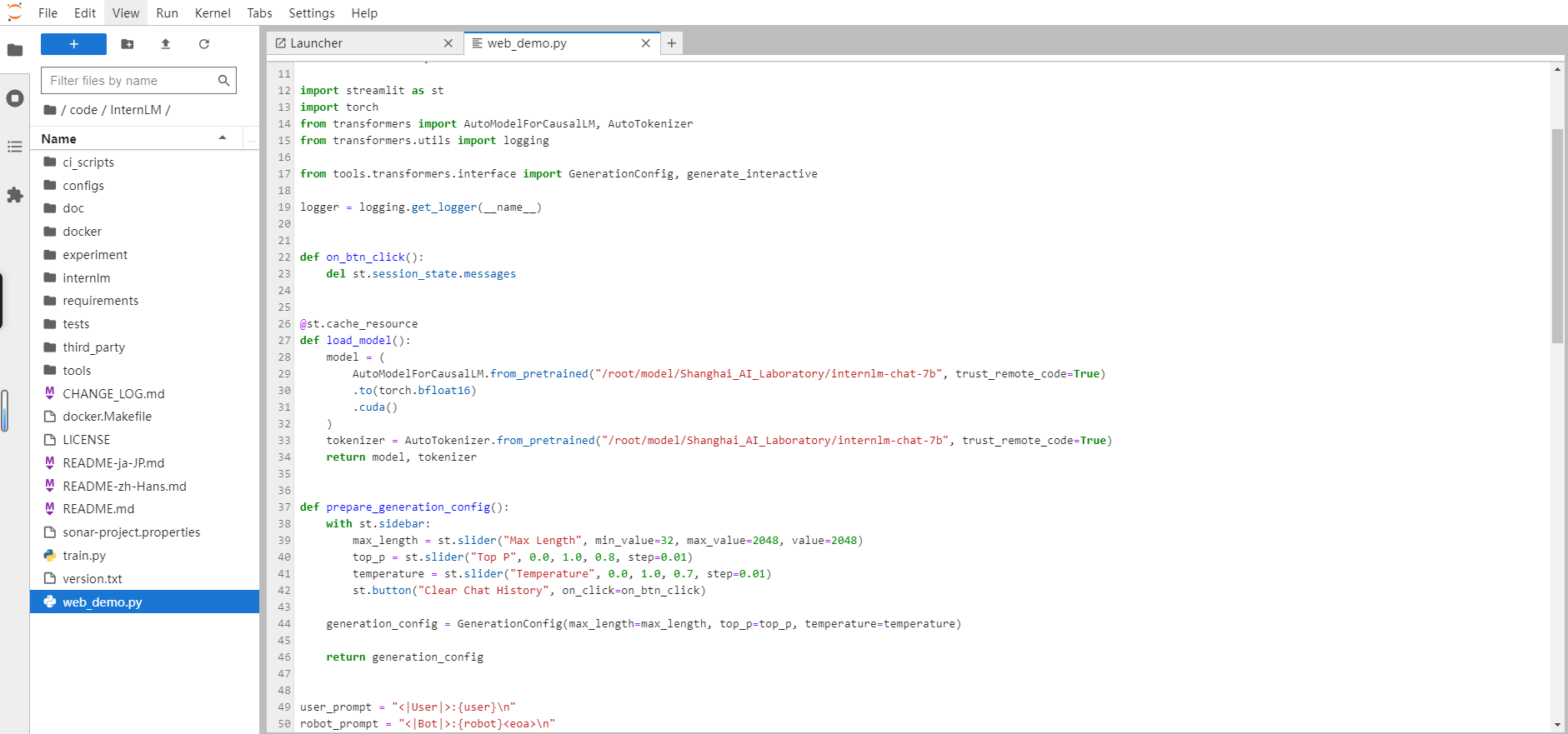

修改web_demo.py中的模型地址,换为本地地址

创建文件cli_demo.py,并将内容写入文件

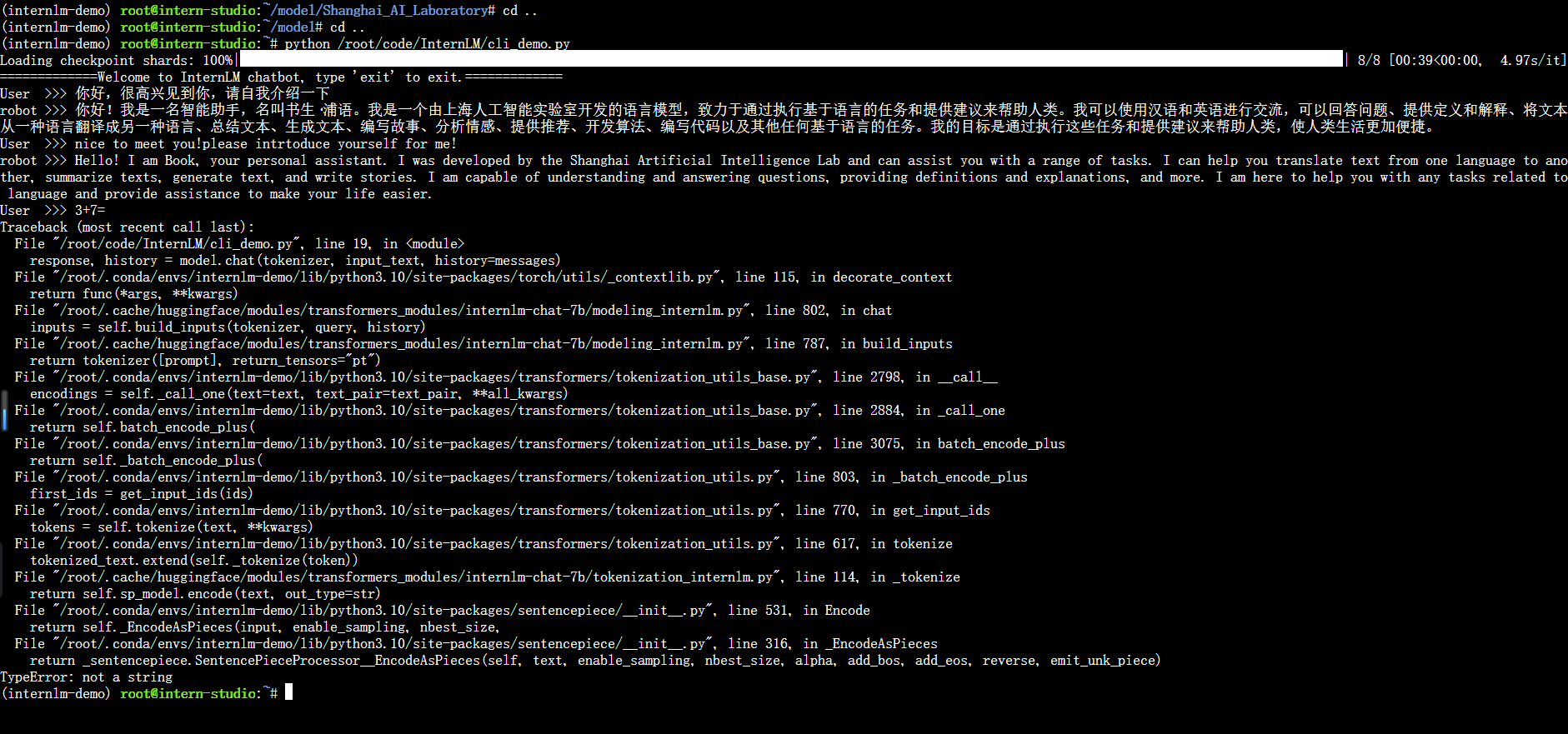

终端运行

正常中英文问答没有问题

不过给一个算式直接炸了

然后重新跑了一下,又没问题了

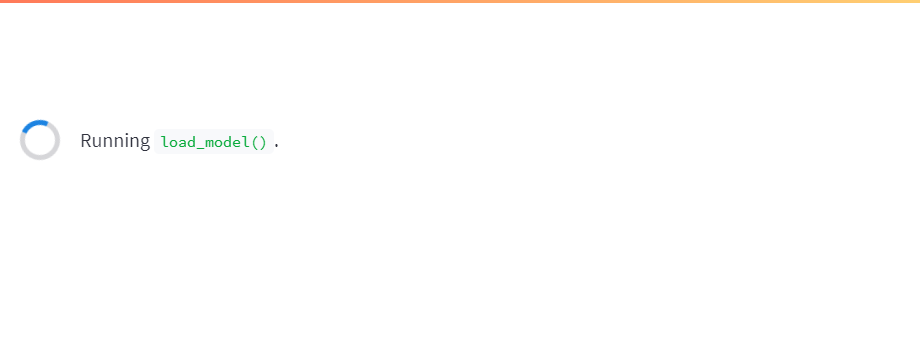

web运行

设置好端口映射后运行代码

运行模型

运行结果

Lagent 智能体工具调用 Demo

环境准备

跟上边的一样

模型下载

已经复制好了

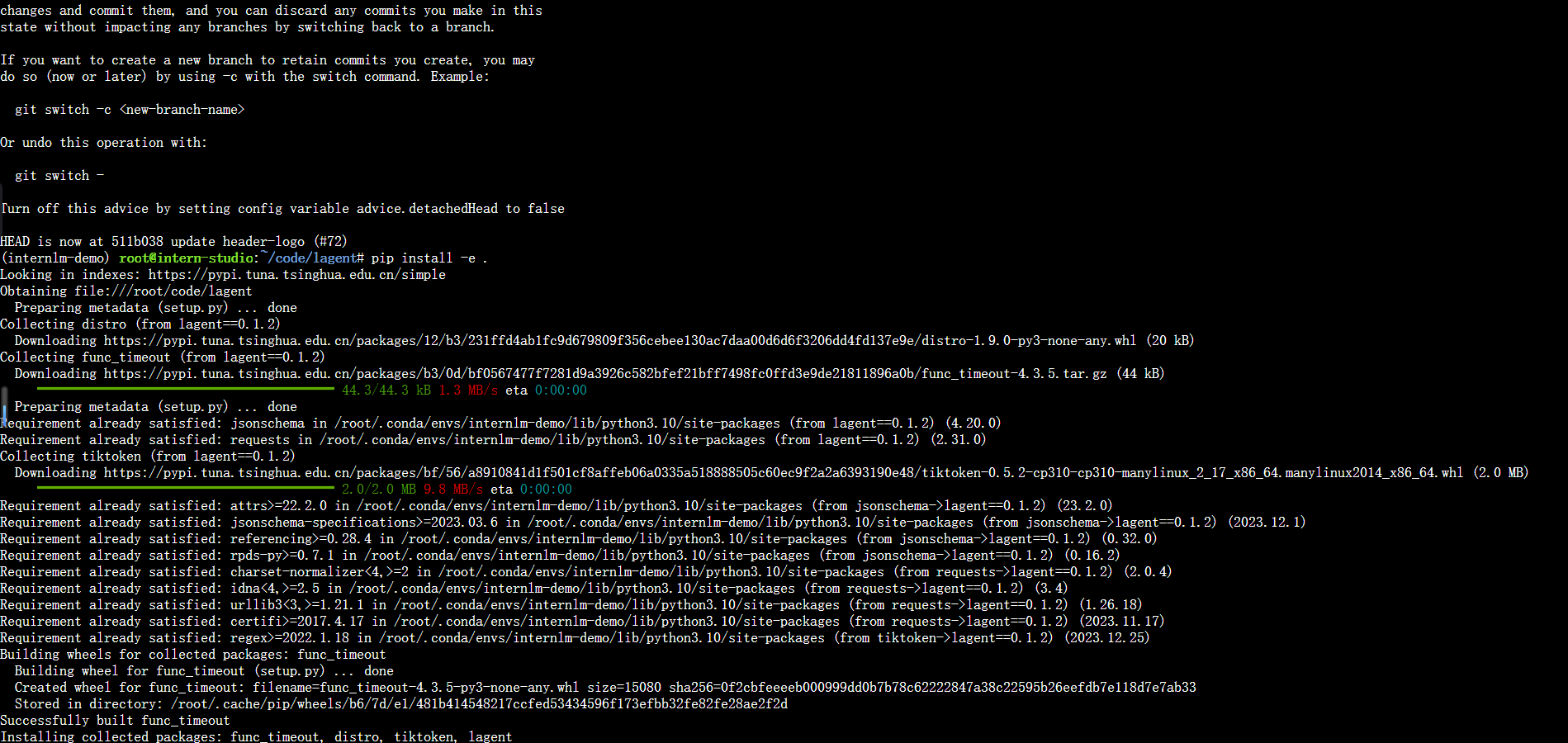

Lagent 安装

修改代码

Demo 运行

效果展示

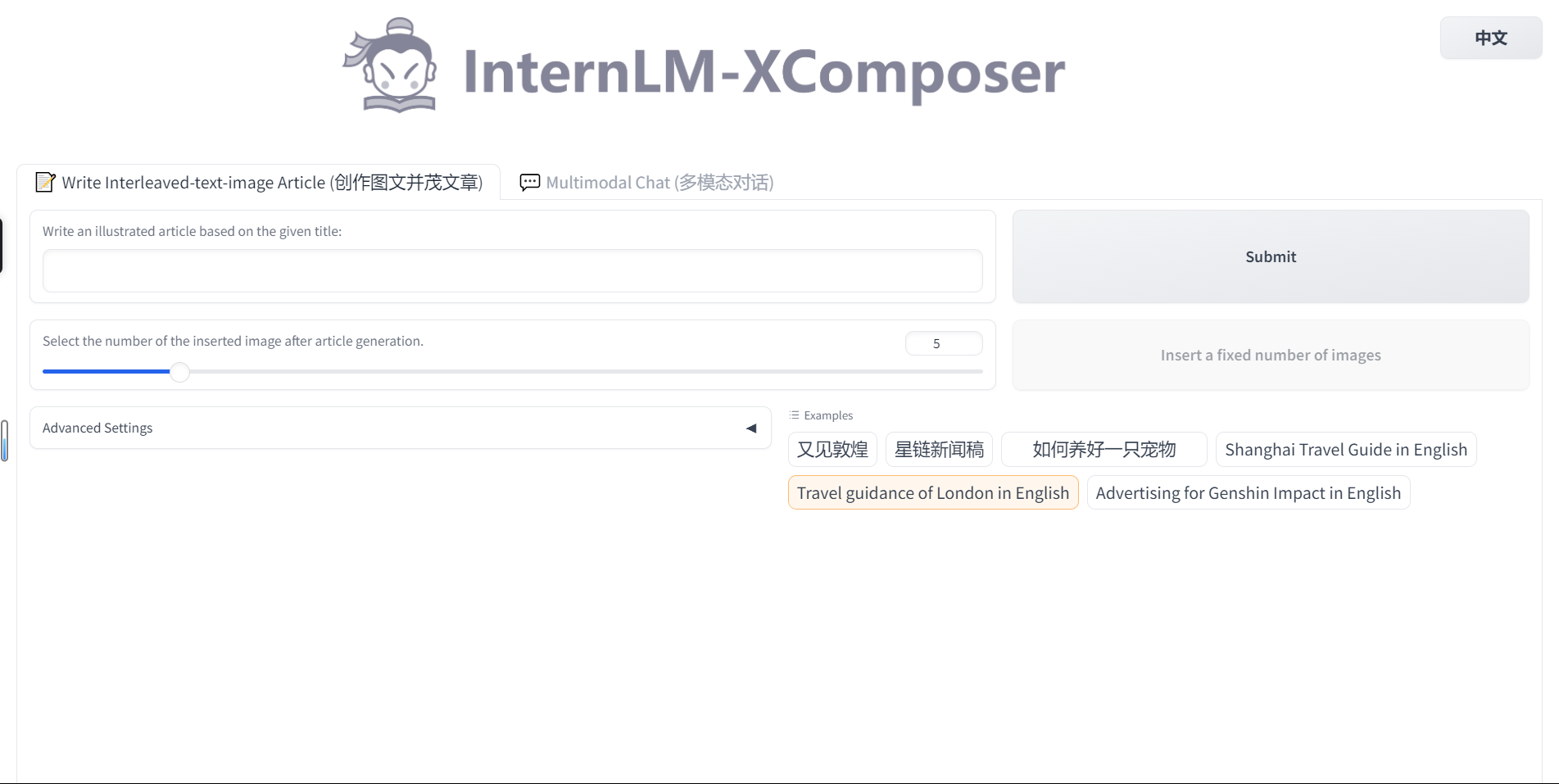

浦语·灵笔图文理解创作 Demo

环境准备,模型准备都和上边一样

代码准备

运行代码

我们来玩一玩吧!!

报错了!!为了赶作业,回头我再来完善

翻了翻源码我发现参数里面有个private,默认是False,就是说默认公开的,但是因为torch版本和gradio的版本匹配缘故,导致会出现错误。

我们直接解决出现问题的地方就好,使用下面的命令

cd /root/code/InternLM-XComposer

python examples/web_demo.py \

--folder /root/model/Shanghai_AI_Laboratory/internlm-xcomposer-7b \

--num_gpus 1 \

--port 6006 \

--private

而且我本来觉得只要把端口映射改成0.0.0.0:6006就可以跑了,然后我发现我失败了,还是不行,所以我采用了上边的方法

运行结果

创作图文并茂文章

输入标题,浪漫广西

给大家展示下成品

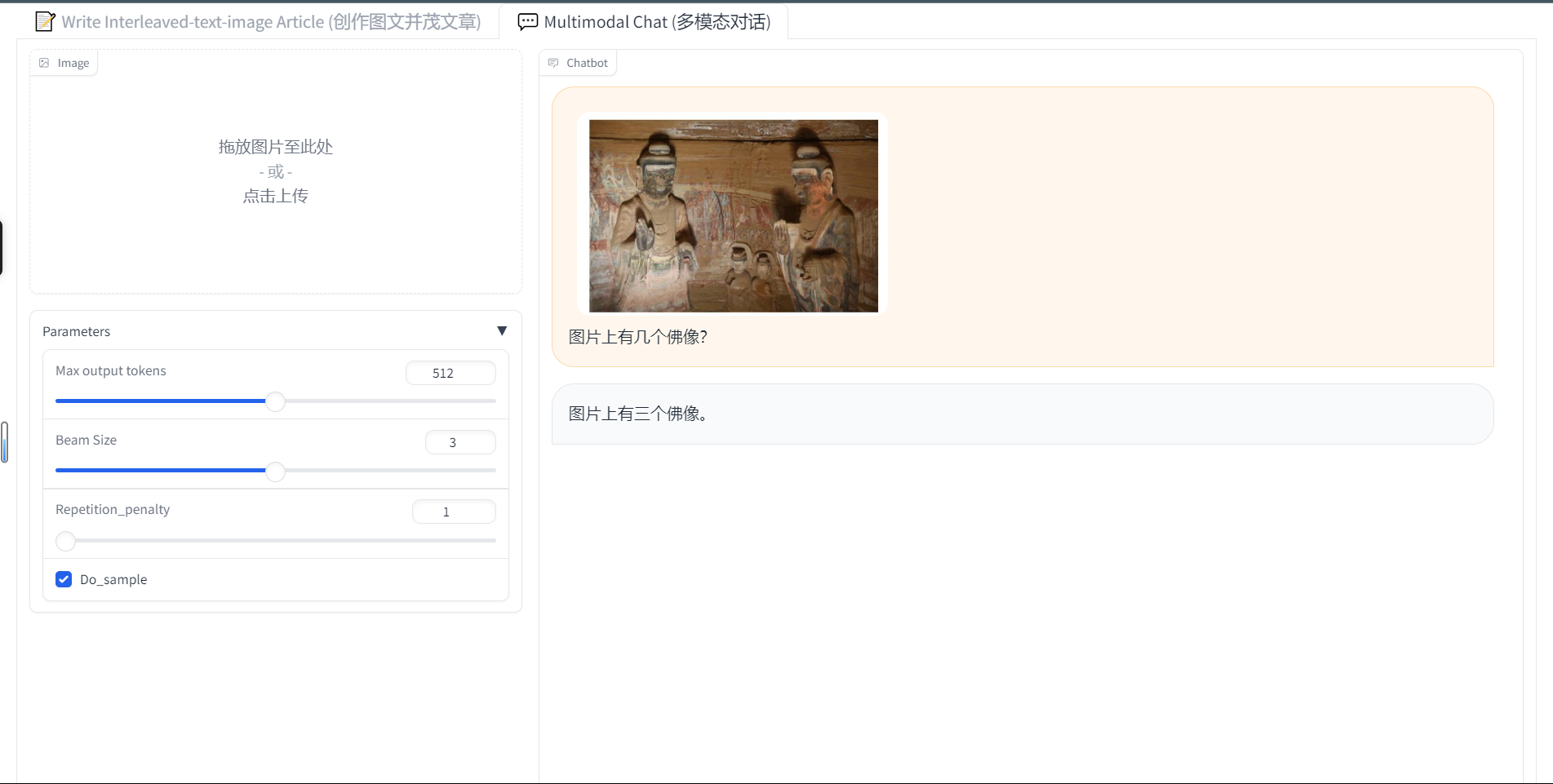

多模态对话

浙公网安备 33010602011771号

浙公网安备 33010602011771号