9070XT本地部署DeepSeek模型(非ollama)

官网

https://www.amd.com/zh-cn/resources/support-articles/release-notes/RN-RAD-WIN-25-1-1.html

安装最新版AMD Adrenalin驱动

AMD Radeon游戏卡本地部署DeepSeek,需打开AMD官网(中英文均可),输入显卡型号,下载AMD Adrenalin最新版驱动,安装并重启。

https://www.amd.com/en/support/download/drivers.html

安装LM Studio for Ryzen AI

LM Studio官网网站的锐龙专栏,并下载LM Studio for Ryzen AI安装包。

https://lmstudio.ai/ryzenai

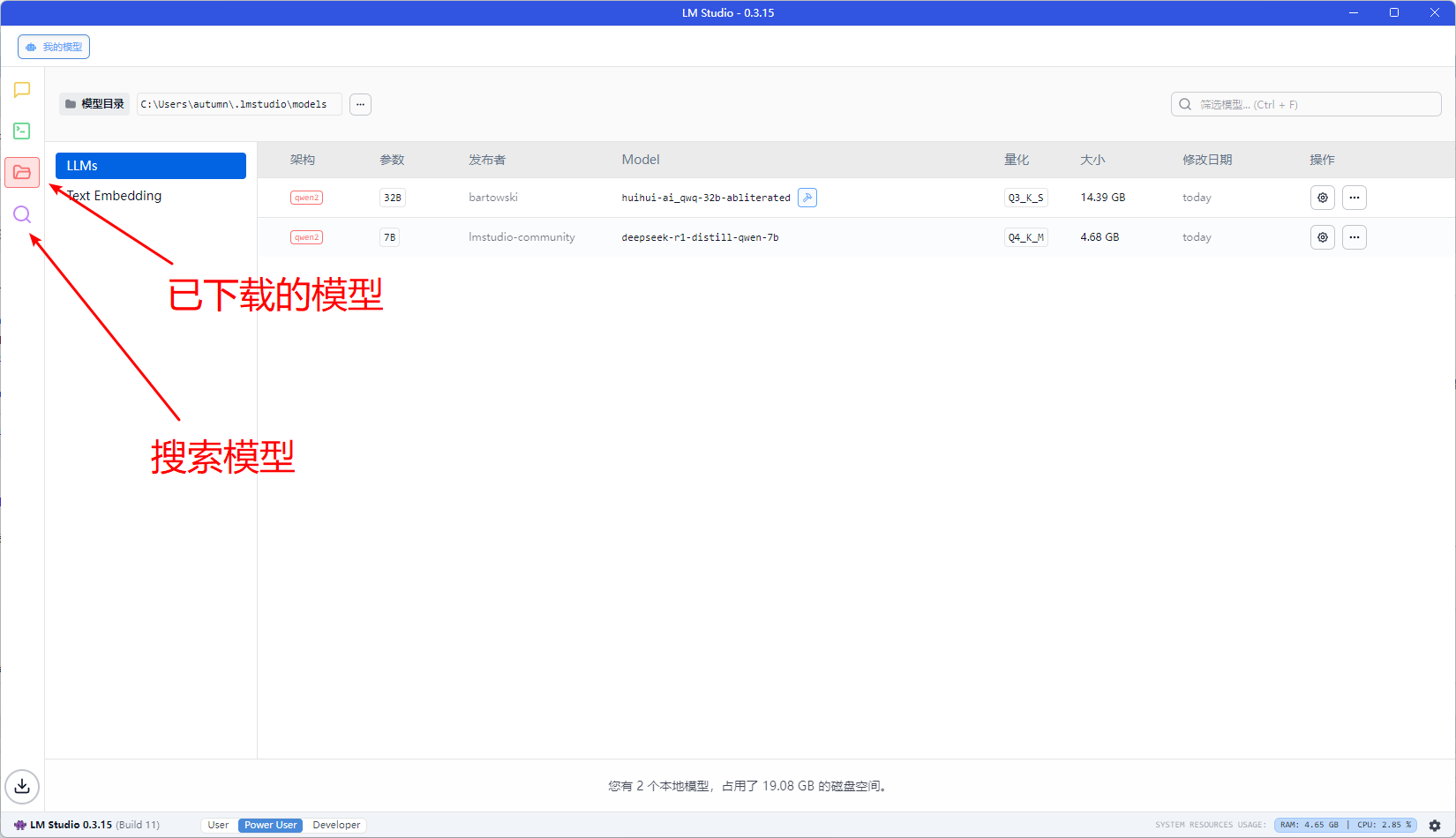

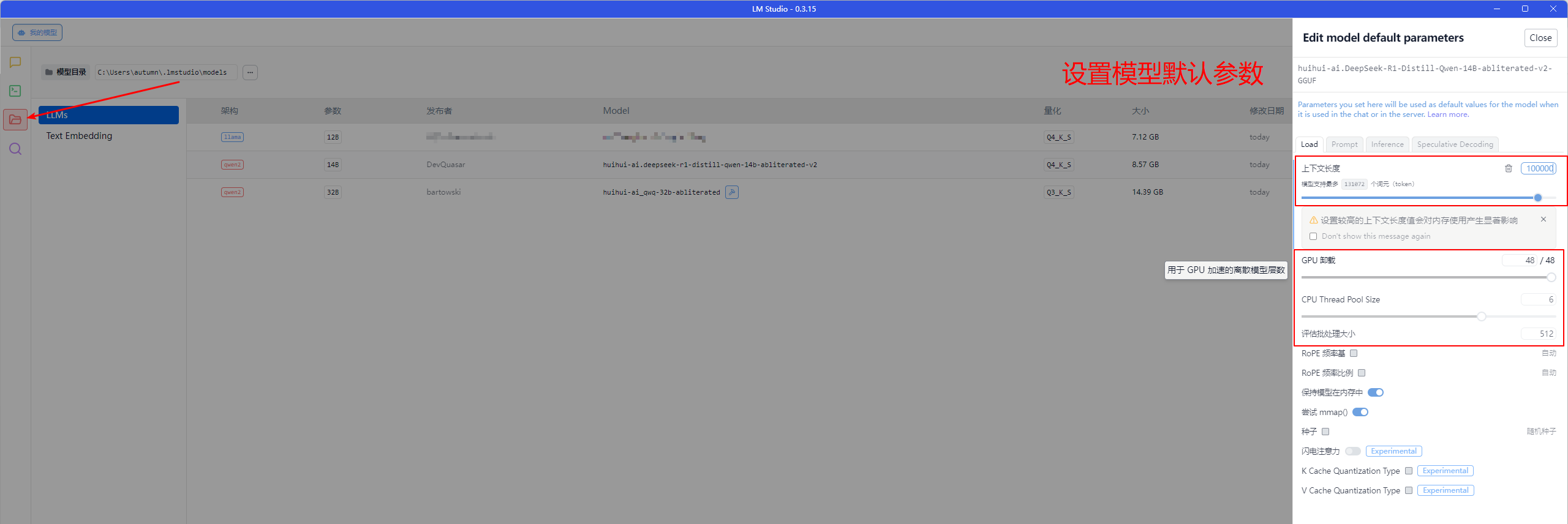

设置大模型参数【重要,涉及GPU的能力】

点击对话正上方的select a model to load ,选择该对象要使用的大模型

参数解释:

Context Length: 该模型一次最大可以加载多少个token

若是简单的问答,推荐4096

若是小红书文案,推荐10000以上

若是写作文,小说,推荐100000左右

GPU Offload: 运行时,所占用的GPU显存,建议先给一半

CPU Thread Pool Size: 拉满

Evaluation Batch Size: 512

后面不动,都以推荐为准

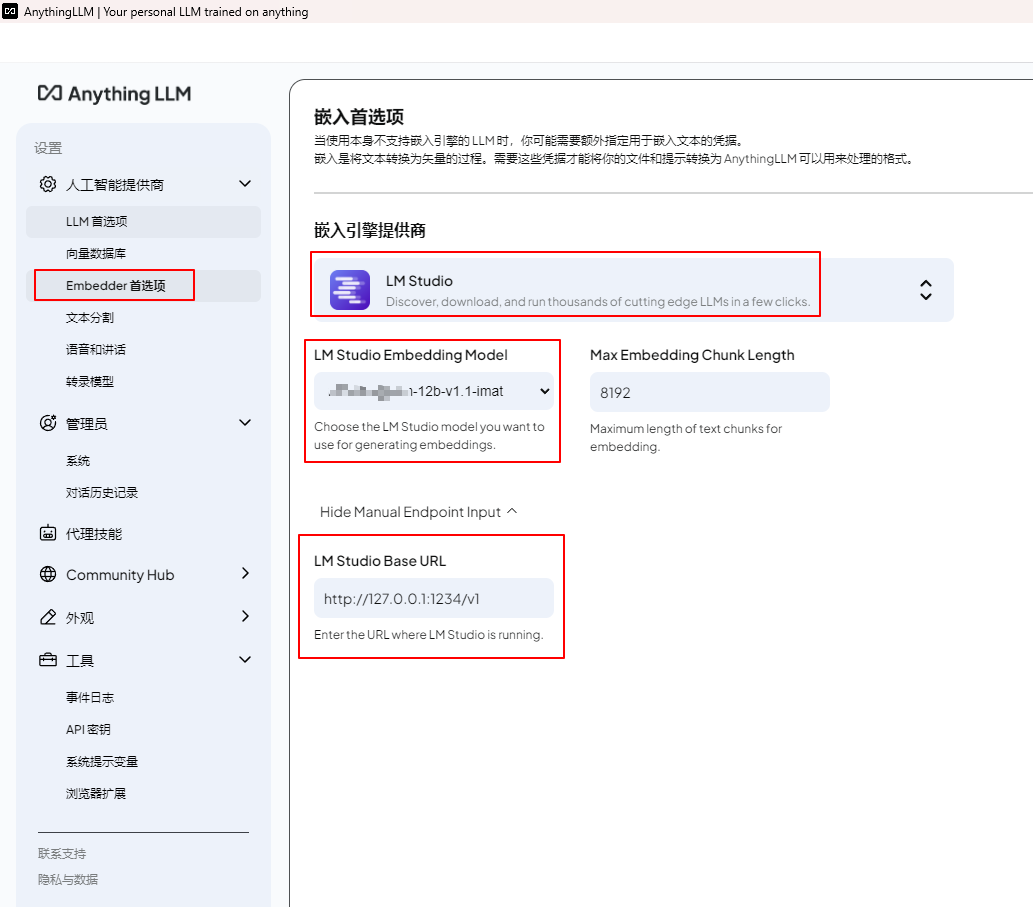

Anything LlM

官网:https://anythingllm.com/desktop

Anything LlM设置LM Studio

LM Studio vs Ollama:本地大语言模型运行平台全面对比

随着大语言模型(LLM)的快速发展,越来越多用户开始尝试在本地部署模型。两款热门工具 —— LM Studio 和 Ollama,分别代表了「可视化易用」与「开发者灵活性」的两种思路。

🎯 基本信息对比

| 特性 | LM Studio | Ollama |

|---|---|---|

| 开发团队 | LM Studio + AMD 合作 | 独立 Ollama 团队 |

| 定位方向 | 图形化 LLM 聊天助手 | 本地 LLM 服务运行平台 |

| 开源情况 | 部分闭源 | 部分开源(CLI、模型管理) |

🛠️ 技术能力对比

| 项目 | LM Studio | Ollama |

|---|---|---|

| 支持平台 | Windows、macOS(AMD 优化) Linux(实验) |

macOS(M 系列优化) Linux、Windows(较新) |

| 模型格式 | GGUF(基于 llama.cpp) | GGUF(同上) |

| 硬件加速 | AMD Ryzen AI NPU、iGPU、CPU 支持 Vulkan GPU 加速 |

Apple GPU(M 系列) NVIDIA CUDA 部分 AMD GPU |

| 多模型支持 | ✔️ 支持多个主流模型 | ✔️ 支持,且模型切换灵活 |

| 本地运行 | ✅ 支持全离线 | ✅ 支持全离线 |

| 推理性能 | 依赖 AMD 硬件优化 | 支持主流 GPU,性能优秀 |

🧑💻 使用体验对比

| 项目 | LM Studio | Ollama |

|---|---|---|

| 启动方式 | 图形化界面,一键启动 | 命令行 + Web UI |

| 交互方式 | 本地聊天框,支持多会话 | 本地聊天 + API 接入 |

| 模型下载 | 内置模型市场,选择即下 | ollama run model 下载或使用 Modelfile |

| 自定义开发 | ❌ 不支持嵌入项目 | ✅ 支持 API 与 CLI 嵌入 |

| 生态扩展性 | 封闭生态 | 开放,可接入 Notion、Obsidian 等 |

🧠 场景适配建议

| 你是谁? | 推荐使用 |

|---|---|

| 内容创作者、写作者、非程序员 | ✅ LM Studio |

| 开发者、AI 工程师 | ✅ Ollama |

| 使用 AMD Ryzen AI 笔记本 | ✅ LM Studio(硬件优化) |

| 使用 Apple Silicon 或 NVIDIA 显卡 | ✅ Ollama(性能更强) |

| 想嵌入 AI 到自己 App 或服务中 | ✅ Ollama |

| 只想轻松体验 AI 聊天 | ✅ LM Studio |

📌 总结

- LM Studio:适合想要简洁体验、本地运行、可视化界面的用户,尤其是使用 AMD Ryzen AI 设备的朋友。

- Ollama:更适合开发者和重度 AI 用户,支持灵活集成、多平台部署和自定义工作流。

两者都能本地运行 LLM,区别只在「体验导向 vs 开发导向」。

🔗 相关链接

写于 2025 年,工具能力和平台支持可能会持续演进需关注各自官方动态。

参考:

https://finance.sina.com.cn/tech/roll/2025-02-09/doc-ineiwvfy5130986.shtml

浙公网安备 33010602011771号

浙公网安备 33010602011771号