DeepSeek本地化部署(Windows)

DeepSeek本地化部署(Windows)

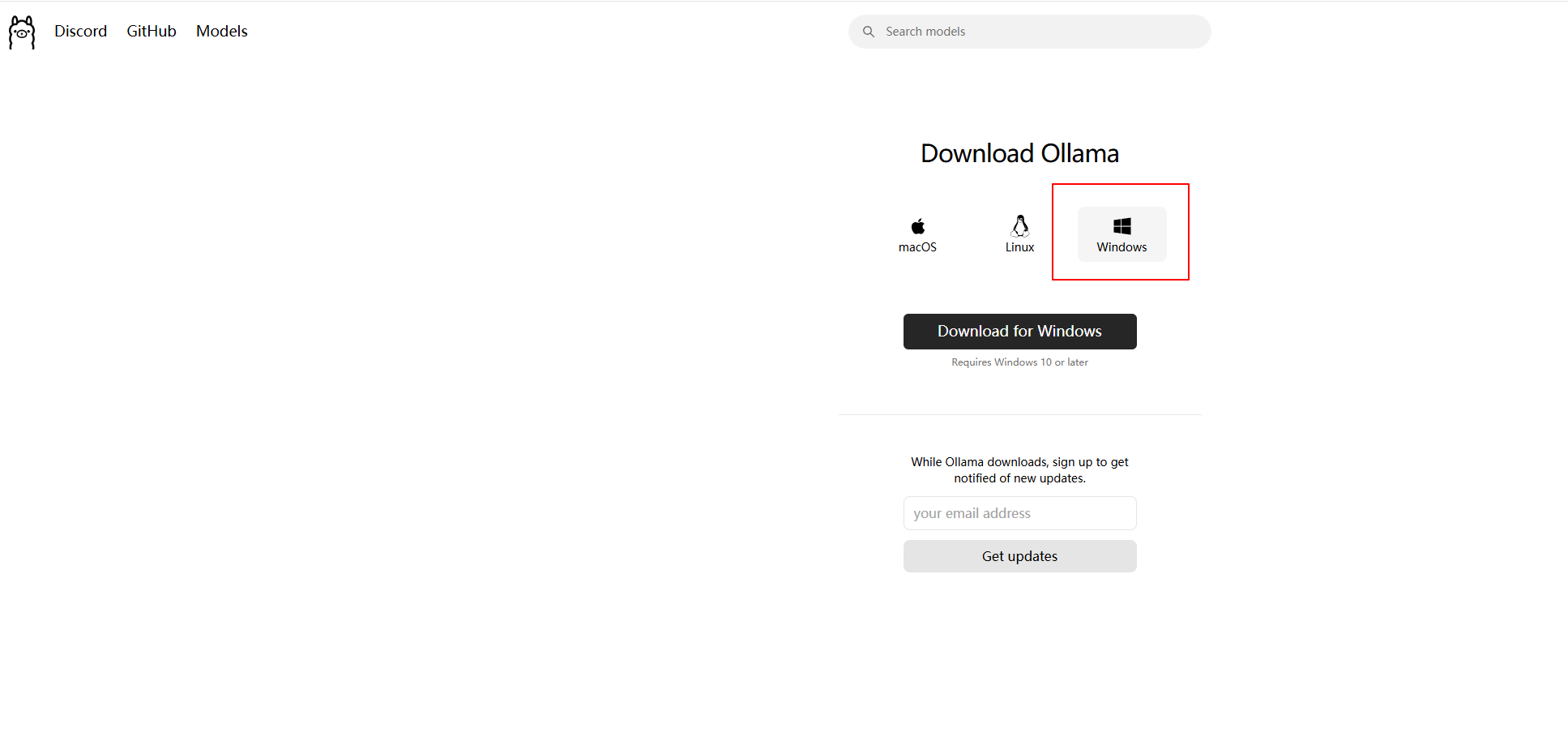

安装 Ollama

https://ollama.com/download/windows

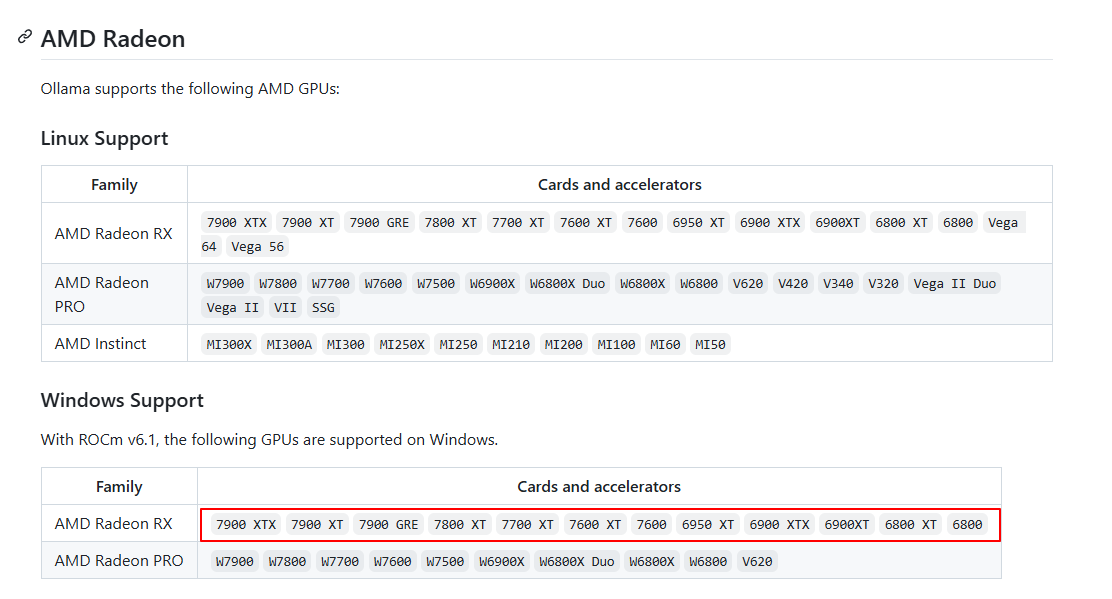

查看Ollama支持的显卡,可以看到官方不支持9070XT。

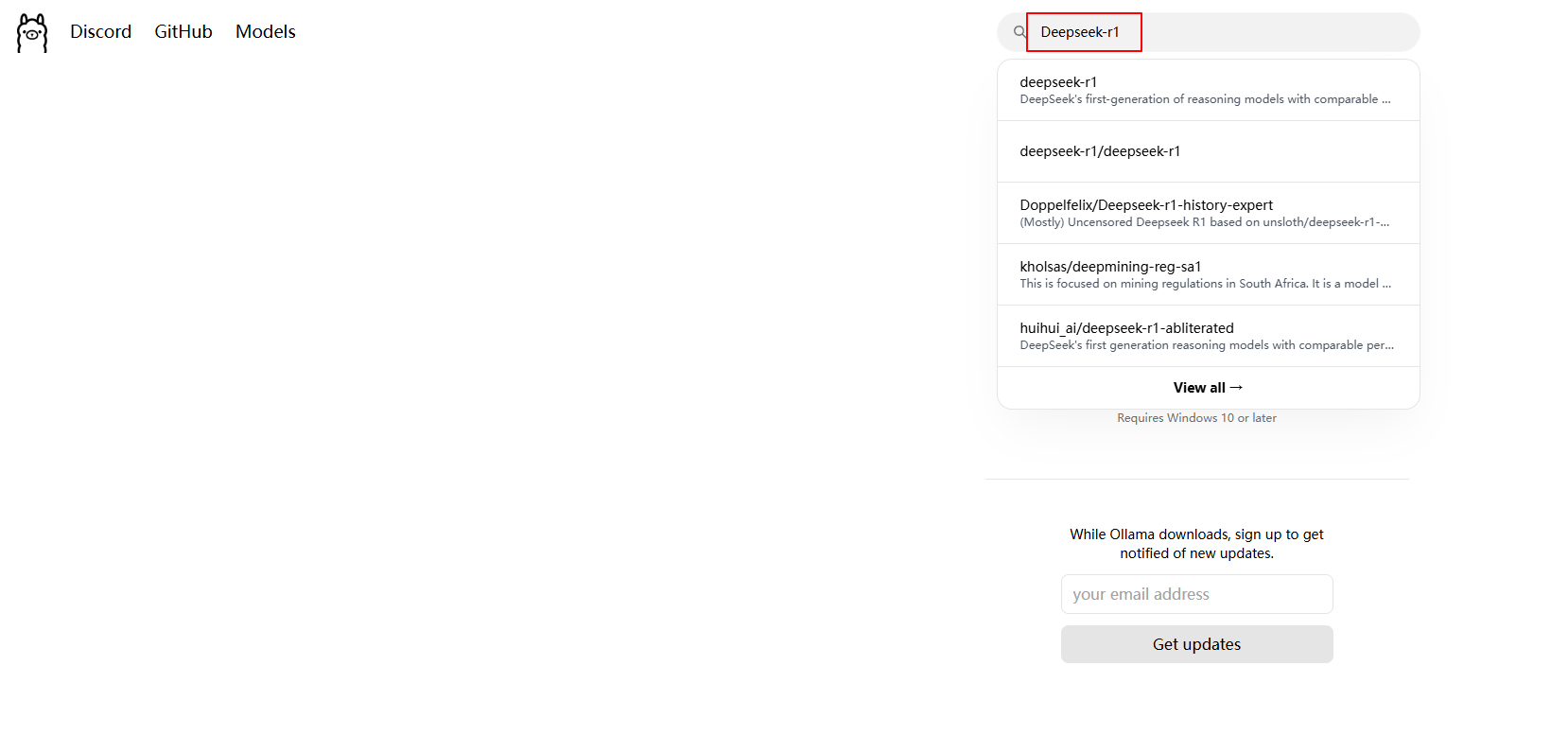

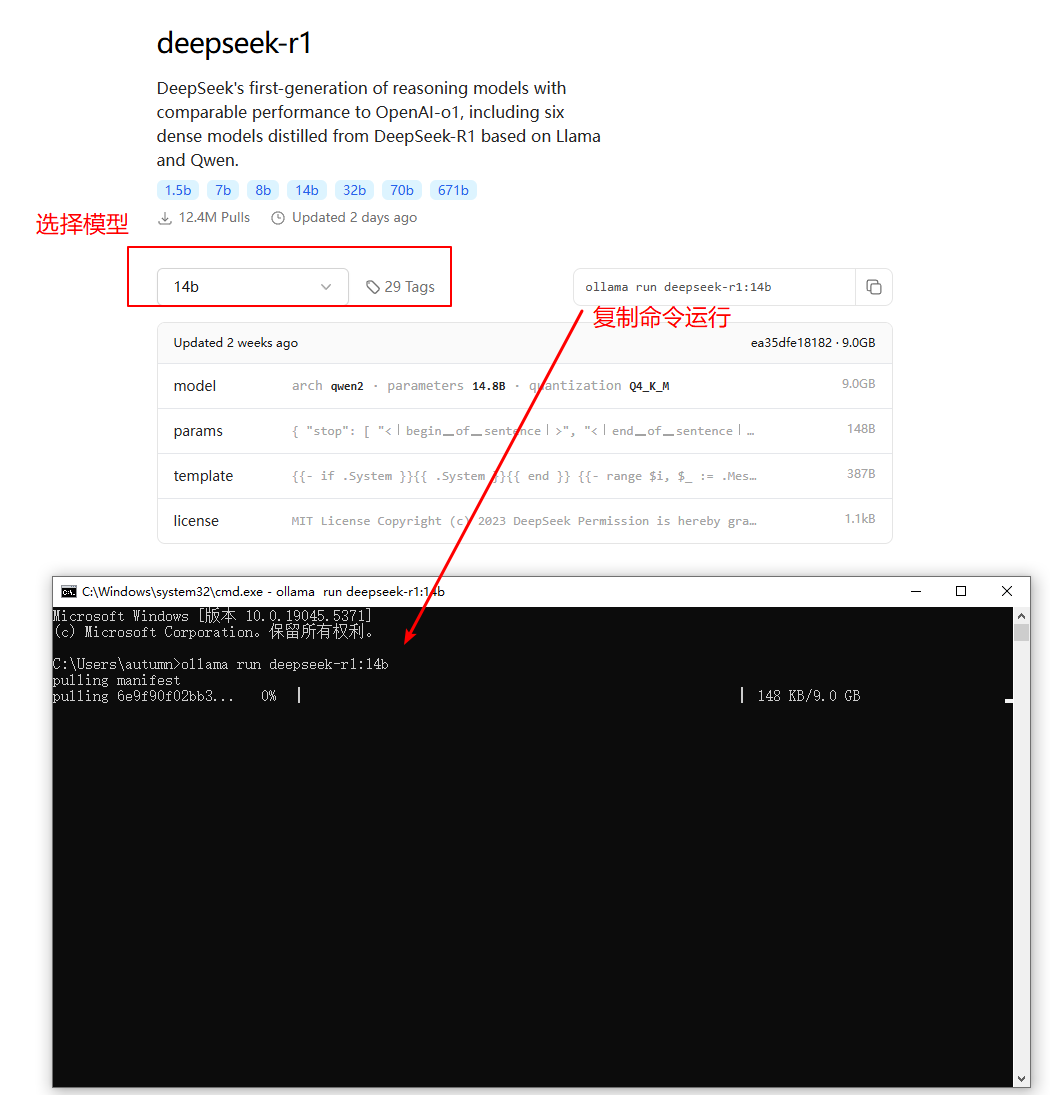

CMD部署deepseek模型

https://ollama.com/ 网址中,在网页上方搜索框中输入 Deepseek-r1

1.5b: 需要1.1GB显存

7b: 需要4.7GB显存

8b: 需要4.9GB显存

14b: 需要9.0GB显存

32b: 需要20GB显存

70b: 需要43GB显存

671b: 需要404GB显存

#下载并运行deepseek模型,如果下载慢可以挂代理或者启动多个cmd窗口多线程下载

ollama run deepseek-r1:7b

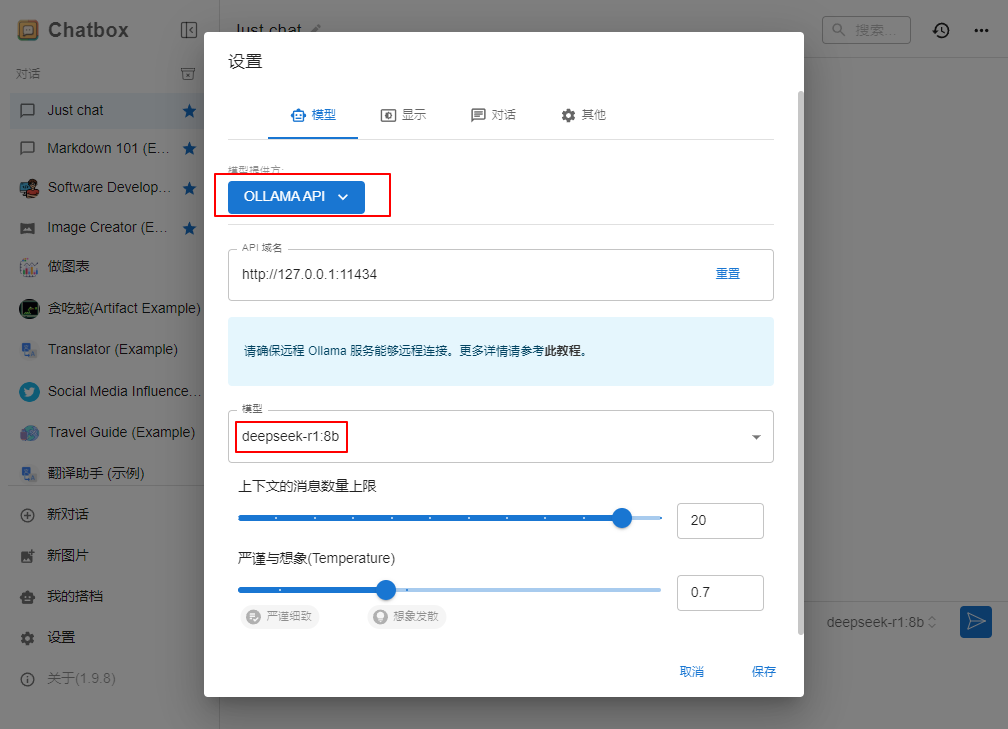

可视化图文交互界面 Chatbox(可选)

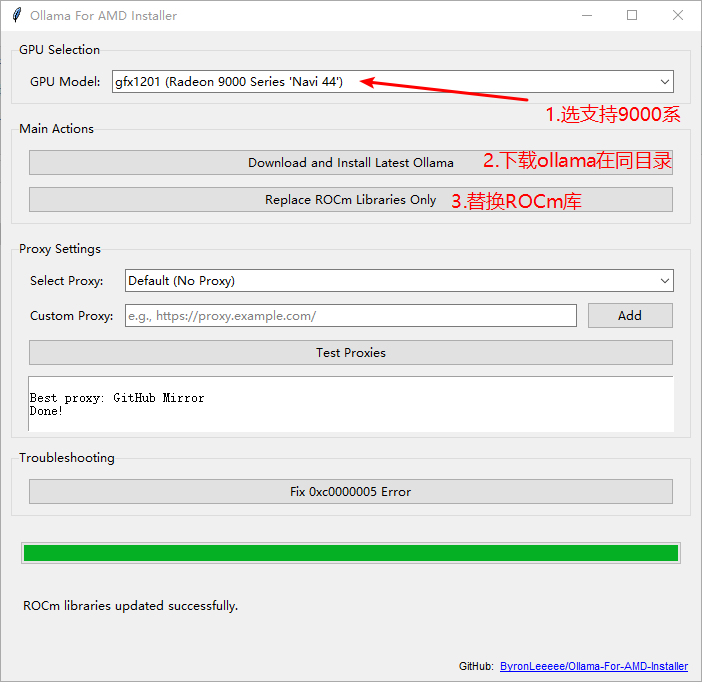

9070XT使用Ollama部署Deepseek

第三方安装方式

https://github.com/ByronLeeeee/Ollama-For-AMD-Installer

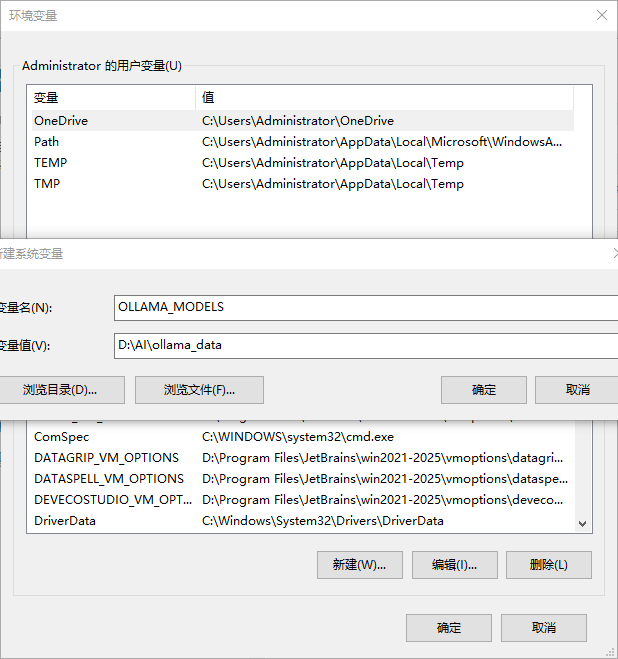

设置模型环境变量

如果有之前下载好的ollama模型,可以直接设置环境变量OLLAMA_MODELS。还可以设置OLLAMA_HOST和OLLAMA_PORT(默认11434)

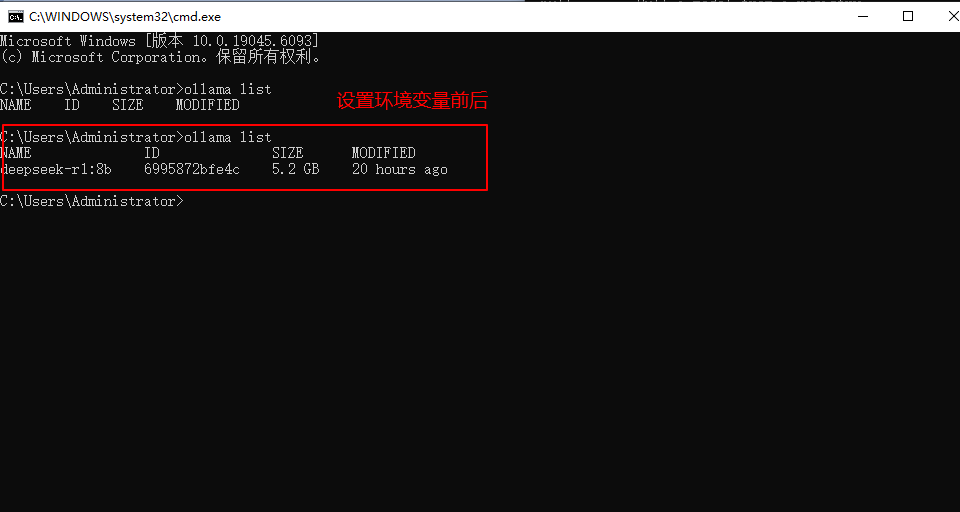

#查看模型

ollama list

界面工具

Anything LLM设置工作区LLM

Hugging Face下载gguf文件导入Ollama

Modelfile

创建Ollama模型Modelfile文件如Qwen2.5Modelfile文件,放在gguf相同文件夹下

FROM ./Qwen2.5-Q2_K.gguf

Ollama导入模型并运行

#qwen2.5为模型名称,Modelfile为文件名称

ollama create qwen2.5 -f Modelfile

#运行模型

ollama run qwen2.5

如果这篇文章对你有用,可以关注本人微信公众号获取更多ヽ(^ω^)ノ ~

浙公网安备 33010602011771号

浙公网安备 33010602011771号