第七周作业

1、破坏mbr表并修复

首先破坏MBR表文件

[root@ys ~]# dd if=/dev/zero of=/dev/sda count=1 bs=446 记录了1+0 的读入 记录了1+0 的写出 446字节(446 B)已复制,0.0105188 秒,42.4 kB/秒 [root@ys ~]# hexdump -C /dev/sda -n 446 -v 00000000 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 |................| 00000010 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 |................| 00000020 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 |................| 00000030 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 |................| 00000040 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 |................| 00000050 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 |................| 00000060 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 00 |................|

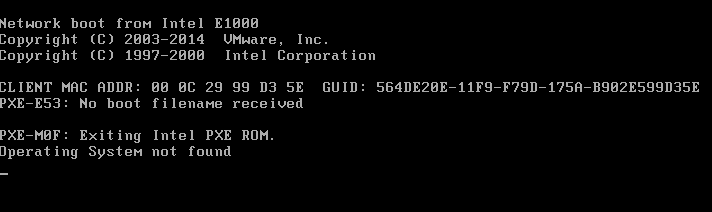

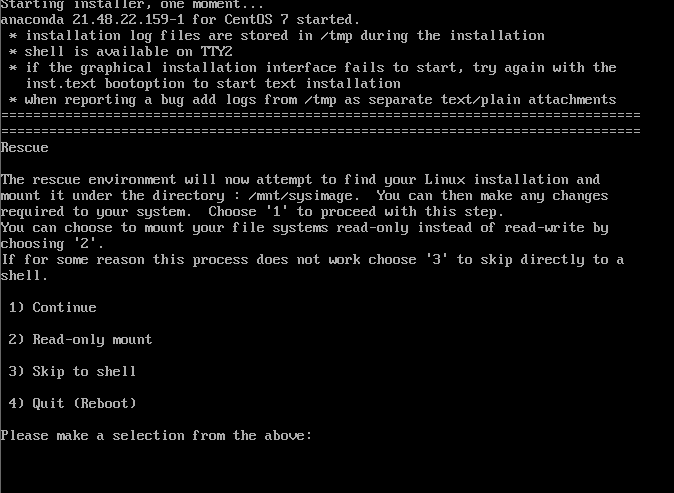

重启后已无法正常启动了,现在虚拟机挂载系统光盘重启进入救援模式

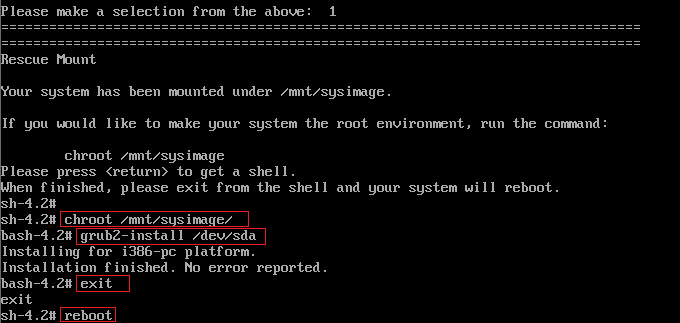

选择第一项进入命令行模式,挂载根目录后,使用grub命令重新安装引导文件后,重启系统

至此,系统修复完成

2、总结RAID的各个级别及其组合方式和性能的不同。

RAID-0:

读、写性能提升

可用空间:N*min(S1,S2,...)

无容错能力

最少磁盘数:2, 2+

特点:

优点:读、写性能提升,不存在校验,不会占太多CPU资源,设计、使用和配置比较简单;

缺点:无冗错能力,不能用于对数据安全性要求高的环境;

可用空间:N (硬盘个数) *min (s1,s2...取决于最小的硬盘空间)

适用领域:视频生成和编辑、图形编辑,其它需要大的传输宽带的操作

RAID-1:

读性能提升、写性能略有下降

可用空间:1*min(S1,S2,...)

有冗余能力

最少磁盘数:2, 2N

特点:

磁盘数:最低2个,2n个,n大于等于1

优点:

读性能提升、写性能略有下降,具有100%数据冗余,提供最高的数据安全保障,理论上可实现2倍的读取效率设计和使用较简单;

缺点:

开销大,空间利用率只有50%,在写性能方面提升不大;

有冗余能力

可用空间:1*min (s1,s2...由最小硬盘的空间决定)

适用领域:财务、金融等高可用、高安全的数据存储环境

RAID-2:

采用校验冗余

把数据分散为位或块,加入汉明码,间隔写入到磁盘阵列的每个磁盘中在成员磁盘上的地址都一样

采用并行存取的方式

花费大、成本昂贵

RAID-3:

数据块被分成更小的块,并行传输到各个成员磁盘上,同时计算xor校验数据存放到专用的校验磁盘上;

xor算法:(异或)

相同为假、不同为真

特点:

磁盘数:最低3个

优点:

读写性能都较好,当磁盘损坏时,对整体吞吐量影响较小,减少了开销;

缺点:

控制器设计复杂,采用并行的存取方式,主轴同步时吞吐量没有提高,校验磁盘的写性能有瓶颈;

适用领域:

视频生成和图形、视频编辑等;需要高吞吐量的应用环境;

RAID-4:

多块数据盘异或运算值存于专用校验盘

校验存储在固定磁盘

最少需要3块硬盘;

数据交叉存储在2块硬盘中,再由第3块硬盘存储数据的校验码;

校验码是由2块硬盘中的chunk块按位进行异或运算后而得的值;

其中1块硬盘坏了不影响文件数据读写操作,数据还可以恢复,但就是有些慢;即使坏了1块硬盘仍然继续在线工作时,称为降级模式,此时数据没有保障,风险较大;所以要马上用新硬盘替换坏硬盘,暂定业务,用2块可用盘进行计算,按位校验恢复数据到新硬盘即可,当所有数据都恢复到新硬盘后,就能继续正常工作了;但是万一在恢复过程中也是有风险的;

RAID4还有一个固有缺点:用单块盘作为存放校验码,无论前面哪块盘访问数据,校验盘都得被访问;即集中存放校验码的校验盘访问压力过大,很容易造成性能瓶颈;所以,尽早发现坏盘损坏,就能尽早更换;可以在接1块新硬盘当做空闲备用盘。

异或运算,存储校验码:

例如:1101,0110按位校验,校验码为:1011

RAID-5:

读、写性能提升

可用空间:(N-1)*min(S1,S2,...)

有容错能力:允许最多1块磁盘损坏

最少磁盘数:3, 3+

校验有序的存储在不同磁盘

采用独立存取的阵列方式,校验信息被均匀的分散到阵列的各个磁盘上;

相对于RAID-4把校验码存放在一块硬盘上,而RAID-5是将3块盘循环轮流作存放校验码。左对称即校验码存放各盘的顺序是先在前2块盘存数据,第3块盘存校验码,依次类推,右对称相反。

特点:

磁盘数:最低3个

优点:

读性能较高,中等的写特性,校验信息的分布方式存取,避免出现写操作的瓶颈;

缺点:

控制器设计复杂,磁盘重建的过程比较复杂;

可用空间:(N-1)*min(S1,S2,...其中的最小空间)

有容错能力:1块磁盘

适用领域:文件服务器、email服务器、web服务器等环境,数据库应用;

RAID-6:

读、写性能提升

可用空间:(N-2)*min(S1,S2,...)

有容错能力:允许最多2块磁盘损坏

最少磁盘数:4, 4+

有两个校验

组合不同级别的RAID

组合不同级别的RAID的目的

从RAID0到RAID6,不同级别的RAID在性能、冗余、价格等方面做了不同程度的折中;

重点介绍:

RAID-10、RAID-01、RAID-50

RAID-10:

读、写性能提升

可用空间:N*min(S1,S2,...)/2

有容错能力:每组镜像最多只能坏一块

最少磁盘数:4, 4+

先使用RAID 1连接两块磁盘,在使用RAID 0连接4块磁盘

特点:

磁盘数:最低4个,2n个,n大于等于2;

优点:

读性能很高,写性能比较好,数据安全性好,允许同时有N个磁盘失效;

缺点:

利用率只有50%,开销大;

可用空间:N*min(S1,S2,...其中最小空间)/2;

有容错能力:每组镜像最多只能坏一块;

适用领域:多用于要求高可用性和高安全性的数据库应用;

RAID-01:

多块磁盘先实现RAID0,再组合成RAID1

同RAID 10 ,只不过是先采用RAID 0

先分成两组做成RAID-0,再把组成的RAID-0做成RAID-1;不符合常用方法,每一组有一块坏的硬盘可能性大;

RAID-50:

多块磁盘先实现RAID5,再组合成RAID0

是RAID5和RAID0的结合,先实现RAID5,再条带化;(先做RAID-5在做RAID-0,最少6块盘,每组允许坏1块盘,空间利用率灵活)、RAID7(某家公司的私有技术,实际是文件服务器)

特点:

磁盘数:最低6个;

优点:

比RAID5有更好的读性能,比相同容量的RAID5重建时间更短,可以容许N个磁盘同时失效;

缺点:

设计复杂,比较难实现;同一个RAID5组内的两个磁盘失效会导致整个阵列失效;

适用领域:大型数据库服务器、应用服务器、文件服务器等应用;

3、创建一个2G的文件系统,块大小为2048byte,预留1%可用空间,文件系统 ext4,卷标为TEST,要求此分区开机后自动挂载至/test目录,且默认有acl挂载选项

1.查看块设备信息

[root@localhost ~]# lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT sda 8:0 0 20G 0 disk ├─sda1 8:1 0 1G 0 part /boot └─sda2 8:2 0 19G 0 part ├─centos-root 253:0 0 17G 0 lvm / └─centos-swap 253:1 0 2G 0 lvm [SWAP] sdb 8:16 0 5G 0 disk sr0 11:0 1 4.4G 0 rom

2.在sdb磁盘上创建大小为2G的分区

[root@localhost ~]# fdisk /dev/sdb 欢迎使用 fdisk (util-linux 2.23.2)。 命令(输入 m 获取帮助):n Partition type: p primary (0 primary, 0 extended, 4 free) e extended Select (default p): p 分区号 (1-4,默认 1): 起始 扇区 (2048-10485759,默认为 2048): 将使用默认值 2048 Last 扇区, +扇区 or +size{K,M,G} (2048-10485759,默认为 10485759):+2G 分区 1 已设置为 Linux 类型,大小设为 2 GiB 令(输入 m 获取帮助):w ▽he partition table has been altered! Calling ioctl() to re-read partition table. 正在同步磁盘。

3.在sdd2分区上创建文件系统

[root@localhost ~]# mkfs.ext4 -b 2048 -m 1 -L TEST /dev/sdb1 mke2fs 1.42.9 (28-Dec-2013) 文件系统标签=TEST OS type: Linux 块大小=2048 (log=1) 分块大小=2048 (log=1) Stride=0 blocks, Stripe width=0 blocks 131072 inodes, 1048576 blocks 10485 blocks (1.00%) reserved for the super user 第一个数据块=0 Maximum filesystem blocks=269484032 64 block groups 16384 blocks per group, 16384 fragments per group 2048 inodes per group Superblock backups stored on blocks: 16384, 49152, 81920, 114688, 147456, 409600, 442368, 802816 Allocating group tables: 完成 正在写入inode表: 完成 Creating journal (32768 blocks): 完成 Writing superblocks and filesystem accounting information: 完成

4.查看结果如下:

[root@localhost ~]# blkid /dev/sr0: UUID="2020-11-04-11-36-43-00" LABEL="CentOS 7 x86_64" TYPE="iso9660" PTTYPE="dos" /dev/sda1: UUID="a88ee30d-183e-43a7-9304-4edde84ddabb" TYPE="xfs" /dev/sda2: UUID="tVurm7-NSyR-DxiS-HpCp-6oUj-NGYN-fcpcrJ" TYPE="LVM2_member" /dev/sdb1: LABEL="TEST" UUID="ebbb4b7f-6579-4641-ae10-072d60f8eddf" TYPE="ext4" /dev/mapper/centos-root: UUID="a49484d9-8a1e-421c-a3b3-e038fff43e72" TYPE="xfs" /dev/mapper/centos-swap: UUID="b1d4b18a-dab9-4c3a-91c1-c2677f526076" TYPE="swap"

5.将分区挂载到指定文件夹

在/etc/fstab文件中添加以下内容

UUID="ebbb4b7f-6579-4641-ae10-072d60f8eddf" TYPE="ext4" /test ext4 acl 0 0

6.创建目标文件夹,使配置文件生效并再次查看分区信息确认

[root@localhost ~]# mkdir /testdisk [root@localhost ~]# mount -a [root@localhost ~]# lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT sda 8:0 0 20G 0 disk ├─sda1 8:1 0 1G 0 part /boot └─sda2 8:2 0 19G 0 part ├─centos-root 253:0 0 17G 0 lvm / └─centos-swap 253:1 0 2G 0 lvm [SWAP] sdb 8:16 0 5G 0 disk └─sdb1 8:17 0 2G 0 part /test sr0 11:0 1 4.4G 0 rom

4、创建一个至少有两个PV组成的大小为20G的名为testvg的VG;要求PE大小 为16MB, 而后在卷组中创建大小为5G的逻辑卷testlv;挂载至/users目录

使用整块sdd一个盘和sdc硬盘中的10G空间共同创建物理卷组

[root@centos7 ~]#lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT sda 8:0 0 200G 0 disk ├─sda1 8:1 0 1G 0 part /boot ├─sda2 8:2 0 100G 0 part / ├─sda3 8:3 0 50G 0 part /data sdb 8:16 0 200G 0 disk sdc 8:32 0 20G 0 disk sdd 8:48 0 10G 0 disk sr0 11:0 1 3.7G 0 rom

2在sdc硬盘上创建10G的分区

Device Boot Start End Blocks Id System

/dev/sdc1 2048 20973567 10485760 8e Linux LVM

- 在sdc1分区和sdd上分别创建物理卷(pv)

[root@centos7 ~]#pvcreate /dev/sdd Physical volume "/dev/sdd" successfully created. [root@centos7 ~]#pvcreate /dev/sdc1 Physical volume "/dev/sdc1" successfully created. [root@centos7 ~]#pvs PV VG Fmt Attr PSize PFree /dev/sdc1 lvm2 --- 10.00g 10.00g /dev/sdd lvm2 --- 10.00g 10.00g

4创建物理卷组(vg),并将以上的pv加入其中

[root@centos7 ~]#vgcreate -s 16M testvg /dev/sdd /dev/sdc1 Volume group "testvg" successfully created [root@centos7 ~]#vgs VG #PV #LV #SN Attr VSize VFree testvg 2 0 0 wz--n- <19.97g <19.97g

- 在testvgz中创建大小为5G的逻辑卷(lv)

[root@centos7 ~]#lvcreate -n testlv -L 5G testvg Logical volume "testlv" created. [root@centos7 ~]#lvs LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert testlv testvg -wi-a----- 5.00g

- 创建文件系统

[root@centos7 ~]#mkfs.ext4 /dev/testvg/testlv mke2fs 1.42.9 (28-Dec-2013) Filesystem label= OS type: Linux Block size=4096 (log=2) Fragment size=4096 (log=2) Stride=0 blocks, Stripe width=0 blocks 327680 inodes, 1310720 blocks 65536 blocks (5.00%) reserved for the super user First data block=0 Maximum filesystem blocks=1342177280 40 block groups 32768 blocks per group, 32768 fragments per group 8192 inodes per group Superblock backups stored on blocks: 32768, 98304, 163840, 229376, 294912, 819200, 884736 Allocating group tables: done Writing inode tables: done Creating journal (32768 blocks): done Writing superblocks and filesystem accounting information: done [root@centos7 ~]#blkid /dev/sda1: UUID="793af41e-2bb7-4c31-9f0f-571251920f22" TYPE="xfs" /dev/sda2: UUID="5e9ce9bf-255f-4fc9-8ec1-2ca462b11486" TYPE="xfs" /dev/sda3: UUID="4366d641-77fb-4f52-8115-250792bbdf64" TYPE="xfs" /dev/sdc1: UUID="BVowtB-XbIj-kzzL-Qd0J-AXD6-xsMz-LYogzM" TYPE="LVM2_member" /dev/mapper/testvg-testlv: UUID="1b99642e-c5ab-432d-9ce6-5624a8a016a2" TYPE="ext4" /dev/sdd: UUID="adCzZS-JTc3-gTpl-e5eE-lkgA-zs0p-A4jea1" TYPE="LVM2_member"

- .在/etc/fstab配置文件中添加以下内容:

UUID=1b99642e-c5ab-432d-9ce6-5624a8a016a2 /users ext4 defaults 0 0

- .创建目标文件夹,并手动使配置文件生效

[root@centos7 ~]#mkdir /users

[root@centos7 ~]#mount -a

- .查看结果

[root@centos7 ~]#lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT sda 8:0 0 200G 0 disk ├─sda1 8:1 0 1G 0 part /boot ├─sda2 8:2 0 100G 0 part / ├─sda3 8:3 0 50G 0 part /data sdb 8:16 0 200G 0 disk sdc 8:32 0 20G 0 disk └─sdc1 8:33 0 10G 0 part sdd 8:48 0 10G 0 disk └─testvg-testlv 253:0 0 5G 0 lvm /users sr0 11:0 1 1024M 0 rom sr1 11:1 1 1024M 0 rom

浙公网安备 33010602011771号

浙公网安备 33010602011771号