论文阅读:NetVLAD: CNN architecture for weakly supervised place recognition

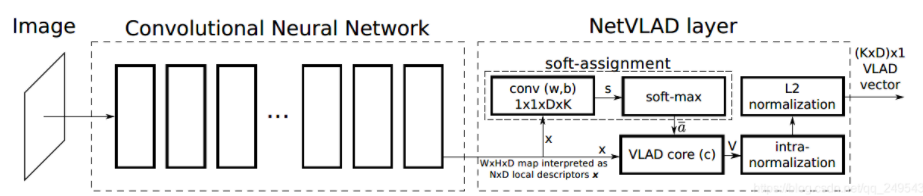

论文核心:文中提出一种卷积神经网络结构,可以实现端到端的识别。主要创新点是将传统的VLAD结构嵌入到CNN网络结构中去,得到一个新的VLAD层。NetVLAD可以很容易的运用到任何的CNN结构中,并且可以使用反向传播进行优化。

简介

这篇文章主要针对地点识别问题来进行的研究。地点识别存在着一个很大的挑战是,在光照等其它因素影响下,即便是同一个地点图像之间的差异也是非常大。关键问题是如何找到这样一个具有代表性且具有区分性特征的表达。

传统做法是将地点识别问题看作实例检索任务,使用具有不变性特征(SIFT)来表示每一个图像,然后将特征聚合成一个向量表示,这些向量通常对图像具有一定的代表和区分性,方法有BOW,VLAD,FV等。随着近些年卷积网络的不断发展,CNN对图像的表达能力已经非常可观并且有效。虽然CNN能够用在较大的数据集上,但是如果直接迁移使用CNN,那么它作为一个黑盒来提取图像特征,但很大程度上会限制示例级别(instance-level)上的识别任务。所以这篇文章主要抓的问题是:

- 如何定义一个好的网络结构

- 怎样获取足够多的标注数据

- 怎么训练能提高结构性能

第一,基于现有的神经网络架构,文章提出一个带有VLAD层的卷积神经网络模型 NetVLAD,它可以被加到任何的CNN结构中,并且可以使用BP算法优化。

第二,为了训练网络,收集了大量不同时间不同角度相同地点的全景图。通过这些数据进行训练是若监督学习,因为我们知道这些地点很接近,但是并不知道图像中的哪个部分决定了这两幅全景图是同一个地方。

第三,使用端到端的方式来学习模型参数,得到的描述特征对于视角和光照情况具有非常高的鲁棒性。

方法:

局部聚合向量(VLAD)是广泛应用在示例检索与图像分类中的一种描述池化方法,它能够抓取图像中局部特征在图像中聚合的统计信息。视觉词袋聚合是记录每个词的数目,而VLAD是记录每个词的残差和。

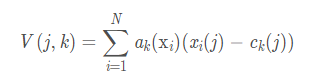

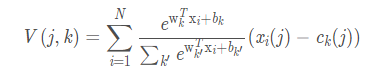

给定N个D维局部图像描述算子xi作为输入,K个聚类中心记为ck,作为VLAD的参数。VLAD的输出是一个K x D维的图像描述向量,为了方便记作V是一个K x D 的矩阵,但是这个矩阵被转换成向量表示,然后再进行归一化,计算公式如下:

其中,xi(j)和ck(j) 表示的是第i个局部表述算子和第k个聚类中心的第j个特征值。ak(xi)可以理解为第i个局部特征属于第k个类的权重,也就是,如果它的值等于1就说明它属于这个聚类的簇。如果是传统方法的VLAD,那么这个值只能是0和1。直观上看,V表征着所有局部特征再每一个聚类簇上的残差(xi - ck)和。

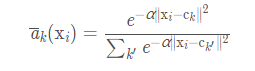

在传统的VLAD中,由于ak(xi)是一个不连续的值,取值为1或0,并且满足![]() ,使得不能反向传播,文章采用一种近似的方式,来对ak(xi)做软分配(soft assignment)如下式:

,使得不能反向传播,文章采用一种近似的方式,来对ak(xi)做软分配(soft assignment)如下式:

这个权重的分配可以把它当作一个模糊聚类的分配方式,根据每个局部特征到聚类中心的距离来生成一个概率函数权重。对于一个局部特征描述xi 在每个聚类簇下的权重的范围在0~1之间,权重最高的可以理解为该特征离聚类簇中心的聚类最近,权重低说明其离簇中心较远。可以注意到,当 α → + ∞ 时,这个式子就表示着原始的VLAD结构。、

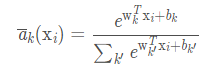

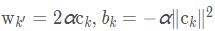

进一步地,可以将上式进行平方展开,(a + b)2=a2 + b2 +2ab,可以得到下式:

其中, ,最终,我们可以得到VLAD特征向量为:

,最终,我们可以得到VLAD特征向量为:

可以看出,式中的参数wk,bk,ck, 都是可以训练的,和原始的VLAD很近似,NetVLAD通过这种在不同聚类簇上的软分配(soft-assignment)方式,能够有效的聚合了局部特征空间中不同部分(聚类)的一阶残差的统计量。另外我们可以注意到,NetVLAD中包含着三个参数,wk,bk,ck,

原始VLAD中只有一个参数ck,这使得NetVLAD相对于传统的方法具有更加的灵活性,并且所有的参数在特定的任``务下可以通过端到端的方式来学习得到。

由图1可以看出,NetVLAD 层可以直接接在卷积网络中的最后一层(H × W × D)上,把最后一层的特征图看作 N个密集的 D 维局部描述子。soft-assignment过程可以分为两个步骤:

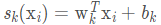

1)通过k个滤波器{wk}将N x D 矩阵来学到:

2)卷积输出然后经过一个soft-max 函数,来生成

总结

这篇文章通过结合传统的特征提取方法,设计了NetVLAD这种网络结构,使得网络更加有效的利用卷积特征,能够有效的提高对同类别图像的表达能力,并提高分类的区分能力。这也是这篇文章最大的贡献。

浙公网安备 33010602011771号

浙公网安备 33010602011771号