安装爬虫常用包时出现的小问题

1、安装一些第三方插件时,由于网速限制可能导致请求超时,pip安装可以设置超时时间

pip --default-timeout=100 install -U [packageName]

为了方便一般使用pip源进行安装,pip源相比于直接安装会快出很多

国内常用pip源 清华:https://pypi.tuna.tsinghua.edu.cn/simple 阿里云:http://mirrors.aliyun.com/pypi/simple/ 中国科技大学 https://pypi.mirrors.ustc.edu.cn/simple/ 华中理工大学:http://pypi.hustunique.com/ 山东理工大学:http://pypi.sdutlinux.org/ 豆瓣:http://pypi.douban.com/simple/ 用法:pip install [packageName] -i pip源

为了以后不再复制pip源地址,可以设置配置文件,方法来自 https://www.cnblogs.com/microman/p/6107879.html

# Linux下,修改 ~/.pip/pip.conf (没有就创建一个文件夹及文件。文件夹要加“.”,表示是隐藏文件夹) [global] index-url = https://pypi.tuna.tsinghua.edu.cn/simple [install] trusted-host=mirrors.aliyun.com # windows下,直接在user目录中创建一个pip目录,如:C:\Users\xx\pip,新建文件pip.ini。内容同上。

上述方式已亲测有效,省时省力,方便快捷

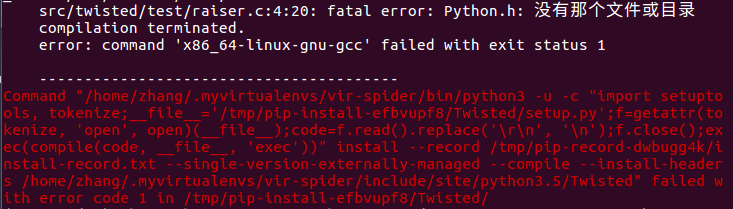

2、安装爬虫框架scrapy时依赖性错误

经过我的不断查找和尝试,最终找到两种代码解决依赖问题

#此方法试过无用 sudo apt install libssl-dev #亲测已解决 sudo apt-get install build-essential python3-dev libssl-dev libffi-dev libxml2 libxml2-dev libxslt1-dev zlib1g-dev

浙公网安备 33010602011771号

浙公网安备 33010602011771号