关于《Intriguing properties of neural networks》的阅读笔记

1. 中心思想

我们小组阅读了Intriguing properties of neural networks,本文主要介绍了两个方面一个是神经网络的语义信息不存在于独立的神经元中,而存在于整个神经元激活的空间内。另外一个是神经网络的盲点-----对抗样本的存在性

2. 数据集和网络结构

本文用到的数据集如下:

1. MNIST dataset

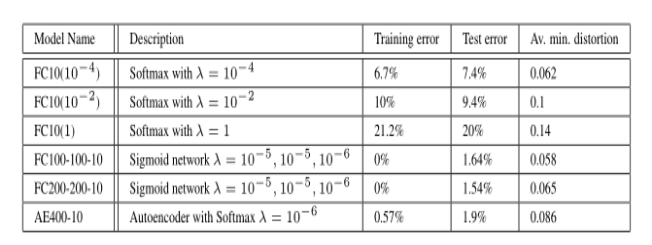

由一个或多个隐藏层和softmax分类器组成的简单全连接网络——称为“FC”;

在自动编码器上训练的分类器——称为“AE”。

2. ImageNet dataset

AlexNet网络。

3. 来自Youtube 的10M图像样本

具有10亿可学习参数的无监督训练网络——称为“QuocNet”。

3. Units of: φ(x)

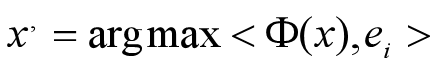

先前的工作试图通过单个神经元去解释某种特征(例如:某个神经元对直线很敏感,另一个神经元对圆弧很敏感)。换而言之,也就是他们认为某个独立神经元包含了语义信息。用公式表示如下:

实验结果显示,同单个神经元一样,这个随机的方向也能表示某种确切的语义信息,从而说明了这个随机方向也可以表示某种特征。所以作者们认为神经网络携带语义信息的并不是单个神经元,而是隐层所表示的整个空间。

4. 形式描述

4.1 描述

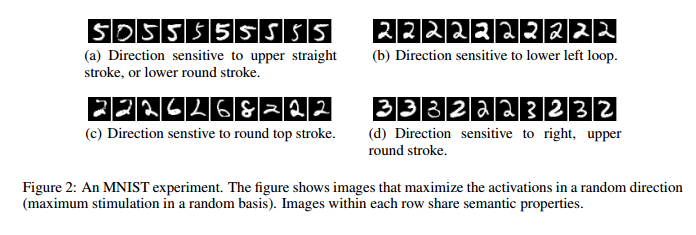

用于产生高效对抗样本方式的公式化描述:

经过前面的几个实验得到了以下的结论:

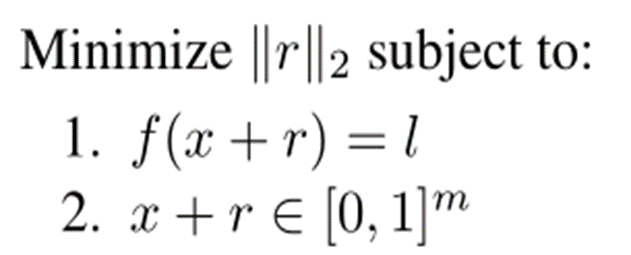

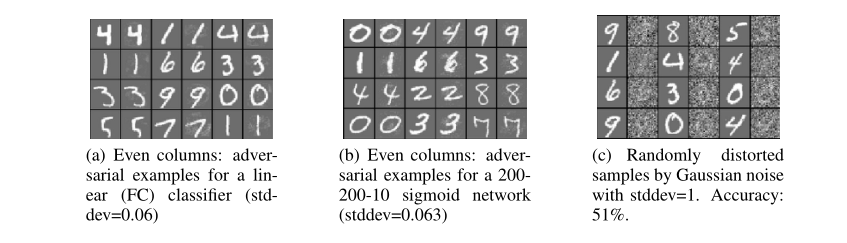

1. 对于文中提到的所有网络结构,都能生成对抗样本。

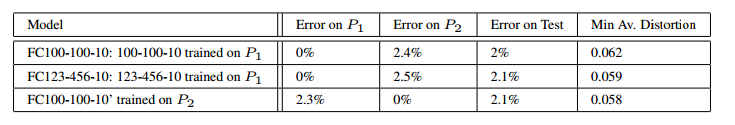

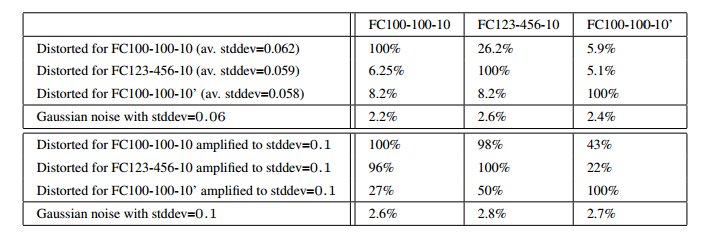

2. 对抗样本具有跨模型的泛化能力:在A模型上产生的对抗样本,有很大一部分在B模型(和A模型结构相同,超参数不同)上也有效。

3. 对抗样本具有跨数据集的泛化能力:在D1数据集训练得到的模型上产生的对抗样本,在D2数据集训练得到的模型上也有效,D1和D2属于不同的子集,两个模型是结构完全不同的模型。

参考文献:

[1]Intriguing Properties of Neural Network

[2]hard negative mining

[3]https://www.bilibili.com/video/BV1VW411n73a?from=search&seid=2324307158576255334

浙公网安备 33010602011771号

浙公网安备 33010602011771号