【PRML读书笔记-Chapter1-Introduction】1.2 Probability Theory

一个例子:

两个盒子:

一个红色:2个苹果,6个橘子;

一个蓝色:3个苹果,1个橘子;

如下图:

现在假设随机选取1个盒子,从中.取一个水果,观察它是属于哪一种水果之后,我们把它从原来的盒子中替换掉.重复多次.

假设我们40%的概率选到红盒子,60%的概率选到蓝盒子.并且当我们把取出的水果拿掉时,选择盒子中任何一个水果还是等可能的.

问题:

1.整个过程中,取得苹果的概率有多大?

2.假设已经去的了一个橘子的情况下,这个橘子来自蓝盒子的可能性有多大?

(这里,推荐一篇好文:数学之美番外篇:平凡而又神奇的贝叶斯方法)

下面,设定一些变量:

:表示选盒子这一事件,它有两种可能:

代表选到了红盒子;

代表选到了蓝盒子;

表示选水果这一时间,它也有两种可能,

代表选到了苹果;

代表选到了橘子.

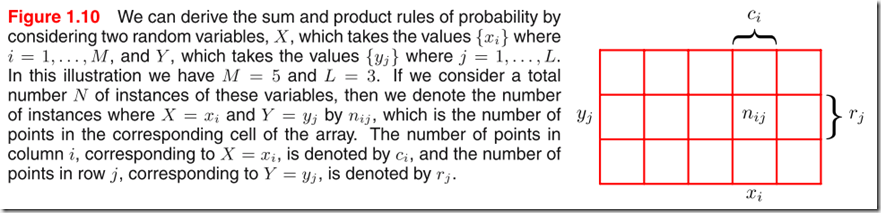

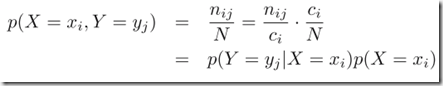

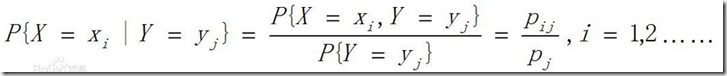

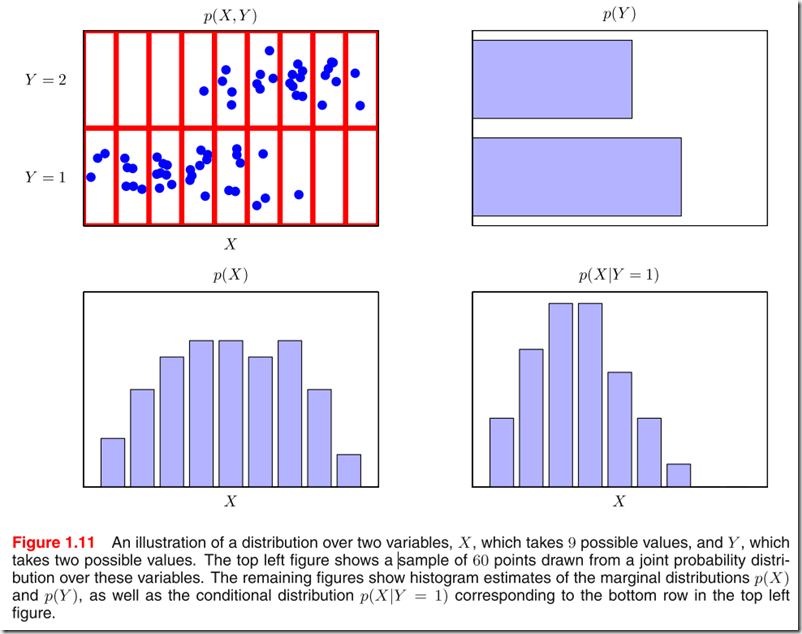

考虑更一般的情况(抛开前面的问题),两个随机变量:

表示盒子,

表示水果.

表示抽到的盒子是哪个;

表示抽到的水果是哪个;

概率之和为1.

因此,可以知道

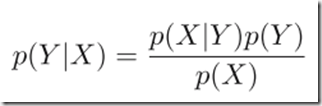

bayes公式:

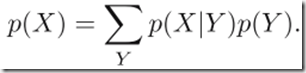

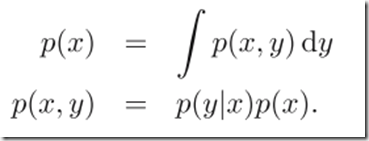

温习一下边缘分布和条件分布:

边缘分布:若干个变量的概率加和所表现出的分布:P(i)=sum(P(i,j),for each j in n)

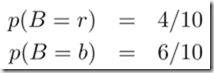

回到刚才的例子:

:这个表示,当抽到红盒子的前提下,抽到苹果和抽到橘子的概率之和.(盒子中只有苹果和橘子,肯定是不是抽到苹果就是抽到橘子,所以,概率之和为1)

贝叶斯公式可以说是尽可能基于我们当前的认知去对未来的事件做出最理想的猜测,而这种猜测并不一定是对的.其中,

是先验概率,因为我们在抽取水果之前,就已经知道了他的值是多少.

(from wiki:

在贝叶斯统计中,某一不确定量p的先验概率分布是在考虑"观测数据"前,能表达p不确定性的概率分布。它旨在描述这个不确定量的不确定程度,而不是这个不确定量的随机性。这个不确定量可以是一个参数,或者是一个隐含变量(英语:latent variable)。

在使用贝叶斯定理时,我们通过将先验概率与似然函数相乘,随后标准化,来得到后验概率分布,也就是给出某数据,该不确定量的条件分布。

先验概率通常是主观的猜测,为了使计算后验概率方便,有时候会选择共轭先验。如果后验概率和先验概率是同一族的,则认为它们是共轭分布,这个先验概率就是对应于似然函数的共轭先验。)

是后验概率,因为这个概率是我们在抽取水果之后,才能够计算得到的.

(from wiki:

在贝叶斯统计中,一个随机事件或者一个不确定事件的后验概率是在考虑和给出相关证据或数据后所得到的条件概率。)

在这个例子中,因为选择红盒子的概率为4/10,蓝盒子的概率为6/10,所以我们觉得选择蓝盒子的概率更大.但是,如果现在只告诉我们抽到的水果是橘子(已知相关数据的前提下),那么,我们会认为是红盒子抽到的橘子会大一些,因为

=2/3.

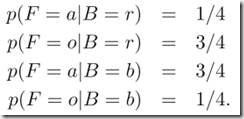

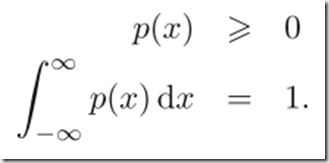

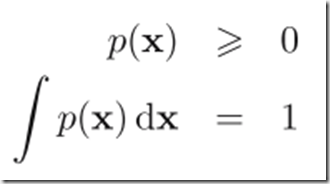

1.2.1 概率密度

简单回归一下概率密度函数:

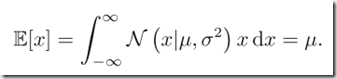

1.2.2 期望和方差

一元函数的期望

多元函数的期望

多元函数的条件期望

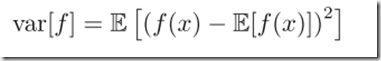

方差(variance):方差是各个数据分别与其平均数之差的平方的和的平均数,用字母D表示。在概率论和数理统计中,方差(Variance)用来度量随机变量和其数学期望(即均值)之间的偏离程度。

协方差(covariance):在概率论和统计学中,协方差用于衡量两个变量的总体误差。而方差是协方差的一种特殊情况,即当两个变量是相同的情况。

1.2.3 贝叶斯概型

之前举了从盒子中抽水果的例子来讲诉贝叶斯公式.再举一个多项式曲线拟合的例子:

D为数据集,w为所求的参数向量.那么:分母为常量

要求

就要先求

,它的含义就是当参数为w时,数据集为D的概率有多大,这个其实就是似然函数.似然函数并不等于w的概率分布.

虽然说在贝叶斯和频率学说中,似然函数

都起到一个关键的作用,但是,两种学说使用的方式确实完全不同:

1. 频率学说:w被认为是一个固定的值,它的值取决于一些估计的形式,通过考虑数据集D的分布来决定估计的误差.\

2. 贝叶斯:从贝叶斯的观点来看,给定一个单一的数据集D,通过w的概率分布来表达参数中的不确定性.

其中,最常见的极大似然估计.是使得

最大化.在机器学习的文献中,使得似然函数最大化等价于使误差函数最小化.其中一种测误差的方法就是boostrap.假设给定N个点

我们可以随机绘制一个新的点集

作为X的代替.因此,X中的一些点可以被

中的点所替代(还有一部分无法替代).这种过程重复L次,可以生成一个大小为N的数据集L.每一次都从原始数据X中采样获得.参数估计的精确度可以通过不同的bootstrap数据集的预测得到.(说明:每次数据集的迭代是有方向性的,即不断接近目标数据集.)

贝叶斯观点有个优点在于它的先验概率来源于常识.比如抛硬币,如果抛了3次全是正面朝上,那么一个经典的极大似然给出的结果会是抛一枚硬币正面朝上的概率为1(显然,这是不合理的),但是贝叶斯方法基于之前的一些常识会尽可能地减弱这种极端的情况.

对于频率学派和贝叶斯学派的争议不断.对于贝叶斯方法的一个批判就是对于先验概率经常是基于数学计算的方便性,甚至由于对先验的依赖性导致最终结果的主观性.为了减弱这种主观性,可以通过一种叫做非告知的先验方法.但是当需要比较模型的时候,这也会带来困难.贝叶斯方法在基于较差的先验的前提下,对于得到的较差的数据也会有很高的置信度.而频率学派对于这种问题提供了一些保障,例如交叉验证.

此外,随着抽样方法的发展,推动了贝叶斯技术的应用.

1.2.4 高斯分布(正态分布)

首先插播一段高斯朴素贝叶斯from wiki:

如果要处理的是连续数据一种通常的假设是这些连续数值为高斯分布。 例如,假设训练集中有一个连续属性,

。我们首先对数据根据类别分类,然后计算每个类别中

的均值和方差。令

表示为

在c类上的均值,令

为

在c类上的方差。在给定类中某个值的概率,

,可以通过将

表示为均值为

方差为

正态分布计算出来。如下,

处理连续数值问题的另一种常用的技术是通过离散化连续数值的方法。通常,当训练样本数量较少或者是精确的分布已知时,通过概率分布的方法是一种更好的选择。在大量样本的情形下离散化的方法表现更优,因为大量的样本可以学习到数据的分布。由于朴素贝叶斯是一种典型的用到大量样本的方法(越大计算量的模型可以产生越高的分类精确度),所以朴素贝叶斯方法都用到离散化方法,而不是概率分布估计的方法。

对于连续型变量,最重要的概率分布之一-------高斯分布(标准分布).

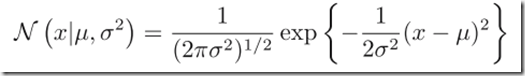

单变量高斯分布:

主要的参数:

µ-----均值 µ^2-------方差(开根号就是标准差σ)

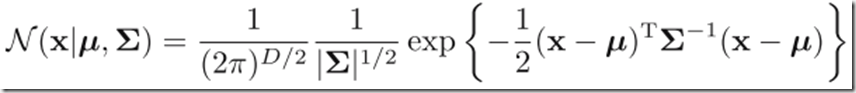

如果x是一个D维的向量的话,那么:

其中,

是D维的向量,叫均值;

是D*D的矩阵,叫协方差.

代表

的行列式.

在多变量的情况下,如果多个变量相互独立且符合相同的分布,那么我们把它记为i.i.d(independent and identically distributed,).即独立同分布.两个独立的变量的联合概率计算公式:

其中,X表示一个包含多个变量的向量,而且这些变量都是独立同分布的.

方式一:基于给定的数据,求参数的概率

方式二:基于给定的参数,求数据的概率.

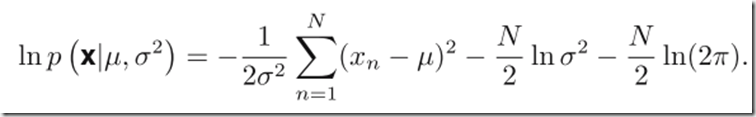

求得高斯分布中的均值和方差,我们就要做极大似然估计.通过取对数求最大与不取对数求最大化在结果上是一致而且取对数能简化计算,而且由于大量的小概率事件(他们的概率很小时计算机会出现下溢)使得计算机在计算时精度丢失,取对数的话可以避免这种情况的发生.

如下:

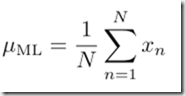

为了最大化上面的式子,我们可以先求出样本均值和方差:

当然,这种方法也是有局限的,在于高斯分布中,对方差的期望是等于:

,可以发现,均值是无偏估计量,方差是有偏估计量.因此,我们用上面的式子得到的方差往往会比

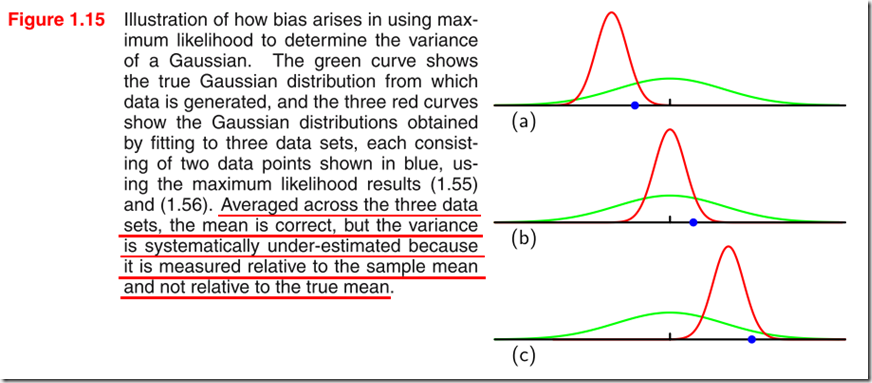

上图表示三次抽样估计,绿色曲线表示真实高斯分布,红色曲线表示利用最大似然估计求出的三次抽样的分布,平均三次抽样的期望,即为整体的期望,而图中很明显可以看出三次抽样的方差是设计成一样的,也就说明其平均值是永远不会等于真实方差的(即红色曲线的方差均值不等于绿色曲线的方差),这是因为公式(1.56)可以说明的,那就是似然估计的方差依赖似然估计的期望,而不是依赖真正的期望所造成的。(引自:http://eletva.com/tower/?p=433)

这幅图再添加一些理解:from zhihu

在均值

已知的情况下,方差的最大似然估计(即样本方差)的表达式是这样的:

你一定计算过,它是无偏的。

在均值未知的情况下,方差的最大似然估计(即样本方差)的表达式是这样的:

注意括号里的减数变成了样本均值。样本均值是随着样本而变的,样本整体偏向哪一边,样本均值也会偏向哪一边。事实上,如果把看成变量,则

恰在

等于样本均值时取最小值。这就是为什么

会偏小。

不过随着N的增长,数据点增多,偏差会变小.因为均值越来越接近.

这种依赖极大似然估计的偏差是过拟合问题的根源.

1.2.5 曲线拟合回顾

给定n个点

及其相应的目标值

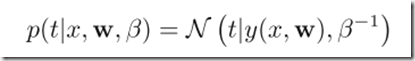

,假设t的值服从高斯分布,即

.其中β代表精度.

对w和β进行估计

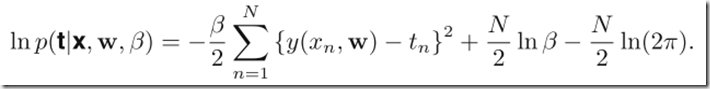

我们通过给定的训练数据通过极大似然估计来确定w和β的值.假设iid的情况下,式子如下:

缩放不改变最大最小的求值,把β/2替换成1/2.求最大化的log函数等价于最小化误差函数:

此外,根据高斯条件分布,我们还可以利用极大似然估计去得到精确度β的值.

求得w和β之后,对x的值进行预测

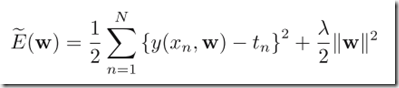

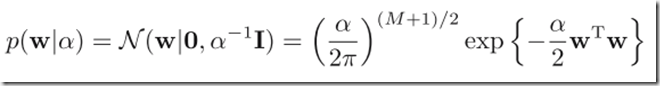

进一步讨论贝叶斯方法,介绍一种基于多项式参数w的先验分布.为了简化问题,先考虑一下高斯分布形式:

其中,α 是这个分布的精确度.M+1表示向量w(M阶多项式)中的参数个数.

这里提出一个超参数(hyperparameters)的概念:即参数的参数.参数是随机变量时,该参数分布中的参数就是超参数.

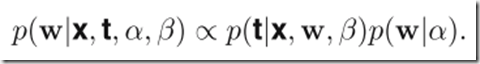

这里w的后验分布正比于先验分布和似然函数的乘积,即

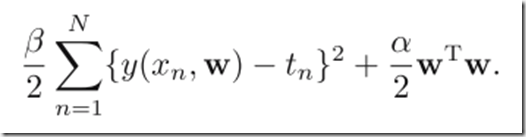

对于给定的数据,我们可以通过最大化后验分布来求得w.这种方法就叫做"maximum posterior"或"simply MAP".通过取副对数,我们发现最大化后验等价于最小化平方和误差函数:

1.2.6 贝叶斯曲线拟合

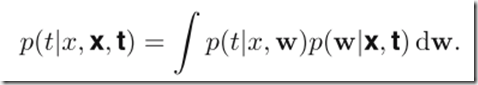

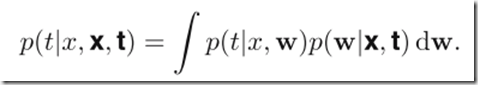

我们把预测分布写成这种形式:

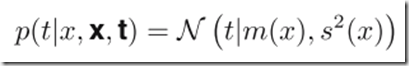

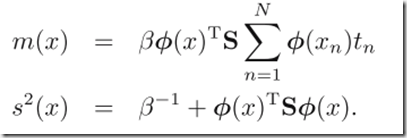

其中,均值和方差为:

我们可以发现,方差,均值是独立于x的.其中

If you have any questions about this article, welcome to leave a message on the message board.

Brad(Bowen) Xu

E-Mail : maxxbw1992@gmail.com

![image_thumb111[1] image_thumb111[1]](https://images0.cnblogs.com/blog/405927/201506/051212445821134.png)

![image_thumb27[1] image_thumb27[1]](https://images0.cnblogs.com/blog/405927/201506/051213073481024.png)

![image_thumb13[1] image_thumb13[1]](https://images0.cnblogs.com/blog/405927/201506/051213309884112.png)

![image_thumb15[1] image_thumb15[1]](https://images0.cnblogs.com/blog/405927/201506/051213318016525.png)

![image_thumb31[1] image_thumb31[1]](https://images0.cnblogs.com/blog/405927/201506/051213335984043.png)

![image_thumb4[1] image_thumb4[1]](https://images0.cnblogs.com/blog/405927/201506/051213429574934.png)

![image_thumb101[1] image_thumb101[1]](https://images0.cnblogs.com/blog/405927/201506/051213467548094.png)

![image_thumb19[1] image_thumb19[1]](https://images0.cnblogs.com/blog/405927/201506/051213522388270.png)

![image_thumb511[1] image_thumb511[1]](https://images0.cnblogs.com/blog/405927/201506/051213550982745.png)

![image_thumb41[1] image_thumb41[1]](https://images0.cnblogs.com/blog/405927/201506/051214010043048.png)

![image_thumb81[1] image_thumb81[1]](https://images0.cnblogs.com/blog/405927/201506/051214029262135.png)

![image_thumb6[1] image_thumb6[1]](https://images0.cnblogs.com/blog/405927/201506/051214065357238.png)

![image_thumb36[1] image_thumb36[1]](https://images0.cnblogs.com/blog/405927/201506/051214239732466.png)

![image_thumb43[1] image_thumb43[1]](https://images0.cnblogs.com/blog/405927/201506/051214278634654.png)

浙公网安备 33010602011771号

浙公网安备 33010602011771号