机器学习笔记(一)

本次笔记图片取自MOOC平台浙江大学的机器学习课程中(https://www.icourse163.org/course/ZJU-1206573810)

机器学习的定义和特征

通俗定义机器学习既是非显著式编程,区分于显著式编程的固定的输入和输出,对于机器学习的编程,任务T通过输入的E(经验 Experience)来实现,输入的E量越大,任务的P(识别率 Performeance Measure)也对应越高,这就是非显著式编程的机器学习的特性。

机器学习的分类:监督学习和强化学习。例如人脸识别,语音识别等可归为监督学习,例如智能下棋和自动化行驶技术则是强化学习。两者的区别在于监督学习的实现基于大量的训练样本,它的所有经验都是人工采集后输入计算机,为训练数据打标签(Labeling for training date),强化学习是指通过与环境的互动,找到最大化收益函数。

监督学习可分为有标签的监督学习,无标签的监督学习和半标签监督学习,其中,有标签的监督学习又可以分为有关分类问题的监督学习和有关回归问题的监督学习。

有关分类问题的监督学习中的标签都是离散的,比方说人脸识别问题当中,将两张人脸图案进行对比时只有两种可能:同一张脸则标为1,不是同一张脸则标为0.,或者在一堆人脸照片中寻找特定某人的照片,则对这堆照片依次标记1,2,3……,分别比对特定某人的照片,直到找到匹配照片即找到标签的标记。

有关回归问题的监督学习是关于连续的标签的相关问题,比如房价走势问题

当然,离散和连续的界限是模糊的,它们在某些时候可以进行转化,所以研究回归问题时可以加以转化后利用分类问题的方法进行研究。

大部分机器学习研究的都是分类问题,下面是关于具体案例中机器学习的步骤:

一:特征提取(Feature Extraction)-不是机器学习的重点,但是非常重要,提取好的特征有时候比好的算法对于识别率有更好的效果。比如让机器区分苹果和橘子,特征可以取颜色,形状,表面粗糙程度等。

二:特征选择(Feature Selection)选择合适的特征尤为重要,

三:选择算法或构造算法,是机器学习的重点。

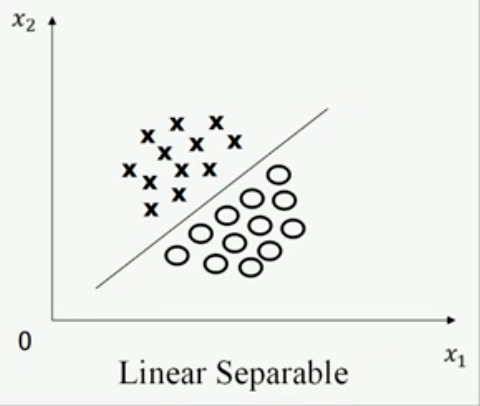

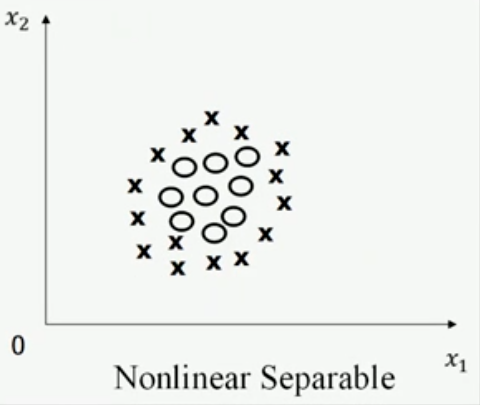

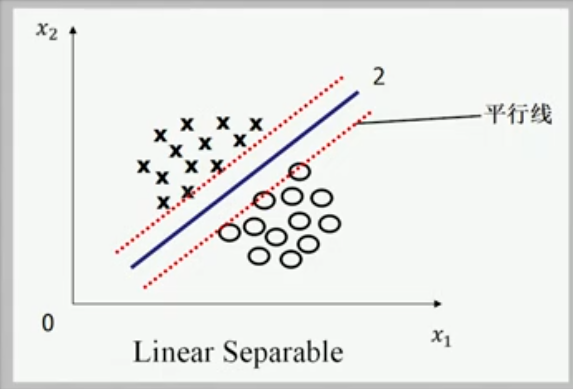

对于许多问题,都可以分为线性可分和线性不可分问题,在二维平面上,通俗的讲,线性可分问题就是在特征空间中可以找到一条直线区分两个类型样本,线性不可分则找不到这样的一条直线。

对于三维平面,则对于线性可分的定义是在这个三维的特征空间中可以找到一个平面区分两个类型,以此类推可以运用到更高维度的特征空间中。

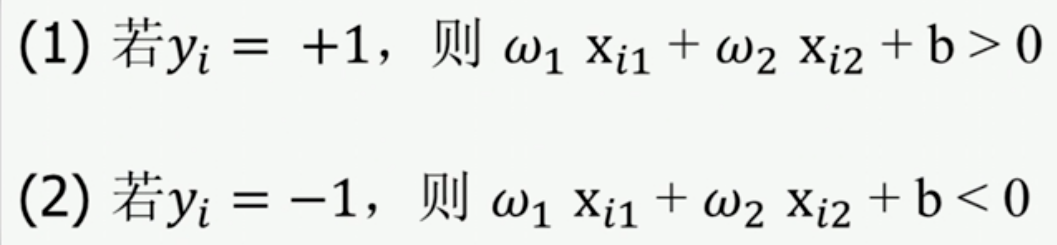

现在我们单独讨论二维空间中的线性可分情况。对于二维的特征空间中,有以下的情况,其中x1,x2表示两个特征,圆圈和叉分别标记两种训练样本,则能够找到一条直线(超平面),其方程如图所示,其中w1为x1的权重,w2为x2的权重,b为偏置。这里默认w1,w2>0,则我们可以明显得到在C1侧有w1x1+w2x2+b>0,C2侧w1x1+w2x2+b<0。

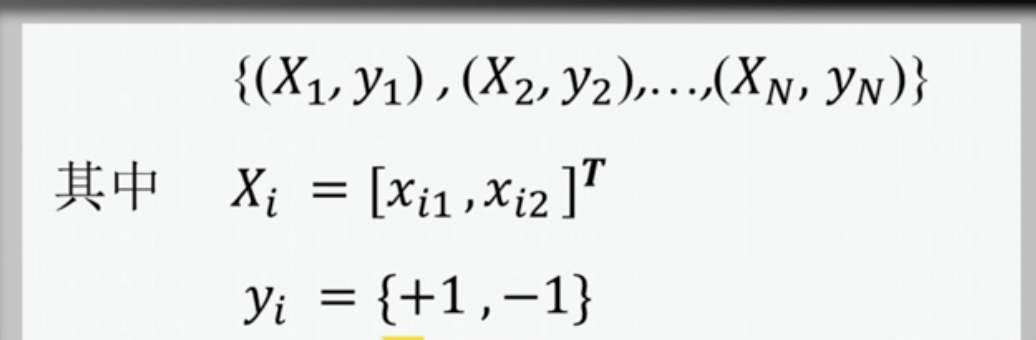

这里用数学严格定义二维的特征空间下的训练样本以及标签,假设有N个训练样本以及其标签,则有如下表示:

yi的取值是-1或1,当其对应的Xi属于上图中C1部分,yi取1,如果对应的是C2部分,择取-1.Xi是特征空间中的一个向量。则当这个训练集线性可分,则有以下结论:

支持向量机中有解决线性可分问题的方法,对于具体的解决方案要基于一个问题,即在线性可分问题中,必定存在无数多个超平面可以将训练样本分为两个类别,那到底应该取哪一个最合适。这个不难得到以下结论可以找到唯一的一条最优化直线(二维平面内):

1.该直线能区分两类训练样本

2.该直线的间隔(margin)取最大,这里的magin是指平移该直线使得恰好接触到达两类训练样本时这两端的平移直线之间的距离。

3.在2的基础上,这条直线位于间隔的中间。

总结:因为想学习基于pytorch的深度学习,但是相关机器学习的基础知识不甚了解,所以算是补了基础课吧,为了学好pytorch,我计划用一周到两周的时间学习机器学习的基础知识(并不深入),然后用两到三天时间再次速成python和numpy相关基础,最后用一个月左右的时间从pytorch基础学起,因为暑假居家环境设备不好(没有服务器),所以争取在开学后就可以直接用服务器进行实践。

浙公网安备 33010602011771号

浙公网安备 33010602011771号