hdfs课堂测试遇到的问题

这个是今天做的课堂测试,一开始找的博客运行不成功,

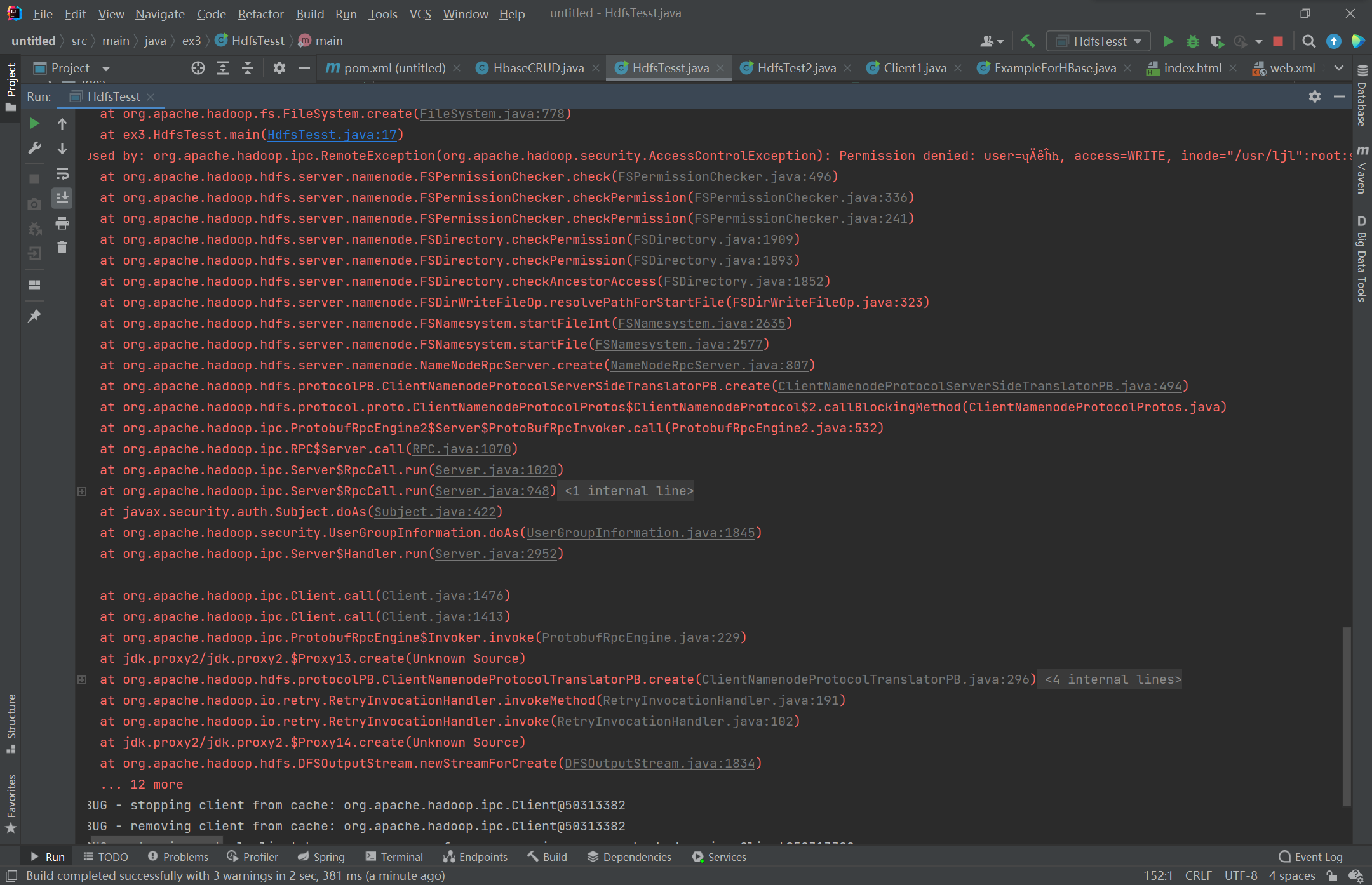

import java.io.IOException; import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.FSDataOutputStream; import org.apache.hadoop.fs.FileSystem; import org.apache.hadoop.fs.Path; public class HdfsTesst { public static void main(String[] args) throws IOException { Configuration conf=new Configuration(); // System.setProperty("HADOOP_USER_NAME","root"); conf.set("fs.default.name", "hdfs://192.168.88.161:8020"); Path inFile =new Path("/usr/ljl/hdfstest1.txt"); FileSystem hdfs=FileSystem.get(conf); FSDataOutputStream outputStream=hdfs.create(inFile); outputStream.writeUTF("信2005-2班20204088廖嘉龙HDFS课堂测试"); outputStream.flush(); outputStream.close(); } }

报这个错 Caused by: org.apache.hadoop.ipc.RemoteException(org.apache.hadoop.security.AccessControlException): Permission denied: user=ʮÄêĥһ, access=WRITE, inode="/usr/ljl":root:supergroup:drwxr-xr-x

是权限的原因,创建的文件没有写的权限,然后去搜解法,说用一条赋予写权限的命令可以解决,但是不管用

显示文件或者目录不存在,真tmd见鬼,看了好多博客也没解决,

然后在代码里面加了一条语句,

System.setProperty("HADOOP_USER_NAME","root");

就是上面被注释掉的那条,就可以了

浙公网安备 33010602011771号

浙公网安备 33010602011771号