Dify Windows Docker.desktop 部署

官方文档:https://www.dify-china.com/account.html

1、环境准备

- 安装docker.desktop

- 安装docker-compose

- 下载dify代码:https://github.com/langgenius/dify

- 我是直接拉取的main分支代码,tag是1.9.2

2、安装dify

这个可以参考github中dify下面的教程,比较简单

cd dify

cd docker

cp .env.example .env

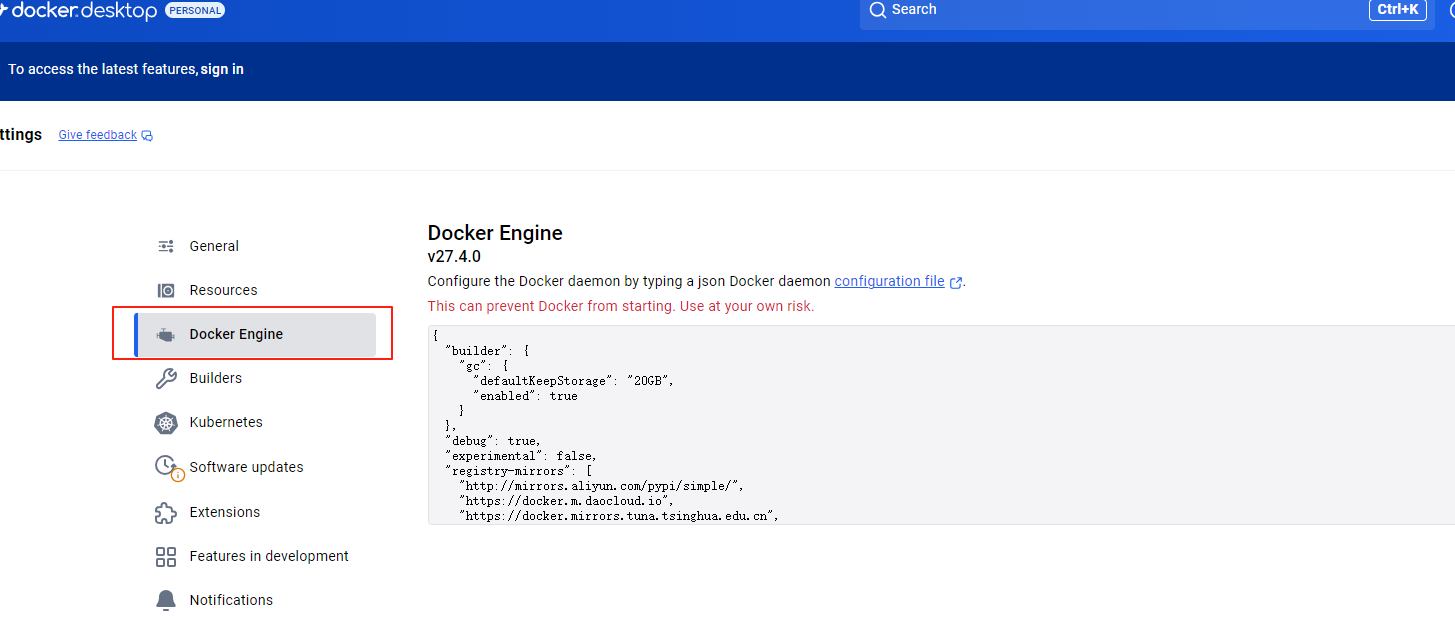

docker compose up -d如果总拉取失败,建议更改下镜像源地址,参考下图:

原始配置

{

"builder": {

"gc": {

"defaultKeepStorage": "20GB",

"enabled": true

}

},

"experimental": false

}更换源后的配置(亲测不用梯子可用)

{

"builder": {

"gc": {

"defaultKeepStorage": "20GB",

"enabled": true

}

},

"debug": true,

"experimental": false,

"registry-mirrors": [

"https://docker.xuanyuan.me",

"https://docker.1ms.run",

"https://dislabaiot.xyz"

]

}由于网络问题,各种镜像拉取了很多次,终于成功了,我本地电脑自带梯子,所以如果有镜像未拉下来,建议搭tizi试试。

2.1 .env

dify的compose.yaml文件有个Nginx,这个默认使用宿主机的80和443端口,这个可能已经被占用,咱们修改下.env文件就行了。修改以下两个环境变量。

EXPOSE_NGINX_PORT=8800

EXPOSE_NGINX_SSL_PORT=4443我已经改成8800,那么启动成功以后就直接访问:http://localhost:8800/

3、dify添加ollama

3.1 docker安装ollama

我本机配置不太行,我就下载个0.5b的,如果配置好建议下载参数更多的。

# 运行ollama

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

# 进入容器内部

docker exec -it ollama sh

# 下载qwen大模型

ollama pull qwen2.5:0.5b3.2 添加ollama这个模型供应商

3.3 添加大模型

参考官方文档:https://docs.dify.ai/zh-hans/development/models-integration/ollama#如何在我的网络上暴露-ollama?

如果是docker部署的ollama就直接添加上就行了~然后注意下url,填写的和我一样就行了。如果是window安装可能麻烦点,需要配置环境变量啥的,建议直接docker部署。

4、其它大模型

这块不就赘述了,ollama更适合小型项目使用,如果使用参数更多的模型则需要更高的配置,所以更建议直接使用云上大模型。

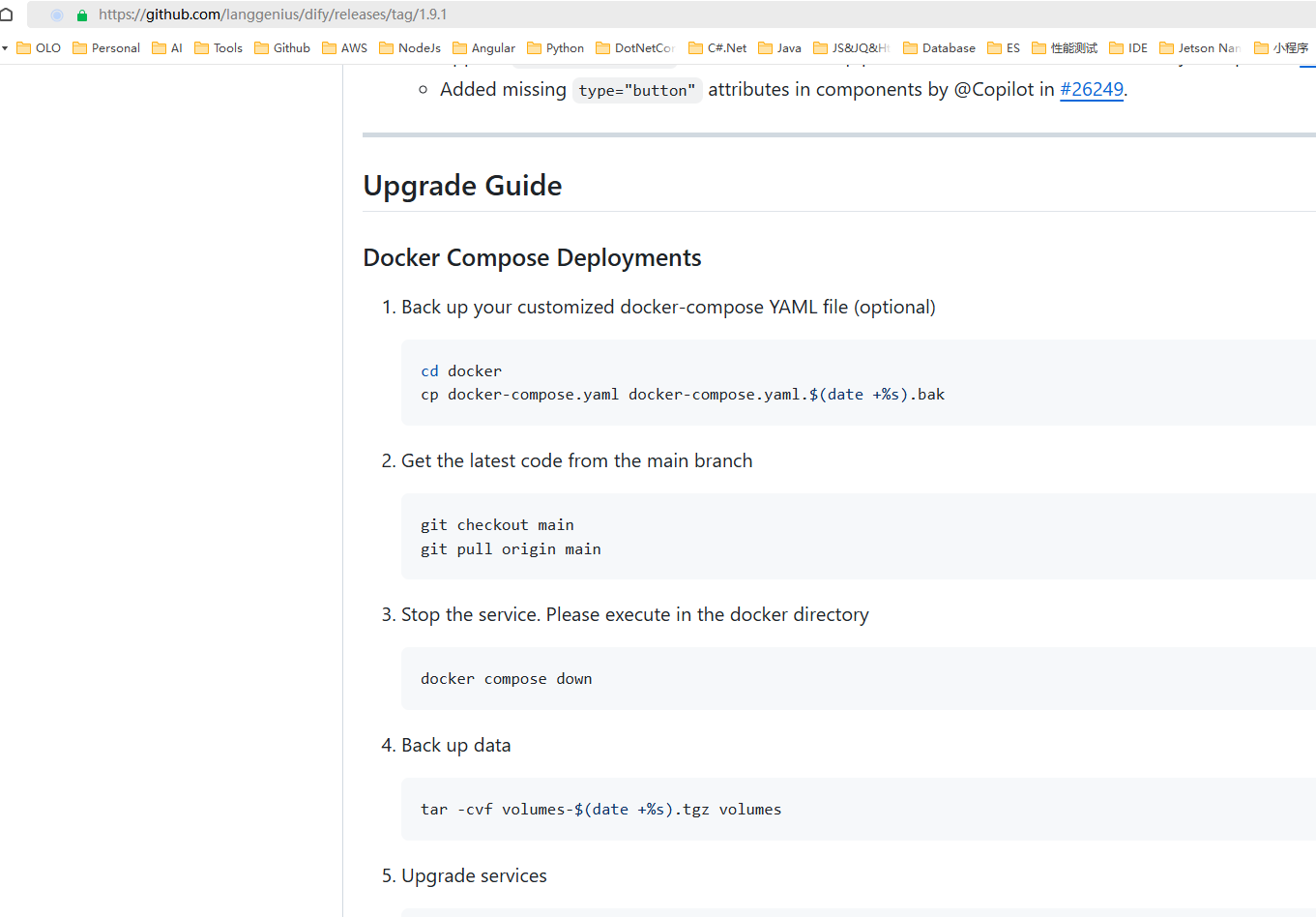

5、版本升级

这个我没有实操,不过github上有教程,在release下面,可以参考下

浙公网安备 33010602011771号

浙公网安备 33010602011771号